热门标签

热门文章

- 1Springboot+Vue项目-基于Java+MySQL的宠物商城网站系统(附源码+演示视频+LW)

- 2c 语言如何处理表格文件中的数据库,C#程序从Excel表格中读取数据并进行处理

- 3C++11:std::function 函数封装器

- 4android开发 -- 复制文本内容到系统剪贴板_android 复制内容到剪切板

- 5【模型复现】CV、NLP多用途模型——Transformer复现_nlp和cv有没有共用的模型

- 6知识图谱学习笔记(三)—— 实体识别与链接_基于表示学习的实体链接

- 7手术麻醉系统管理源码

- 8angular入门_angular安装

- 9毕业设计项目 python金融大数据分析与可视化_python金融数据可视化

- 10产品经理有没有必要考NPDP?考了有用吗?

当前位置: article > 正文

基于Spark的分布式数据处理和机器学习技术【上进小菜猪大数据】_scala spark 机器学习

作者:小小林熬夜学编程 | 2024-05-14 16:48:28

赞

踩

scala spark 机器学习

上进小菜猪,沈工大软件工程专业,爱好敲代码,持续输出干货。

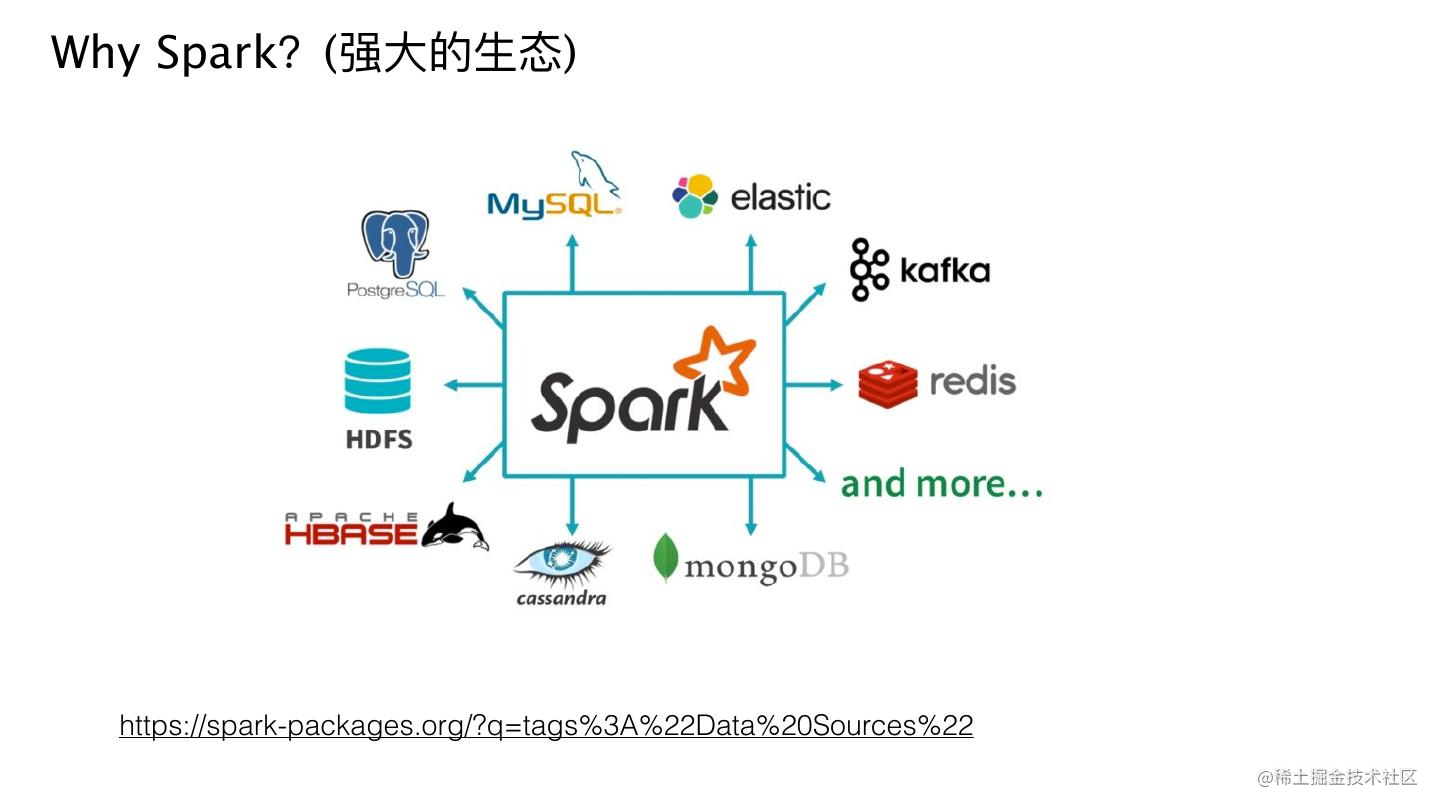

大数据已经成为当今社会中一个重要的资源和挑战。随着数据规模的不断增长,如何高效地处理和分析这些数据成为了一个关键问题。本文将介绍基于Apache Spark的分布式数据处理和机器学习技术,展示如何利用Spark来处理大规模数据集并进行复杂的机器学习任务。我们将详细讨论Spark的基本概念、架构和编程模型,并提供一些示例代码来说明其在大数据领域中的应用。

1. 引言

在过去的几年中,大数据技术取得了巨大的进展。传统的数据处理工具和方法已经无法胜任处理日益增长的数据量和复杂度。在这种情况下,分布式计算框架如Apache Spark应运而生。Spark提供了一种高效、可扩展的方式来处理和分析大规模数据集,并且支持广泛的数据处理任务和机器学习算法。

2. Spark的基本概念和架构

Spark是一个基于内存的分布式计算框架,它以弹性的方式处理数据,并在内存中进行计算,从而大大提高了处理速度。Spark的核心概念是弹性分布式数据集(Resilient Distributed Dataset,简称RDD)。RDD是一个可并行操作的不可变分布式对象集合,它能够跨多个节点进行分布式计算。

Spark的架构主要由驱动程序、集群管理器和执行器组成。驱动程序负责将任务分发给执行器,而执行器则在集群中的节点上执行实际的计算任务。集群管理器负责管理整个集群的资源分配和任务调度。

3. Spark编程模型

S

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/569299

推荐阅读

相关标签