热门标签

热门文章

- 1数据挖掘之决策树归纳算法的Python实现_python 决策树算法 相近问题归纳

- 2Verilog RTL新手实验分析总结_rtl-p实验

- 3win10安装misql8_win10 安装mysql 8.0.12

- 45-在Linux上部署各类软件_linux 部署root应用程序

- 5C语言的内存知识_c语言程序内存空间结构存储

- 6【JAVA毕设|课设】基于SpringBoot+Vue的进销存(库存)管理系统-附下载方式_vue+springboot进销存系统csdn下载

- 7安卓 onActivityResult 废弃,registerForActivityResult 使用详解

- 8pytorch 状态字典:state_dict_torch模型适配state dict

- 9探秘BERT语义相似度计算:BertSimilarity开源项目解析与应用

- 10注意力模块

当前位置: article > 正文

hive moving data报错,unable to move source...,yarn显示任务执行成功_unable to move source hdfs

作者:小小林熬夜学编程 | 2024-06-13 04:19:54

赞

踩

unable to move source hdfs

1.报错情况

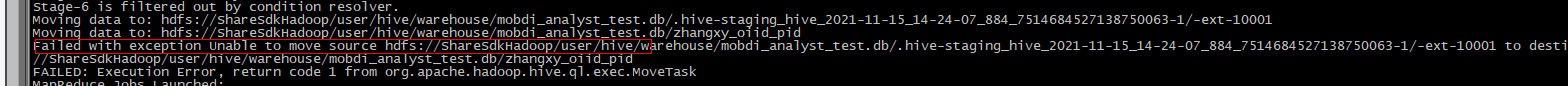

有个小伙伴hive任务报错,moving data时,报错如下

Failded with exception:unable to move source hdfs://...........

2.问题排查

这种情况一般跟任务没有关系了,说明hive任务已经执行成功了。因为默认hive,spark任务数据先写到一个临时目录,等各个节点的数据都写完整以后,校验没问题了,在move到表的hdfs路径下(所谓move其实就是重命令),这个过程报错,说明跟hdfs有关系,跟yarn,hive,spark都没有关系了。

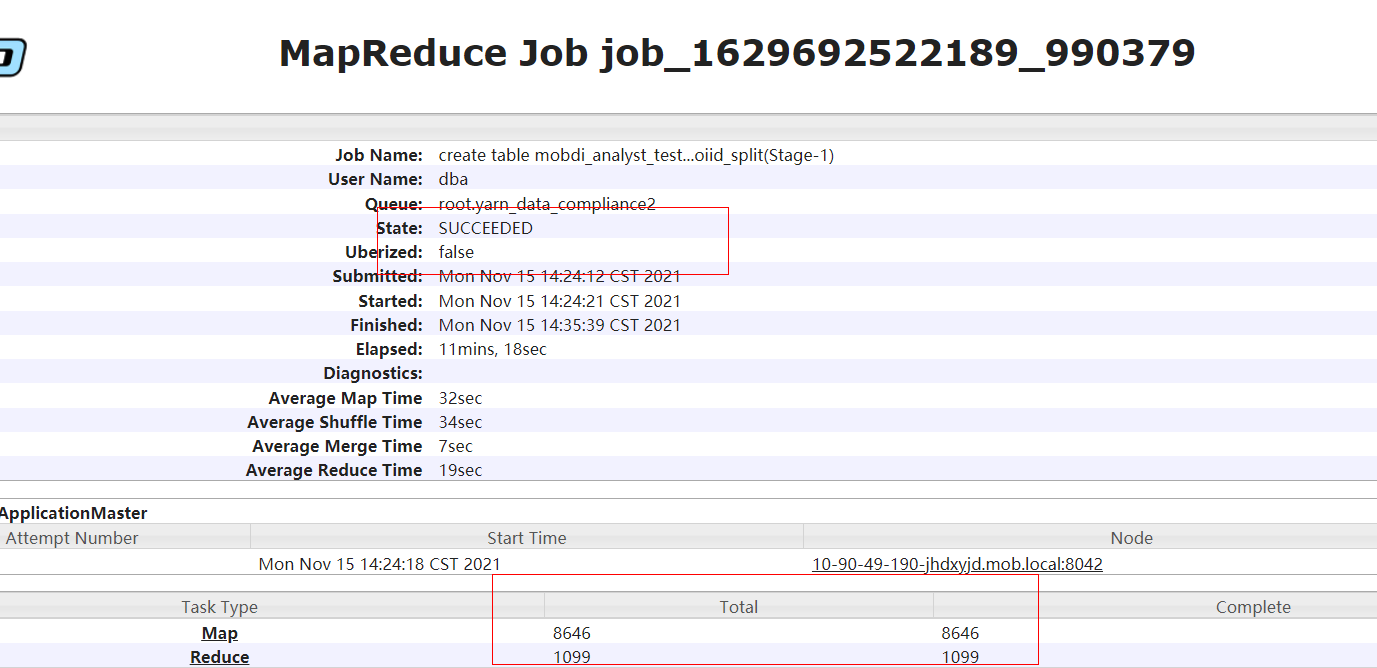

查看yarn日志,显示日志果然已经执行成功。

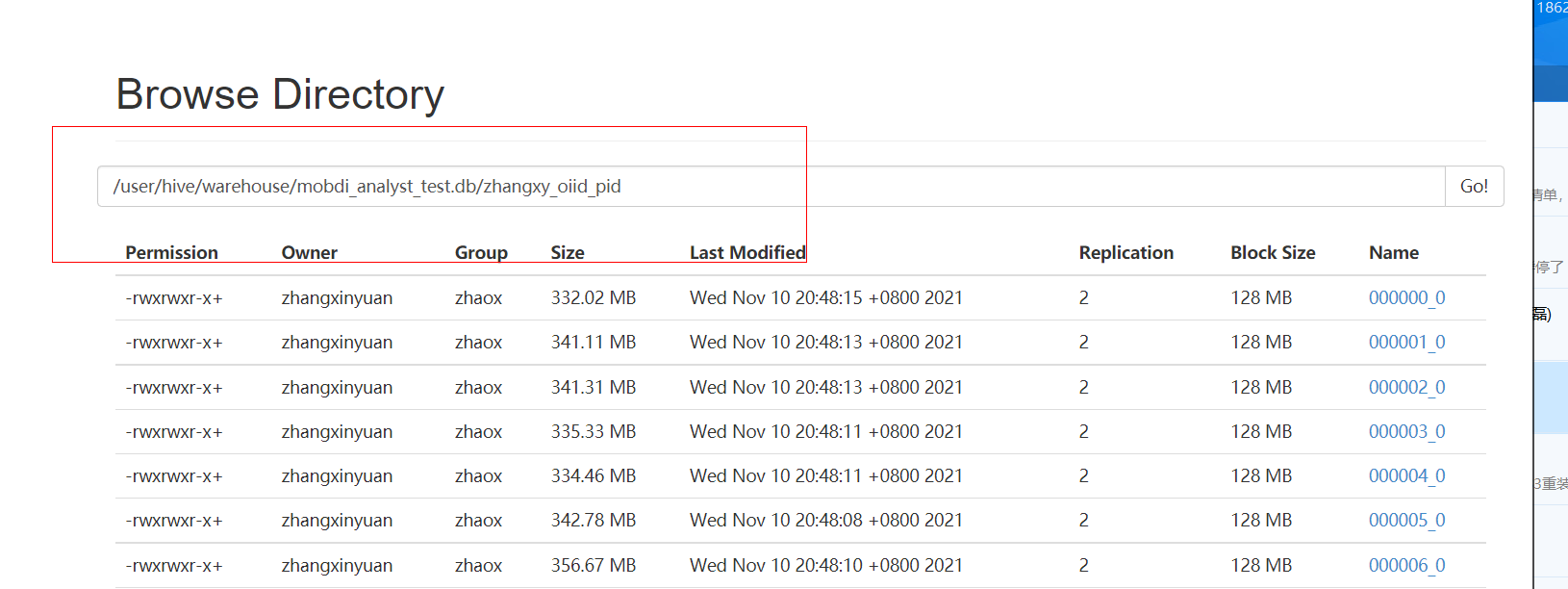

既然跟hdfs有关系,那就说明一般是路径有问题(比如权限,路径异常,节点丢失等等)。

先看hdfs路径,发现该路径下竟然有文件,不合理哇,看文件时间不是任务执行时间。表都未创建。很明显因为这个路径有数据存在,造成表加载异常,move失败。(原因是因为为了数据安全,hdfs路径加T权限,只有表的所有者才可以删表,其他人删不了数据,估计是删表异常,造成数据未删除。)

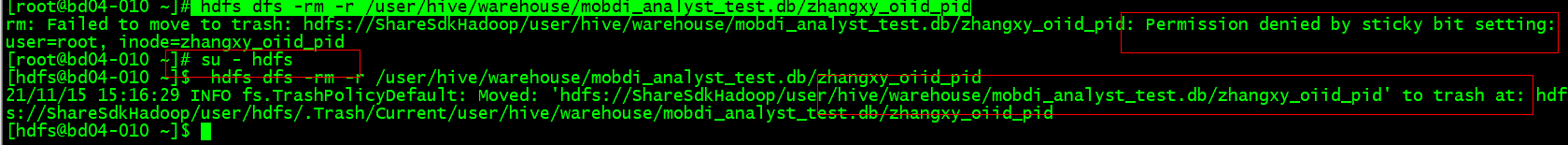

3.解决方案

很简单,把表所在的路径数据清空即可

任务重跑,问题解决

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/710853

推荐阅读

相关标签