热门标签

热门文章

- 1Xilinx PCIE DMA 仿真环境搭建_xilinnx pcie map

- 2掌握机器学习基础:Scikit-Learn(sklearn)入门指南

- 3(附源码)基于PHP图书管理系统-计算机毕设 15723

- 4霸榜!近期不容错过的3个AI开源项目,来了_ai直播开源

- 5关于cloudflare的“检查站点连接是否安全”一直反复转圈的问题_cloudflare一直检查不跳转_cloudflare验证一直重复

- 6变分自编码器以及公式推导过程_变分自编码器的目标函数p(x,z)和q(x,z)

- 7软件测试之测试用例评审流程_软件测试计划评审会

- 8DataSciComp 有关数据科学的比赛

- 9SYN Flood攻击与防御方法_syn flood攻击有哪几种防御方式

- 10ubuntu下使用cmake编译opencv4.8.0+ffmpeg4.2.2+cuda11.1_ffmpeg 4.2.2 下载

当前位置: article > 正文

Ollama-部署运行大模型Gemma_ollama run gemma:2b

作者:小小林熬夜学编程 | 2024-06-17 18:23:06

赞

踩

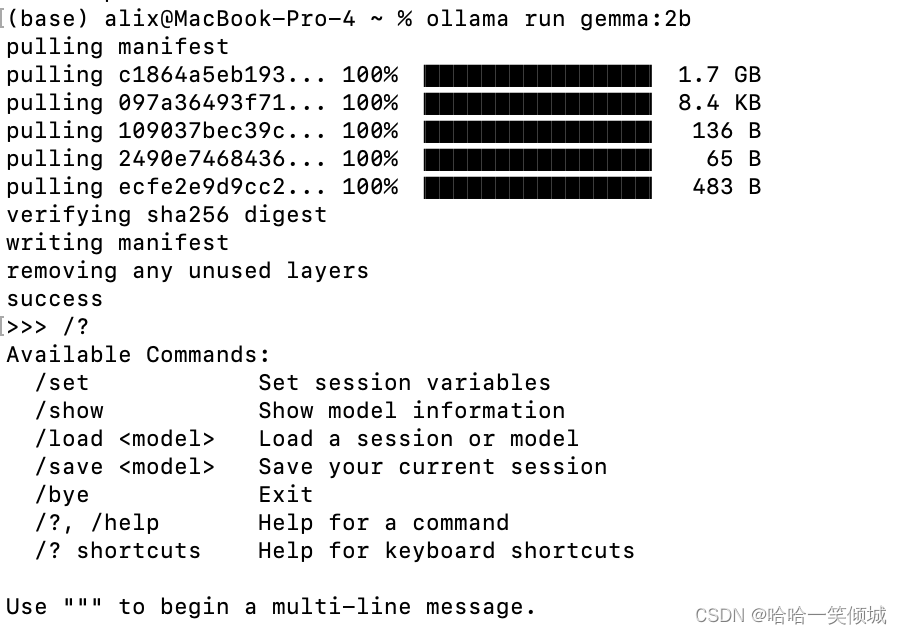

ollama run gemma:2b

Ollama (Ollama) 是一款命令行工具,可在 macOS 、 Linux 、Windows 上本地运行 Llama 2、Code Llama 、Gemma 等模型。

工具下载网址:Ollama

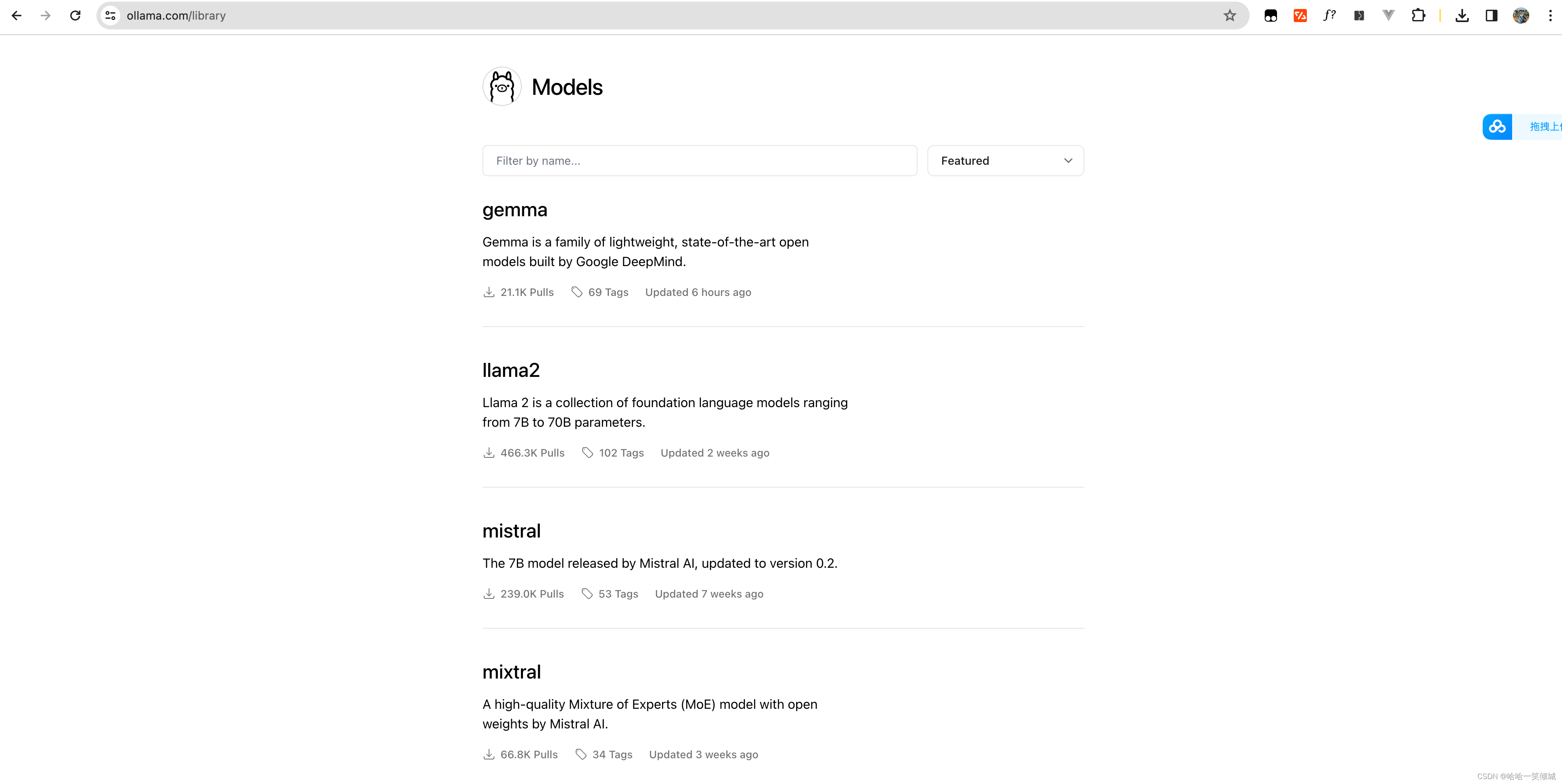

支持的数据模型:支持模型

1、根据 pc 系统安装ollama,安装之后并运行。

2、打开命令行工具窗口:

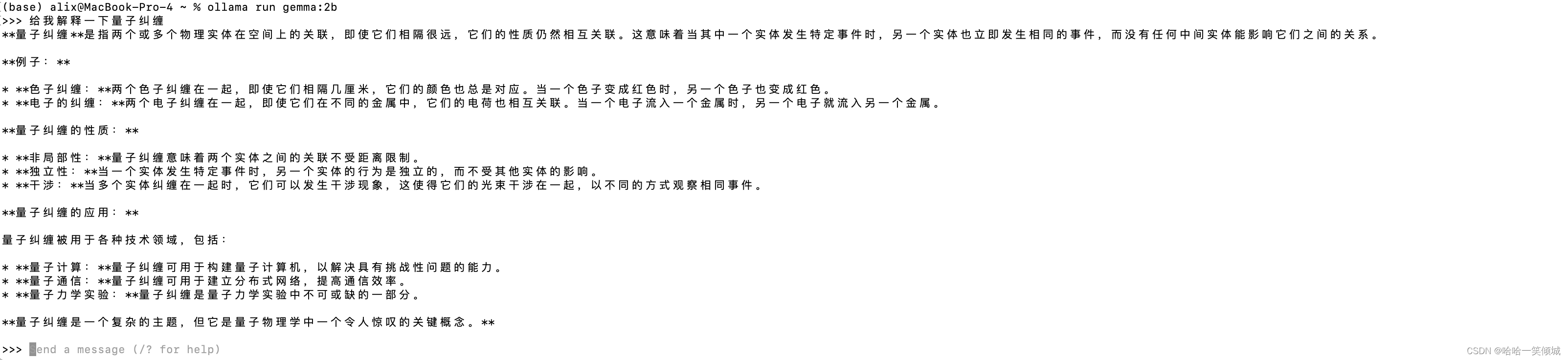

ollama run gemma:2b 3、模型安装完成,我这边选择的是 gemma:2b ,接着就可以直接使用了。

3、模型安装完成,我这边选择的是 gemma:2b ,接着就可以直接使用了。

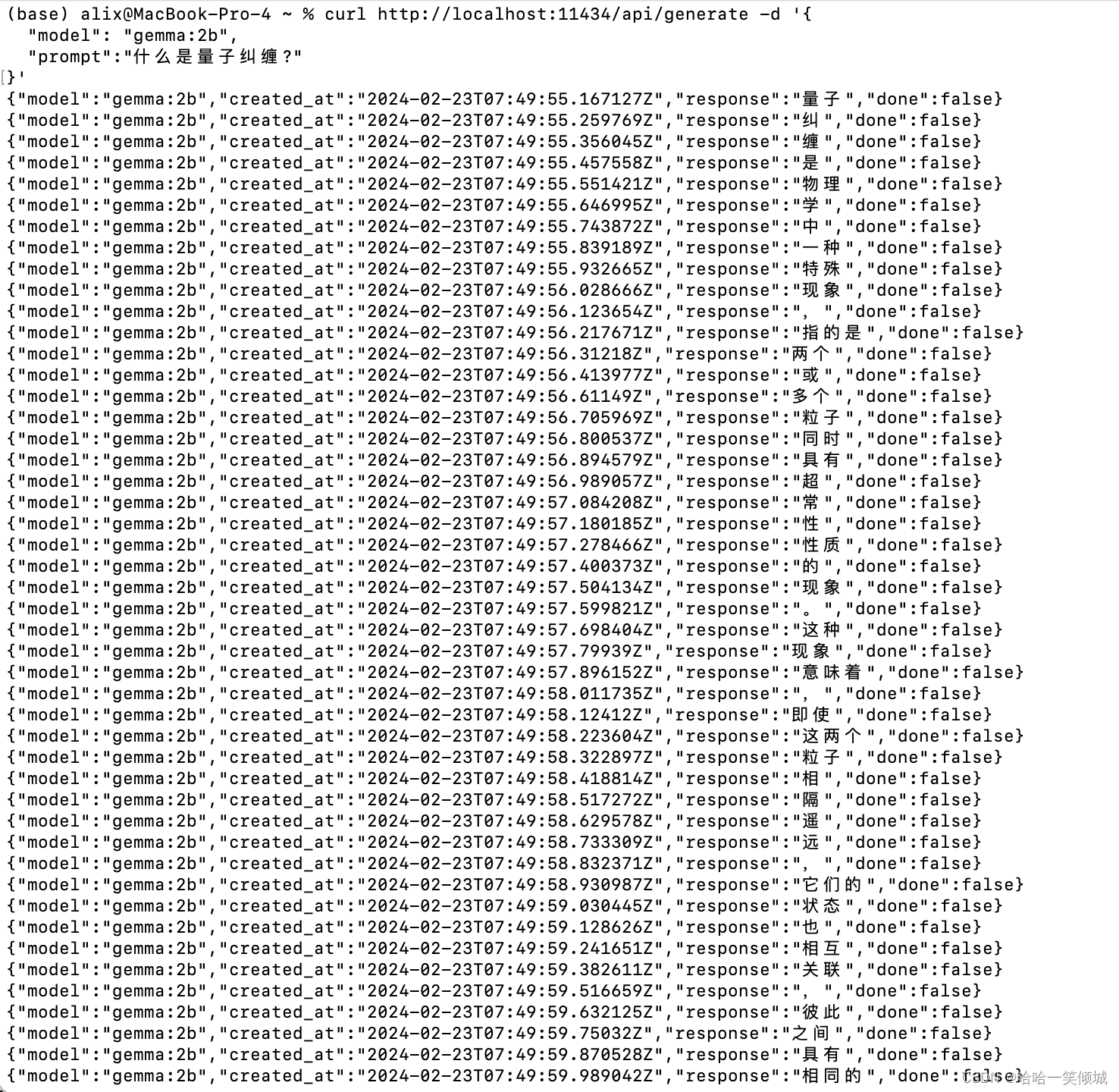

4、还可以直接 api 调用:

- curl http://localhost:11434/api/generate -d '{

- "model": "gemma:2b",

- "prompt":"什么是量子纠缠?"

- }'

本机命令行使用和接口调用都使用正常,根据你的需求选择不同的模型下载使用吧。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/732296

推荐阅读

相关标签