- 1建设智慧城市,需要考虑哪几个方面?_智慧城市建设需要考虑哪些因素?()

- 2Stable Diffusion AI绘画系列【16】:霸气侧漏的二次元武侠风_stable diffusion 国漫风

- 3『第十二章』数据持久化:SwiftData_swiftdata modelcontext

- 4Go最新google vr 入门之制作简易的VR播放器及去除界面控制按钮,腾讯Golang开发面试凉凉_vrvideoview

- 5搭建Gitlab仓库管理系统_基于gitlab的代码仓库管理++系统开发

- 6[ctf.show.reverse] 36D杯 神光_ctfshow神光

- 7AI大模型系列之七:Transformer架构讲解_大模型transformer架构

- 8三秒4张图!让 Stable Diffusion 出图速度暴增的新一代生成模型LCM!_stable加快出图速度

- 9【HarmonyOS】HUAWEI DevEco Studio 下载地址汇总_deveco studio历史版本下载

- 10构建未来的知识库:Ollama、WebUI 和 AnythingLLM 的完美结合_anythingllm有网页端吗

【机器学习】HQ-Edit引领图像编辑新潮流_图像编辑技术

赞

踩

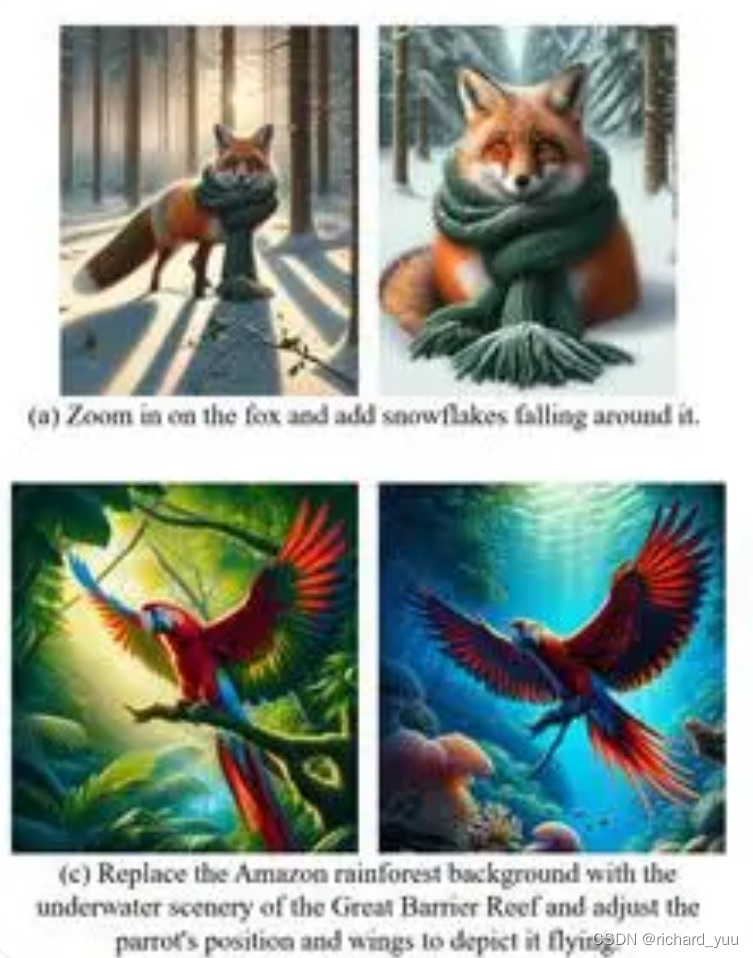

在数字化时代,图像编辑技术正以前所未有的速度发展,成为创意产业和日常生活不可或缺的一部分。然而,传统的图像编辑方法往往依赖于人工操作,效率低下且难以应对大规模数据。近期,加州大学圣克鲁斯分校的研究团队为我们带来了一项革命性的技术——HQ-Edit,一个高质量的基于指令的图像编辑数据集,它不仅为图像编辑领域注入了新的活力,更在技术上实现了质的飞跃。

一、HQ-Edit的诞生:一场技术的革命

在图像编辑领域,数据集的质量对于模型的性能有着至关重要的影响。然而,传统的方法往往依赖于属性指导或人工反馈来构建数据集,这种方法不仅效率低下,而且难以保证数据的质量和多样性。为了克服这一难题,加州大学圣克鲁斯分校的研究团队提出了一种全新的解决方案——HQ-Edit。

HQ-Edit是一个高质量的基于指令的图像编辑数据集,其编辑量达到了惊人的20万次。与传统方法不同,研究团队利用先进的基础模型GPT-4V和DALL-E 3,设计了一个可扩展的数据收集管道。这个管道能够自动生成高质量的图像编辑数据,极大地提高了数据集的规模和多样性。

在数据收集过程中,研究团队首先在线收集了各种示例,然后通过扩展这些示例来创建具有输入和输出图像的高质量双连画。这些双连画不仅包含了图像本身的信息,还附带了详细的文本提示,使得机器能够更准确地理解编辑指令和期望的输出结果。

此外,研究团队还通过精细的后处理步骤,确保了图像和文本之间的精确对齐。这一步骤对于提高数据集的质量和可靠性至关重要,它确保了模型在训练过程中能够学习到正确的图像和文本对应关系。

二、技术实现与优势:强大的编辑能力和精准的匹配

HQ-Edit的成功不仅仅在于其庞大的数据规模,更在于其先进的技术实现和独特的优势。首先,GPT-4V和DALL-E 3这两个基础模型的引入,使得数据收集过程更加自动化和智能化。这两个模型不仅能够自动生成高质量的图像编辑数据,还能够根据指令进行精细化的调整和优化。

其次,HQ-Edit的数据集具有高分辨率和丰富的细节。这使得模型在训练过程中能够学习到更多的图像特征和纹理信息,从而提高了模型的编辑能力和输出质量。同时,详细的文本提示也为模型提供了更多的上下文信息,使得模型能够更准确地理解用户的意图和期望。

此外,为了定量评估使用GPT-4V图像编辑对的质量,研究团队还提出了两个评估指标:对齐和一致性。这两个指标能够有效地评估模型在图像和文本对齐方面的性能,以及模型在保持图像一致性和编辑意图方面的能力。

三、应用前景与实例展示:InstructPix2Pix的突破

HQ-Edit的应用前景广阔,特别是在图像编辑领域。以InstructPix2Pix为例,这个基于深度学习的图像转换技术通过自然语言指令来指导图像转换的过程。在HQ-Edit的加持下,InstructPix2Pix的性能得到了极大的提升。

以下是一个使用InstructPix2Pix和HQ-Edit进行图像编辑的代码实例:

python

# 加载预训练的InstructPix2Pix模型和HQ-Edit数据集

model = load_model('InstructPix2Pix')

hq_edit_dataset = load_dataset('HQ-Edit')

# 选择一个示例进行编辑

example = hq_edit_dataset[random.randint(0, len(hq_edit_dataset)-1)]

input_image = example['input_image']

text_prompt = example['text_prompt']

# 使用InstructPix2Pix进行图像编辑

output_image = model.edit_image(input_image, text_prompt)

# 显示编辑结果

display_image(output_image)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

在上面的代码中,我们首先加载了预训练的InstructPix2Pix模型和HQ-Edit数据集。然后,我们随机选择一个示例进行编辑。这个示例包含了输入图像和文本提示。接着,我们使用InstructPix2Pix模型对输入图像进行编辑,并将编辑结果保存为输出图像。最后,我们使用一个函数来显示编辑结果。

通过这个代码实例,我们可以看到HQ-Edit和InstructPix2Pix的强大组合在图像编辑领域的巨大潜力。无论是在艺术创作、广告设计还是日常生活中,这种技术都将为我们带来更加便捷和高效的图像编辑体验。