- 1【微信小程序】零基础快速入门_小程序开发学习路线

- 2如何用Python编写俄罗斯方块Tetris游戏?_pygame tetris

- 3Druid数据库密码加密_druid开启数据库加密

- 4已解决java.util.concurrent.ExecutionException异常的正确解决方法,亲测有效!!!

- 5Neural Data-to-Text Generation with Dynamic Content Planning_neural pipeline for zero-shot data-to-text generat

- 6MySQL 出现 ERROR 1396 (HY000): Operation CREATE USER failed for ‘xxx’ 问题的解决方法_error 1396 (hy000): operation drop user failed for

- 7解决MacOS打开网下下载的Txt乱码_mac打开txt文件乱码

- 8谷粒商城学习笔记-18-快速开发-配置&测试微服务基本CRUD功能

- 9SQLserver链接MySQL服务器_链接服务器"sm"的 ole db 访问接口 "msdasql" 返回了消息 "[mysql][od

- 10YOLOv8改进 | 主干篇 | 低照度增强网络PE-YOLO改进主干(改进暗光条件下的物体检测模型)_yolov8低光照

通义千问7B本地急速安装部署(N卡)_qwen-7b 硬件要求

赞

踩

目标

简单本地搭建,学习体验再图其他用途,对于有pycharm的算是急速安装了。因为默认的就是

Qwen/Qwen-7B-Chat

的,所以不需要修改。高的我PC也跑不动。

环境

具备略微的python知识,知道pycharm略微的使用。也需要一些工具(都是开发的人常用的)

1、python3.10(要求大于3.8)

2、pycharm最新版本。(好处,避免环境混乱,而且有终端调用,免得来回切换)

3、github desktop

4、网络(当然不是上网那么简单,懂得都懂)

方法很多种,无非快速使用环境。而且各类说明看的人头大。

NIVIDIA最新驱动,CUDA最新驱动(见我stable diffusions的文章相关内容)。

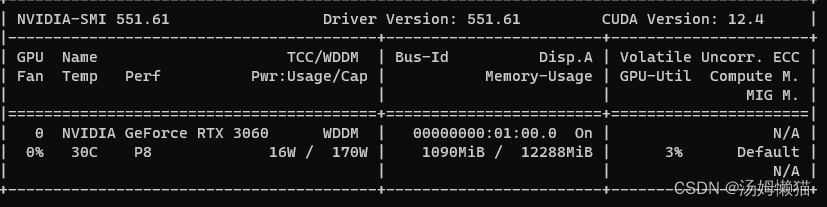

本人设备情况

I5 12代 32内存 3060rtx(12G显存)

上面的CUDA Version是能支持的cuda版本的,下面的是当前已经安装的CUDA版本。

步骤。

1、用github下载并创建一个文件夹

因为我的已经建好了,所以有那个报错。

2。使用pycharm打开这个项目文件夹

打开后,解释器会自动调用的你python(使用默认设置,即虚拟环境指向当前文件夹的venv/script).并会询问依赖文件是不是requirements.txt(也可以不管后面去软件下面的终端界面这样至少不同项目的PIP包不会乱)

3.解释器自动配置好它会自动下载requirements.txt里的依赖文件,但是requirements_web_demo.txt的内容可能需要在pycharm安装。

4.需要单独安装对应的Pytorch,我当前的cuda是12.3的,他最新的是12.1.但也能用。

PyTorch![]() https://pytorch.org/

https://pytorch.org/

把最下面生成的语句,粘到你pycharm终端

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

这个如果不装你也能用,只是你会看到内存干到90%+,回答问题奇慢无比。只用CPU不用GPU的情况,所以这个很关键。(但是我的CPU也只跑到30%多,但32G的内存基本干完,装了这个就用nvidia-smi 看就是GPU在跑了)

4.pycharm运行web_demo.py,它已经会自动下载缺失的文件。而且完成后是可以运行的。有个IP端口提示,打开之即可)

同时它也会提示优化需要下载的东西,有兴趣就继续搞了,没兴趣就可以先去看看效果了。

都完成你关了pycharm可以去命令行运行了,当然需要带你python环境的参数(就是这个文件夹的/venv/script)。