- 1一键安装tansformer_runtimeerror: failed to import transformers.pipeli

- 2计算机基础应用期中试卷,计算机应用基础期中考试计算机试卷.doc

- 3【思维与学习方法总结】面试_pdd 搜索2组

- 4大模型/NLP/算法面试题总结1——大语言模型有哪些//泛化能力

- 5速盾:高防CDN的特点与作用

- 6数据结构——树的基本知识_数据结构树的知识点

- 7医疗与大模型:重塑未来医疗生态的营销之道_医疗大模型市场需求

- 8mysql5.7配置主从_mysql5.7主从配置

- 9iOS APP 上架审核被拒Guideline 4.3 - Design,2.1,2.3.1,5.1.1解决方案_guideline 4.3(a) - design - spam

- 10Android 10 音频焦点仲裁策略分析_android audio 仲裁

深度卷积神经网络学习(CNN)_非线性映射模型的作用

赞

踩

什么是卷积神经网络

CNN:神经网络在前面的学习中我们已经了解过很多了,其本质就是多层感知机,卷积神经网络其实也一样,但是我们可以将其看成多层感知机的变种。它成功的原因在于其所采用的局部连接和权值共享的方式:

- 一方面减少了权值的数量使得网络易于优化,算力大大提高

- 另一方面降低了模型的复杂度,也就是减小了过拟合的风险

该优点在网络的输入是图像时表现的更为明显,使得图像可以直接作为网络的输入,避免了传统识别算法中复杂的特征提取和数据重建的过程,在二维图像的处理过程中有很大的优势。

2.模型构建:

CNN:首先了解卷积神经网络的四个组件:

- 卷积层(Convolution)

- 非线性映射(ReLu),即非线性激活函数

model.add(Conv2D(32,(3,3),activation='relu',padding='valid',input_shape=((28,28,1))))

- 1

- 池化层(Pooling)

model.add(MaxPool2D(2))

- 1

- 分类层(FC)

model.add(Flatten())

- 1

接下来我主要介绍卷积层和池化层

- 首先介绍卷积层,卷积层主要有以下三种特性:

- 参数共享

- 自动提取特征

- 平移不变性

卷积操作其实并不算复杂,但是他有很多种卷积方式,我们在进行卷积之后输出的图像也会和我们选择的卷积核有关,能够让维度下降、不变、甚至上升。

- 接着介绍池化层,池化层一般分为以下两种池化:

- 一般池化(最常用的池化,池化的过程中,不会将前面操作过的像素再用于池化操作)

- 重叠池化,和一般池化相反,一般池化的步长为1时,使用过的像素就会重叠,即重复使用

- 池化层的同样拥有三种特性:

- 池化无参数

- 具有降维作用

- 缩放不变

一般的池化操作我们会使用最大池化,即在选定的部分像素中,我们选择其中最大的一个像素值来作为这一部分的像素的代表,这就使得整体的数据降维,我们生活中常见的马赛克,就是池化操作产生的。

常见的卷积神经网络模型

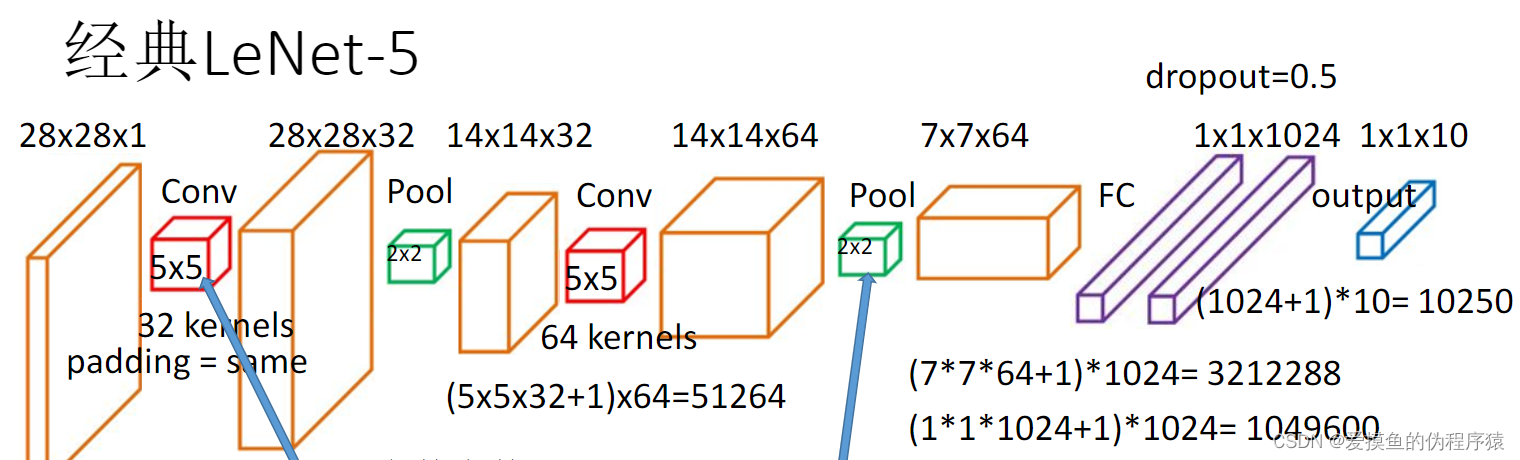

- LetNet-5模型:

Conv-Pool-Conv-Pool-FC-FC-Softmax

模型相对简单,层数也较少

-

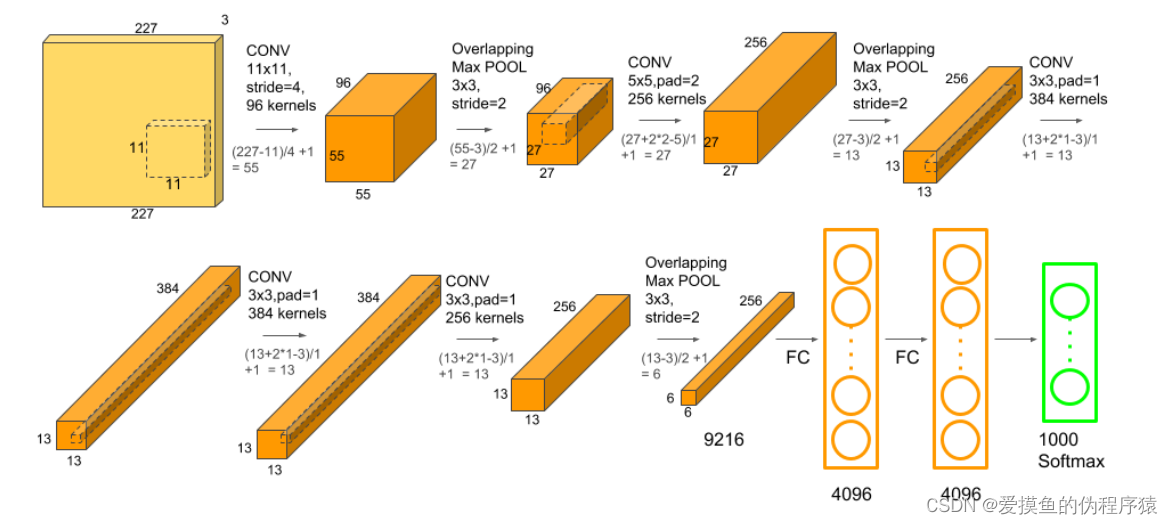

AlexNet模型:

Conv-Pool-Conv-Pool-Conv-Conv-Conv-Pool-FC-FC-Softmax -

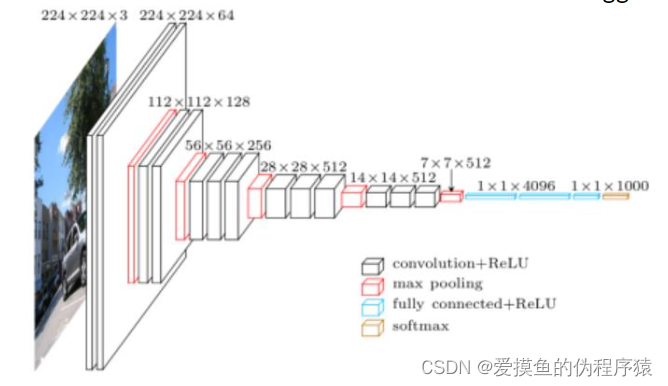

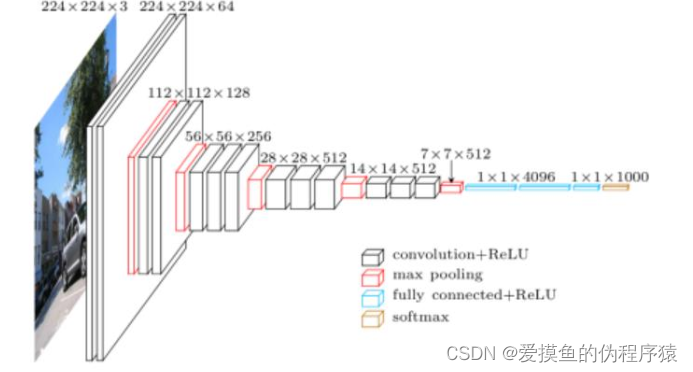

VGG-16模型:

Conv-Conv-Pool-Conv-Conv-Pool-Conv-Conv-Conv-Pool-Conv-Conv-Conv-Pool-FC-FC-FC-Softmax -

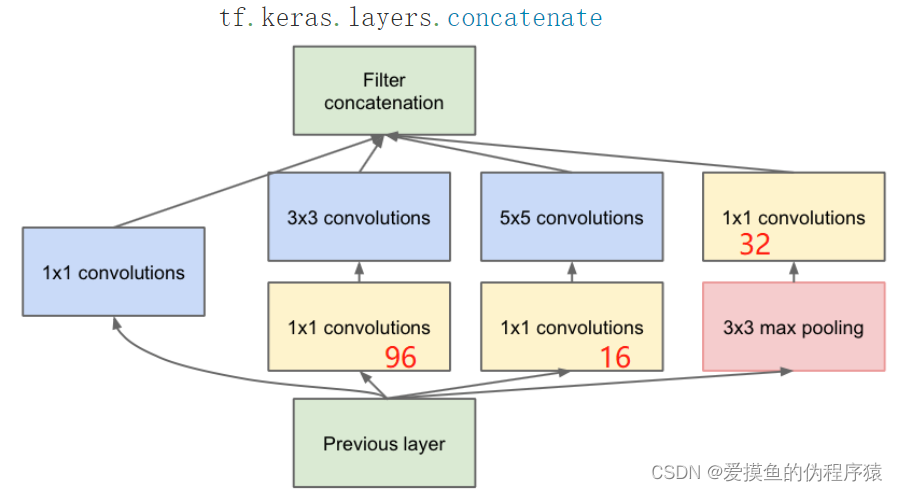

GoogleNet模型(Inception V1)

是一种既有深度又有宽度的模型,具有以下功能:

- 实现跨通道的交互和信息整合

- 可以把不同特征图组合

- 全连接可以看作1X1卷积操作

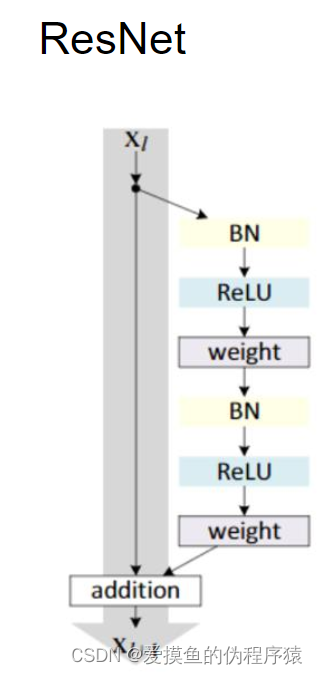

- ResNet模型:

该模型使用ReLu函数用于激活,改善了梯度消失的问题,使信息前后向传播更加顺畅

- 提升了参数利用率

- 底层的特征也进行了充分的传递,泛化性较好

- Loss对底层参数有一定的影响,能较容易地进行训练

3.实验过程:

- 手写数字集测试:

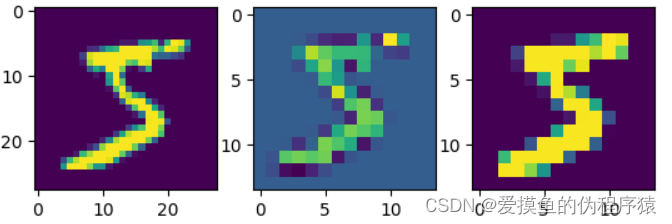

- 首先我们对比一下,图片在经过卷积或者池化操作之后,跟原图会有什么区别

# TensorFlow 卷积池化 import tensorflow as tf import matplotlib.pyplot as plt import numpy as np (x_train,y_train),(x_test,y_test) = tf.keras.datasets.mnist.load_data() x_train = x_train.reshape((-1,28,28,1))/255.0 x_test = x_test.reshape((-1,28,28,1))/255.0 filter = tf.constant([[-1,-1,-1],[-1,9,1],[-1,-1,-1]],dtype='float32') filter = tf.reshape(filter,(3,3,1,1)) img = tf.constant(x_train[0:1]/255.0,dtype='float32') conv_img = tf.nn.conv2d(img,filter,strides=[1,2,2,1],padding='SAME') pool_img = tf.nn.max_pool(img,[1,2,2,1],[1,2,2,1],padding="VALID") # window_size,stride print(conv_img.shape) plt.subplot(131) plt.imshow(tf.squeeze(img)) plt.subplot(132) plt.imshow(tf.squeeze(conv_img)) plt.subplot(133) plt.imshow(tf.squeeze(pool_img)) plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

由于我们采用的卷积核的特性,将一些较大的值都滤掉了,反观池化,虽然较大的值都保留了,但是同样损失了很多细节。

- 接下里,我们构建一个经典LeNet-5的卷积神经网络,进行手写数字的识别

import tensorflow as tf from tensorflow.keras.layers import * from tensorflow.keras.models import Sequential (x_train,y_train),(x_test,y_test) = tf.keras.datasets.mnist.load_data() #tf.keras.datasets.mnist.load_data() #tf.keras.datasets.fashion_mnist.load_data() x_train = x_train.reshape((-1,28,28,1))/255.0 x_test = x_test.reshape((-1,28,28,1))/255.0 y_train = tf.keras.utils.to_categorical(y_train,10) y_test = tf.keras.utils.to_categorical(y_test,10) model = Sequential() model.add(Conv2D(32,(3,3),activation='relu',padding='valid',input_shape=((28,28,1)))) model.add(MaxPool2D(2)) model.add(Conv2D(32,(3,3),activation='relu',padding='same')) model.add(Flatten()) #FC,将二维图片展平成一维向量 model.add(Dense(128,activation='relu')) model.add(Dense(10,activation='softmax')) model.compile(optimizer=tf.keras.optimizers.Adam(), loss=tf.keras.losses.categorical_crossentropy,metrics=['accuracy']) model.fit(x_train,y_train,batch_size=128,epochs=20) print(model.evaluate(x_test,y_test))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

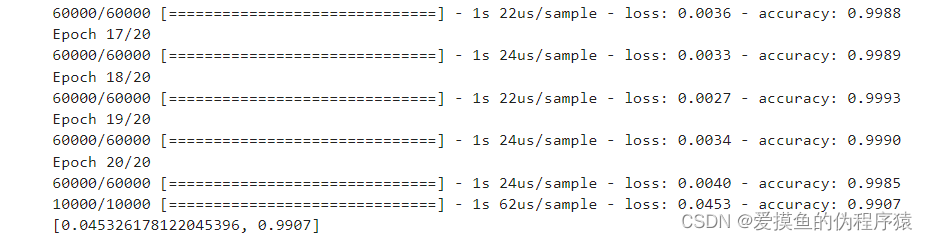

从上述代码中,我们可以发现,这个卷积神经网络中,我们使用了两个卷积层、两个最大池化层、两个全连接层

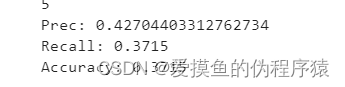

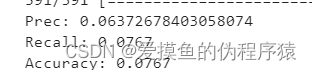

- 我们得到的精度如下:

- Alex-net模型:(主要为8层)

Conv-pool-Conv-pool-Conv-Conv-Conv-pool-FC-FC-Softmax分类输出

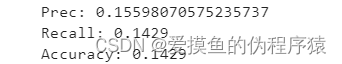

- 初始框架优化效果:

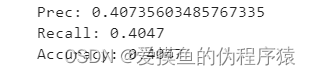

- 将卷积核的数目核batch_size扩大一倍后:

- 感觉精度不高的原因是模型太简单,我们在原模型的基础上增加一层卷积

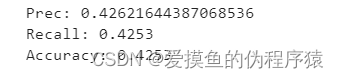

效果不错,再也不是乌龟爬式的增长了 - 再加两层卷积之后再池化

- 重复上述操作

精度的提升很小,说明靠这种方法来提升精度已经达到了极限值

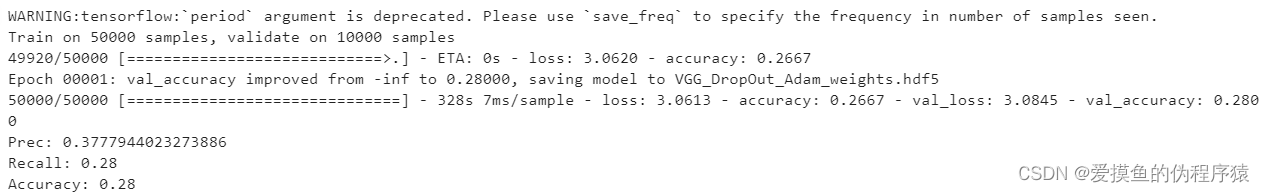

- VGG16模型:(卷积核3x3;池化核2x2,步长为2,即不重叠池化)

从上图我们可以看到,该模型由最大池化层分隔,总共分隔成了6块,其中五块为卷积层,一块为全连接层。且每一次的卷积都使得输入和输出的图像大小不变,只有在池化时变为原来的一半,最后由三层全连接层输出

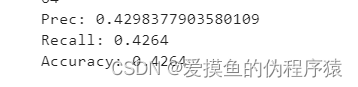

- 略微增大卷积核个数,得到精度如下:

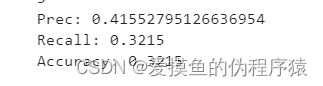

- VGG16模型的层数实在是太多了,以至于我觉得该模型应该是属于过拟合的状态,我决定将其简化,原本的VGG16模型有5个模块,删去最后一个,剩下四个模块。

稍微提升了一些

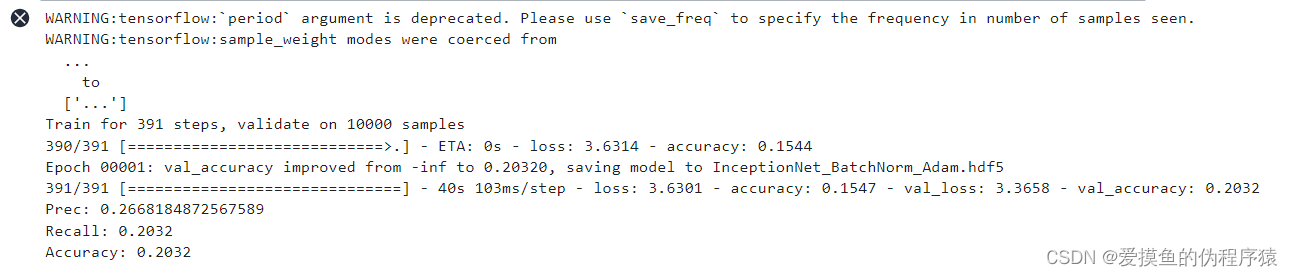

- InceptionNet模型:(更多的支路,更宽的神经网络)

-

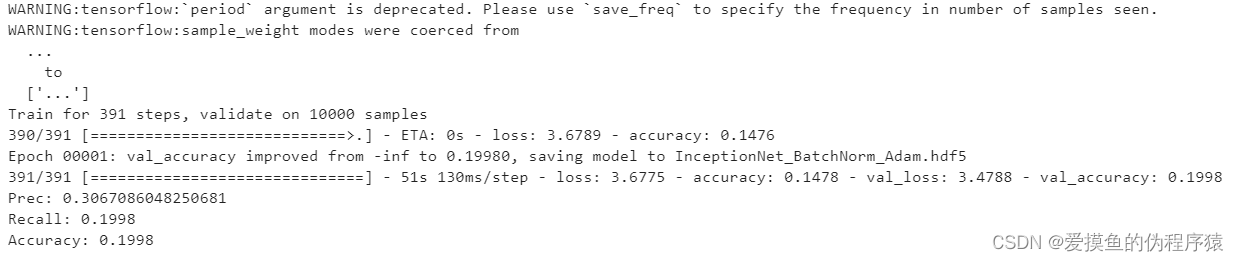

该模型初次的精度如下:

-

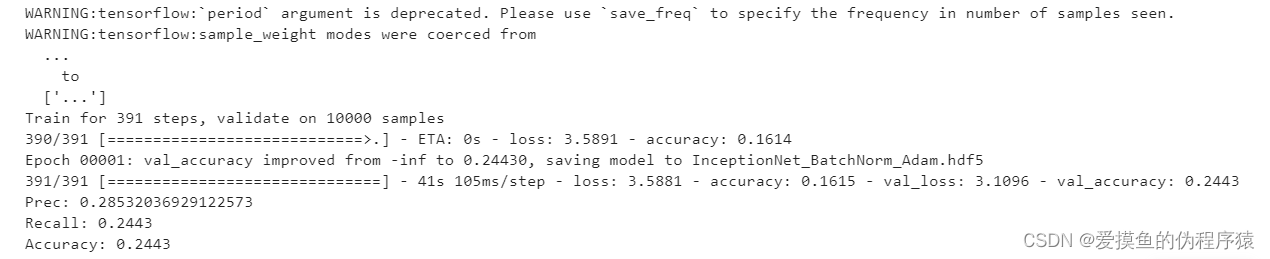

我们知道,卷积核可以提取突破的特征,初步设想,给定较多的卷积核,便能提取更多特征,那么最后的精度应该会高。所以将原来的卷积核个数翻倍,得到的结果如下:

看来这招在这里并不合适 -

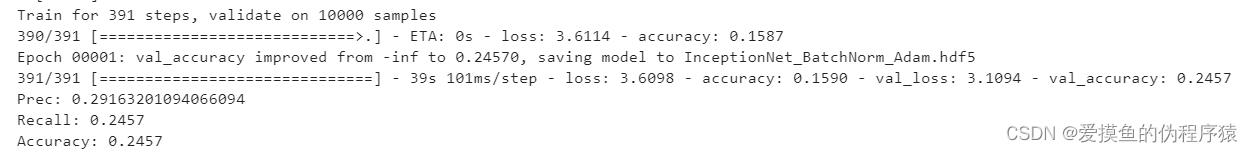

既然增加卷积核的个数行不通,索性让神经网络变得更深一些

精度下降了,看来单纯地深化神经网络,也不一定就能达到最好的效果,太复杂的模型很有可能会过拟合,导致精度下降。 -

删去一层深度之后,效果似乎有所好转

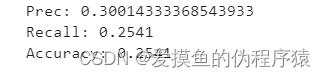

-

增加一条支路,让其模型变成5条支路,3层深度

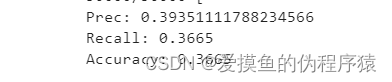

- ResNet模型:

- 初始精度大概是0.126左右,稍微添加了一层卷积,结果精度直接降低一半

- 删去两层卷积

总结

总的来说对几个常见的卷积神经网络结构有了一定的了解,无非就是卷积、池化、归一化、全连接的各种组合,在调试优化模型的过程中我也进行了很多尝试,有了一定的收获。调参是门技术活,而我只会没脑子的瞎调