- 1【运维工程师的出路,你还在迷茫吗?】

- 2学习数据库系统概论这一篇就够了_奇亿登录地址 加1.5.9.5.9.5.0嘉

- 3云计算就业现状如何?“高薪难求”的云计算运维人才,未来前景还有多好?

- 4【vscode】ssh通过跳板机连接内网服务器_ssh 跳板机

- 5windows terminal美化教程_windows terminal 美化

- 6Guitar Pro中输入音符的方法_guitar pro连接符杠

- 7oracle drop column 多个,ORA-39726: unsupported add/drop column operation on compressed tables

- 8【今日CV 计算机视觉论文速览 第124期】Tue, 4 Jun 2019_natural image noise dataset

- 9作为一名程序员,如何开展自己的副业?月赚三万的真实故事_编程技术如何自己创业

- 10127单词接龙(广度优先搜索、双向广度优先搜索)_单词接龙广度优先搜索+优化建图c语言完整写法

实战评测!YOLOv5和YOLOv8哪个更适合动态机器人开发?

赞

踩

点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:3D视觉工坊

添加小助理:dddvision,备注:方向+学校/公司+昵称,拉你入群。文末附行业细分群

扫描下方二维码,加入3D视觉知识星球,星球内凝聚了众多3D视觉实战问题,以及各个模块的学习资料:近20门视频课程(星球成员免费学习)、最新顶会论文、计算机视觉书籍、优质3D视觉算法源码等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

0. 这篇文章干了啥?

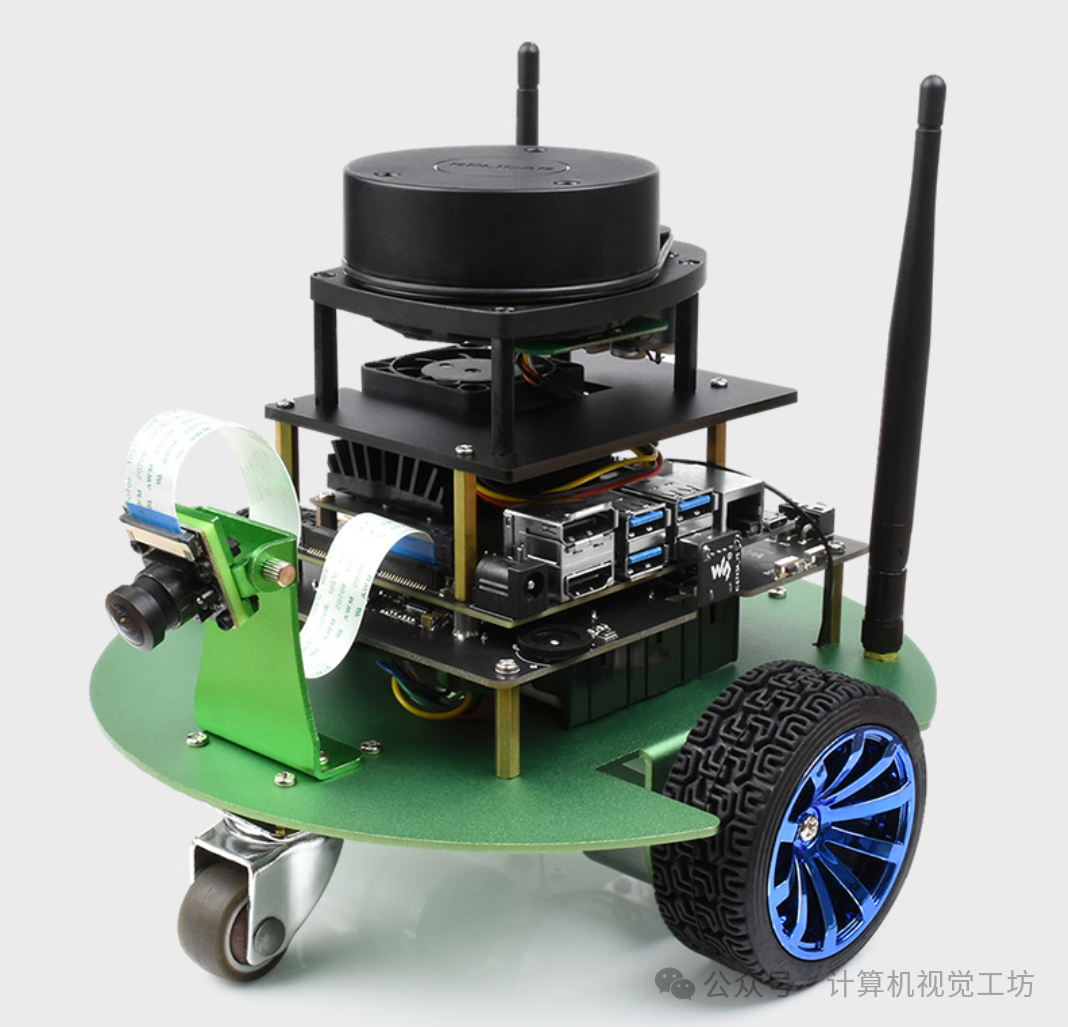

自2007年以来,每年在日本茨城县筑波市举办的筑波挑战赛是一项技术挑战。其目的是增强在现实世界中与人们相同环境下运行的自动驾驶技术。来自各个组织的参与者通过开发移动机器人、进行实验和分享成果来努力推动技术进步。

机器人系统的实用性在多个领域都显而易见,如自主导航、监控和环境监测等。在这些领域中,地面机器人在导航和理解复杂环境中发挥着至关重要的作用。筑波挑战赛见证了现实世界自主导航技术的进步,重点在于移动机器人与人类环境的无缝集成。这一挑战凸显了鲁棒性目标检测能力的重要性,而本研究正是针对这一点进行探讨。

针对强调检测和分类特定对象(如交通标志和箱子)的2023年筑波挑战赛,本研究通过提供几种YOLO模型的比较分析来做出贡献,包括最新的迭代版本如YOLOv8。尽管YOLOv8在特征融合和空间注意力等方面有所改进,但本文对每个模型在机器人应用中的适用性保持批判性观点,特别是在实时处理能力和对不同设置的适应性方面。

这项工作旨在全面评估这些模型在地面机器人相关的一系列场景中的表现,从而评估它们在检测精度、处理效率以及室外导航任务中的实际部署方面的性能。

下面一起来阅读一下这项工作~

1. 论文信息

标题:Precision and Adaptability of YOLOv5 and YOLOv8 in Dynamic Robotic Environments

作者:Victor A. Kich, Muhammad A. Muttaqien, Junya Toyama, Ryutaro Miyoshi, Yosuke Ida, Akihisa Ohya, Hisashi Date

机构:筑波大学

来源:2024 CIS

原文链接:https://arxiv.org/abs/2406.00315

2. 摘要

实时对象检测框架的最新进展引发了对其在机器人系统中应用的广泛研究。本研究对YOLOv5和YOLOv8模型进行了比较分析,挑战了后者在性能指标上普遍被认为的优越性。与初步预期相反,YOLOv5模型在对象检测任务中展示了相当甚至在某些情况下更优的精度。我们的分析深入探讨了导致这些发现的基本因素,检查了模型架构复杂度、训练数据集差异和现实世界适用性等方面。通过严格的测试和消融研究,我们提出了对每个模型能力的深入理解,为机器人应用中对象检测框架的选择和优化提供了见解。这项研究的意义在于设计更高效且上下文自适应的系统,强调了在评估模型性能时采用整体方法的必要性。

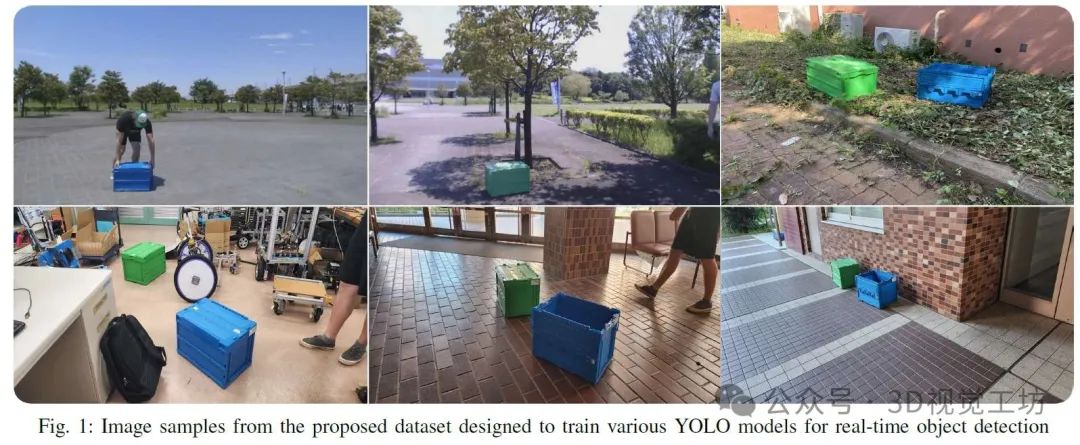

3. 图像样例

4. 主要贡献

本研究的贡献列举如下:

对YOLO模型进行广泛评估,强调这些框架在机器人建图中的实际应用,以应对现实世界的环境复杂性。

开发了一个针对所提出任务的特定需求定制的新颖的1700张图像数据集,解决了研究中概述的挑战。应用了多种数据增强技术来增强数据集的多样性和鲁棒性。

对不同YOLO版本进行详细性能比较,重点在于提高动态设置中目标检测的鲁棒性和效率。

本文通过研究先进目标检测技术与其在机器人系统中的应用的交集,旨在促进关于提高自主机器人在不同环境中操作能力的广泛讨论。

5. 基本原理是啥?

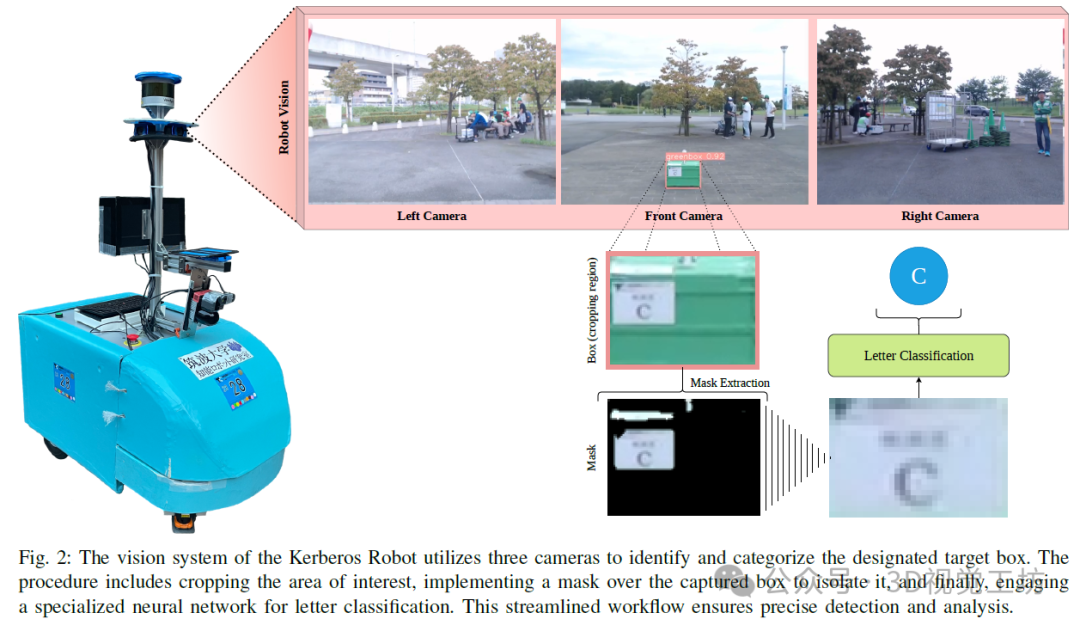

我们的研究采用了实证方法来仔细研究YOLOv5和YOLOv8框架的性能细微差别。研究方法分为两个方面:首先,使用为机器人目标检测设计的标准化数据集来实现和训练模型;其次,通过一系列指标分析训练后模型的性能,主要关注mAP和精确率-召回率值。图2展示了解决所提出任务的方法概述。

实验涉及在精选数据集上训练YOLOv5和YOLOv8模型,该数据集包含用于机器人视觉任务的标注图像。训练过程持续了200个周期,批处理大小为16,使用恒定的学习率0.01,并根据设置为20个周期的耐心参数采用早停法。YOLOv8和YOLOv5模型均从在ImageNet数据集上预训练的权重进行了微调。

A. 优化技术

显然,类别平衡的实现支持了模型在不同类别间实现检测能力的均匀性。这在模型之间平衡的精确率和召回率上尤为明显,确保没有单一类别主导检测过程,这对于机器人应用的多样化需求至关重要。

通过重点关注频繁出现误分类的具有挑战性的样本,如区分蓝色盒子和蓝色天空,难负样本挖掘显著减少了误报。这在机器人学中至关重要,因为区分相似对象可能意味着正确导航和潜在碰撞之间的区别。

mAP的改进,尤其是在不同的光照和环境条件下,强调了领域适应技术的有效性。这一技术增强了模型的鲁棒性,使它们能够在不同的环境中可靠地运行——这是机器人在现实条件下运行所必需的重要属性。

应用高级后处理技术,如非极大值抑制(NMS)和变化的IoU阈值,提高了检测精度。这在精度指标上持续保持高性能得到了证明,这对于确保机器人基于可靠数据做出决策至关重要。

调整模型的深度和宽度以适应特定用例已被证明可以在不牺牲准确性的前提下优化计算效率。较小的模型表现出了惊人的鲁棒性,特别是在计算资源有限的环境中,这是移动机器人常见的场景。

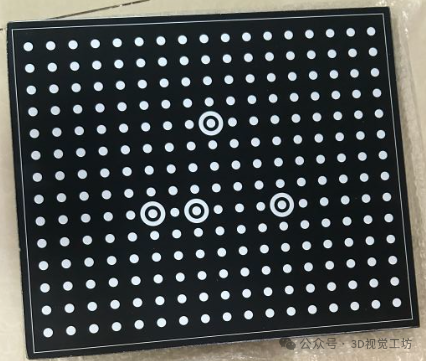

B. 数据准备和模型训练

用于训练的数据集是为了代表机器人系统可能遇到的各种场景而组装的。它包含了各种光照条件、遮挡和角度,以挑战模型的泛化能力。图像在各个类别之间均匀分布,以确保类别平衡,并进行增强以模拟机器人的操作环境。YOLOv8和YOLOv5模型都经过了严格的训练,特别关注可能影响其实际性能的超参数的微调。

C. 消融研究见解

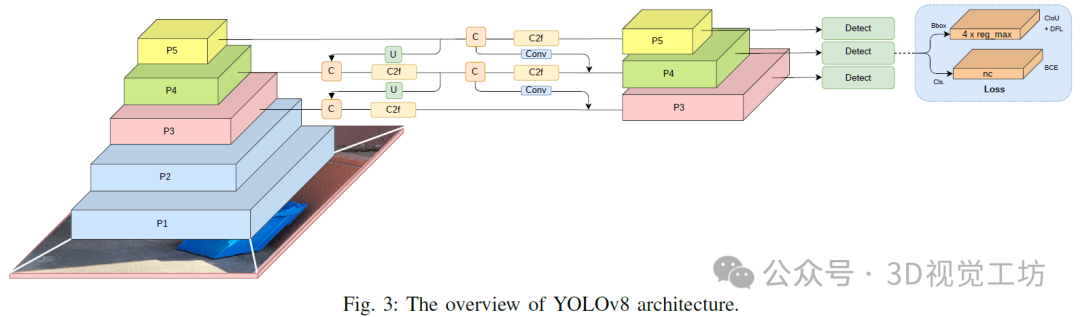

我们进行了消融研究,以了解各种因素对模型性能的影响。我们研究了类别平衡、难例挖掘、领域适应、后处理技术和模型大小调整对精确率和召回率值的影响。初步结果表明,虽然YOLOv8模型受益于架构优化(图3),但这并不一定能在机器人应用中经常遇到的复杂现实场景中转化为更高的精确率。相反,YOLOv5模型的成熟训练过程和优化可能是其稳健精确率性能的贡献因素。后续部分将详细分析消融结果,揭示模型架构、训练范式和数据集特性之间的复杂动态关系。

、

、

6. 实验结果

进行的消融研究通过包括类别平衡、难负样本挖掘、域适应、后处理技术和模型大小调整在内的各种优化技术,深入洞察了YOLOv8和YOLOv5模型的性能提升和局限性。该研究严格评估了每个因素如何为机器人应用的整体性能做出贡献。

A. 性能评估

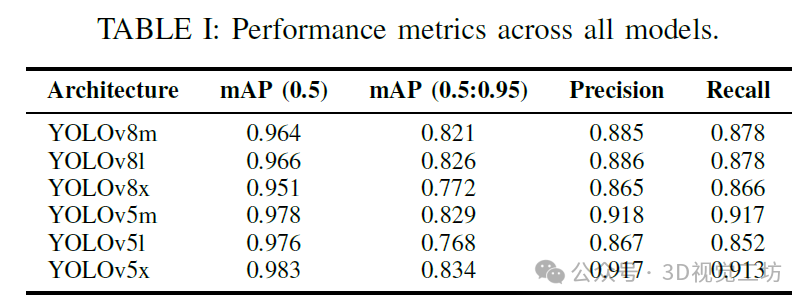

性能评估主要关注两个不同IoU阈值下的mAP:0.5(对象检测的标准)和0.5:0.95(考虑一系列IoU阈值的更严格度量)。计算了精确率和召回率,以反映模型在识别对象时的准确性和完整性。

如表I所示,尽管YOLOv8在架构进步方面预期具有优势,但YOLOv5模型在精确率方面显示出了竞争力,特别是“m”和“x”配置。这一意外结果促使我们更深入地探索可能导致这一结果的模型训练和数据处理的特定方面。

B. 性能指标分析

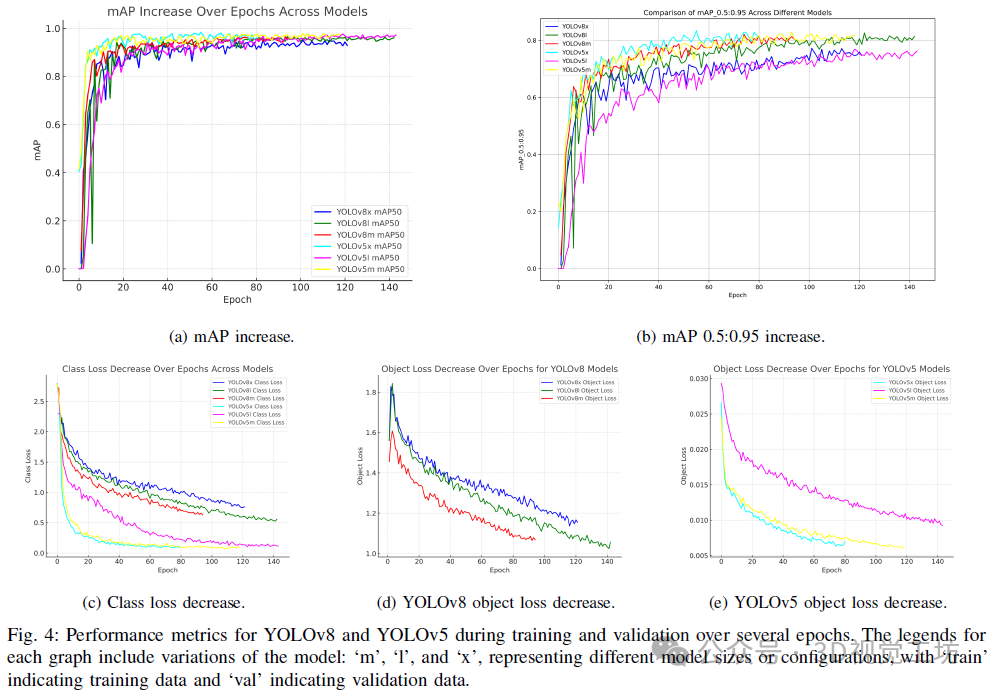

如图4a和4b所示,YOLOv8和YOLOv5模型的平均精度均值(mAP)随着训练周期的增加均表现出显著的改进,其中YOLOv5模型通常略优于YOLOv8,尤其是在更严格的mAP 0.5-0.95指标上。这可能是由于YOLOv5模型针对处理和多样且复杂的对象类别进行了更成熟的训练过程和架构优化。

类损失和对象损失曲线(图4c、4d和4e)显示了一致的下降趋势,这表明两种模型架构都实现了有效的学习和适应。然而,YOLOv5模型在对象损失方面表现出更快速且稳定的下降,这表明它在不同对象检测中的泛化能力更强,这对于机器人导航中的动态环境至关重要。

C. 对机器人应用的启示

这项消融研究的结果表明,虽然像YOLOv8这样的新型模型架构提供了显著的进步,但YOLOv5模型中所固有的特定调整和优化在目标检测任务的精确度和可靠性方面提供了竞争优势。这些见解为优化深度学习模型以在机器人中实现实用和高效的应用指明了清晰的道路,其中准确性、速度和适应不同环境的能力至关重要。对不同优化如何影响模型性能的深入理解不仅有助于为特定机器人任务选择适当的模型,还指导了未来机器人视觉系统的发展。这些结果鼓励在模型选择和训练上采取更加细致入微的方法,主张在超越纯粹架构进步的同时,综合考虑各种因素的平衡。

D. 比较性能的见解

YOLOv5模型在某些配置下表现出更高的精确度,这表明针对YOLOv5的优化可能与所使用的数据集特性更为匹配。这些优化可能包括在不同尺度上更好的特征表示或更有效的背景类抑制。此外,对ImageNet的精细预训练可能为YOLOv5模型提供了针对给定检测任务更鲁棒的特征集,凸显了预训练数据集和预训练过程的重要性。

YOLOv5的架构成熟度与精心准备的训练数据集的融合,挑战了“新模型自然具有更好性能”的预设。它表明,数据集复杂性和模型架构之间的相互作用比先前所认识到的更为重要。我们的研究建议,在机器人应用中的模型选择标准需要发生范式转变,强调实际测试和性能分析,而非假设的模型优越性。

7. 总结 & 未来工作

本研究对YOLOv5和YOLOv8模型在机器人应用中的性能进行了批判性评估,特别关注先进对象检测框架的微妙动态。通过广泛的消融研究和严格分析优化技术,如类别平衡、难负样本挖掘、域适应、后处理技术以及模型大小调整,研究表明,尽管像YOLOv8这样的新模型提供了显著的技术进步,但它们并非在所有指标上都普遍优于旧版本。事实上,YOLOv5模型在检测任务中经常表现出更高的精确度和可靠性,强调了基于特定操作环境而非仅基于模型新颖性来选择模型的重要性。

这项研究的发现不仅突出了为机器人应用量身定制的模型训练和优化的关键作用,还提出了在部署对象检测模型时向更加应用导向的方法转变的范式。在未来的工作中,我们计划将这些发现集成到现实世界的机器人系统中,进一步在动态环境中测试这些模型,以提高其效率和准确性。这不仅有助于推动机器人导航和交互技术的最新进展,还有助于确保充分利用技术进步的优势,增强自主系统在复杂多变环境中的操作能力。

对更多实验结果和文章细节感兴趣的读者,可以阅读一下论文原文~

本文仅做学术分享,如有侵权,请联系删文。

3D视觉工坊交流群

目前我们已经建立了3D视觉方向多个社群,包括2D计算机视觉、大模型、工业3D视觉、SLAM、自动驾驶、三维重建、无人机等方向,细分群包括:

2D计算机视觉:图像分类/分割、目标/检测、医学影像、GAN、OCR、2D缺陷检测、遥感测绘、超分辨率、人脸检测、行为识别、模型量化剪枝、迁移学习、人体姿态估计等

大模型:NLP、CV、ASR、生成对抗大模型、强化学习大模型、对话大模型等

工业3D视觉:相机标定、立体匹配、三维点云、结构光、机械臂抓取、缺陷检测、6D位姿估计、相位偏折术、Halcon、摄影测量、阵列相机、光度立体视觉等。

SLAM:视觉SLAM、激光SLAM、语义SLAM、滤波算法、多传感器融合、多传感器标定、动态SLAM、MOT SLAM、NeRF SLAM、机器人导航等。

自动驾驶:深度估计、Transformer、毫米波|激光雷达|视觉摄像头传感器、多传感器标定、多传感器融合、自动驾驶综合群等、3D目标检测、路径规划、轨迹预测、3D点云分割、模型部署、车道线检测、Occupancy、目标跟踪等。

三维重建:3DGS、NeRF、多视图几何、OpenMVS、MVSNet、colmap、纹理贴图等

无人机:四旋翼建模、无人机飞控等

除了这些,还有求职、硬件选型、视觉产品落地、最新论文、3D视觉最新产品、3D视觉行业新闻等交流群

添加小助理: dddvision,备注:研究方向+学校/公司+昵称(如3D点云+清华+小草莓), 拉你入群。

3D视觉工坊知识星球

3D视觉从入门到精通知识星球、国内成立最早、6000+成员交流学习。包括:星球视频课程近20门(价值超6000)、项目对接、3D视觉学习路线总结、最新顶会论文&代码、3D视觉行业最新模组、3D视觉优质源码汇总、书籍推荐、编程基础&学习工具、实战项目&作业、求职招聘&面经&面试题等等。欢迎加入3D视觉从入门到精通知识星球,一起学习进步。

3DGS、NeRF、结构光、相位偏折术、机械臂抓取、点云实战、Open3D、缺陷检测、BEV感知、Occupancy、Transformer、模型部署、3D目标检测、深度估计、多传感器标定、规划与控制、无人机仿真、三维视觉C++、三维视觉python、dToF、相机标定、ROS2、机器人控制规划、LeGo-LAOM、多模态融合SLAM、LOAM-SLAM、室内室外SLAM、VINS-Fusion、ORB-SLAM3、MVSNet三维重建、colmap、线面结构光、硬件结构光扫描仪,无人机等。

3D视觉相关硬件

| 图片 | 说明 | 名称 |

|---|---|---|

| 硬件+源码+视频教程 | 精迅V1(科研级))单目/双目3D结构光扫描仪 |

| 硬件+源码+视频教程 | 深迅V13D线结构光三维扫描仪 |

| 硬件+源码+视频教程 | 御风250无人机(基于PX4) |

| 硬件+源码 | 工坊智能ROS小车 |

| 配套标定源码 | 高精度标定板(玻璃or大理石) |

| 添加微信:cv3d007或者QYong2014 咨询更多 | ||

点这里

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。