热门标签

热门文章

- 1《软件测试52讲》读书笔记 —— 你真的懂测试覆盖率吗?

- 2linux ubuntu 安装搜狗输入法后无法输入中文_搜狗输入法linux版本,输入时只出现英文

- 3使用QEMU搭建U-Boot+LinuxKernel+busybox+NFS嵌入式开发环境_qemu uboot 网络

- 4图像哈希:全局+局部提取特征_全局特征提取

- 5苹果电脑玩Windows游戏怎么实现 mac想玩windows游戏怎么办 parallels desktop激活密钥 虚拟机玩游戏_mac玩windows游戏

- 6Linux搜狗输入法不能打中文_搜狗输入法linux版无法输入中文

- 7display变量 Linux,linux DISPLAY变量

- 8使用LangChain构建问答聊天机器人案例实战(一)_langchain的实战案例

- 9谁是你项目服务开发最佳的web框架选择:Django or Flask or FastAPI?_fastapi和django

- 10Unity Shader丢失问题_unity shader 丢失

当前位置: article > 正文

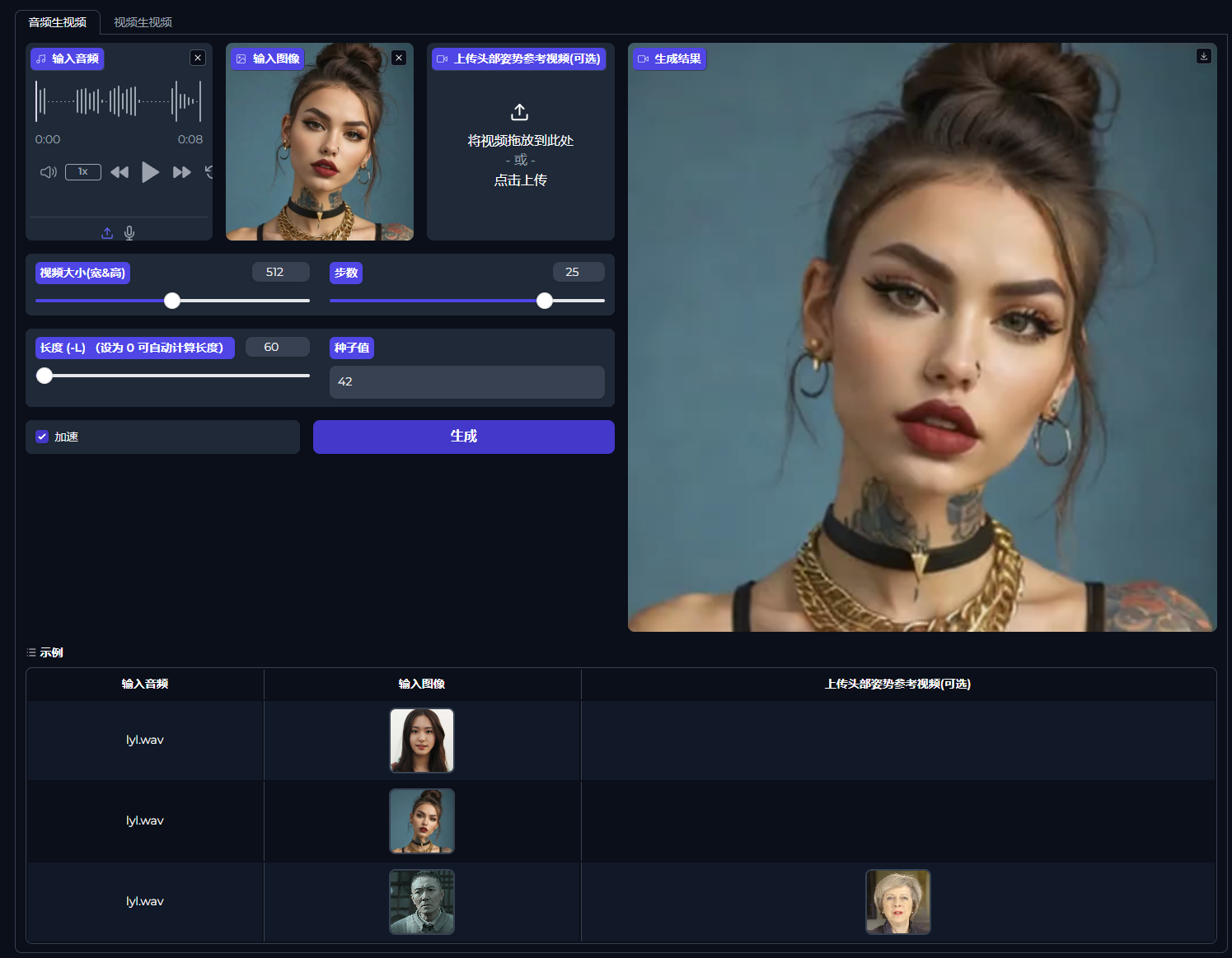

【AI数字人】AniPortrait音频驱动图片数字人本地离线整合包_aniportrait安装

作者:小舞很执着 | 2024-08-05 20:22:39

赞

踩

aniportrait安装

今天分享的项目是由华为和腾讯的研究人员联手开发的AniPortrait,只需一段音频和一个静态的肖像图像,就能生成一段数字人视频。支持音频生成视频、视频生成视频。我已经将项目打包,离线解压即可使用!(整合包在文章末尾自取)

配置要求

WIN

- Windwos10/11操作系统

- 16G显存以上的英伟达显卡

- 如果出现cuda错误,建议安装cuda11.7或以上版本

MAC

暂不支持本地离线版本

可访问在线链接进行体验(需科学上网)

https://huggingface.co/spaces/ZJYang/AniPortrait_official

使用方法

音频生视频

- 将音频文件上传到指定位置

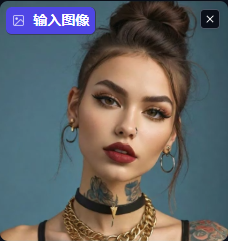

- 接着上传希望动画化的图片

- 上传一个头部姿势参考视频,这个视频将作为生成视频的人物动作姿态的参考依据。(这是一个可选选项)

- 默认的视频尺寸为512×512像素。根据自身情况进行调节。

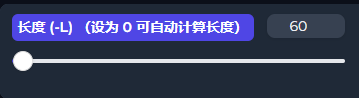

- 视频长度,默认为60,建议设定为0。根据音频计算生成长度。

- 步数,默认25。即模型处理图像的迭代次数。步数越高,生成的视频画面将越精细,但同时对计算资源的需求也越大。

- 种子值可以保持不变。

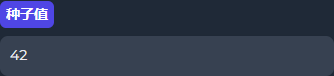

视频生视频

操作方法跟音频生视频类似,上传源视频即可。

需要注意的是,这个项目是有示例的,点击示例会自动配置示例的音频和图片,但是生成示例会很慢!建议用自己的图和音频先试下!

常见问题

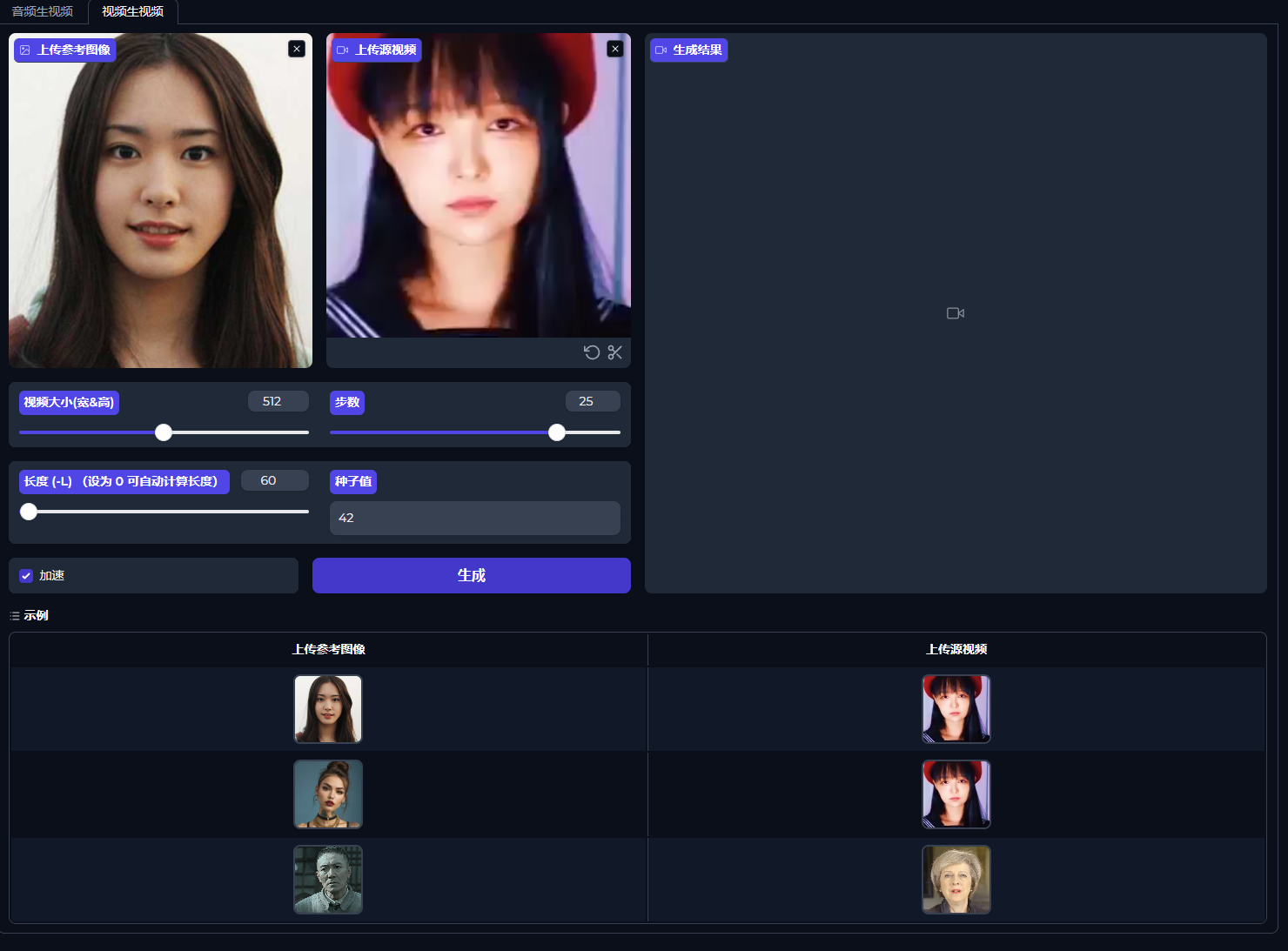

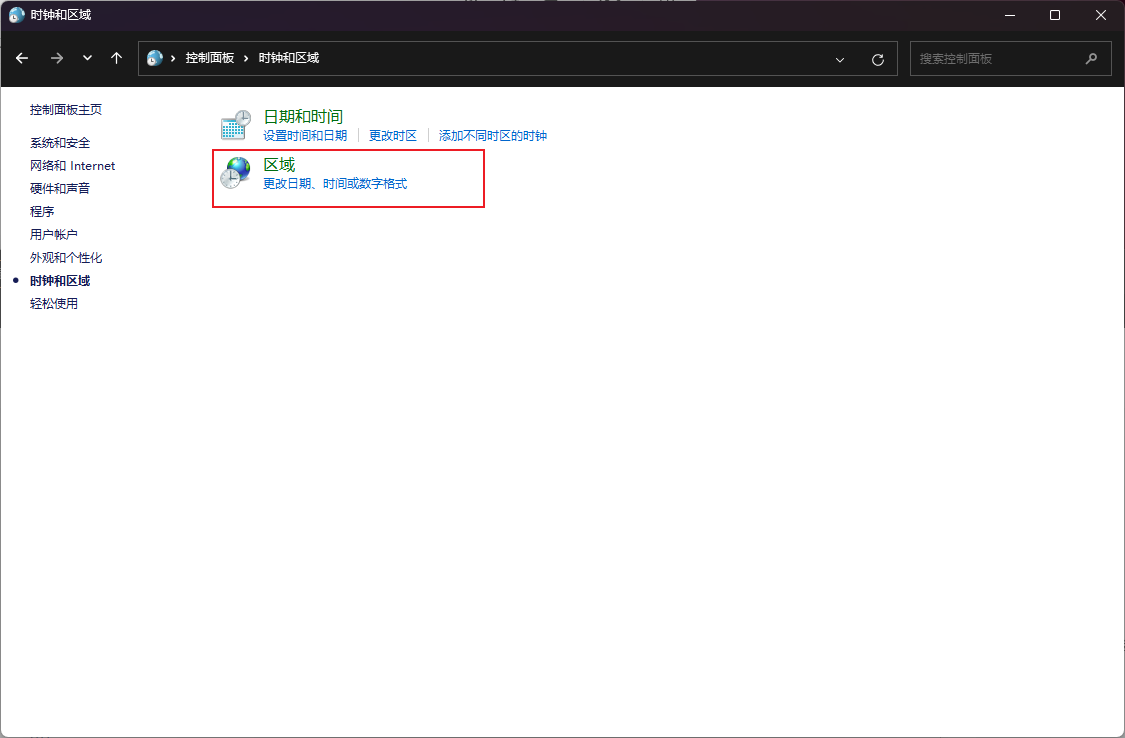

这个项目使用时可能会遇到UTF-8编码问题。

解决方法:

打开控制面板---时钟和区域

点击区域

点击管理

点击更改系统区域设置

勾选这个选项,然后重启电脑即可。

技术实现

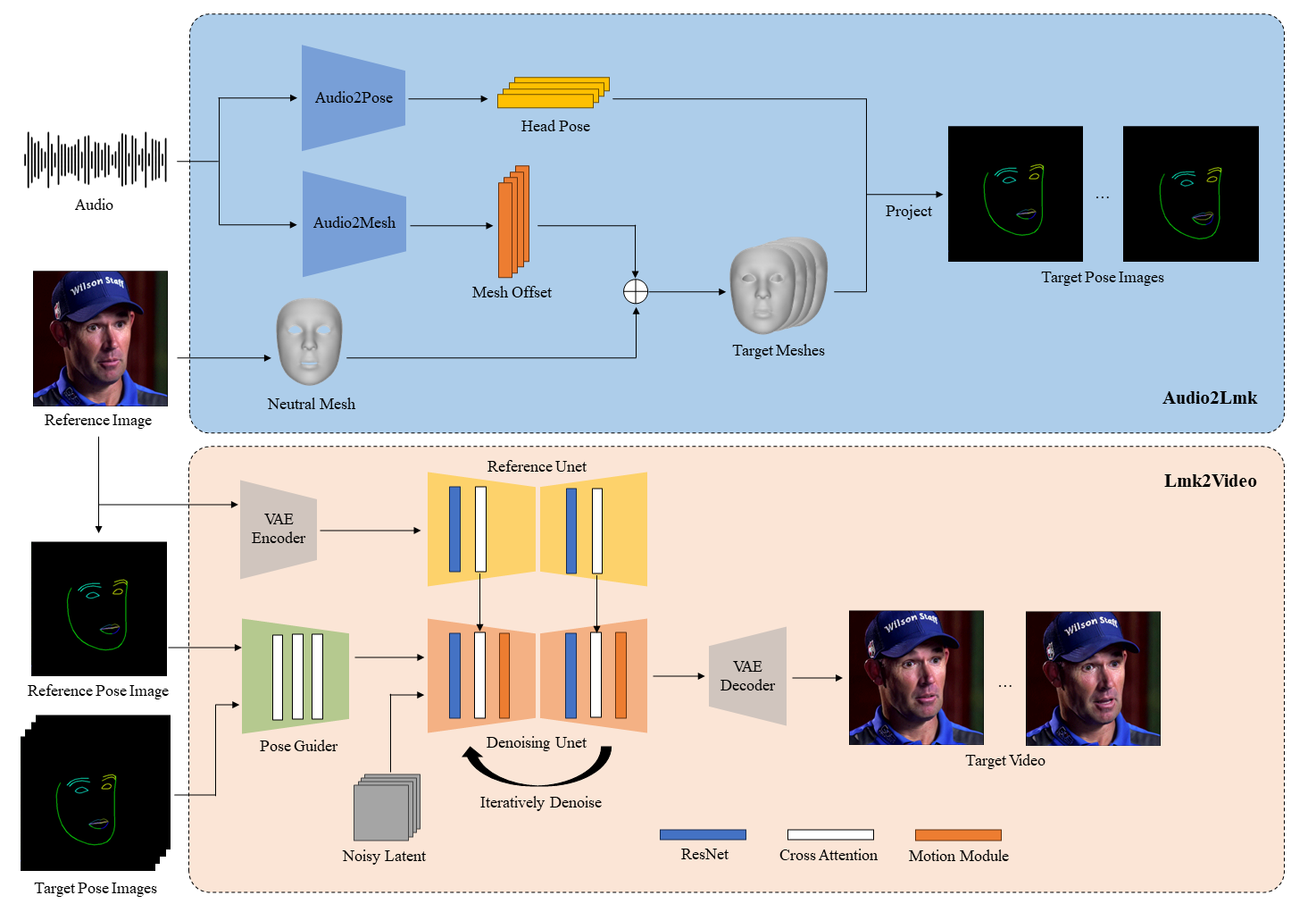

- 利用wav2vec2.0作为Audio2Lmk阶段的基础模型。

- 为了提高网络对唇部运动的敏感性,在渲染姿态图像时,将上下唇用不同的颜色区分开来。

- 所有图像被调整至512x512的分辨率进行训练。

- 音频到面部标记(Audio2Lmk)

-

- 使用预训练的wav2vec模型从音频中提取特征,这些特征能够准确识别发音和语调。

- 通过两个全连接层(fc layers),将音频特征转换为3D面部网格。

- 利用transformer解码器,结合交叉注意力机制,预测头部姿态序列。

- 面部标记到视频(Lmk2Video)

-

- 给定参考肖像图像和面部标记序列,Lmk2Video模块创建与标记序列对齐且外观与参考图像一致的时间一致性肖像动画。

- 网络结构设计灵感来源于AnimateAnyone,使用Stable Diffusion 1.5作为基础,整合了时间运动模块。

整合包获取

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小舞很执着/article/detail/934082

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。