- 1Linux yum与apt安装区别与联系_yum install apt

- 2华为OD 技术综合面,手撕代码真题整理(二一):寻找缺失的数字 | 矩阵路径最小和_华为手撕代码 csdn

- 3opencv如何利用掩码将两张图合成一张图_cv2带掩码的图像合成

- 4全方位指南:从零基础到实战精通,大模型学习教程全面解析!_大模型学习和使用_大模型实战大纲

- 5如何将heic图片转jpg图片格式?5种转换方法可以试试!_heic文件和jpg文件知乎

- 6python的selenuim爬虫爬取实例_sele爬虫点击标题跳转的链接怎么看

- 7redis服务器

- 8加密算法-BASE64_base64加密算法

- 9用哈希表封装unordered_map(以及unordered_set)【C++】

- 10linux精简指令集,精简指令集(MIPS为例)常用指令特点及其格式

每周AI行业资讯-Google、Meta、Flux、360等公司的最新资讯

赞

踩

国外厂商

Google发布Gemini 1.5 Pro和Gemma 2 2B模型

上周,Google在AI领域大展拳脚,先后发布了Gemini 1.5 Pro和Gemma 2 2B两个新模型。

Gemini 1.5 Pro 0801

-

排名第一:在LLM竞技场的综合排名中,Gemini 1.5 Pro 0801超过了GPT-4o mini,跃居第一。

-

实验版本:虽然Google称其为实验版本,还未正式发布,但已在AI Studio中提供使用。

-

多模态能力:该模型在多模态能力上表现出色,超越了GPT-4o和Claude 3.5,并支持音频和视频处理。例如,我用一个多小时的播客文件进行测试,模型在十几秒内就完成了总结。

Gemma 2 2B

-

设备端运行:Gemma 2 2B是一个可以在设备端运行的模型,得分超过了许多比它大的LLM。

-

iPhone 15 Pro:这是一个经过量化处理并结合MLX之后的模型,在iPhone 15 Pro上的运行效果非常出色。

-

安全分类器ShieldGemma:该模型内置了Google新发布的安全分类器ShieldGemma,可以有效检测仇恨言论、骚扰、性暗示内容以及危险内容。

FLUX:开源图像生成的新标杆

在SD3模型出现问题后,开源图像领域一度陷入低迷,创新和新玩法越来越少。社区急需一个强大的图像模型来推动发展。

新的希望:FLUX系列模型

前Stability AI核心成员Robin Rombach创立了一家新公司,并获得了3200万美元的融资。他们发布了一系列图像生成模型,其中两个是开源的。这些模型的质量接近Midjourney,成为开源图像生成领域的新标杆。

发布的FLUX系列模型包括:

-

FLUX.1 [pro]

-

特点:FLUX.1的最佳版,提供最先进的图像生成性能。

-

优势:拥有一流的提示跟随、视觉品质、图像细节和输出多样性。

-

-

FLUX.1 [dev]

-

用途:用于非商业应用的开放权重导向精馏模型。

-

来源:直接从FLUX.1 [pro]精馏而来。

-

特点:具有类似的质量和提示词依从能力,同时比相同尺寸的标准模型更高效,可用于非商业用途。

-

-

FLUX.1 [schnell]

-

特点:最快型号,专为本地开发和个人使用而设计。

-

许可:在Apache 2.0许可下公开可用。

-

支持:已经获得ComfyUI的支持,可以直接使用。

-

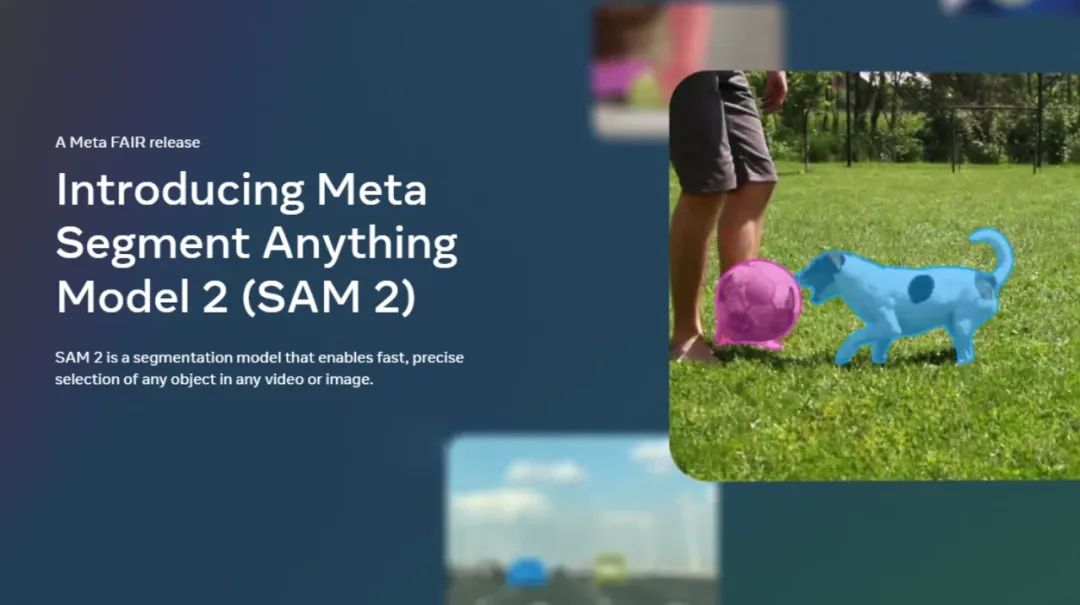

Meta发布Meta Segment Anything Model 2 (SAM 2)图像分割模型

上周,Meta在图像领域继续发力,发布了Meta Segment Anything Model 2(SAM 2)图像分割模型。

SAM 2的特点和优势

-

实时、可提示的图像和视频对象分割:SAM 2实现了视频分割体验的飞跃,实现了图像和视频应用之间的无缝使用。

-

提高的分割准确性:相比之前的模型,SAM 2在图像分割准确性方面有了显著提升,并且在视频分割性能上也取得了进展,同时需要三分之一的交互时间。

-

0-shot泛化:SAM 2可以分割任何视频或图像中的任何对象,这意味着它可以应用于以前未见过的视觉内容,无需自定义适应。

SA-V:最大的视频分割数据集

同时发布的还有SA-V,这是目前最大的视频分割数据集,具有以下主要特点:

-

巨大规模:包含大约51,000个视频和超过600,000个遮罩注释。

-

地理多样性:视频搜集自47个国家,展示了真实场景中的地理多样性。

-

覆盖面广:注释包含整个对象、对象部分以及具有挑战性的情况(例如对象被遮挡、消失和重新出现)。

应用实例

在演示中,SAM 2能够从一个非常模糊且画面复杂的航拍视频中稳定跟踪和分割指定人物,展示了其强大的分割能力。

国内厂商

360 发布了一个集合了全国 15 家模型厂商所有 LLM 模型的 AI 助手

在对所有模型进行详细测试明确了模型能力之后在利用 360 自研的搜索意图判断能力和 AI 模型路由,在用户问问题的时候用对应领域最好的模型回答。这个综合模型的效果甚至全面超过了 GPT-4o。