- 1Pandas 安装与教程_pandas库怎么安装

- 2Weblogic的了解、安装及其使用

- 3zabbix监控服务器交换机item参数参考_system.cpu.util

- 4星界边境Starbound创意工坊订阅的mod的存放路径_星界边境创意工坊mod游戏内不显示

- 5kubernetes部署分布式存储longhorn_longhorn 分布式

- 6windows命令行修改密码时(普通用户)发生系统错误_如何用cmd修改系统密码提示系统错误

- 7idea 常用的快捷键整理_在idea里面用什么快捷键看接口层框架

- 8zabbix 监控服务器CPU_zabbix监控cpu

- 9ubuntu防火墙各种配置及启动异常解决方案_ubuntu 开机bridge firewalling registered

- 10实现单例模式时synchronized的必要性_单例模式静态工厂访问为什么要加synchronized

李沐动手学习深度学习——4.1练习

赞

踩

1. 计算pReLU激活函数的导数。

pReLU激活函数公式根据课本有如下:

p

R

e

L

U

(

x

)

=

max

(

0

,

x

)

+

α

min

(

0

,

x

)

\mathrm{pReLU}(x) =\max(0, x)+\alpha \min(0,x)

pReLU(x)=max(0,x)+αmin(0,x)

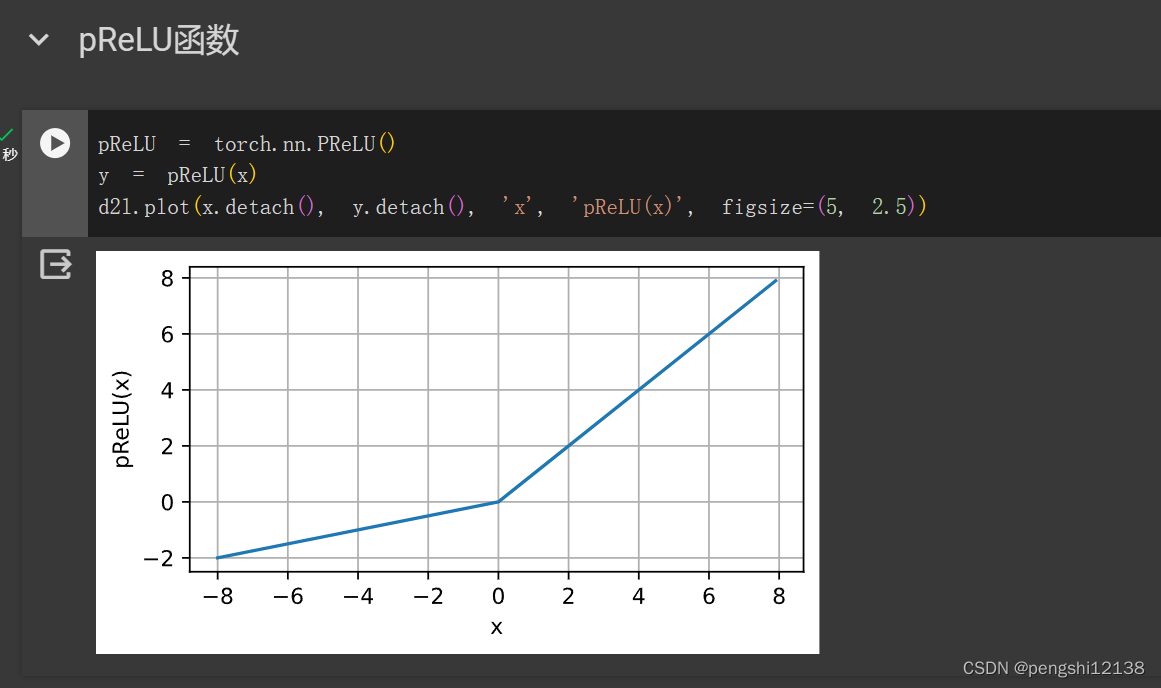

对应的函数图像为:

对应的导数计算为:

d

p

R

e

L

U

d

x

=

{

1

,

x

≥

1

α

,

x

<

1

\frac{\mathrm{d} \mathrm{pReLU}}{\mathrm{d} x} =\left \{

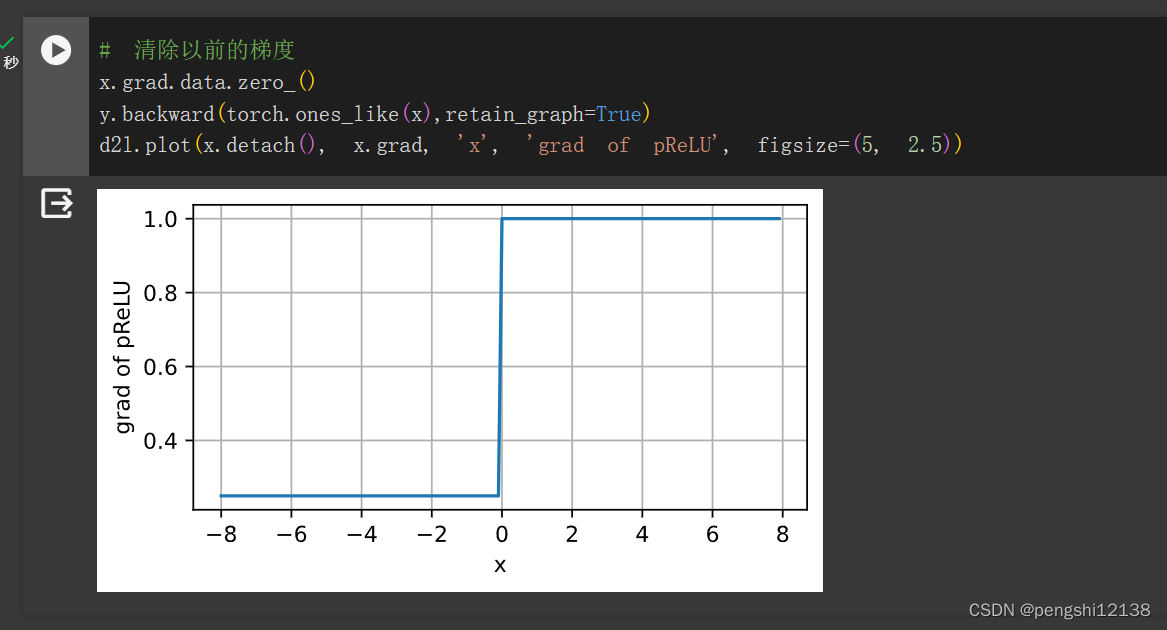

对应的梯度图像如下:

2. 证明一个仅使用ReLU(或pReLU)的多层感知机构造了一个连续的分段线性函数

- 单个ReLU构成的多层感知机是分段线性函数

- 同层多个组合ReLU构成的多层感知机同样是分段线性函数

- 多层多个组合ReLU函数构成的多层感知机,具有多个维度,同样也是分段函数

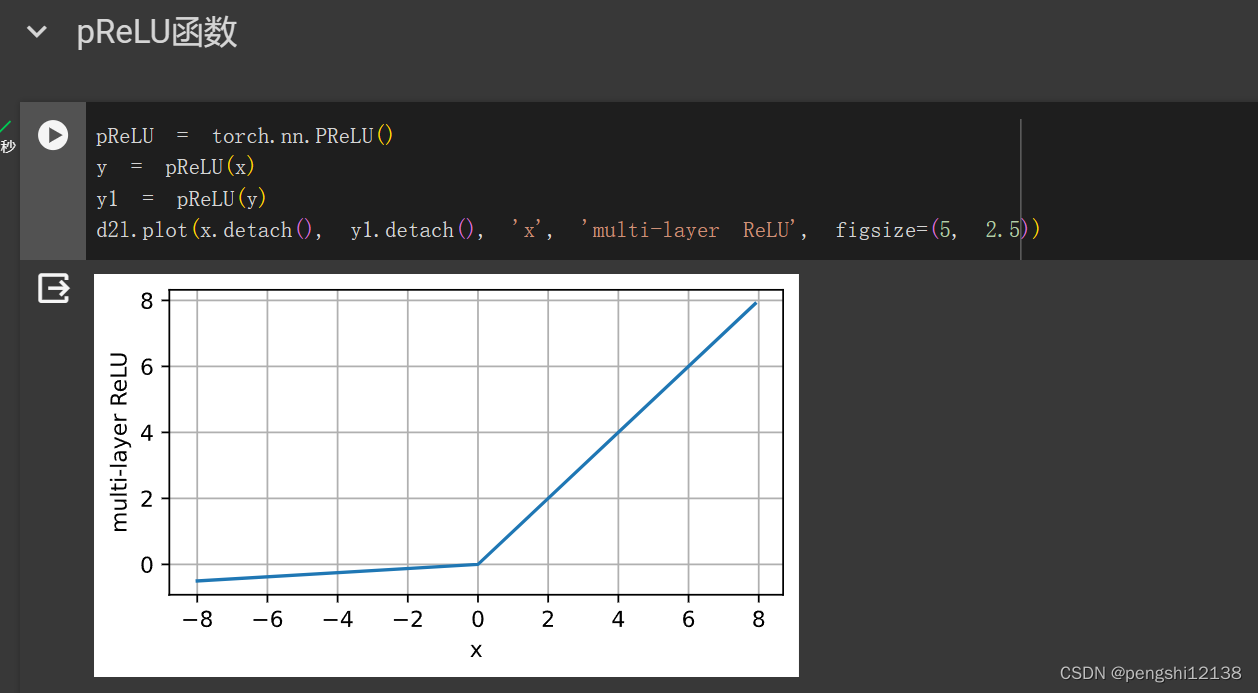

叠加两层的ReLU函数如图下,以此类推。

3. 证明

t

a

n

h

(

x

)

+

1

=

1

−

exp

(

−

2

x

)

1

+

exp

(

−

2

x

)

+

1

=

2

1

+

exp

(

−

2

x

)

=

2

s

i

g

m

o

d

(

2

x

)

4. 假设我们有一个非线性单元,将它一次应用于一个小批量的数据。这会导致什么样的问题?

数据量不够,拟合效果会比线性单元更差,梯度估计不稳定。