- 1微信小程序实现的一个登录页面Demo_微信小程序登录页面

- 2在VIm中快速缩进多行_vim怎么缩进多行

- 3容器Container--简单点

- 4GPS北斗卫星授时服务器在数字化医院系统中应用

- 5linux 密码复杂度 测试,linux密码复杂度检测cracklib模块

- 6Processing of multipart/form-data request failed. Stream ended unexpectedly

- 7STM32CubxMX配置文件,KEIL打开提示不能打开项目文件的解决方法_cubemx生成的代码用keil打开无内容

- 8使用Python实现学生成绩管理系统_python学生成绩管理系统代码

- 9OpenStack安装部署_192.168.50.200:6080

- 10您使用的App是用什么技术开发_查看app使用的什么技术

学习笔记1:Xcode vision pro 模拟器-环境/场景 模拟替换

赞

踩

xcode vision pro 模拟器

笔者首先是带着疑问开始使用这个模拟器,并尝试做做demo。

第一个问题是对于这个模拟器是否做的足够真?到底可以模拟逼真到什么程度

从各种推断来讲,这个模拟器应该是需要尽量逼真的还原实际真机体验,这个也应该是苹果的目标。

- 首先visionpro真机真的很贵, 3499美刀,apple 也不会准备太多的适配样机给到开发者;因此模拟器就显得非常重要了,理论上一些传统的应用(比如2d ipad应用直接运行),希望开发者在模拟器上测试就可以直接发布上架,无需真机,最终上架由apple工程师们在真机运行审核;

- 开发者样机真的是为那些真正开发“空间计算” app的开发者们准备的;做过arvr都应该了解,电脑上模拟运行的效果与真机实际运行的效果,可以是一个天上一个地下,没有真机真搞不定。

- vision pro比起其他的xr设备是领先x年,开发者们很难凭借目前市场上其他的xr设备来凭空想象。

- visionpro的交互逻辑与市面上已有的xr设备完全不同,而这个对于内容的设计影响非常大,同样很难靠模拟器来完成。除非就是一个完整的2d ipad应用,完全不做任何的修改。

当前使用的版本 :

Version 15.0 (1015.1)

SimulatorKit 935.1

CoreSimulator 920.3

vision os 1.0

特别不一般:环境/场景 模拟替换

所以,带着这个疑问和推断,开始了模拟器的体验,经过2天的摸索,找到了1个做的特别不一般的功能:环境可以替换;

做过vr都应该了解,通常vr桌面是有一个场景的,这个场景一般会支持用户替换和自定义,正所谓换个环境换种心情,但是这个特性在vr上,消费者好像都不怎么买账,当前的xr设备厂也没有怎么去宣传,那是可能是因为做的不够好,么有吸引到消费者;

但是visionos这个环境替换做的思路就很不一样了,这个环境是会影响到应用的呈现效果的,应用是与环境融为一体的;

当然这个里面需要很多的关键技术,也是需要大量的算力的,slam,mesh网格,光线追踪,亮度,物体材质,折射反射,物体跟踪,以及与app之间的距离等;甚至声音都可能会根据环境做不同的渲染(这个在模拟器上还没有找到,等后续再进行摸索);

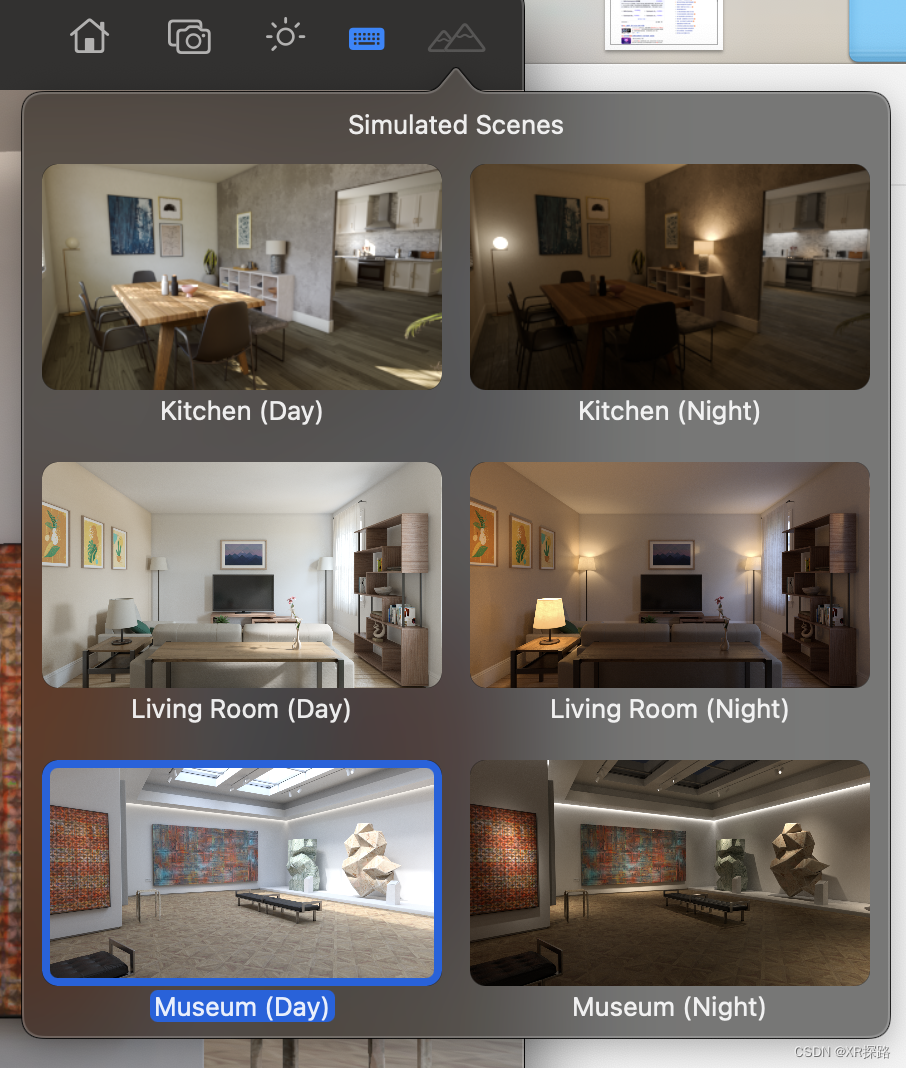

6个模拟场景

当前模拟器自带了6个模拟场景,均为室内使用场景,厨房/客厅/博物馆,分为白天和晚上;

每一个模拟场景都代表了一种用户使用情况;

- 客厅场景:还是比较容易理解的,用户在家里使用也大多是在客厅,同时这个也可以覆盖到办公场景;

- 厨房场景:难以理解。。。但是从下图中能够看到是有一个大桌子的,或许也是可以满足办公或者娱乐;

- 博物馆场景:仿佛是将博物馆带回家;

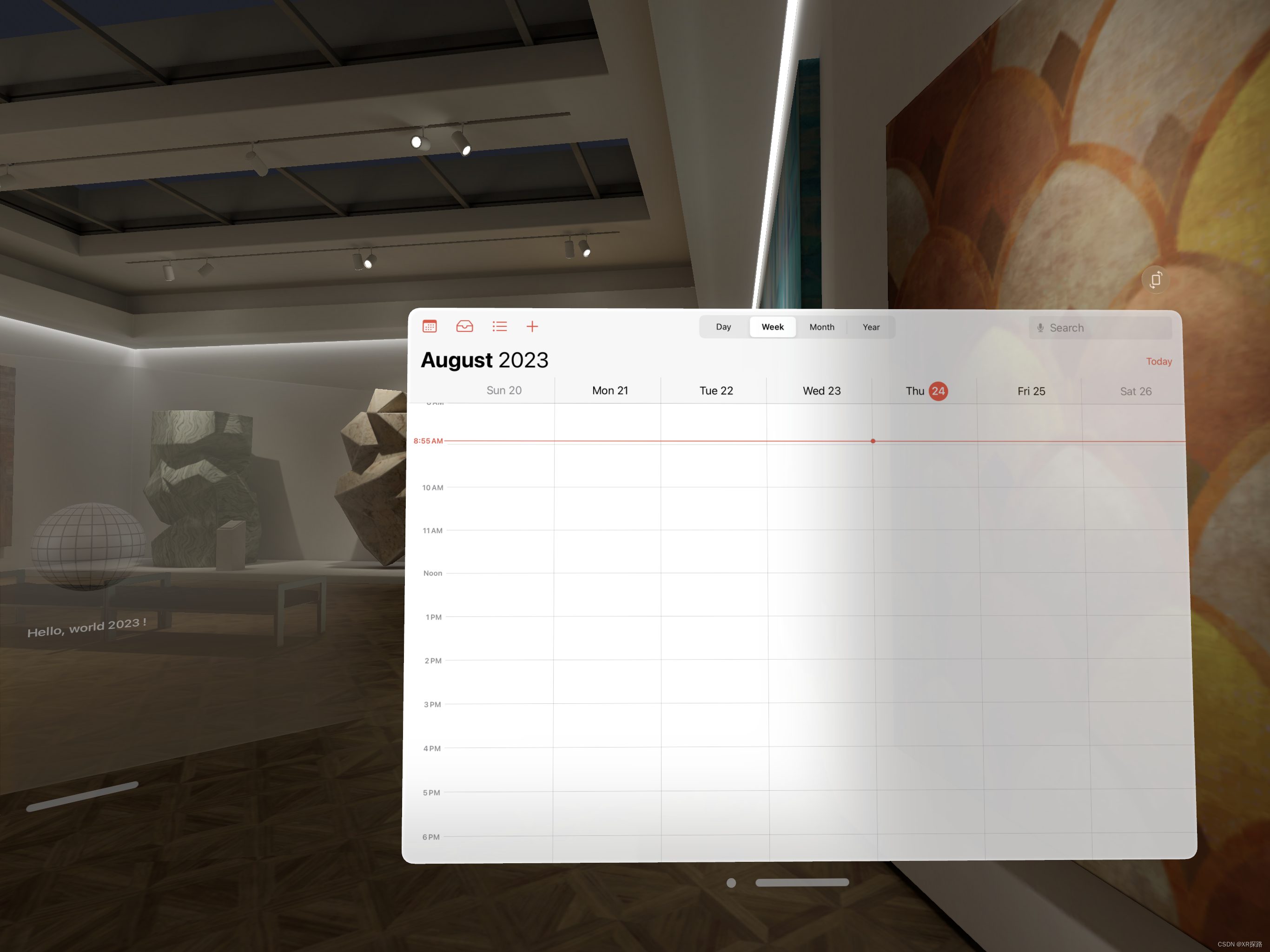

应用(日历app)+ 模拟场景

下面就以1个应用(日历)为例,在同一个环境下,不同的位置,更换不同的环境,以及应用所呈现出来的效果;

同一个环境,app锚定在不同的位置

可以发现一些差别,日历的界面在同一个环境下,在不同的位置,会根据这个环境的光线,物体材质,纹理发生变化:

当日历的界面靠近右边墙面时,透明度会渐近发生变化:同时墙面背景能够呈现出来。

同一个应用,在不同的环境

小结:

vision pro 的vst(video see through) ,不仅仅是让用户能够看到外界实际空间,而且visionpro凭借强大的算力,将这个外界空间进行了“理解”,包括空间里面的各种物体表面,材质,实际光照强弱等等进行理解甚至重建,同时APP(GPU生成的虚拟的内容)能够根据实际的空间环境发生改变,进行统一3D渲染;

苹果是希望用户能够保持与实际环境的沟通,而不是完全封闭在一个虚拟的环境中;

举个例子:你手里拿着1个虚拟的汽车模型,当你拿着汽车模型在空间中移动,而空间中的光照强度和色温都会不一样,此时你会发现汽车模型摆放在不同的空间和位置上,所呈现出来的效果会有很大的变化,就仿佛置身于真实的世界中一样;