- 1flex布局怎样让div居中_div flex 居中

- 2切片引理和两个意想不到的应用_对球体等间隔平行面切割

- 3uni-App 封装 uni.request() 发起网络请求_uni.request判断网络是否通顺

- 4强化学习SAC算法 倒立摆环境和车杆环境

- 5【同步】文件同步命令rsync |自动同步软件FreeFileSync

- 6决策树学习笔记整理_采用决策树分类法,预测该客户的拖欠贷款类别

- 7字段约束_该字段仅适用于刚体 : 刚体约束ansys

- 8前端 a链接 如何实现下载功能_a链接下载

- 9pycharm的python环境不一致情况_pycharm终端 不是虚拟环境的python

- 10网页常见布局案例解析+代码_简单页面布局代码

本地ChatGLM3-6B接入知识库!让他拥有实时知识!0基础私有化部署!19/45_docker-compose 部署chatglm3-6b

赞

踩

hi~

上一篇,我们搭建了本地的知识库应用:fastgpt!然后给知识库搭好了桥(one api),并且把本地部署的大模型Qwen-14B接入了知识库!

很多伙伴可能觉得14B的尺寸太大,本地的电脑部署不了!

所以今天!

跟着雄哥本地部署一个chatglm3-6b!用API把他接入知识库!

整体项目是这样的!

我们在纯本地的环境搭建,涉及垂类大模型+嵌入模型的部署、docker部署,都搞掂后!

使用知识库应用去搭建本地私有的知识库!

现在市场上已有大量的知识库/文档对话产品了,学会了这个部署,你基本了解到整个企业知识库部署的过程!内容如下:

day17:动手本地部署ONE-API管理工具,与知识库打通!【已更新】

day18:与知识库对话!部署Qwen-7B/14B,用API接入知识库!【已更新】

dat19:与知识库对话!部署ChatGLM3-6B,用API接入知识库!【本篇】

day20:本地部署M3e嵌入模型!接入知识库,完全体!大功告成!

day21:快速上手!3分钟动手搭建私有的知识库!

day22:进阶!三种数据处理办法,提高知识库性能!

day23:进阶!知识库可视化高级编排!

day24:进阶!自定义内容,不该说的一句不说,只聊指定内容!

day25:按部门/学科,建立知识库并分发给对应部门使用

一边做一边看大家反馈,有不清楚的,雄哥再补充!

ok!人的专注力只有10分钟!那,话不多说!

本篇在win11系统完成,需要docker+WSL子系统(非wsl不稳定)!

星球的伙伴学完【7天精通docker】,可以直接上手!

还没来得及学的,可以在星球先学!

点击加入知识星球![]() https://t.zsxq.com/15XR5BKhd

https://t.zsxq.com/15XR5BKhd

如果你还没加星球,那你一定要加啦!联系小胖参加 ‘团购’ 活动!

这个过程,任何报错,也可以找他!或者加入交流群!

最近我们在跑Agent项目,回复可能有点慢!

整个过程非常的简单!

① 下载chatglm3-6b一键包

② 以API方式本地启动

③ 接入one api中,打通到知识库!

④ 改配置文件,让知识库与大模型相认!

第一部分:下载chatglm3-6b一键包

之前雄哥都发给教程,只需要在后台回复 “傻瓜式”

傻瓜式!一键部署ChatGLM3,免去环境烦恼+开箱即用!集成API调用!本地化界面操作!

第二部分:以API方式本地启动

下载之后,你根据以上教程启动大模型!

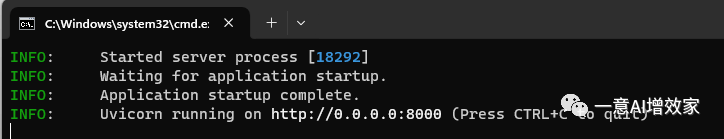

他会自动生成一个地址!眼熟吧?就是他!

第三部分:接入one api中,打通知识库!

还记得我们之前获取到的本地IP吧?不记得?乖乖去看雄哥的专栏!

按照这个顺序填入下图!然后按提交!别选错!

添加进去吧!这个url,你要看自己本地的IP是多少,不要盲目跟着这里填!

第四部分:让知识库与大模型相认!

我们要把chatglm3接入到知识库里,不然用不到的!

道理是一样的!

找到fastgpt的配置文件:‘config.json’!打开!复制qwen的配置,粘贴到下来,改成chatglm3!

保存!退出!

回到docker中!选择fastgpt,关闭!启动!

然后点击‘3000’端口!自动打开知识库配置界面!

输入账号密码登录!

来到应用这里!都可以看到qwen和chatglm3了!

雄哥家里电脑是24GB的,启动两个量化模型大概20G左右!

加上m3e,大概占用1.5G左右!同时启动,完全够用了!

当然,现在知识库还不能工作,因为现在还没有接入m3e嵌入模型,只能简单对话!还不能接入自己的数据!

下一篇,我们把嵌入模型部署好,并且接入部署one-api,直接做完成体!

星球的伙伴!

一定要打卡啦!