热门标签

热门文章

- 1NX二次开发 批量导出图纸 合并DWG_nx多个图纸页输出到一个dwg

- 2AI Stable Diffusion Prompt参数【二】之 生成效果查验_hires upscaler

- 3Hive内置函数大全(再背几遍)_hive arccos

- 4搭建一个Hadoop集群 HDFS-HA (Zookeeper自动故障转移)

- 5微服务学习|初识elasticsearch、操作索引库、文档操作、RestClient操作索引库、RestClient操作文档_elasticsearch 索引库类型

- 6使用java代码和jmeter脚本批量造数_java造数模板参数配置,一键造数

- 7this beta version of Typora is expired, please download and install a newer version.Typora的保姆级最新解决方法_无法下载this beta version of typora is expired

- 8springboot 之 单元测试

- 9USTC算法设计与分析-总结_ustc近似算法作业

- 10科研学习|论文解读——基于旅游知识图谱的游客偏好挖掘和决策支持(IPM,2023)_csdn 旅游科研

当前位置: article > 正文

NLP 算法实战项目:使用 BERT 进行文本多分类_bert多文本分类

作者:小蓝xlanll | 2024-06-02 19:21:20

赞

踩

bert多文本分类

数据

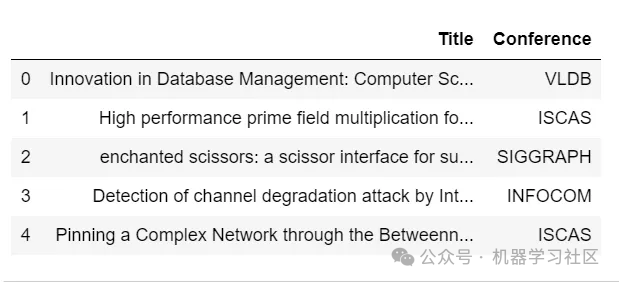

该数据集包含2,507篇研究论文标题,并已手动分类为5个类别(即会议)。

探索与预处理

- import torch

- from tqdm.notebook import tqdm

-

- from transformers import BertTokenizer

- from torch.utils.data import TensorDataset

-

- from transformers import BertForSequenceClassification

-

- df = pd.read_csv('data/title_conference.csv')

- df.head()

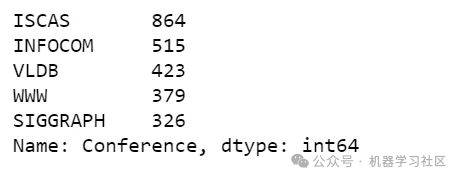

df['Conference'].value_counts()

您可能已经注意到我们的类别不平衡,我们将在稍后解决这个问题。

对标签进行编码

- possible_labels = df.Conference.unique()

-

- label_dict = {}

- for index, possible_label in enumerate(possible_labels):

- label_dict[possible_label] = index

- label_dict

![]()

df['label'] = df.Conference.replace(label_dict)

训练和验证集划分

由于标签不平衡,我们以分层的方式划分数据集,使用这个作为类别标签。

在划分后,我们的标签分布将如下所示。

- from sklearn.model_selection import train_test_split

-

- X_train, X_val, y_train, y_val = train_test_split(df.index.values,

- df.label.values,

- test_size=0.15,

- random_state=42,

- stratify=df.label.values)

-

- df['data_type'] = ['not_set']*df.shape[0]

-

- df.loc[X_train, 'data_type'] = 'train'

- df.loc[X_val, 'data_type'] = 'val'

-

- df.groupby(['Conference', 'label', 'data_type']).count()

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小蓝xlanll/article/detail/664011

推荐阅读

相关标签