- 1【Hadoop】YARN容量调度器详解_yarn 容量调度器配置

- 2基于AI的计算机视觉识别在Java项目中的使用 (二) —— OpenCV的使用_java视觉识别特征

- 3快看!UE5蓝图宝典

- 4Git 的下载与安装_git下载

- 5蓝桥杯单片机省赛题目《全集》之第十二届省赛第一场_蓝桥杯第十二届eda真题

- 6【web系列十二】element plus的一些实用技巧_element-plus

- 7element ui table表格鼠标悬浮或点击 取消高亮_elementui表格鼠标滑过不高亮当前行

- 8数据库原理及MySQL应用 | 数据库安全加固_linux数据库加固

- 9Carla简单入门-3 传感器_carla 中的传感器

- 10MinIO入门_minio 判断文件是否存在

2步生成25帧高质量动画,计算为SVD的8% | 在线可玩

赞

踩

西风 发自 凹非寺

量子位 | 公众号 QbitAI

耗费的计算资源仅为传统Stable Video Diffusion(SVD)模型的2/25!

AnimateLCM-SVD-xt发布,一改视频扩散模型进行重复去噪,既耗时又需大量计算的问题。

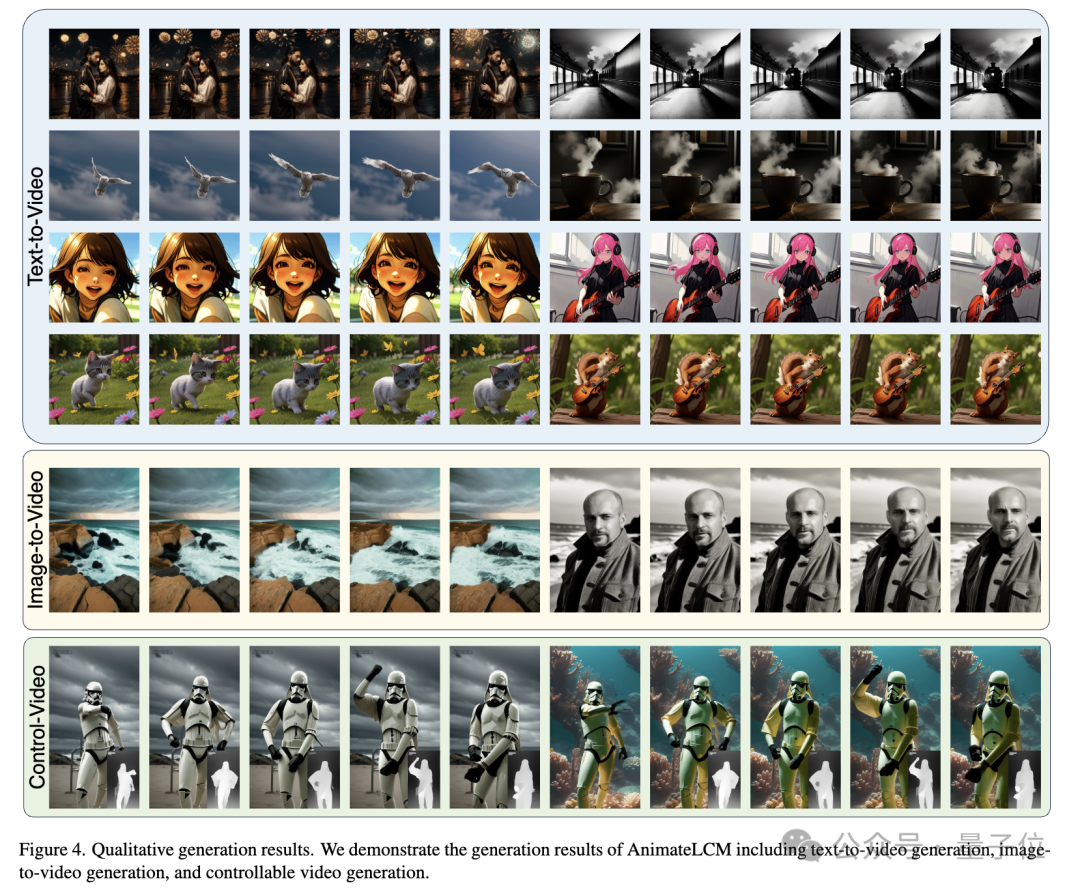

先来看一波生成的动画效果。

赛博朋克风轻松驾驭,男孩头戴耳机,站在霓虹闪烁的都市街道:

写实风也可以,一对新婚夫妇依偎在一起,手捧精致花束,在古老石墙下见证爱情:

科幻风,也有了外星人入侵地球的即视感:

AnimateLCM-SVD-xt由来自香港中文大学MMLab、Avolution AI、上海人工智能实验室、商汤研究院的研究人员共同提出。

2~8步就能生成25帧分辨率576x1024的高质量动画,并且无需分类器引导,4步生成的视频就能实现高保真,比传统SVD更快、效率更高:

目前,AnimateLCM代码即将开源,有在线demo可试玩。

上手试玩demo

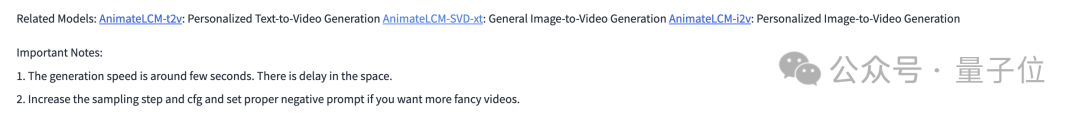

在demo界面可以看到,AnimateLCM目前有三个版本,AnimateLCM-SVD-xt是通用图像到视频生成;AnimateLCM-t2v倾向个性化文本到视频生成;AnimateLCM-i2v为个性化图像到视频生成。

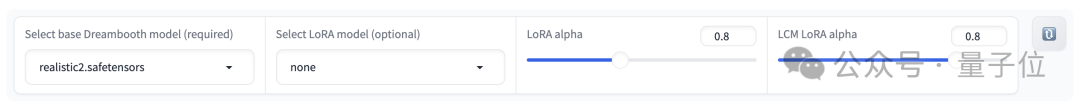

下面是一个配置区域,可以选择基础的Dreambooth模型,也可以选择LoRA模型,并通过滑动条调整LoRA alpha值等。

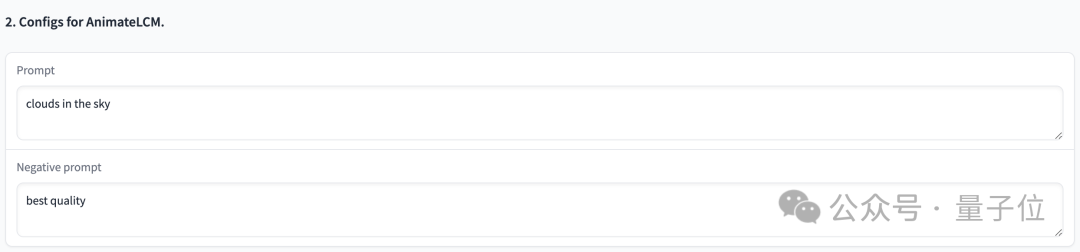

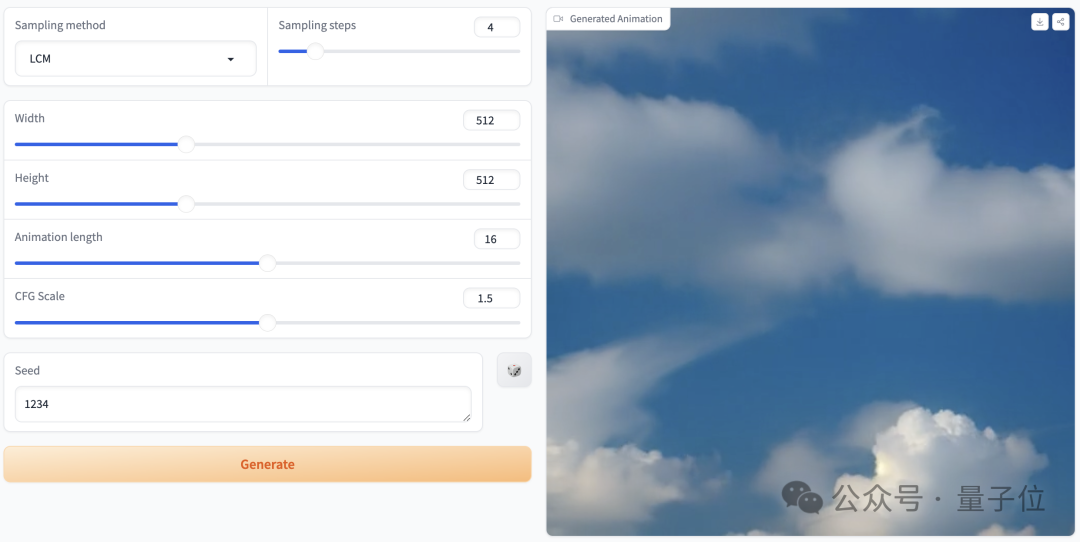

接下来可以输入Prompt、负面prompt,指导生成的动画内容和质量:

还有一些参数可以调整:

我们上手体验了一把,提示词为“clouds in the sky”,参数设置如上图,采样步骤仅为4步时,生成的效果是这样婶儿的:

采样步骤为25步时,提示词“a boy holding a rabbit”,效果如下:

再看看一波官方放出的展示效果。2步、4步、8步效果对比如下:

步数越多,动画质量越好,仅4步AnimateLCM就能做到高保真:

各种风格都能实现:

怎么做到的?

要知道,虽然视频扩散模型因能生成连贯且高保真度的视频而受到越来越多的关注,但难题之一是迭代去噪过程不仅耗时而且计算密集,这也就限制了它的应用范围。

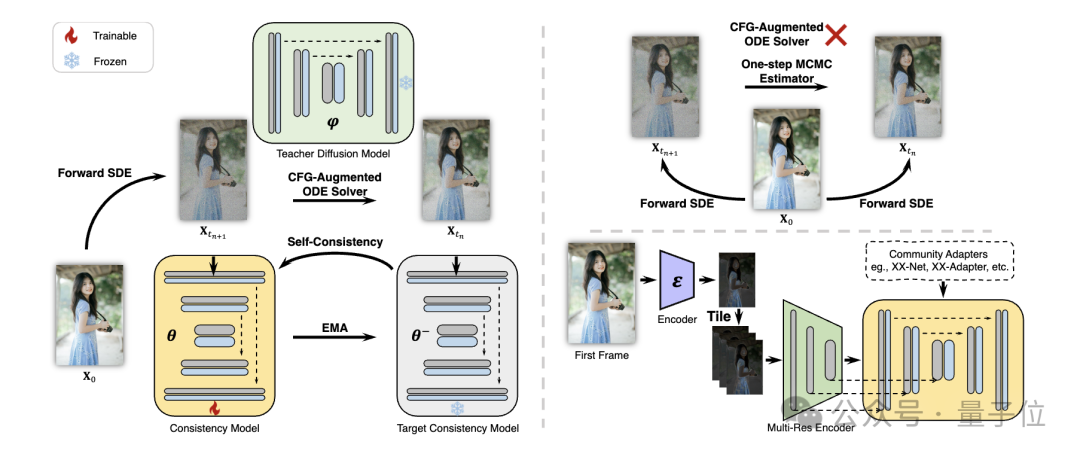

而在AnimateLCM这项工作中,研究人员受到一致性模型(CM)启发,该模型简化了预训练的图像扩散模型以减少采样所需的步骤,并在条件图像生成上成功扩展了潜在一致性模型(LCM)。

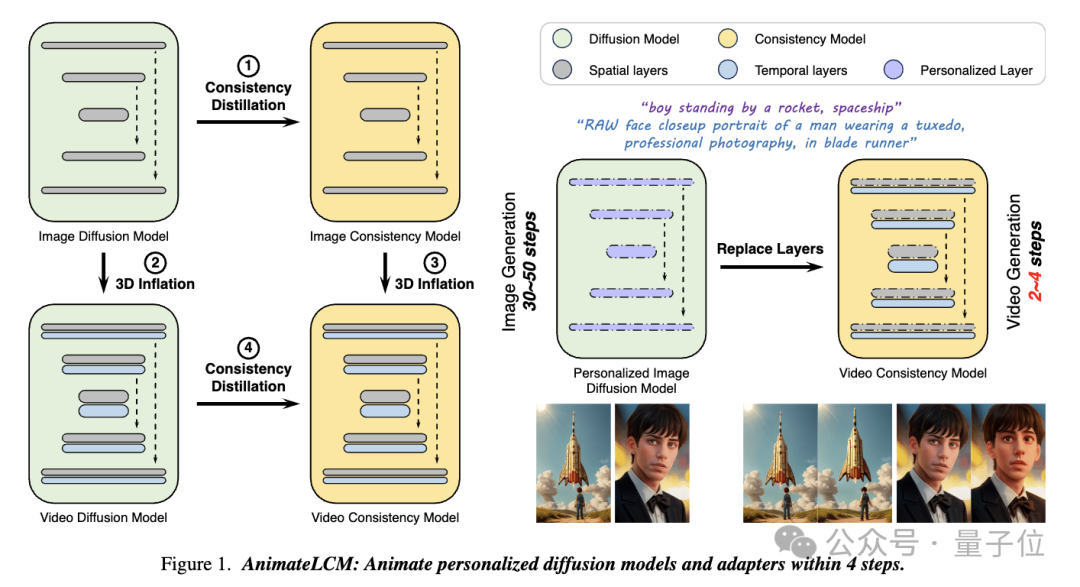

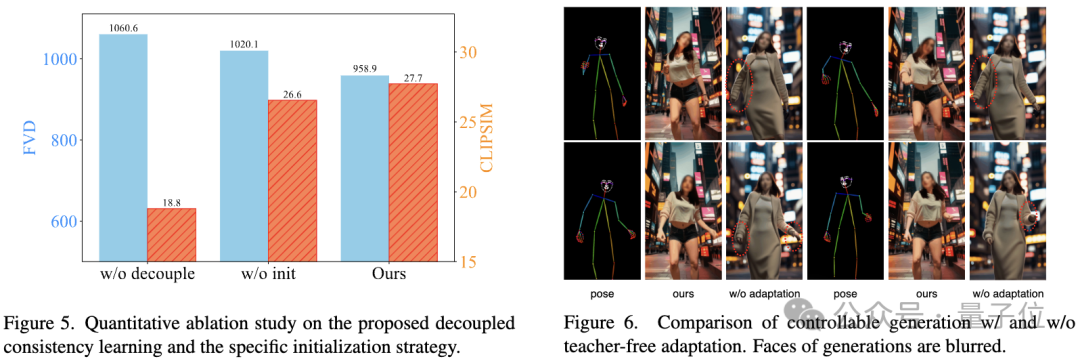

具体来说,研究人员提出了一种解耦的一致性学习(Decoupled Consistency Learning)策略。

首先在高质量的图像-文本数据集上蒸馏稳定扩散模型为图像一致性模型,然后在视频数据上进行一致性蒸馏以获得视频一致性模型。这种策略通过在空间和时间层面上分别训练,提高了训练效率。

此外,为了能够在Stable Diffusion社区中实现即插即用适配器的各种功能(例如,用ControlNet实现可控生成),研究人员又提出了Teacher-Free自适应(Teacher-Free Adaptation)策略,使现有的控制适配器更符合一致性模型,实现更好的可控视频生成。

定量和定性实验都证明了方法的有效性。

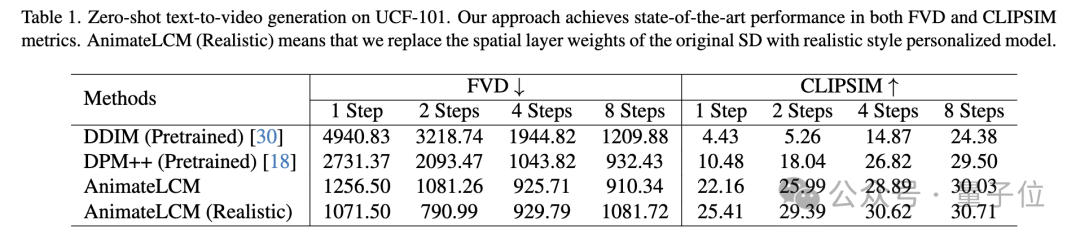

在UCF-101数据集上的零样本文本到视频生成任务中,AnimateLCM在FVD和CLIPSIM指标上均取得了最佳性能。

消融研究验证了解耦一致性学习和特定初始化策略的有效:

项目链接:

[1]https://animatelcm.github.io/

[2]https://huggingface.co/wangfuyun/AnimateLCM-SVD-xt

— 完 —

报名中!

2024年值得关注的AIGC企业&产品

量子位正在评选2024年最值得关注的AIGC企业、 2024年最值得期待的AIGC产品两类奖项,欢迎报名评选!

评选报名截至2024年3月31日

中国AIGC产业峰会同步火热筹备中,了解更多请戳:在这里,看见生成式AI的应用未来!中国AIGC产业峰会来啦!

商务合作请联络微信:18600164356 徐峰

活动合作请联络微信:18801103170 王琳玉

点这里

- 相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。