热门标签

热门文章

- 1【Python】paddleocr快速使用及参数详解_paddleocr参数

- 2linux的php探针使用,php探针在Linux下的安装过程

- 3YOLOv3目标检测算法——通俗易懂的解析_基于yolov3的目标检测

- 4【HTML】HTML、CSS基础_html css基础

- 5【Python学习笔记】Python logging模块的学习

- 6事务(ACID特性,读问题,隔离级别)_事务的读问题

- 7.NetCore项目nginx发布_.net core nginx

- 8java开发之SSM开发框架_javassm框架

- 9unity中简单背包系统_unity背包系统

- 10Android 开发之Windows环境下Android Studio安装和使用教程(图文详细步骤)_androidstudio preference window

当前位置: article > 正文

云端部署大模型 ChatGLM3-6B

作者:很楠不爱3 | 2024-03-20 10:46:51

赞

踩

chatglm3-6b

目录

ChatGLM3-6B是什么?

ChatGLM3-6B 是一个基于清华大学 KEG 实验室和智谱 AI 公司于2023年共同训练的语言模型 GLM3-6B 开发的人工智能助手。

为什么要在云端部署?

ChatGLM3-6B 是一个基于深度学习技术训练的语言模型,其训练过程需要大量的计算资源和存储空间,而且模型优化和更新也需要专业的人才进行。因此,将模型部署到云端可以解决计算资源和存储空间不足的问题,同时也可以方便地将模型部署到其他平台和设备上,提高模型的普适性和可扩展性。

在云端部署模型还可以通过云端服务提供商的计算和存储资源,对模型进行实时更新和优化,使得模型能够更好地适应用户的需求和场景的变化。此外,云端部署还可以为用户提供更加便捷和高效的使用体验,用户可以通过云端服务访问模型,无需将模型下载到本地设备上,提高了使用的效率和便捷性。

因此,将 ChatGLM3-6B 部署到云端是一种比较合理的选择,可以更好地满足用户的需求,并提高模型的性能和可靠性。

简而言之,如果本地的GPU资源比较丰富可以在本地部署,否则还是在云端部署会更加方便

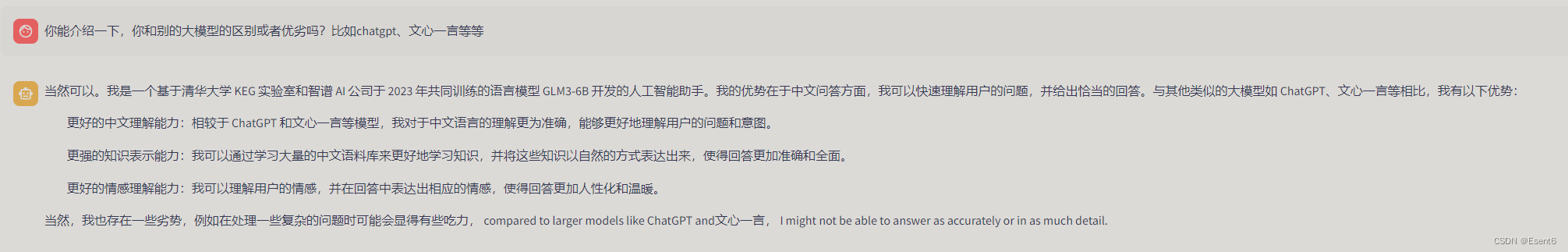

效果如何?

以下是基于部署好的ChatGLM3-6B进行的一些对话:

有何学习收获?

通过本次DataWhale组织的 《如何用免费GPU线上跑AI项目实践》,我成功在趋动云平台实现了大模型的云端部署,假如真的有一天无法使用国外的大模型,可以通过此方法搭建好云端的大模型,更加方便的进行问答。

在模型搭建的过程中,需要细心和耐心,手敲代码也很可能出现错误,无法解决的问题,可以试试重头再来QAQ。

了解到了一些关于Git相关的知识,比如克隆。

哈哈,后面可以试试利用本地的GPU资源部署大模型

具体搭建模型的教程链接:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/很楠不爱3/article/detail/272768

推荐阅读

相关标签