- 1深度学习中的验证集和超参数简介_验证集参与网络权重更新吗

- 2springboot+vue+elementui杂志在线投稿网站java_vue 电子杂志

- 3pytorch.onnx.export方法参数详解,以及onnxruntime-gpu推理性能测试

- 4(十九)DEEP SEMI-SUPERVISED ANOMALY DETECTION_deep sad

- 5NetworkX入门教程

- 62024 最新Ai对话ChatGPT系统网站源码 附搭建教程

- 7程序员职业生涯:经验与技术的平衡之道

- 8模型搭建——__init__()和forward()_def forward(self, x):

- 9从没学过建筑设计的我,使用AI绘画SD在线版5分钟就生成的效果图炸裂!

- 10python3 服务端使用CGI脚本处理POST的Json数据_python cgi获取json postman

Groq推理引擎——比GPU快18倍

赞

踩

Groq推理引擎——比GPU快18倍

https://wow.groq.com/events/

在人工智能不断发展的领域中,追求更快、更高效的语言模型(LMs)一直是推动力。最近,一项突破性的进展以Gro的形式出现,这是一种革命性的平台,可以改变LM推理速度。Gro的创新方法是通过专用硬件——语言处理单元(LPUs)来推动的,它开创了快速文本生成的新时代,展示了超越传统基于GPU的推理方法的前所未有的速度。本文将深入探讨Gro的技术、它对各个行业的影响以及它对未来人工智能应用的变革潜力。

Gro的推理速度

Gro在LM推理方面的出色速度源于其利用LPUs,这是专门设计用于处理基于语言的任务的专用硬件。与最初为图形处理而开发后来被重新用于人工智能的传统GPU相比,LPUs在计算密度和内存带宽方面提供了更高的性能,专门为顺序文本生成任务量身定制。这种策略性的架构使得Gro能够实现卓越的速度,例如每秒生成近500个标记,远远超过GPT-4和Mixr等领先竞争对手的能力。

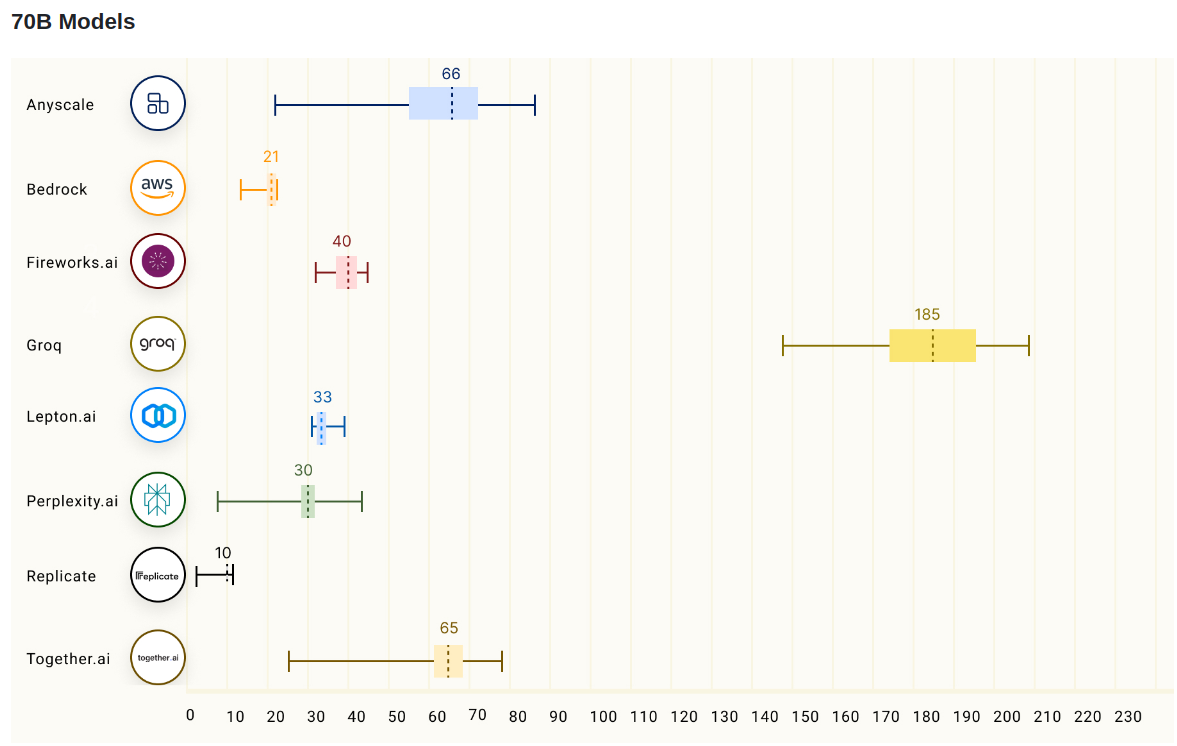

下图是70B平台上各种平台的推理速度(标记/秒)

https://github.com/ray-project/llmperf-leaderboard

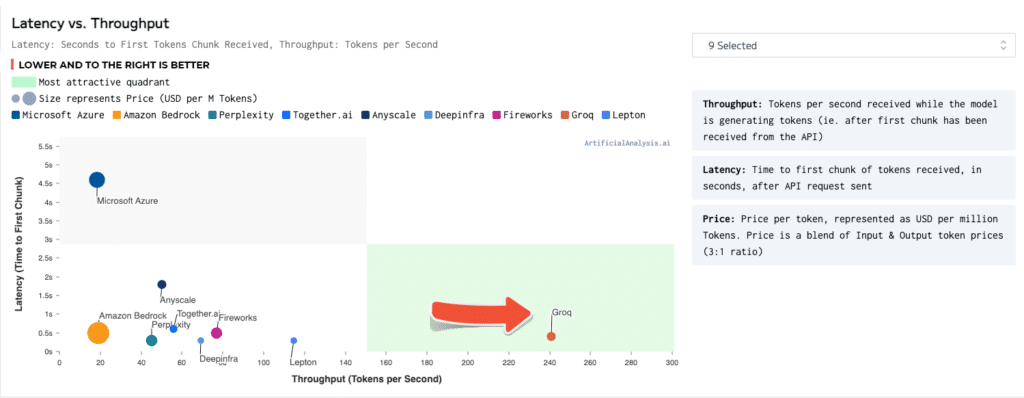

延迟与吞吐量

- **延迟:**发送API请求后,接收到第一个标记块的时间,以秒为单位

- **吞吐量:**模型生成标记时每秒接收到的标记数(即在从API接收到第一个块之后)

- 低且靠右的位置更好,绿色代表最有吸引力的象限

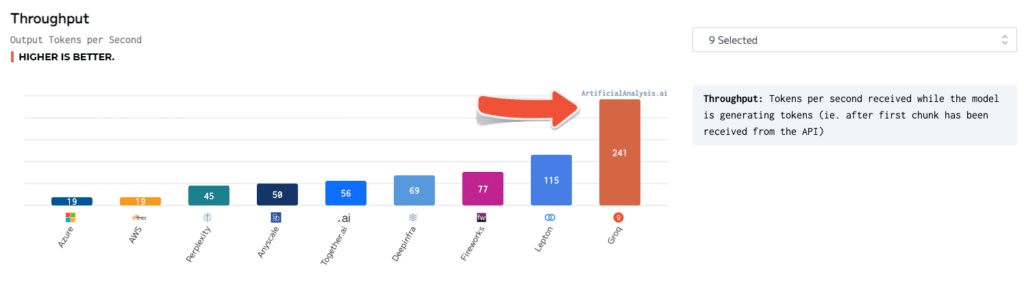

吞吐量

- **吞吐量:**模型生成标记时每秒接收到的标记数(即在从API接收到第一个块之后)

- 数值越高越好

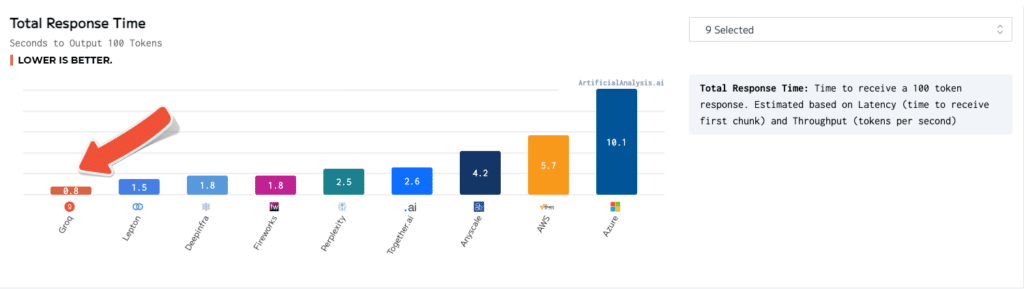

总响应时间

- **总响应时间:**根据延迟和吞吐量估计接收100个标记的时间

- 数值越低越好

理解LPUs

LPUs代表了LM处理中的一种范式转变,为计算密集型语言任务提供了无与伦比的效率和速度。通过优化计算密度和内存带宽,LPUs在传统GPU和CPU上表现出色,特别是在需要快速文本生成的场景中。与擅长并行计算的GPU不同,LPUs优先考虑顺序处理,使其在LM推理中具有重要意义,其中序列生成至关重要。

对各行业的影响

Gro加速推理速度的影响是广泛而深远的,可以在各个行业中应用。在实时语言翻译、转录服务和自动化紧急系统等领域,毫秒的差距可能意味着成功与失败的区别,Gro的快速文本生成能力提供了前所未有的优势。此外,在算法交易和对话式人工智能等领域,速度对于决策和用户交互至关重要,Gro的性能提升为新的可能性和优化打开了大门。

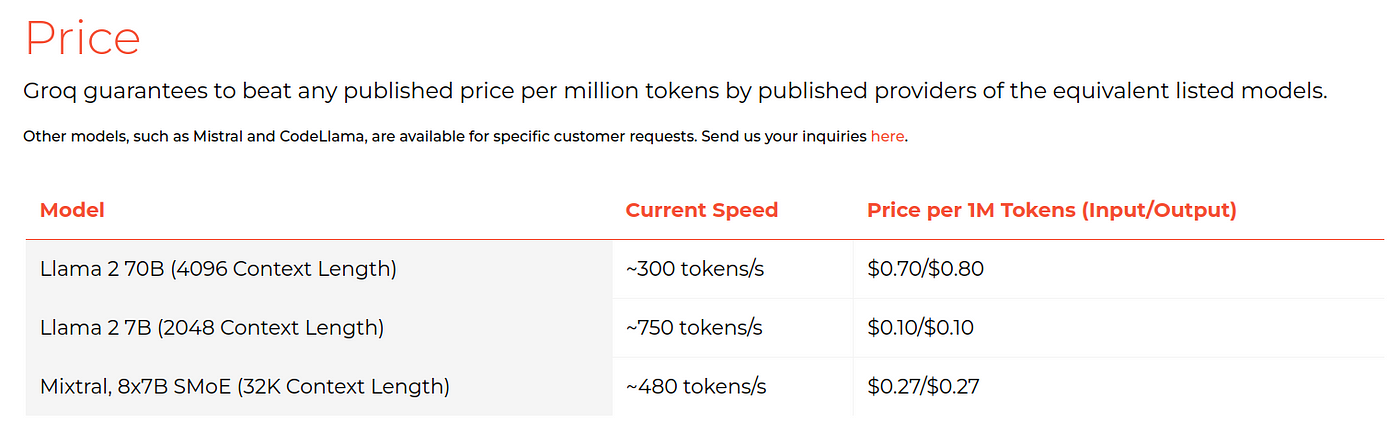

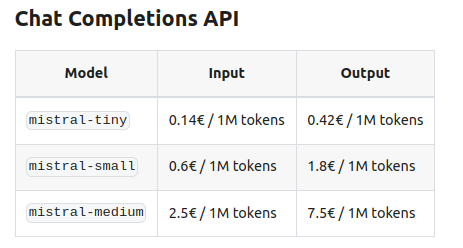

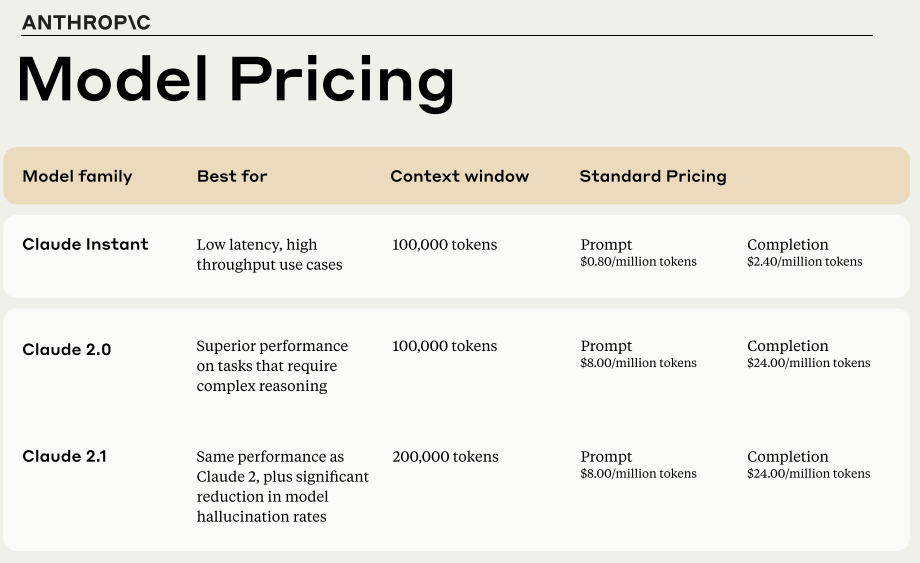

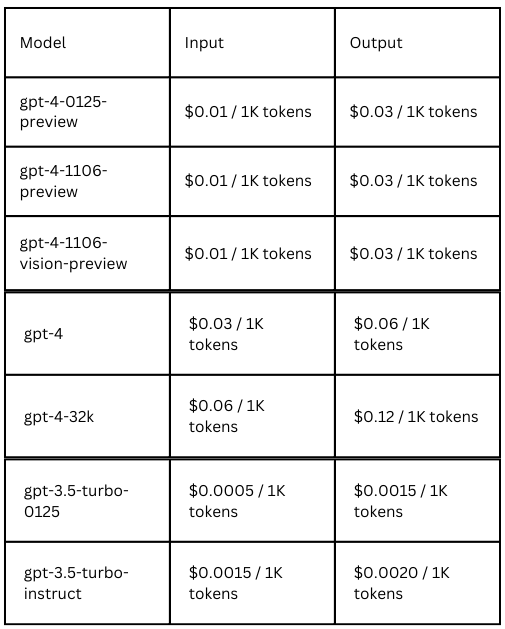

API访问和定价

GROQ : https://wow.groq.com/

Mistral : https://docs.mistral.ai/platform/pricing/

Anthropic : https://www-cdn.anthropic.com/31021aea87c30ccaecbd2e966e49a03834bfd1d2/pricing.pdf

OpenAI : https://openai.com/pricing#language-models

Gro的API访问为开发者和组织提供了利用其快速推理能力的机会。通过访问Lama 270 Billion和Mistral AI的Mix等模型,用户可以亲身体验Gro技术的变革力量。此外,Gro的竞争定价模型确保了可访问性,提供了比传统替代方案低得多的价格,同时保证了卓越的性能。

未来展望

随着Gro不断突破LM推理速度的界限,人工智能应用的未来前景变得比以往更加光明。以LPUs为创新前沿,实时语言处理、对话式人工智能等领域的可能性是无限的。随着更多行业采用Gro的技术,我们可以预期看到更多基于人工智能的解决方案的普及,这些解决方案由于速度限制而曾被认为是无法实现的。最终,Gro的崛起标志着语言模型发展的关键时刻,为人工智能带来了效率、可访问性和创新的新时代。

总之,Gro在LM推理速度方面的突破性进展代表着人工智能行业的一次重大变革。通过利用LPUs这种专用硬件,Gro重新定义了可能性的边界,开创了快速文本生成和实时语言处理的新时代。随着企业和开发者采用Gro的技术,我们正站在人工智能应用的转型之际,速度、效率和性能融合在一起,为创新和进步开启了前所未有的可能性。