热门标签

热门文章

- 1U-Net网络模型改进(添加通道与空间注意力机制)---亲测有效,指标提升_unet加入注意力机制

- 2docker全面教程(简介、原理、常用命令、构建实例、dockerfile、docker compose、docker部署postgres数据库的案例介绍)_docker compose使用另一个容器的pg数据库

- 3Android Studio中SQLite的使用,主要介绍sqlite插入和读出图片的操作方法以及可能遇到的问题

- 4Git-第一章:Git概述

- 5Ajax面试题精选及参考答案(3万字长文)

- 6【C Primer Plus】第5章

- 7【MoveIt2-humble】入门教程(翻译自官方文档)二:在 RViz 中实现可视化_moveit2教程

- 8patroni 部分源码阅读

- 9web自动化测试进阶篇05 ——— 界面交互场景测试_网站交互性测试

- 10pyltp实体识别_基于pyltp进行命名实体识别

当前位置: article > 正文

在 CPU 上使用 LLAMA 2.0 通过个人数据进行情境学习_llama2 加入自己的数据

作者:很楠不爱3 | 2024-05-29 19:15:16

赞

踩

llama2 加入自己的数据

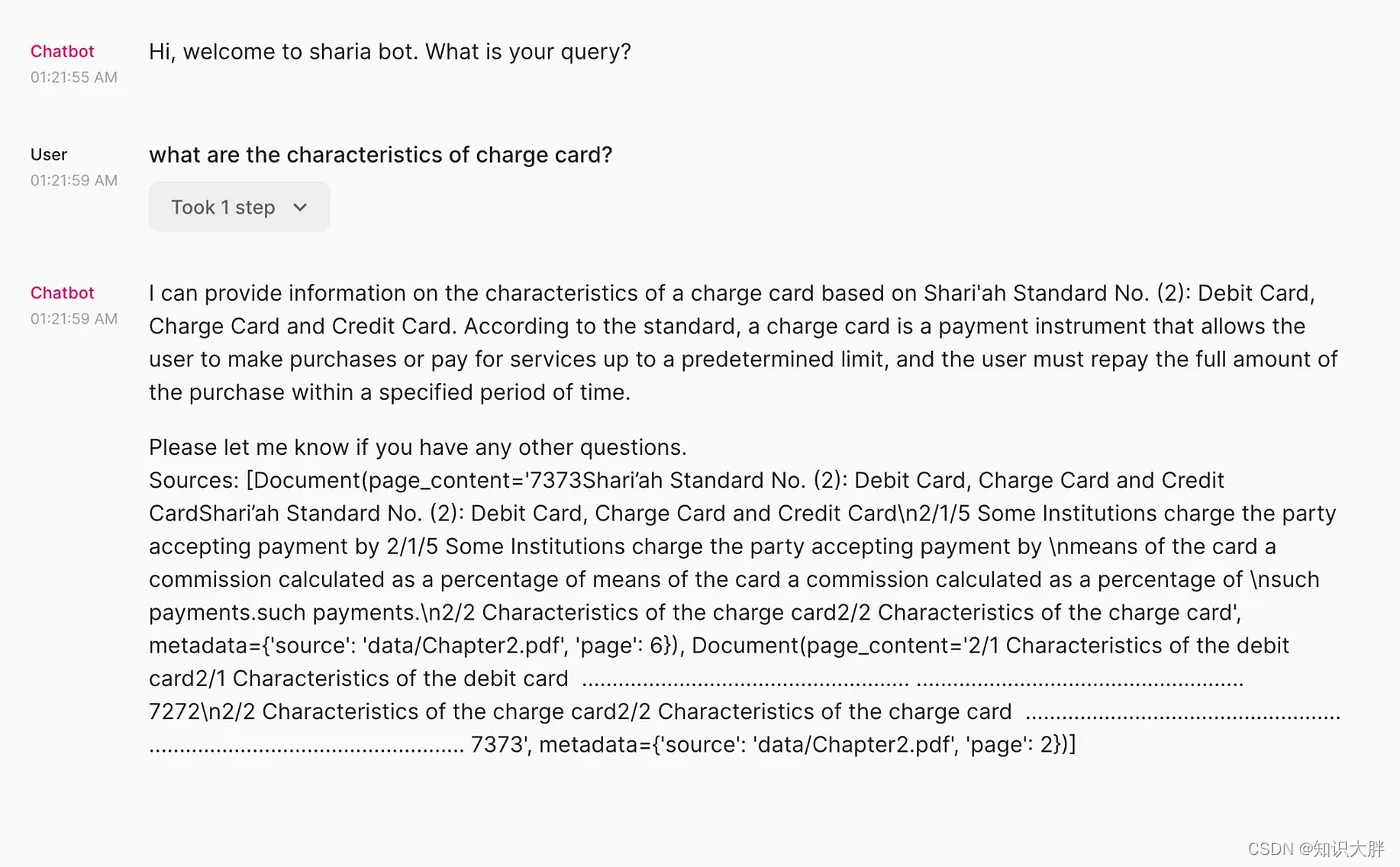

最终目标

该模型不仅可以从一组特定文件中给出答案,还可以提及它从何处获取信息。

以下是技术堆栈。

软件规格

操作系统:最好是Ubuntu

Python: 3.10及以上版本

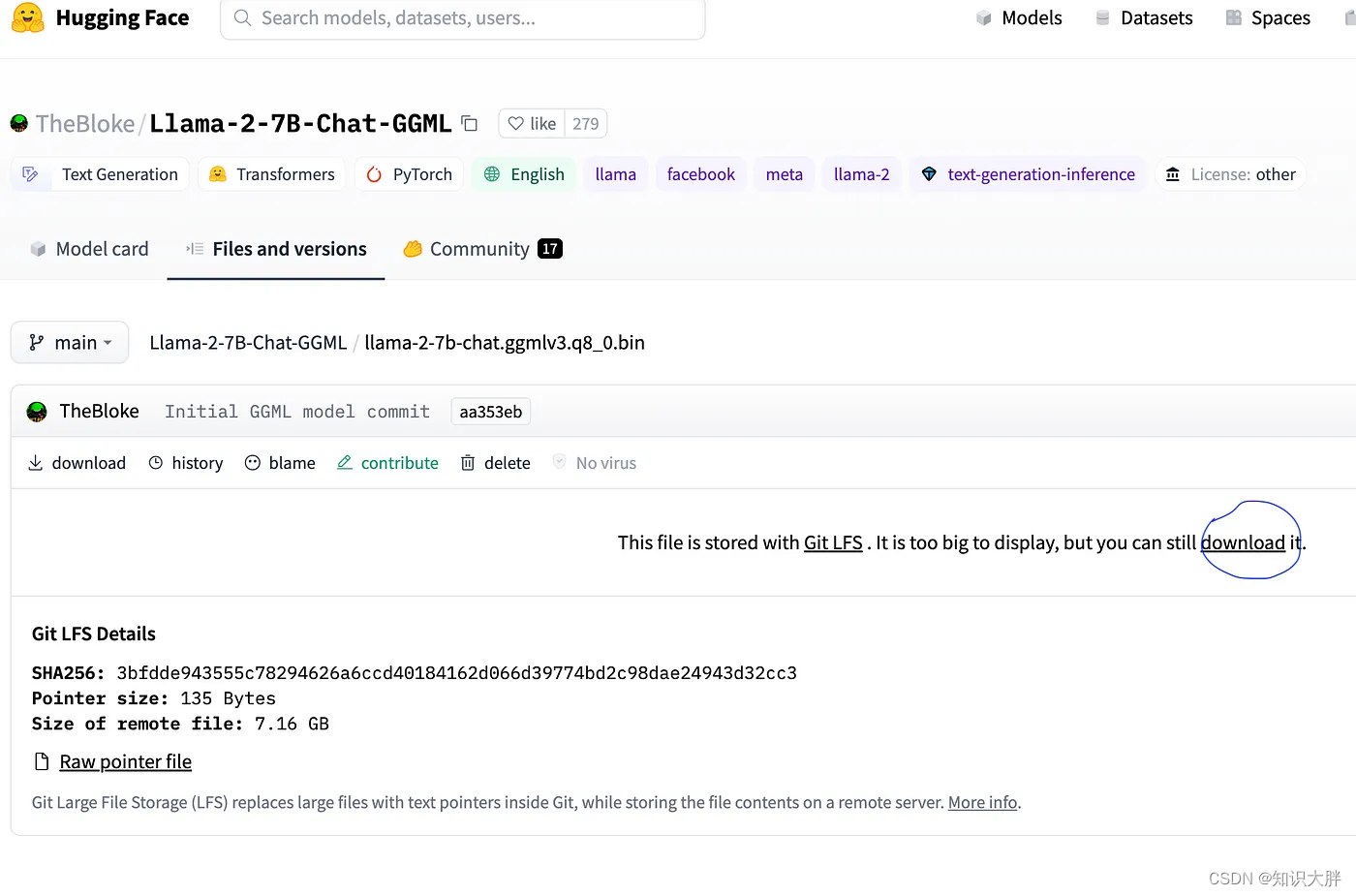

模型:Quantized llama-2–7B-Chat-GGML(以便它可以在 CPU 上运行)[感谢Tom Jobbins ]

矢量数据存储:FAISS

变压器:C变压器

部署:Chainlit

硬件要求

硬盘空间: llama 型号约为 7GB,其余的是您的数据。

RAM:至少 16GB(8GB 将在一两个问题后失败)

设置项目

创建一个名为 llama2_project 的文件夹并将 llama2 模型下载到其中。该模型可通过此链接获取。

https://huggingface.co/TheBloke/Llama-2-7B-Chat-GGML/blob/main/llama-2-7b-chat.ggmlv3.q8_0.bin

- 1

项目文件夹应如下所示:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/很楠不爱3/article/detail/643639

推荐阅读

相关标签