- 1win11重置系统之后恢复自己的office服务_win11退回win10后office还在吗

- 2每天学python-盛最多水的容器_盛最多水的容器python

- 3API等级和Android版本对应关系以及历史_api19

- 4pytorch简单新型模型测试参数

- 5Centos7.9 安装配置mysql8.0.33_centos7.9 使用yum安装mysql 8并配置大小写不敏感

- 6scratch编程我的世界3D史蒂夫_用scratch做3d沙盒游戏代码

- 7每日五道java面试题之spring篇(三)

- 8Unity结合HTC Vive开发之射线与UI交互_unity vrtk 射线不显示但是可以点击ui怎么回事

- 9异常详细信息: System.InvalidCastException: 对象不能从 DBNull 转换为其他类型。_+ asbytearray “list2[0].asbytearray”引发了类型“system.i

- 10【JavaEE】idea的smart tomcat插件

K8S实战:Centos7部署Kubernetes1.20.0集群

赞

踩

一、准备工作

1.1、创建3台虚拟机

1.1.1、下载虚拟机管理工具

由于我的笔记本使用vmware安装虚拟机老是有问题,本次我使用的是Oracle VM VirtualBox虚拟机。下载地址:https://www.virtualbox.org/wiki/Downloads

1.1.2、安装虚拟机管理工具

双击下载的.exe文件即可,建议不要安装在C盘,原因大家都懂的。

1.1.3、下载虚Centos镜像

通过“里巴巴开源镜像站”https://developer.aliyun.com/mirror/进行下载,我本次下载的是Centos 7.9

1.1.4、创建3台虚拟机

创建虚拟机的过程此次省略,不懂的可以去百度就可以了。

1.1.5、设置虚拟机网络环境

我设置的虚拟机网络环境为“桥接模式”

1.2、虚拟机基础配置(3台虚拟机进行相同处理)

1.2.1、配置host

host配置如下图所示,IP地址使用自己的IP地址

192.168.1.7 k8s-master

192.168.1.8 k8s-node01

192.168.1.9 k8s-node02

- 1

- 2

- 3

1.2.2、关闭防火墙

执行一下命令完成操作

systemctl stop firewalld

systemctl disable firewalld

- 1

- 2

1.2.3、将桥接的IPv4流量传递到iptables的链

执行一下命令进行配置

cat > /etc/sysctl.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

- 1

- 2

- 3

- 4

二、Docker安装(所有节点执行)

参考我的另一篇博文:CentOS 7.8 Docker安装、卸载与Docker-Compose的安装

三、Kubernetes安装

3.1、配置阿里云yum源(所有节点执行)

执行一下命令进行配置

cat > /etc/yum.repos.d/kubernetes.repo <<EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

3.2、安装(所有节点执行)

所有虚拟机执行以下命令进行安装kubelet、kubeadm和kubectl。

yum -y install kubelet-1.20.0 kubeadm-1.20.0 kubectl-1.20.0

systemctl enable kubelet

- 1

- 2

执行下面命令关闭swap,不然执行kubeadm命令时会报错

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab

- 1

- 2

3.3、matser节点初始化

使用以下命令进行matser节点初始化

sysctl -w net.ipv4.ip_forward=1

kubeadm init --apiserver-advertise-address=192.168.1.7 --apiserver-bind-port=6443 --pod-network-cidr=192.168.1.0/16 --service-cidr=10.96.0.0/12 --kubernetes-version=1.20.0 --image-repository registry.aliyuncs.com/google_containers

- 1

- 2

3.4、创建文件夹、复制文件并给予权限(matser节点)

matser节点初始化成功之后,安装日志会输出接下来操作的提示,执行如下命令创建文件夹、复制文件并给予权限

mkdir -p $HOME/.kube

cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

chown $(id -u):$(id -g) $HOME/.kube/config

- 1

- 2

- 3

3.5、安装网络插件(matser节点)

通过下面链接下载插件yaml文件

https://docs.projectcalico.org/v3.20/manifests/calico.yaml

- 1

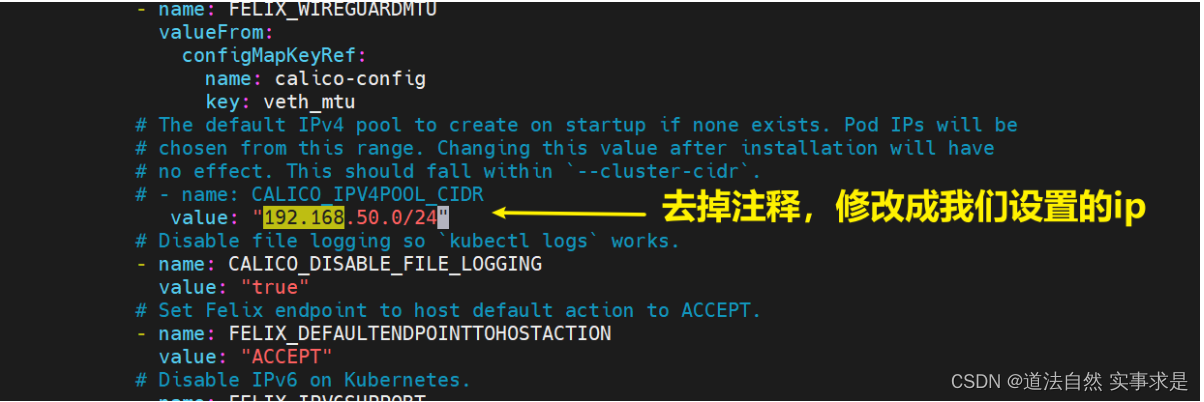

修改配置文件,如下图所示

通过下面命令安装网络插件

kubectl apply -f calico.yaml

- 1

3.6、安装node节点

执行matser节点初始化安装成功后,安装日志会输出安装node节点的命令,复制命令,在其他两个node节点中执行。

kubeadm join 192.168.1.7:6443 --token ysjwr1.ii05kwoyv823gdqe --discovery-token-ca-cert-hash sha256:7c6240a7b293068427e031f5d072e4b4c3ab1048fa947a52b8f882b10cca0914

- 1

至此,如果顺利的话,kubernetes的安装就完成了,可以使用一下命令检查是否安装成功

kubectl get nodes

kubectl get pods -A

- 1

- 2

四、kubernetes-dashboard安装

4.1、安装kubernetes-dashboard

执行以下命令安装kubernetes-dashboard

kubectl apply -f https://raw.githubusercontent.com/kubernetes/dashboard/v2.4.0/aio/deploy/recommended.yaml

- 1

4.2、暴露端口

执行以下命令

kubectl edit svc kubernetes-dashboard -n kubernetes-dashboard

- 1

type: ClusterIP 改为 type: NodePort

4.3、查询放行的端口

使用以下命令进行查询。

kubectl get svc -A |grep kubernetes-dashboard

- 1

4.4、访问web界面

访问: https://集群任意IP:端口 例如:https://192.168.1.7:31820/

4.5、创建访问账号

执行以下命令创建访问账号。

vi dash.yaml

# 内容如下:

apiVersion: v1

kind: ServiceAccount

metadata:

name: admin-user

namespace: kubernetes-dashboard

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: admin-user

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: cluster-admin

subjects:

1. kind: ServiceAccount

name: admin-user

namespace: kubernetes-dashboard

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

然后执行以下命令

kubectl apply -f dash-usr.yaml

- 1

4.6、生成令牌

执行以下命令生成令牌。

kubectl -n kubernetes-dashboard get secret $(kubectl -n kubernetes-dashboard get sa/admin-user -o jsonpath="{.secrets[0].name}") -o go-template="{{.data.token | base64decode}}"

- 1

五、附言

本次搭建kubernetes集群差不多花了一天半了时间。主要在以下几个地方耗费了比较多的时间。

- 虚拟机IP地址查看

在执行ipconfig查看IP的时候提示命令不存在,然后在执行yum install upgrade报如下错误

cannot find valid baseurl for repobase/7/x86_64

- 1

解决办法:

执行以下命令,

vi /etc/sysconfig/network-scripts/ifcfg-enp0s3

service network restart

yum install upgrade

yum install net-tools

- 1

- 2

- 3

- 4

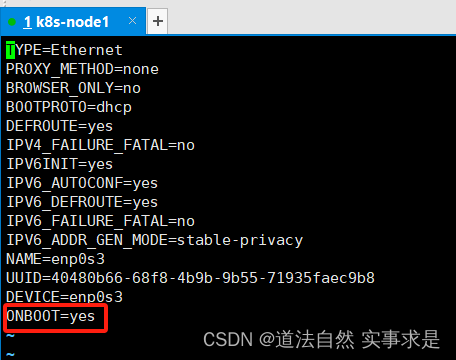

将onboot修改为“yes”,如下图所示

2. master节点初始化

在参考 Kubernetes集群部署中执行kubeadm init --config=init-config.yaml时,一直报如下错误

错误一:

Failed to start Docker Application Container Engine.

- 1

错误二:

k8s-master node not found.

- 1

解决方案:

卸载kubernetes旧版本,使用如下脚本

yum remove kube*

modprobe -r ipip

lsmod

rm -rf /etc/kubernetes/

rm -rf /etc/cni

rm -rf /var/lib/etcd

yum clean all

- 1

- 2

- 3

- 4

- 5

- 6

- 7

使用如下命令进行初始化并升级kubernetes的版本

kubeadm init --apiserver-advertise-address=192.168.1.7 --apiserver-bind-port=6443 --pod-network-cidr=192.168.1.0/16 --service-cidr=10.96.0.0/12 --kubernetes-version=1.20.0 --image-repository registry.aliyuncs.com/google_containers

- 1

补充:kubernetes-dashboard卸载

master节点初始化重置命令

kubeadm reset

- 1

- kubernetes-dashboard安装

在参考 Kubernetes(K8S)集群部署安装完kubernetes-dashboard一直打不开,开始以为是端口防火墙或火狐浏览器太新的问题,后面通过执行kubectl get pod -A发现kubernetes-dashboard的状态不对,服务压根就没起来。

解决方案:

通过查看kubernetes-dashboard与kubernetes版本对应关系升级kubernetes-dashboard到v2.4.0解决

补充:kubernetes-dashboard卸载

删除现有的dashboard服务

kubectl delete service kubernetes-dashboard --namespace=kubernetes-dashboard

kubectl delete service dashboard-metrics-scraper --namespace=kubernetes-dashboard

- 1

- 2

删除现有的dashboard pod

kubectl delete deployment kubernetes-dashboard --namespace=kubernetes-dashboard

kubectl delete deployment dashboard-metrics-scraper --namespace=kubernetes-dashboard

- 1

- 2

强制删除现有的dashboard pod命令

kubectl delete pods kubernetes-dashboard-658485d5c7-qnp55 -n kubernetes-dashboard --grace-period=0 --force

- 1