- 1Python机器学习/数据挖掘项目实战 泰坦尼克号Titanic生存预测 Kaggle入门比赛Titanic : Machine Learning from Disaster 随机森林分类器_请用python3 jupyter写一份关于titanic生存模型预测的代码,只用训练集,数据集

- 2【鸿蒙】HarmonyOS认证学习资料整理_一次开发多端部署的三个层次有哪些

- 3安全性分析之“面向全场景的鸿蒙系统”_鸿蒙系统安全评估报告

- 4【最新面试】2022年软件测试面试题大全(持续更新)附答案

- 5vue 监听元素高度变化

- 6android studio gradle国内代理设置

- 7将带alpha通道的4通道png图片转换为3通道图片

- 8RTL8852BE网卡驱动安装及modprobe: ERROR: could not insert ‘8852be‘: Invalid argument问题解决_modprobe: error: could not insert 'rtw_8852ce': in

- 97年经验之谈 —— 性能测试场景的设计方法_性能测试-页面加载延时

- 10Arduino驱动MQ5模拟煤气气体传感器(气体传感器篇)_arduino与mq5

马斯克的 Grok-1 开源,3140亿参数目前最大开源模型,最佳实践教程来啦

赞

踩

近几天开源社区最大的热点,莫过于埃隆马斯克信守承诺的最大开源模型Grok-1。

Grok-1 是一款 314B 大型专家混合 (Mixture of Expert,MoE) Transformer,作为基础模型,基于大量文本数据进行训练,没有针对任何具体任务进行微调,使用 JAX 库和 Rust 语言组成的自定义训练堆栈从头开始训练。

官方提供的详细模型参数如下:

-

参数量: 3140亿

-

架构: 8个混合专家模型(MoE),每个Token使用2个专家

-

层数: 64层

-

多头注意力: Q使用48个注意力头,K/V 使用8个注意力头

-

嵌入尺寸: 6,144

-

词表大小: 131,072个Tokens,采用SentencePiece 分词器

-

使用RoPE位置编码

-

支持激活分片和8位量化

-

最大序列长度(上下文): 8,192个Tokens

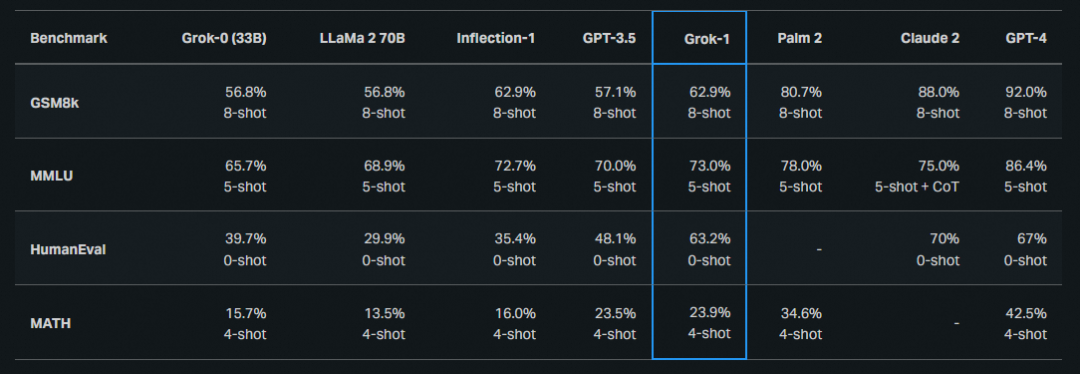

模型性能方面,Grok-1官方发布的Benchmark超过GPT-3.5 和 LLaMa2 70B(MMLU 为73%,GMSK 为62.9%,HumanEval 为63.2%)

话题中的模型效果如何,老规矩,我们向大家提供推理实践教程~

更多大模型实战案例

模型链接和下载

Grok-1模型在ModelScope社区可下载:

模型链接:https://www.modelscope.cn/models/AI-ModelScope/grok-1/summary

社区支持直接下载模型的repo:

from modelscope import snapshot_download

model_dir = snapshot_download("AI-ModelScope/grok-1")

- 1

- 2

Grok推理和评测

环境准备

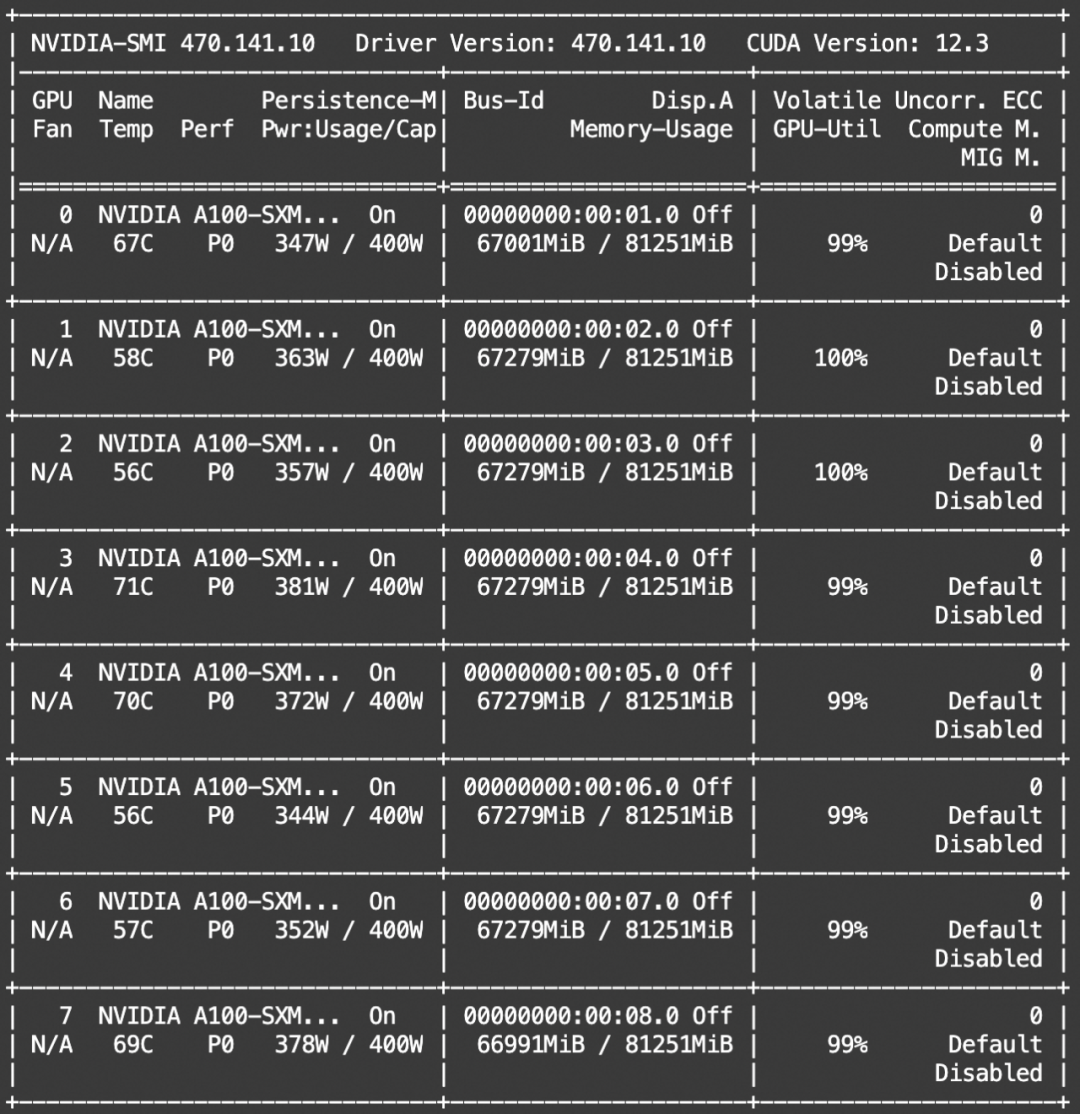

Grok-1需要8卡A100运行。原始模型是Jax框架编写,因此使用魔搭默认镜像无法工作,为此需要使用Jax的镜像:

docker pull ghcr.io/nvidia/jax:jax

# 如果国内用户无法拉取上面的镜像可以使用我们转储的镜像

# docker pull registry.cn-wulanchabu.aliyuncs.com/ed/jax:1.0

- 1

- 2

- 3

进入docker实例之后对grok代码库进行克隆:

git clone https://github.com/xai-org/grok-1.git

cd grok-1

pip install -r requirements.txt

# 修正Jax版本

pip install --upgrade "jax[cuda12_local]==0.4.23" -f https://storage.googleapis.com/jax-releases/jax_cuda_releases.html

- 1

- 2

- 3

- 4

- 5

运行推理可以直接使用官方提供的样例:

# cd grok-1

# 修改样例中的CKPT_PATH = "ModelScope下载的模型路径"

python run.py

- 1

- 2

- 3

显存占用

技术交流群

前沿技术资讯、算法交流、求职内推、算法竞赛、面试交流(校招、社招、实习)等、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企开发者互动交流~

我们建了大模型算法岗技术与面试交流群, 想要进交流群、需要源码&资料、提升技术的同学,可以直接加微信号:mlc2060。加的时候备注一下:研究方向 +学校/公司+CSDN,即可。然后就可以拉你进群了。

方式①、微信搜索公众号:机器学习社区,后台回复:加群

方式②、添加微信号:mlc2060,备注:技术交流

用通俗易懂方式讲解系列

- 用通俗易懂的方式讲解:自然语言处理初学者指南(附1000页的PPT讲解)

- 用通俗易懂的方式讲解:1.6万字全面掌握 BERT

- 用通俗易懂的方式讲解:NLP 这样学习才是正确路线

- 用通俗易懂的方式讲解:28张图全解深度学习知识!

- 用通俗易懂的方式讲解:不用再找了,这就是 NLP 方向最全面试题库

- 用通俗易懂的方式讲解:实体关系抽取入门教程

- 用通俗易懂的方式讲解:灵魂 20 问帮你彻底搞定Transformer

- 用通俗易懂的方式讲解:图解 Transformer 架构

- 用通俗易懂的方式讲解:大模型算法面经指南(附答案)

- 用通俗易懂的方式讲解:十分钟部署清华 ChatGLM-6B,实测效果超预期

- 用通俗易懂的方式讲解:内容讲解+代码案例,轻松掌握大模型应用框架 LangChain

- 用通俗易懂的方式讲解:如何用大语言模型构建一个知识问答系统

- 用通俗易懂的方式讲解:最全的大模型 RAG 技术概览

- 用通俗易懂的方式讲解:利用 LangChain 和 Neo4j 向量索引,构建一个RAG应用程序

- 用通俗易懂的方式讲解:使用 Neo4j 和 LangChain 集成非结构化知识图增强 QA

- 用通俗易懂的方式讲解:面了 5 家知名企业的NLP算法岗(大模型方向),被考倒了。。。。。

- 用通俗易懂的方式讲解:NLP 算法实习岗,对我后续找工作太重要了!。

- 用通俗易懂的方式讲解:理想汽车大模型算法工程师面试,被问的瑟瑟发抖。。。。

- 用通俗易懂的方式讲解:基于 Langchain-Chatchat,我搭建了一个本地知识库问答系统

- 用通俗易懂的方式讲解:面试字节大模型算法岗(实习)

- 用通俗易懂的方式讲解:大模型算法岗(含实习)最走心的总结

- 用通俗易懂的方式讲解:大模型微调方法汇总