- 1Java之方法的重载(求最大值方法的重载)_求最大值方法对重载

- 2SpringBoot从入门到精通教程(三十一)- 爬虫框架集成_springboot爬虫教程

- 3CodeForces978C Letters(模拟)_there are nn dormitories in berland state universi

- 4Git总结 | Git面试都问些啥?_git在分支里面创造新的分支

- 5AI系列:大语言模型的function calling(下)- 使用LangChain

- 6PyCharm环境下Git与Gitee联动:本地与远程仓库操作实战及常见问题解决方案_pycharm连接gitee

- 7【每日一题】求一个整数的惩罚数

- 8百度UIE:Unified Structure Generation for Universal Information Extraction paper详细解读和相关资料

- 9Python 动态抓取 Android 进程内存信息 数据可视化_python实现对手机性能的可视化分析

- 10桌面虚拟化之最佳实践篇1-- VIEW COMPOSER

MSE 支持 Apache Shenyu 网关实现全链路灰度_全链路灰度 动态路由

赞

踩

什么是全链路灰度

微服务体系架构中,服务之间的依赖关系错综复杂,有时某个功能发版依赖多个服务同时升级上线。我们希望可以对这些服务的新版本同时进行小流量灰度验证,这就是微服务架构中特有的全链路灰度场景,通过构建从网关到整个后端服务的环境隔离来对多个不同版本的服务进行灰度验证。

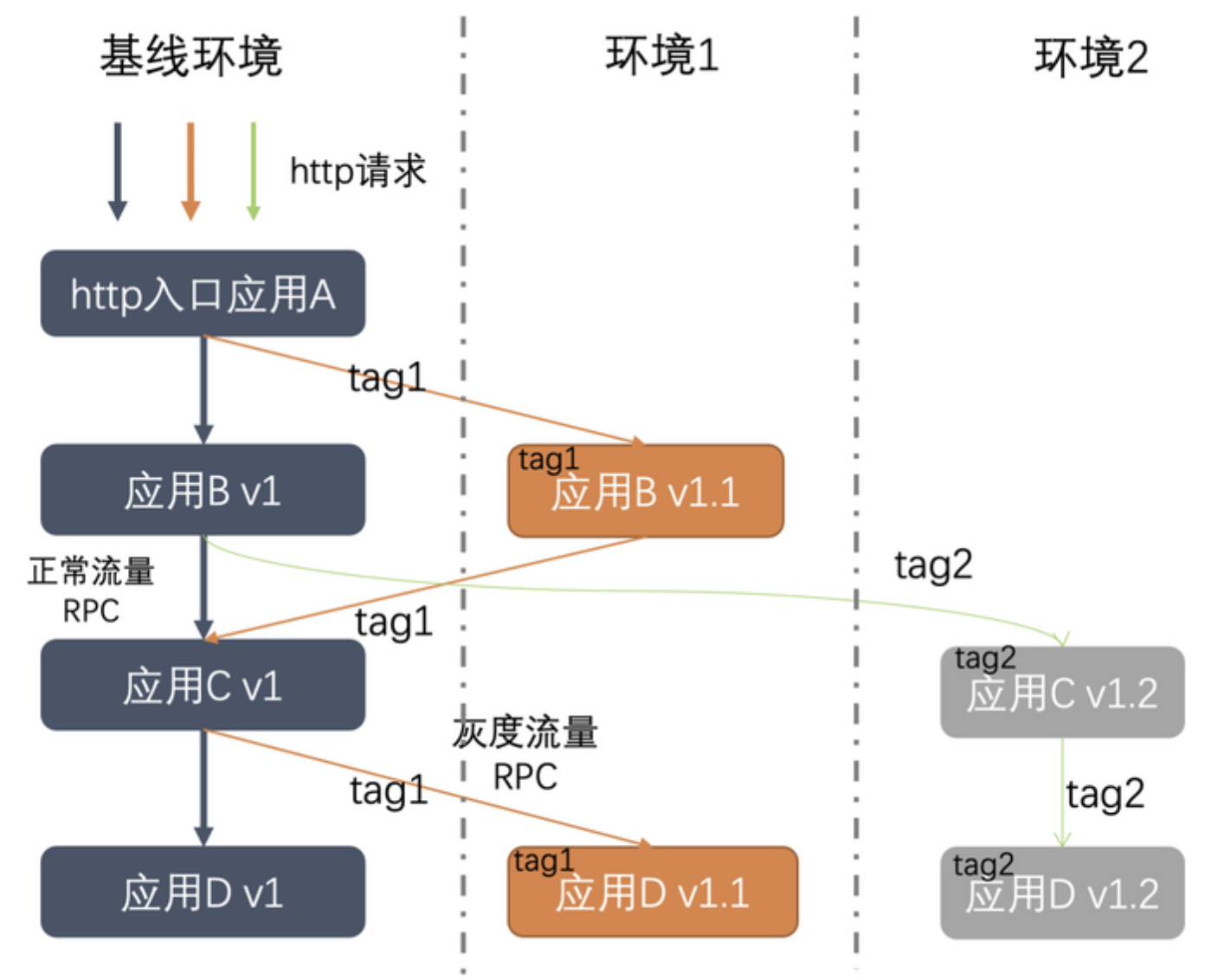

在发布过程中,我们只需部署服务的灰度版本,流量在调用链路上流转时,由流经的网关、各个中间件以及各个微服务来识别灰度流量,并动态转发至对应服务的灰度版本。如下图:

上图可以很好展示这种方案的效果,我们用不同的颜色来表示不同版本的灰度流量,可以看出无论是微服务网关还是微服务本身都需要识别流量,根据治理规则做出动态决策。当服务版本发生变化时,这个调用链路的转发也会实时改变。相比于利用机器搭建的灰度环境,这种方案不仅可以节省大量的机器成本和运维人力,而且可以帮助开发者实时快速的对线上流量进行精细化的全链路控制。

基本概念

泳道:一条虚拟的流量路径,比如上图中标签 1 的流量,就属于一个泳道

基线环境:承载所有流量,比如某个服务,没有标签 1 节点,那么就会回退到基线环境

流量回退:某个服务,没有标签 1 节点,那么就会回退到基线环境,这个行为叫流量回退

泳道组:为便于理解,流量涉及应用以及其泳道,称为泳道组。

全链路灰度的应用场景

日常/开发/项目/测试环境隔离

构造日常、开发、项目、测试等多套环境的“泳道”,每个项目环境都有唯一的一个项目标签,流量带上这个项目标签后会路由到该项目环境,否则会去主干环境。如果没有这套机制,开发环境要进行物理隔离,这就需要部署整套微服务架构,成本非常高。

全链路灰度发布

线上所有应用部署灰度版本,灰度流量全部进入灰度版本,正常流量进入生产版本。灰度版本只针对灰度流量验证,有效减少风险。云上客户安 x 就有这样的场景,要灰度发布 N 个应用,想灰度流量在这 N 个应用的灰度版本之间路由。

高可用/临近路由

业务高可用部署后,服务调用如果跨机房,会带来额外的调用延迟。开启同机房优先路由后, 让 Consumer 服务调用优先选择相同机房的 Provider,降低 rt。

全链路压测

直接使用线上环境压测,让压测流量的 DB 操作落库到影子表,Redis 落到影子 KEY,MQ 落到影子 TOPIC。如果没有路由能力,需要搭建一套仿真的线上环境用于压测,成本直线上升。用线上环境配合流量控制能力可以实现 0 机器成本,0 维护成本完成全链路压测。

涉及技术

那么全链路灰度具体是如何实现呢?我们需要解决以下问题:

1.链路上各个组件和服务能够根据请求流量特征进行动态路由 (标签路由)

2.需要对服务下的所有节点按照标签分组,能够区分版本 (节点打标)

3.需要对流量进行灰度标识、版本标识,并向下传递 (标签传递)

除了对 RPC/HTTP 调用需要按照标签灰度,对 DB、消息、分布式任务也需要按照标签灰度(消息灰度、数据库灰度)

标签路由

在云原生环境下,由于节点的生命周期缩短,IP 变化,导致原来按照 IP 来设置路由规则的方式不再适用。所以,标签是云原生环境下的一等公民。

不论节点、流量、还是消息,都不再通过 IP、节点来标记,运维开发同学只需要关注标签就可以。

在不同的上下文中,有不同的标签值,可以带来不同的业务场景。

比如当标签值是可用区的时候,就可以实现临近路由;当标签值是版本的时候,就可以据此实现金丝雀发布、全链路灰度等。

节点打标

在云原生环境下,尤其是典型的 K8s 部署模式下,我们可以通过 labels 来给一组 pod/workload 打标,这样就能通过标签来标记、查找节点。比如 K8s 的 service 就依赖了 label;阿里云微服务引擎(MSE)也使用 label alicloud.service.tag 来设置节点标签。

当然,业务上肯定也有一些应用不是 K8s 部署的,所以节点打标也需要支持非 K8s 环境。

在非 K8s 环境中,可以通过环境变量、系统参数、文件等方式标记节点的标签,然后把这些标签注册到注册中心,consumer 在调用的时候,可以根据这些标签来实现路由逻辑。

标签传递

在整个的微服务调用中,我们希望流量上的标能够一直传递下去,其一是回溯流量来源,其二是可以在任意节点上依据流量做灰度。

在 OpenTelemetry 之前,可以通过自定义 Header 来实现流量标签透传,比如 MSE 就使用了 x-mse-tag header。

OpenTelemetry 引入了 Baggage 概念,可以通过标准方式来添加 Header。

上述两种技术,都实现了流量标签的传递。

消息灰度、数据库灰度

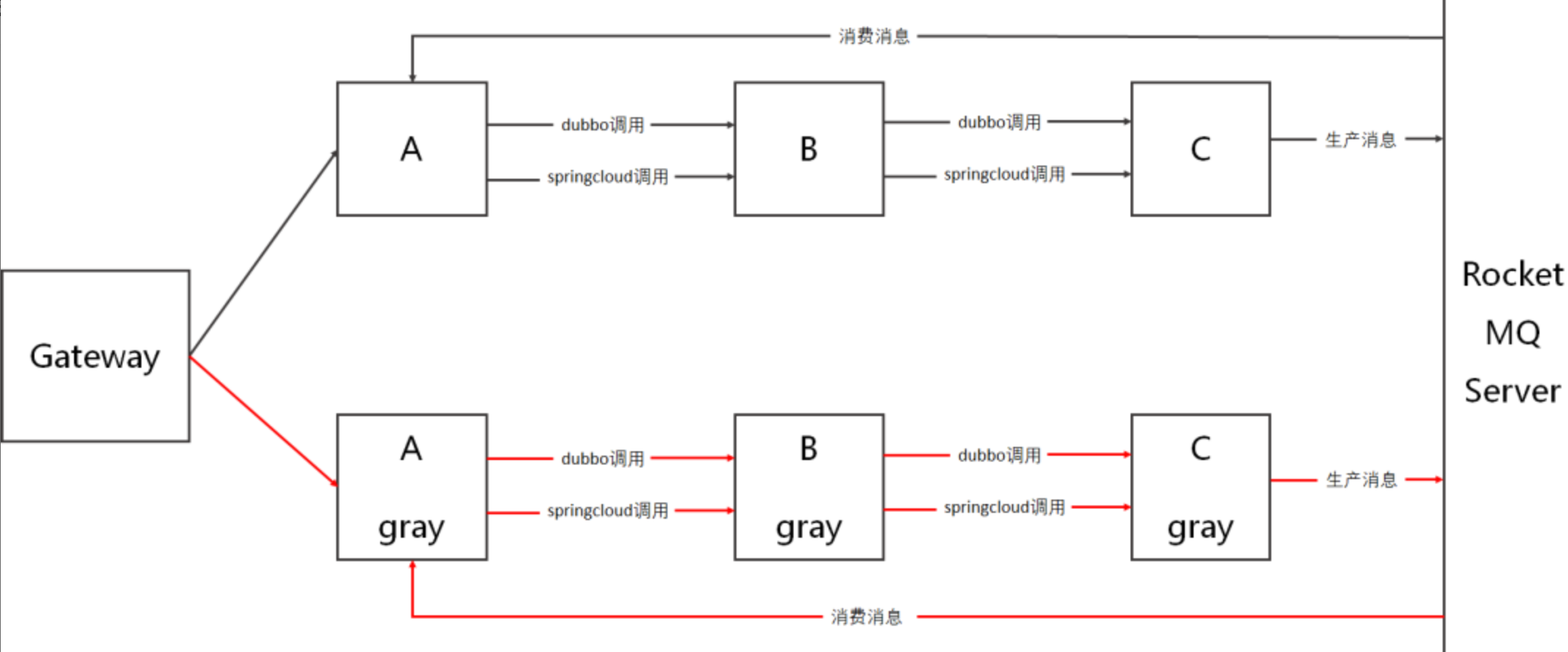

比如在上图中,以 RocketMQ 为例,C 应用生产消息,A 应用消费消息,那么如何做到 C 应用的 gray 节点的消息,只能被 A 应用的 gray 节点消费。

首先,要给消息打标。gray 节点生产的消息,可以通过 userProperty 特性,添加额外 property 来给消息打标。

其次,要按照标签消费消息。gray 节点消费消息的时候,可以通过 SQL92 Filter 特性,只筛选特定标签的消息。

使用 Shenyu 网关,实现全链路灰度

部署 Apache Shenyu 网关

Apache Shenyu 网关分为 shenyu-admin(用于规则管控)和 shenyu-bootstrap(用于处理流量)。

按照 Apache Shenyu 的说明文档 [ 1] ,依次创建 shenyu 命名空间、shenyu-cm ConfigMap。

按照 Apache Shenyu 说明文档,依次创建 shenyu-admin-svc Service 和 shenyu-admin Deployment。

由于我们需要再安装 Spring Cloud 插件,所以采用手动部署模式:

创建 spring-boot 项目,名字叫 shenyu-bootstrap [ 2] ,添加 shenyu-spring-boot-starter-plugin-springcloud 等相关依赖。

在 application.yaml 中配置,shenyu.sync.websocket.urls 为 ws://shenyu-admin-svc:9095/websocket,接收 shenyu-admin 的配置。

访问 shenyu-admin,打开 Spring Cloud 插件。

部署微服务 demo

mse-simple-demo 分为 A、B、C三个应用,依次调用各自目录下的 build.sh 构建镜像。

然后创建 values.example.yaml,在其中配置好镜像地址、注册中心地址后,执行 helm 命令安装部署:

helm3 upgrade mse-simple-demo1 helm/mse-simple-demo \

--namespace shenyu --create-namespace \

--install \

--values helm/mse-simple-demo/values.example.yaml

按照 demo 部署好后,可以在 shenyu-admin 上,看到 sc-A 已经注册到网关了:

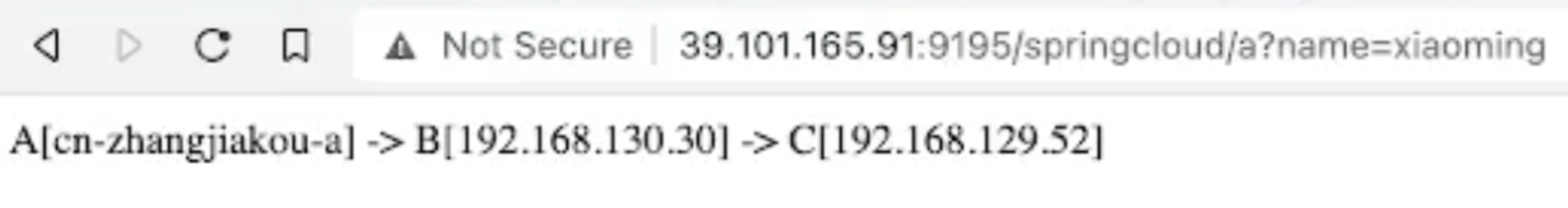

此时默认没有任何流量规则,A->B->C 调用链路默认都走基线环境:

设置规则

首先,创建 shenyu-demo 泳道组,选择 shenyu-bootstrap 作为流量入口,A、B、C 作为泳道组应用。

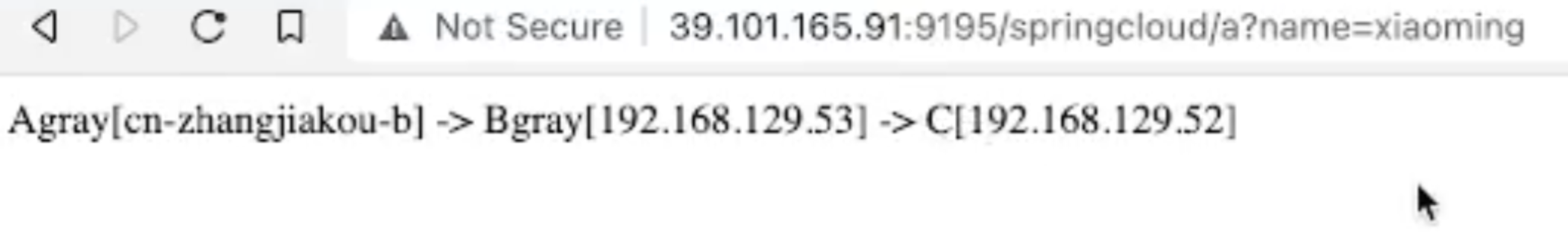

接下来配置规则,例如有参数 name=xiaoming 的,我们认为是灰度流量,走 gray 标签的泳道:

验证

然后我们访问网关,带上 name=xiaoming,发现 A 应用和 B 应用都走到了 gray 节点,C 应用因为没有 gray 节点,走到了基线节点:

OpenSergo 开源微服务治理标准

随着微服务架构的普及,微服务治理的概念也越来越被更多人认知,微服务治理的标准化、治理数据面的多样性、多语言支持等也越来越迫切。

我们观察到了这个趋势,发起了 OpenSergo [ 3] 项目,致力于制定微服务治理的标准及参考实现。

其中,全链路灰度作为基本能力,目前 OpenSergo 也在制定相关标准,包括如何给机器打标、给流量打标、如何路由等。

总结

MSE 全链路灰度能力,提供了全链路隔离流量泳道能力,企业和开发这可以通过全链路灰度能力,提供端到端的稳定基线环境、流量一键动态切流、全链路的可观测能力。

此外,MSE 微服务治理具备无倾入接入能力,基于 Java Agent 技术,实现无需修改一行业务代码就能接入。具备无损上下线能力,使得业务发布更加丝滑。

接下来,MSE 全链路灰度,将会支持更多基础设施(数据库、消息等),支持更多语言、更多接入模式,为企业和开发者提升开发、运维效率。

相关链接

[ 1] Apache Shenyu 的说明文档:

https://shenyu.apache.org/zh/...

[2] shenyu-bootstrap的源码链接:

https://github.com/aliyun/ali...

[3] OpenSergo: