- 1Vue 3 和 Spring Boot 3 的操作流程和执行步骤详解_springboot3 + vue3

- 2NewSQL分布式数据库发展策略讨论_与newsql相关的综述性论文

- 3计算机网络——TCP/UDP_tcp提供面向字节流的传输服务,为实现流传输服务付出了大量开销

- 424数维杯C题18页保姆级思路+代码+后续参考论文_确定天然气水合物资源分布范围意义

- 5从入门到精通,大厂内部整理Android学习路线

- 6鸿蒙内核源码分析 (内核启动篇) | 从汇编到 main ()

- 7【水声通信】基于matlab OFDM-QPSK水声通信仿真(含误码率检测)【含Matlab源码 3954期】_现代水声通信原理与matlab应用

- 8Android Model引入其他aar包 导致无法打包成aar

- 9哈希表(散列表)——C++数据结构详解_哈希表数据结构代码c++

- 10Idea集成git

开篇词:大模型国内应用落地思考与实践_大模型应用模式与安全可信及评测现状和落地实践

赞

踩

自从GPT-3发布以来,随着以ChatGPT为首的应用工具一夜爆火,人工智能似乎找到了应用层面的合适出口,让大众、用户和产业,看到了大模型人工智能所具备的应用潜力。

国内外关于大模型的研究层出不群,各大厂都在进行大模型的训练和发布,致力于提供更多领域和效果更好的大模型。众所周知,大模型的研究投入是非常大的,GPT-3训练一次的费用是460万美元,训练时间为355个GPU年,总成本据悉达到1200万美元,投入如此大的成本,最终都是需要通过商业模式获取回报的。

但是目前的大模型技术,在实际落地中还面临着很多挑战,包括:大模型前期投入很大的挑战、大模型的迭代训练技术难点以及大模型落地部署等问题。

大模型发展趋势与政策

人工智能是国家战略的重要组成部分,是未来国际竞争的焦点和经济发展的新引擎。近年来,中国人工智能行业受到各级政府的高度重视和国家产业政策的重点支持,国家陆续出台了多项政策,鼓励人工智能行业发展与创新。

人工智能法草案已被列入国务院2023年立法工作计划,提请全国人大审议。

展望未来,我国将强化人工智能技术研发,鼓励人工智能前沿研究和原始创新,构建开源开放的创新生态,加快人工智能在科学研究、医疗服务、文化创意、生态治理等领域的部署落地。

ChatGPT的优缺点

下面的内容,我们先简单总结下使用ChatGPT的特性和优缺点。

ChatGPT的优点

ChatGPT的缺点

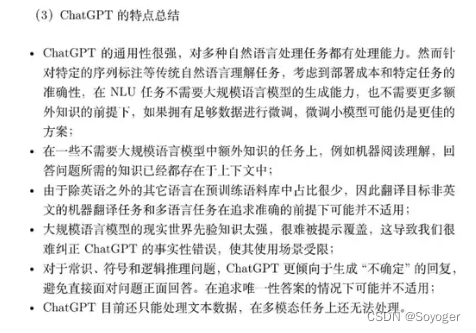

ChatGPT的特点总结

大模型国内落地的路径思考

相信,使用过ChatGPT的人,在被ChatGPT表现出的惊人的能力所征服时,也对ChatGPT在某些场景下的落地感到痛苦。受限于地域、网络、数据安全和法律合规等限制,ChatGPT的使用,总有一种被别人卡脖子的感觉。

所以,国内各行业、企业拥有自己的大模型和技术就显得非常有必要,也势在必行。

打造国内的大模型,并在生产实践中落地,我认为有以下几种路径:

ChatGPT模式

ChatGPT模式,即在未完全禁止国内使用ChatGPT的情况下,通过代理注册openai 接口,通过代理的方式在国内落地。这种方式的优点是简单,轻量级,易操作,适合一些互联网轻量级产品和功能;而缺点是可定制化受限,成本高,网络延迟高,存在一定的数据安全和法律风险,所示不太适合大规模落地,适合0-20人创业小团队。

产研结合垂直模式

产研结合垂直模式,即依靠大中型企业和国内顶尖学府,在强大的算力资源支持下,训练垂直行业的大模型,如医疗、法律大模型等。

对于一些缺少校园资源的企业,可通过对开源组件和框架的二次开发,对开源模型的微调和有限数据的训练,达到可以应用的程度。这种方式的优点是可扩展性强,可定制,不受网络限制,实现本地调试开发和部署;而缺点是需要一定的开发能力,本地训练和部署对资源开销比较高。所以,这种开发模式,适合有一定研发能力的中小企业。

通用大模型模式

通用大模型模式,即训练完全通用大模型,通过突破工程难题,利用摩尔定律来降低大型模型的训练成本。虽然这是一个挑战,但是国内已经有大企业正在致力于解决这个问题,这种模式对经济基础和算力要求高,不太适合创业公司和中小公司。

大模型落地的挑战

大模型前期投入巨大的挑战

大模型如GPT-3等在前期投入上面临巨大的挑战,主要包括:

-

硬件资源:训练大模型需要大量的计算资源,包括高性能的GPU和大量的存储空间。

-

数据需求:大模型需要大量的训练数据。获取、清洗和标注这些数据需要大量的时间和人力。

-

时间成本:大模型的训练时间通常很长,可能需要几周甚至几个月。

-

能源消耗:大模型的训练需要大量的电力,这不仅增加了成本,也对环境造成了影响。

-

模型调优:大模型的调优和优化需要专业的知识和经验,这也是一项重大的投入。

因此,尽管大模型在某些任务上可能表现出色,但其前期投入的挑战也不容忽视。

大模型技术迭代训练的难点

大模型的参数规模大、模型训练用到的数据规模大、模型训练用到的机器更多 。

-

参数规模大(一张卡搞不定):其中参数规模主要与传统的深度学习模型进行比较,传统模型参数量最多也就是百万,而预训练模型则一下子直接突破到了亿这个级别,在此后的模型参数的规模增长呈现了一种指数级的跨越式增长,并且能够实现效果的持续提升。

-

数据规模大(一台机器处理不完):2018年的 BERT模型,使用了BooksCorpus (单词量 800M),English Wikipedia (单词量 2,500M)进行训练,总体数据量在GB级别,然而到了中文领域,数据量直接飙升到了TB 起步,其中悟道2.0用了3TB 数据,ERNIE3.0用了4TB 数据。

-

机器规模大(分布式训练):据报道,GPT3.5 的训练使用了微软专门建设的 AI 计算系统,由 1 万个 V100 GPU 组成的高性能网络集群,总算力消耗约 3640 PF-days (即假如每秒计算一千万亿次,需要计算 3640 天)。

大模型落地部署面临的问题

与传统的产品相比,大模型在部署时同样存在挑战,模型很大,推理速度慢、迁移学习低效以及部署硬件资源要求高。

大模型领域必备的新晋“三剑客”产品

尽管大模型应用落地充满了很多的挑战,但是国内外还是有很多企业和个人在不断的攻克一个又一个难关,开发出很不错的产品,能够帮助全球开发者降低学习和使用成本。

这个专栏我会先简单介绍大模型时代的3个新晋网红,也是目前我们本地应用落地必备的工具,分别是HuggingFace、LangChain和ChatGLM,然后基于这三个产品,开发和微调训练出很多可实际落地的大模型。

关于新晋“三剑客”产品的具体介绍、应用和实战开发,我将放在后面的章节介绍。