热门标签

热门文章

- 1计算机方向-年度重磅国际学术会议-第四届人工智能,大数据与算法国际学术会议 (CAIBDA 2024)_第四届人工智能,大数据与算法国际学术会议(caibda 2024)

- 2【NI-DAQmx入门】数据采集方法_daqmx数据采集

- 3【无标题】yoloV8目标检测与实例分割--目标检测onnx模型部署_yolov8 onnx部署

- 4Django学习过程中遇到的问题_jdango报错: raise improperlyconfigured( django.core.

- 5【Kotlin】函数式编程 ② ( 过滤函数 | predicate 谓词函数 | filter 过滤函数 | 合并函数 | zip 函数 | folder 函数 | 函数式编程意义 )

- 6【全开源】同城派送小程序(FastAdmin+ThinkPHP+GatewayWorker+Uniapp)_fastadmin gatewayworker

- 7python 节气计算_单独的计算24节气【转】

- 8Spark On Hive配置_spark on hive 配置

- 9【虚拟化】虚拟化简介 | Hypervisor介绍_虚拟化是什么开发的

- 10django项目自定义错误显示页面

当前位置: article > 正文

基于 vLLM 搭建 DeepSeek-V2 Chat 服务_vllm deepseek

作者:我家小花儿 | 2024-07-30 19:43:56

赞

踩

vllm deepseek

直奔主题。

安装vLLM

官方实现的代码还没有 merge 到 vLLM 主分支,所以直接 git clone DeepSeek 的分支。

git clone https://github.com/zwd003/vllm.git

cd vllm

pip install -e .

- 1

- 2

- 3

源码安装大概耗时 10 分钟。

OpenAI 接口规范启动

官方 Github 放的是单条推理代码,如果需要启动 api 服务,直接用 OpenAI 接口规范启动即可:

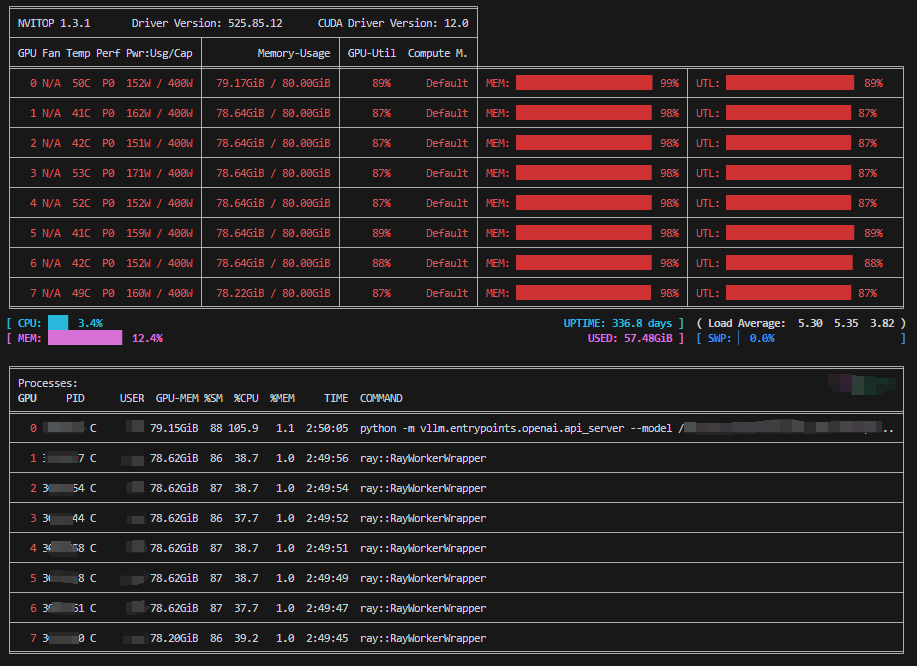

CUDA_VISIBLE_DEVICES=0,1,2,3,4,5,6,7 python -m vllm.entrypoints.openai.api_server --model {YOUR_PATH}/deepseek-ai/DeepSeek-V2-Chat --port 10000 --tensor-parallel-size 8 --gpu-memory-utilization 0.9 --max-model-len 8192 --trust-remote-code

- 1

首次启动大概耗时10分钟(8卡80G A100),后续启动差不多1分钟以内。

注:如果跑崩了出现OOM,启动时添加参数 --enforce-eager 即可解决。

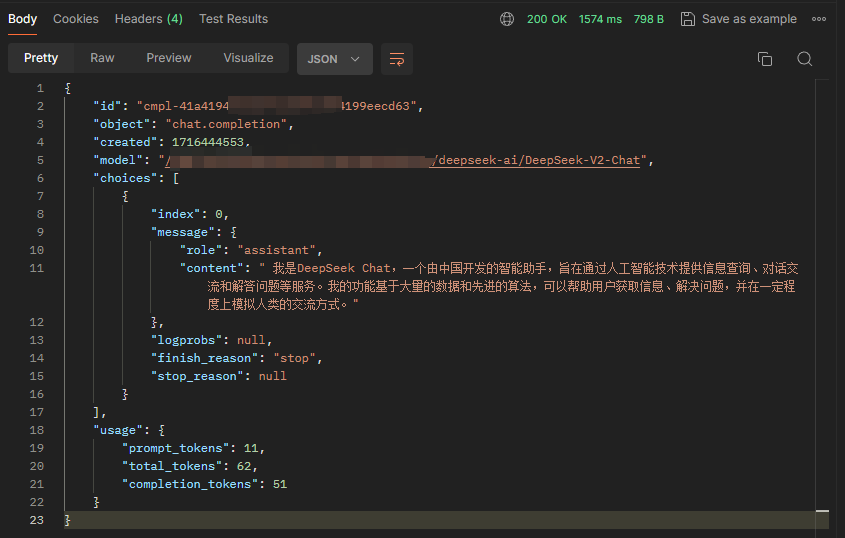

接口测试

{

"model": "{YOUR_PATH}/deepseek-ai/DeepSeek-V2-Chat",

"messages": [{"role": "user", "content": "你是谁"}],

"temperature": 0.3,

"stream": false

}

- 1

- 2

- 3

- 4

- 5

- 6

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/905148

推荐阅读

相关标签