热门标签

热门文章

- 1python字符串处理_python,字符串的处理

- 2在IDEA中切换分支没有反应_idea git 切换分支 不生效

- 3如何通俗易懂地理解YOLO系列(v1-v7)?

- 4大模型化身数据魔法师,降低NLP高置信误判_大模型增强的高风险用户识别

- 5装备嵌入式系统通用测试平台_rs422和flexray

- 62022年博客之星排行榜 日榜 2023-01-04 博客之星总榜_1158kp。vip

- 7Pycharm双击无法的打开的一种解决办法_pycharm突然打不开

- 8TeamViewer远程控制_tvnserver

- 9实用篇 | 关于Gradio快速构建人工智能模型实现界面,你想知道的都在这里_gr.textbox

- 10LVS负载均衡

当前位置: article > 正文

在你的手机上跑本地AI大模型_koboldcpp手机运行

作者:我家小花儿 | 2024-07-31 20:15:59

赞

踩

koboldcpp手机运行

可以想象,随着手机硬件性能越来越高,在不远的将来,手机本地可以很流畅的跑任何AI大模型。手机本地跑大模型,除了可以让大模型更加定制化个性化,而且最重要的是可以保护个人隐私(比如想玩NSFW的各位[偷笑])

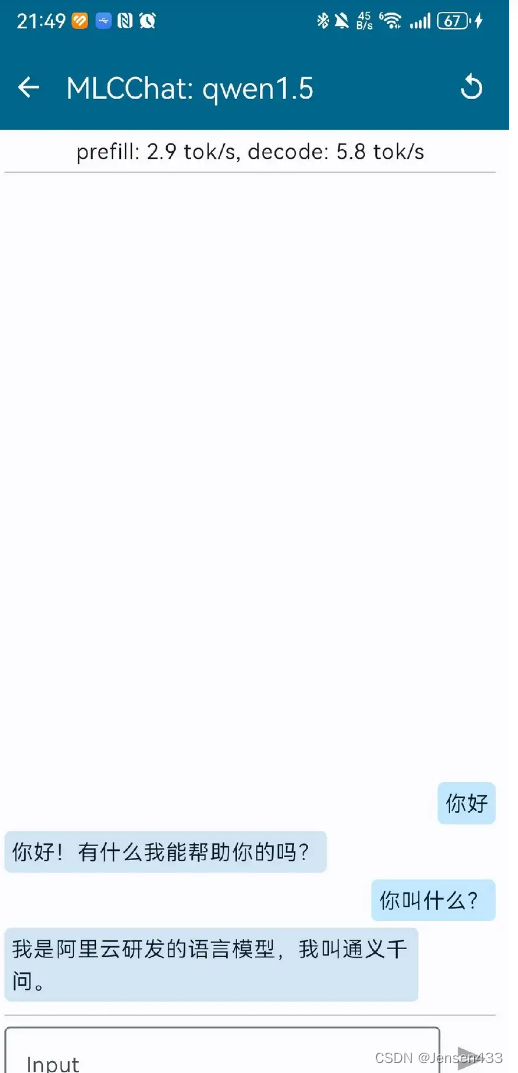

现阶段,本地手机流畅的跑大模型还比较困难,但是可以勉强跑跑10B以下的模型,比如Qwen1.8B, 我用MLC框架就可以跑起来,而且速度还相当可以。你们可以去参考下这个框架,教程什么的都有,不懂可以一起交流。

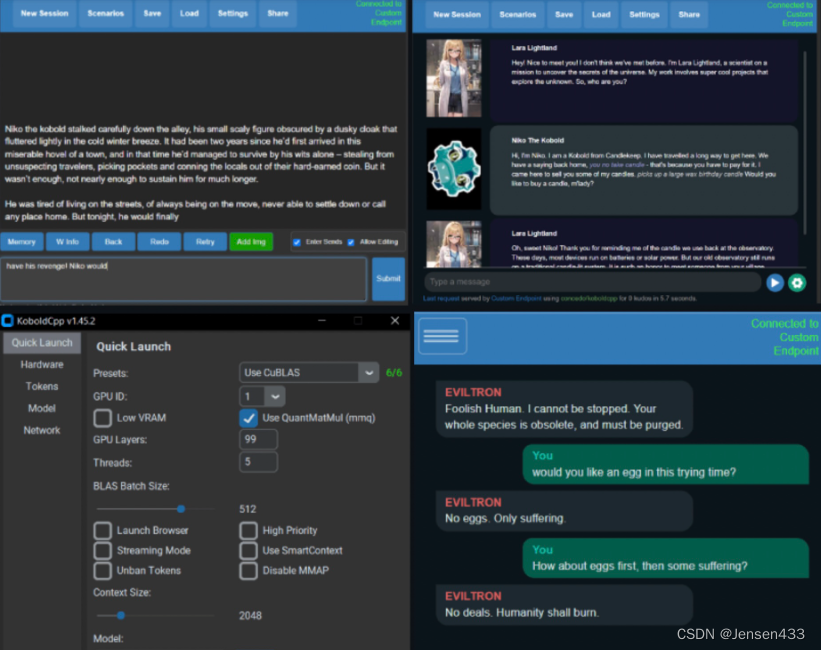

或者用llama.cpp跑GGUF格式的大模型,我尝试过在手机上用koboldcpp跑CausalLM-7B,也勉强可以接受,Github上也有教程,Termux上跑即可

https://github.com/LostRuins/koboldcpp![]() https://github.com/LostRuins/koboldcpp效果如下(配合Chub Venus AI使用,效果更佳):

https://github.com/LostRuins/koboldcpp效果如下(配合Chub Venus AI使用,效果更佳):

总之,手机本地跑大模型还有待时日,但应该是个趋势,请多关注吧。

有需要交流的可以加入我的星球:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/910523

推荐阅读

相关标签