- 1微软蓝屏事件揭示的网络安全深层问题与未来应对策略

- 2人工智能考证初步探索_人工智能技术应用专业考证

- 3Android开发 Intent传递参数,获取数据为null_android intent 传值了 但是获取是空的

- 4git 设置代理、取消代理、查看代理_git 取消代理

- 5FFT STM32+apFFT程序源代码_fftstm32

- 6深夜,我常逛的几个网站。

- 7转行软件测试一周搞定重庆10K+ offer!直接评级高级测试岗位!_上线前会针对线上环境的接口做验证吗

- 8关于数据库的ldf和mdf文件变得超大解决办法_单个数据库文件越来越大

- 9Docker部署开源白板工具Excalidraw并结合内网穿透远程访问_exdraw

- 10git 报错did not match any file(s) known to git_did not match any file(s) known to git

AI视觉带来智能,具身触觉带来温度 | 灵巧手交流回顾

赞

踩

点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

AI视觉赋予机器人智能,但触觉赋予机器人温度。

硅基生命并不活在算法里,他们必定要经历与世界、人类的真实交互。这些交互操作任务如果只依靠视觉去实现,可能能做80%-90%,但如果要让机器人更灵巧地“动起来”,还需要依赖高性能的触觉完成对世界最后10%-20%的触达。

有更敏锐的感知力,有更灵巧的行动力,能不断根据环境反馈而自我调整,进而在交互中进行对开放世界的探索......这为具身智能的应用发展,勾勒出非常具体的研究要求。

上周,BV百度风投联合具身触觉社区、AI TIME、机器人大讲堂等多家平台,邀请到来自北京邮电大学“拔尖人才”教授、中国人工智能学会认知系统与信息处理专委会秘书长方斌,清华大学深圳国际研究生院副教授、博士生导师、国家青年特聘专家丁文伯,京津冀国家技术创新中心特聘副教授赖建诚以及耶鲁大学博士杨丰瑜(Fred Yang),碰撞交流不同触觉技术路线对具身智能的重要价值、应用前景与技术落地等问题。本次活动由BV百度风投轲迪参与主持,感谢所有参与嘉宾的倾力分享与对交流活动的支持!

我们对嘉宾精彩分享进行整理,希望能带给大家更多思考与启发,也欢迎大家继续与我们探讨具身智能的发展问题。

#01 重新理解具身智能

AI不只带来大脑的感知能力,还将带来行为动作能力。具身智能是world in the loop,与物理世界交互,并完成对世界的探索。

BV:从触觉角度出发,大家怎么看具身智能?

方斌:从机器人本体和AI紧耦合的程度可以看出,AI不只带来大脑的感知能力,还会在本体的结构特性基础上,带来行为动作能力。通过和环境与人的不断接触交互,持续提升具身智能水平。

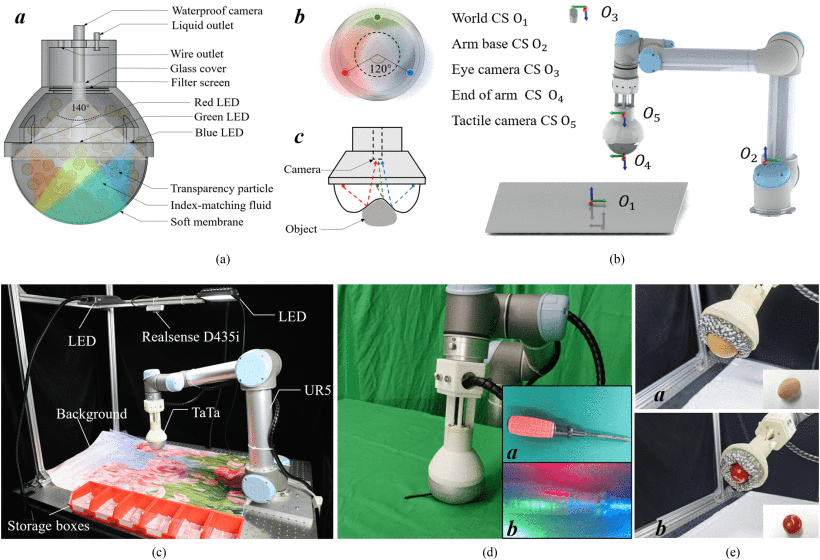

丁文伯:机器人在过去30年的发展得益于控制理论和硬件的发展。受到李飞飞教授高质量、海量的数据集ImageNet启发,机器人发展的另一条思路是:如果我们的数据量足够大、数据质量足够好、硬件足够统一、传感器足够稳定,具身智能的训练就能更受益。我们目前的工作方向叫“视触觉”,是因为传感器产生大量、高质量、高通量数据,这些数据与大模型、硬件结合,将会是具身智能的发展趋势。

BV:具身智能跟AI1.0有哪些不一样的地方?

杨丰瑜:我从多模态角度出发来看,具身智能跟前一波AI有几个不太一样的地方:首先,前AI时代很多算法是open loop的。比如我给定一个输入,它没有将结果(作为新的输入)实现为闭环的。而具身智能是world in the loop,通过感知做了一个决策之后,整个世界的reaction是在不断验证这个假设,并且不断产生新的假设,不断自我更新调整的过程。第二,具身智能需要跟物理世界交互,智能体得到反馈后会根据反馈内容,进行反复决策反复修正,同时,智能体在跟物理视角交互的过程中,完成了它对世界更广阔的探索。比如说,智能体在一个房间,可能原本只能看到一些物体,但通过把遮挡物挪开等动作,通过多模态信息进行感知、决策、交互的任务,不断完成loop来探索这个世界。

#02 触觉发展的重要性

机器人还不具备融入人类社群、与人类交往的能力,触觉是未来人机交互的重要桥梁。

BV:触觉在具身智能发展中,为何如此重要?

丁文伯:计算机视觉解决了人工智能绝大多数问题。人类本身就是视觉动物,相比出门运动,我们可能在家看视频的动力、可实现性更大。视觉赋予了机器人智能,但触觉更为机器人这个硅基生命带来与真实世界的交互的温度。我个人更期待未来更多人机交互的服务型机器人,这类机器人的灵巧操作是一定要用到触觉路线的。我们在跟机器人厂商交流时发现一个问题:机器人还不具备融入人类社群、与人类交往的能力,触觉是未来人机交互很重要的桥梁。

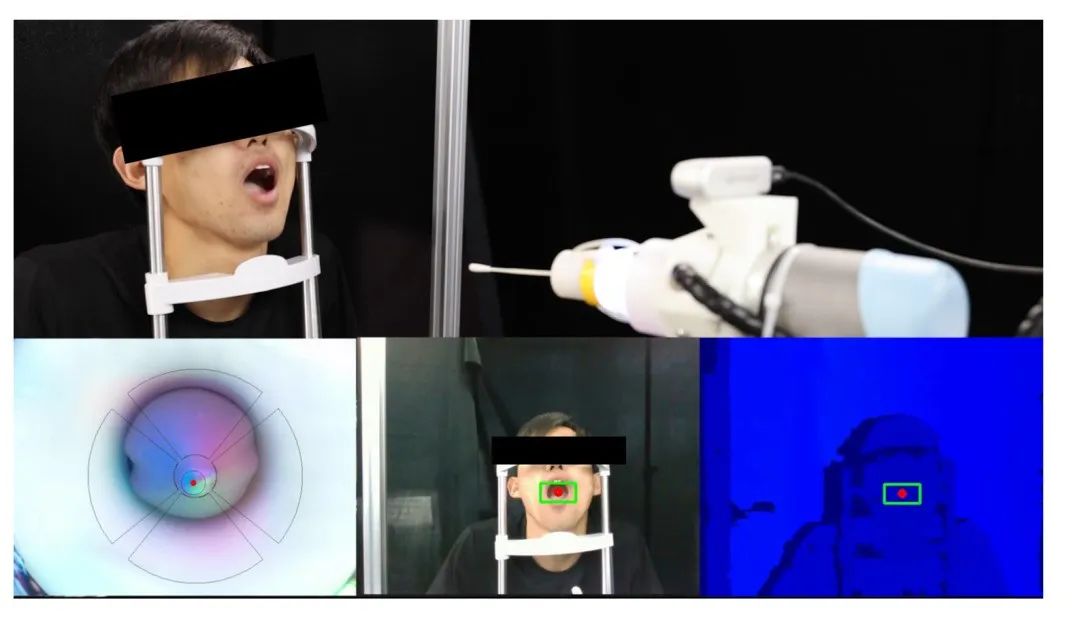

基于视触觉传感器的咽拭子采样机器人

赖建诚:这件事特别像十几年前被逐渐普及的电阻/电容屏,当时大家会觉得键盘能解决一切,是否对触摸屏有真实的需求?但现在,我们生活中的大多数电子产品都采用了可触控的设计,远远超过了在触控屏幕在刚出来时的应用场景。触觉赋予了很多电子产品全新的功能,也衍生出了很多创新的产品,这就是触觉能给生活带来的改变。

杨丰瑜:智能体是根据环境的交互信息来做动作的,所有的传感器都在提供一种hypothesis(假设)。类比人类,比如说我要去抓一个杯子,通过我的视觉判断、经验分析,我大概知道应该抓哪个地方。但我怎么知道我抓到了这个杯子?只有一种可能,就是我触碰到杯子的时候(假设正确的时候)。所有需要与环境进行强交互的地方,都是需要传感器发挥作用的。其实,很多操作如果只依靠视觉或3D远程方案去实现,可能只能做80%,但如果要落地,做到最后的10%-20%,其中就需要很大程度的依靠触觉方案中通过接触来产生的物理信息反馈来实现。

BV:在所有传感器方案中,视触觉方案为什么成为了热点科研方向?

丁文伯:我从过去自己研究电子皮肤,到现在转向光学数据视触觉研究的心路历程来分享一下。我们当时在解决电子皮肤核心的问题,发现当面向大规模阵列做模拟高分辨率采集时,尤其是想做高达几万个阵列的人体触觉感知密度采集,高频率外围电路ADC这种方案是绕不开的,但这种方案的成本很难降下来。但过去10年发展的CCD光电转换技术的发展能很好的绕开ADC高成本的问题。相当于每一帧大概是30赫兹,能低成本完美实现multichannel high resolution。我当时就觉得这个方向靠谱。当你把光当做一种媒介,它可以感知的不仅是机械信息,还可以感知到温度、嗅觉等多模态信息的感知。以前我们讲多模态,是把多种信息放在数字域里去处理,但当有了光之后,我们可以把不同的模态都转化成光(视觉)信息,再用视觉的统一架构来处理,这就可以借助CV领域的东风。

方斌:我们的目的是希望有一个可靠的传感器,建立自己的数据集,做感知识别,把这些用到操作里面。起初关注视触觉传感器的学者非常少,我在2018年 ICRA上发表了国内第一篇视触觉传感器的论文(《A dual-modal vision-based tactile sensor for robotic hand grasping》),后来大家才慢慢开始关注这个方向。

当时做视触觉传感器方案的时候,有合作者并不看好这个方向,需要处理的信息量非常大又复杂,合作过程相对消极,但做科研还是需要有敏锐性和长期坚持。耕耘了十年之后,非常惊喜看到这么多人关注这个领域,并继续在这个方向上发力。对人类来说,相比视觉、听觉、嗅觉、味觉,触觉是生命感知最基础的通道,我们会一直在这个方向上坚持下去。

BV:电子皮肤与视触觉传感器有哪些区别?

赖建诚:电子皮肤和视触觉,是解决触觉需求的两种不同的技术路线,主要区别在于识别触觉信号的机理和所擅长的应用场景。首先,视触觉传感器在铺设和收集大面积的触觉信号时,对硬件、算力和成本的要求会比较高,而电子皮肤因其自身的柔软性和多模态性,可以铺设在机器人的外表面,就像人的皮肤一样,收集真实的三维世界中的多种物理信号,对算力的依赖性不大。此外,在类似手掌、身体表面这样有曲度、不是平面的物体,电子皮肤的柔软特性可以更好地收集数据,它对正压力、剪切力、四维力、温度、湿度、接近觉以及表面粗糙度等信号都能感知,并且可以做到更像人的触觉交互感受。比如说对于养老服务机器人,当把老人抱起来或者搀扶起来的时候,需要知道所有接触位置的力有多大,以确保老人的安全。这个时候就要求在机器人全身满布触觉传感器,而电子皮肤将会是最优的选择。

BV:视触觉传感器、电子皮肤在量产上有哪些挑战?

方斌:视触觉传感器的量产挑战,第一个是可靠性,包括表面硅胶的耐磨性带来的挑战。机器人和人类的触觉系统都会产生磨损问题,人类有自我保护机制,自动更换表皮组织,但机器人目前还无法很好解决这个问题。这也是视触觉传感器为什么在工业场景下没有大范围用起来的根本原因。第二个挑战是视触觉信息嵌入式计算。目前的视触觉方案都是提供接触物体之后的图像,并没有给出相应的力的计算量,这个方向可以降低收集触觉信息的技术门槛,能更方便的把触觉信息推向应用端。这个是未来具身智能触觉领域产品场景化需要解决的两大问题。

赖建诚:目前当具身智能上下游发展起来之后,数据集变大了,算法变得更聪明了,能让机器人做更多任务了,这个时候就该我们电子皮肤上场了。触觉能够赋予机器人多一个维度的信息输入,使得从之前的视觉、听觉这维两个维度的信号进化为触觉、视觉、听觉这三个维度的信号。同时,触觉信号不局限在手上,胳膊、躯干等全身都可以有。

电子皮肤的量产应用方案暂时没有视触觉完善,但目前我们也已经有了完善技术方案来逐步探索。第一,材料很重要,是选取介电材料、导电材料还是半导体材料,并对其加以调控是很核心的问题。第二,要解决鲁棒性问题,要让材料耐得住用。普通电路,比如显示屏,没有挤压环境的影响;但一旦进入触觉领域,要有突然的接触、撞击等情况发生,需要电子皮肤有足够的柔韧性并且耐得住拉伸。目前我们在抗撞击、降成本、增加产量这些问题上,都找到了很好的解决方案。如何在两到三年内生产十万片甚至百万片的好用的电子皮肤产品,这是我们考虑的核心问题。

BV:从视觉到视触觉,有哪些收集数据的经验?

杨丰瑜:我本科的导师是Professor Andrew Owens,在他引导下,我们组研究的就是多模态学习。我刚进组的时候,老师给了我两个选择,一个是做视触觉传感器,另一个是做传统的CV项目。我是做视觉算法出身,并不知道视触觉是什么。好在组里有一个Gelsight设备,我们就经常拿着玩,发现这个东西可以在很多领域发挥作用,非常有趣。

吴恩达老师说过:计算机视觉中,要处理80%的数据和20%的模型问题。跟视觉领域不同的是,视触觉需要高度依赖与物理世界有接触的传感器。一开始遇到最大的问题就是没有数据,那你想做任何的应用都无从谈起。当时我和我老板就说要做一个触觉界的ImageNet。当时我就想,为什么必须要用机器人来采集数据?人可不可以做数据的收集器?第一步,扩大我们的数据集。我们团队三个人每天拿着触觉传感器,每天花五个小时的时间,在不同的室内室外各种地方让传感器去按触,把能按的地方都按完了。遇到的第一个问题就是,Gelsight表面的胶非常容易坏,很容易烂掉。我们自己做的胶有的厚有的薄,都是非标的状态,非常耗时耗力。我们用三个月的时间采集了20多万个不同的点。第二步,要看能否有一个很好的表示。触觉是一件用语言很难描述的事情,因此我们借用触觉和视觉的关联性,来做相互的转化,后来我们用diffusion model来做完成这件事。

BV:如何解决触觉里的泛化问题?

杨丰瑜:传感和具身智能最大的挑战在我看来是泛化,目前视觉和语言的构造已经非常丰富了,我们在想能否把触觉信息也插入进视觉和语言模型中,通过多模态对比学习的方法,完成触觉和其他模态的绑定。

此外,触觉是一种高质量的模态,但这种模态非常小,每当我用Gelsight传感器去按压一个点,接触面积有限,触觉传感只能表征非常小的一块面基代表的信息。但视觉和语言不一样,他们可以描述世界上的绝大多数东西。因此,重点的问题就是,如何在我仅有的触觉采样数据里进行泛化,通过对不同材质、几何位置的稀疏点进行采样,还原推理出稠密的触觉世界。

我的研究方向体现在如何将数据scale up,让更多的触觉数据可以为大家所用。目前视触觉传感器技术路线还没有统一,会面对不同传感器标准不同、数据复用难度大等问题挑战。在我们的触觉模型里,我们把世界上所有开源的视触觉数据集集合在一起,学习出非常大的表征,希望我们的工作能给下游需要利用视触觉和多模态信息打造应用的研究者,提供一些支持。

#03 从应用看不同触觉路线的价值

具身触觉将会是弥补目前控制系统过于复杂的手段。

BV:目前和机器人拥抱是否还非常危险?

赖建诚:这个拥抱的动作如果完全交给视触觉传感器去做,可能面对的问题是:这个动作需要的力,比如1N,要分布在多大的面积上?如果是整个手掌,是没问题的,但如果面积非常小,就很容易对人产生伤害。更好的方式是,电子皮肤加上视触觉传感器一起,让这个问题得到更好解决。

丁文伯:如果不考虑触觉范围大小,视触觉能更好的解决安全性问题。电子皮肤和视触觉这两种方案,毋庸置疑电子皮肤可以更薄,能够贴合机器人表面,可以形成机器人+感知的方案。但视触觉方案里,针对触觉范围问题,我们如果把机械爪、机械臂本身当做感知设备去做一体化设计,那触觉范围的劣势可能不会存在。对柔性问题,我们利用弹性薄膜镜片的柔性/半刚性特性,可以很好的制成软体机械爪,这样就很好的解决了安全性问题。与铁蛋握手,大家肯定会觉得有危险;但与哆来梦、大白一样的机器人握手、拥抱,即使机器人的本体有刚度,但利用弹性薄膜进行外部的覆盖之后,会大大提升机器人的安全性。

BV:具身智能产业链上,如果没有触觉,哪些行业一定发展不起来?

赖建诚:如果没有触觉,那机器人行业跟人/环境能有交互的应用将得不到很好的发展。举个例子,我们带一个很厚的手套,我们的触觉很大程度上会“失灵”了,这个时候我们去抓东西,就会很慢很不灵敏。回到机器人上,目前做抓取的时候动作就很慢,这个过程里如果希望像人类一样灵敏,就需要更好的触觉系统。但如果在不需要跟人接触的场景下,比如安装任务、组装任务,有一个固定路径,这时候触觉的重要性就没有那么高,可以通过对力的调教来完成这些任务。这引出一个问题:具身智能最终走向是哪里?是需要跟人类交互的复杂任务还是不需要交互的简单、重复任务?目前看来,应用场景是需要与人类/环境交互的复杂任务,如果只是解决简单重复任务,那么目前的机器人就可以很好解决。

方斌:未来具身智能机器人需要落到通用场景、做通用任务,不可避免地需要跟物理场景做接触,如果没有触觉,一些特定场景例如医疗、工业等机器人就很难发展起来。例如医疗场景的每一次接触操作都需谨慎,机器人只有配备了精细感知能力才能保证可靠的安全性。再如,工业领域的精密装配,目前在手机装配领域80-90%的工人是在柔性装配线上进行工作。为什么还需要人力来完成这件事呢?很大原因是触觉这块能力不足,对精细设备的感知速度没有人敏捷。未来我们要更关注触觉领域在这些场景的应用。

机器人制作抹茶饮料,图源:清华大学官网

还有一点值得大家关注,人类的动作会有很多误差,但为什么人还可以完成很多精细操作?这还在于触觉会给人带来实时的反馈,我们有通过这些反馈来不断调整精细动作的能力,这个是我们现在机器人所缺乏的。

丁文伯:如果没有触觉,今天我们四位嘉宾可能先失业哈哈。一旦涉及到灵巧操作,具身触觉将会是弥补目前控制系统过于复杂的手段。因为视觉获取的是全局信息,但是微小信息、局部信息对于机器人操作的时候,是至关重要的因素。比如腹腔镜这种远程精准手术操作,需要感受到的力的反馈,是视觉给予不了的。光是看,是很难把握到力度和反馈的。触觉在这种精细的、以及非接触式的操作中,是非常重要的。前段时间刘德华的电影《拆弹专家》里的排爆场景,在未来就需要具有触觉感知的机器人来完成。

#04 触觉研究进行时

数据一致性、非接触帧、大小脑联动......

BV:如何和大小脑进行联动?

丁文伯:从第一原理角度分析,人类分为条件反射和非条件反射,用的是不同的神经元。我们在抓取比较滚烫的东西时候,这些信号并没有经过大脑,而是利用比较低级的神经元就做了反馈。而在做一些精巧操作的时候,需要大量协同手眼脑的工作,这些信息就需要大脑来进行处理。未来从人类神经角度,我认为传感器不一定都要经过机器人的大脑来处理。可能通过模拟计算,来形成灵巧操作的多模态融合方式,单一模态我们就做云边端处理,如果是多模态,就放到大脑集群上处理。视触觉领域的光模拟计算,电子皮肤领域的神经形态的模拟计算,可能会帮助未来具身智能大小脑协同操作成为可行方案。

如果说现在灵巧学习的方式还是基于强化学习的方式,我认为视触觉传感器能带给我们更多的环境参数,这样有可能会训练出更好的模型,也有很大难度,因为现在需要控制的信息非常多,可能会使得模型不收敛。我们还可以参考仿生模式来设计不同位置的传感器,比如指尖传感器,需要收集更多精密信息,就需要更复杂的设计;而手掌可以做一些密度没有那么高、以提供接触式信号为目的的传感器。

BV:视触觉数据集中大量的非接触帧是否有用?

杨丰瑜:如果我们的数据集来源于视频,那势必会存在大量的非接触帧。我们的做法是,把接触帧提取出来,再做处理。我们要结合用这个数据集的目的,来考虑这个问题。有一项工作,我们当时的目的是学习一个触觉表征,希望把触觉和视觉看到的纹理质感信息结合在一起,从这个角度,非接触帧就会形成干扰项。但其他任务上看,非接触帧可能会成为有用的信息,比如很多场景下非常需要判断机器人与环境、物体是否有所接触,最常用的做法就是把非接触帧和接触帧拿来做一个差值,这样就可以判断出来机器人有没有在接触,以及传感器的真实信号质量是怎么样的。在这个角度,非接触帧的意义是非常大的。

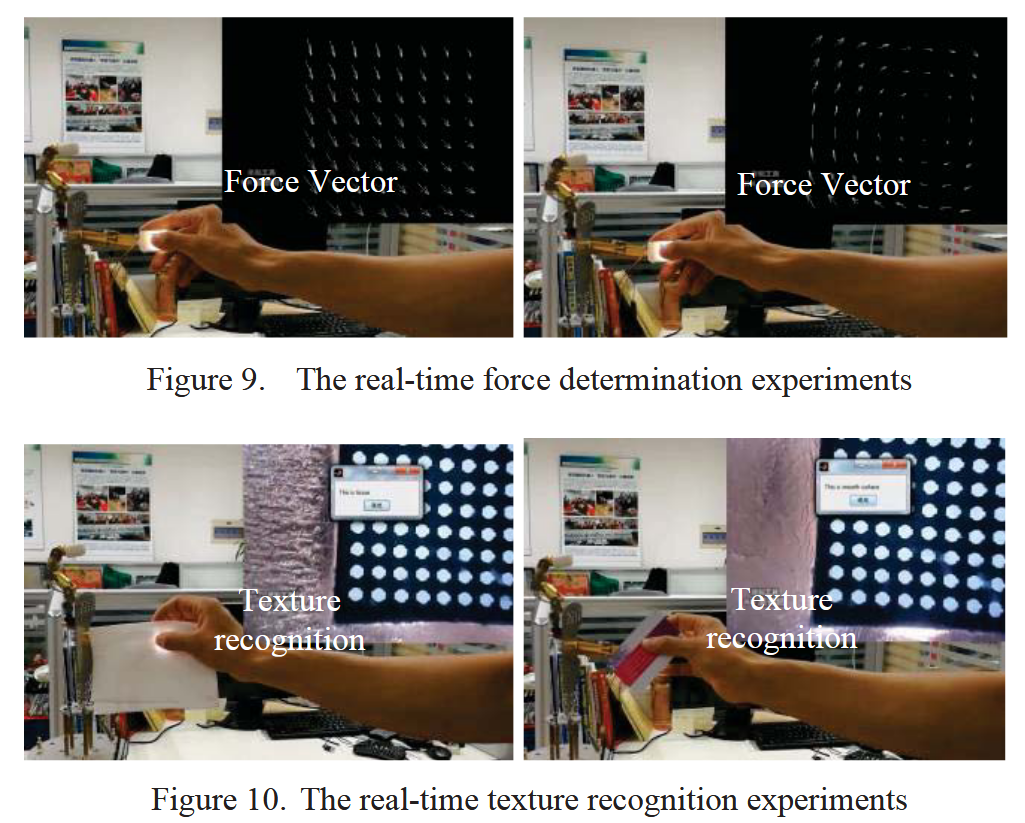

BV:如果数据的一致性差,那是不是就表明数据白采集了?

方斌:这就要看采集后的信息怎么来使用。视触觉信息是多模态信息,和单一模态相比所包含的信息更为丰富。例如今年ICRA 浙大叶琦老师课题组的一篇视触觉工作,用的压阻触觉数据信号质量较差,没有实现触觉的连续测量的能力,就利用了手部与物体操作中有没有接触到的信息,与外部视觉融合,凭借这样的融合信息,在机器人做拧瓶盖的任务成功率就得到了较大幅度的提升。

BV:阻式的传感器作为触觉传感器怎么样?怎么才能弥补采集数据一致性比较差的问题?

方斌:我们目前采用的压阻式传感器,是做了一平方厘米16个阵列点的预标定,通过标定来提升测量的精度。压阻传感器成本低,形态也比较薄,但容易受到外界环境的影响。

赖建诚:电阻和电容式的传感器我们都做,我们的思路是依靠材料来优化性能。我们采用压敏但非温敏的材料,可以降低温度依赖性。

BV:压组阵列式触觉传感器、视触觉传感器还有电子皮肤,谁更适合用在灵巧手的表面上?

赖建诚:需要看采集信息的用途和场景。如果只是想知道指尖的接触信息,我认为三种传感器都有可能实现。在不考虑较大面积以及冲击和碰撞的情况下,视触觉方案会更成熟。如果考虑机器人的内部空间含有多个电机,很难有完整空间铺设视觉模块/电路模块,且对于整手或者躯干部分有触觉需求的情况下,电子皮肤会更合适。

BV:怎么看特斯拉触觉传感方案?

方斌:目前特斯拉用的是薄膜式的触觉传感器,从效果上看,跟目前压阻式的比较类似。为什么视触觉传感器没有被采用?原因应该是目前压阻式比较成熟,计算量也更小一些。视触觉的产品化还需要学界、产业界的持续推进,集成化的能力还需要提升。

图源:特斯拉官方视频

今年3月,方斌教授曾和多位老师共同组织具身触觉论坛,由此建立起国内第一个具身触觉技术社区。论坛和社区的建立,就像星星之火,将推动具身智能产业应用的火热发展,把中国的TactileNet引向世界。

优质前沿技术交流需要更好的创新场域,在此再次感谢具身触觉社区、机器人大讲堂、AI TIME等平台对本次活动的大力支持!

完整直播视频请移步机器人大讲堂视频号、AITIME论道 B站进行观看。

从科研到产业应用,期待更多创新的发生。

*Photo by Katja Anokhina on Unsplash

往期精彩文章推荐

ACL2024 | OceanGPT-沧渊:面向海洋科学任务的大型语言模型初探

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了1800多位海内外讲者,举办了逾600场活动,超700万人次观看。

我知道你

在看

提出观点,表达想法,欢迎

留言

点击 阅读原文 观看精彩回放!