- 1Flutter 学习_apk2 green-box

- 2vue3 h5跳转到小程序,h5分享微信自定义标题和图标_app分享到微信的h5链接转发自定义标题

- 3html5音乐播放器代码,html5简单迷你音乐播放器代码

- 4mac-安装nginx,实现前端访问80端口后端转8080_nginx配置8080端口

- 5EFI盘删除后U盘无法读取、格式化_u盘删除ufi后不能使用了

- 6怎么给3d模型贴图?---模大狮模型网

- 7Java学习笔记(二)_scanner input=new scanner(system.in)

- 8【深度学习】(8) CNN中的通道注意力机制(SEnet、ECAnet),附Tensorflow完整代码

- 9数据结构和算法模块——队列(多例子+图文)

- 10【论文笔记】用于H&E和IHC染色切片分析的基础模型

在阿里云平台部署ChatGLM2-6B模型、langchain-ChatGLM2知识库_langchain-chatchat 阿里云人工只能平台

赞

踩

阿里云平台的环境搭建

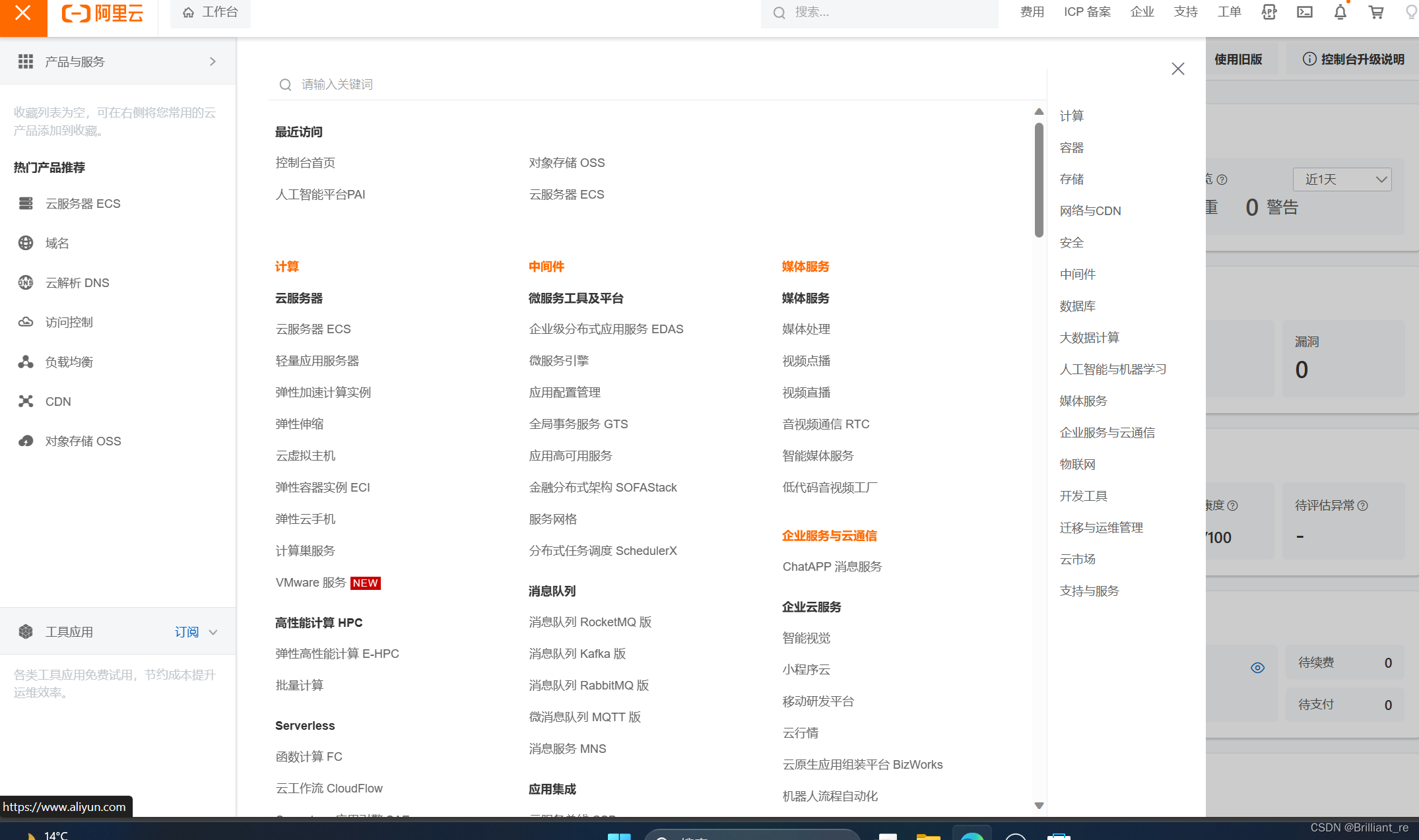

首先是登录阿里云账号,如果没有阿里云账号的需要先注册,然后完成实名认证。这里企业认证和个人认证都可以。

接着领取账号免费试用的权益。在权益中心免费试用里面,选择交互式建模PAI-DSW,领取后将会获得3个月的免费试用时长。

进入控制台,在上述界面中选择人工智能平台PAI,在左边菜单栏选择交互式建模(DSW)。点击创造实例,填写实例名称,资源组选择GPU规格

进入控制台,在上述界面中选择人工智能平台PAI,在左边菜单栏选择交互式建模(DSW)。点击创造实例,填写实例名称,资源组选择GPU规格

| ecs.gn6v-c8g1.2xlarge |

只有这个选项支持试用资源包的抵扣。镜像选择官方镜像即可,我此时的镜像为modelscope1.9.5-pytorch2.0.1-tensorflow2.13.0-gpu-py3.8-cu118-ubuntu20.04

接着下一步创建实例即可。等待环境准备完毕后启动打开即可。这个环境是Linux系统环境。

ChatGLM2-6B模型部署

官网地址https://github.com/THUDM/ChatGLM2-6B

复制源代码

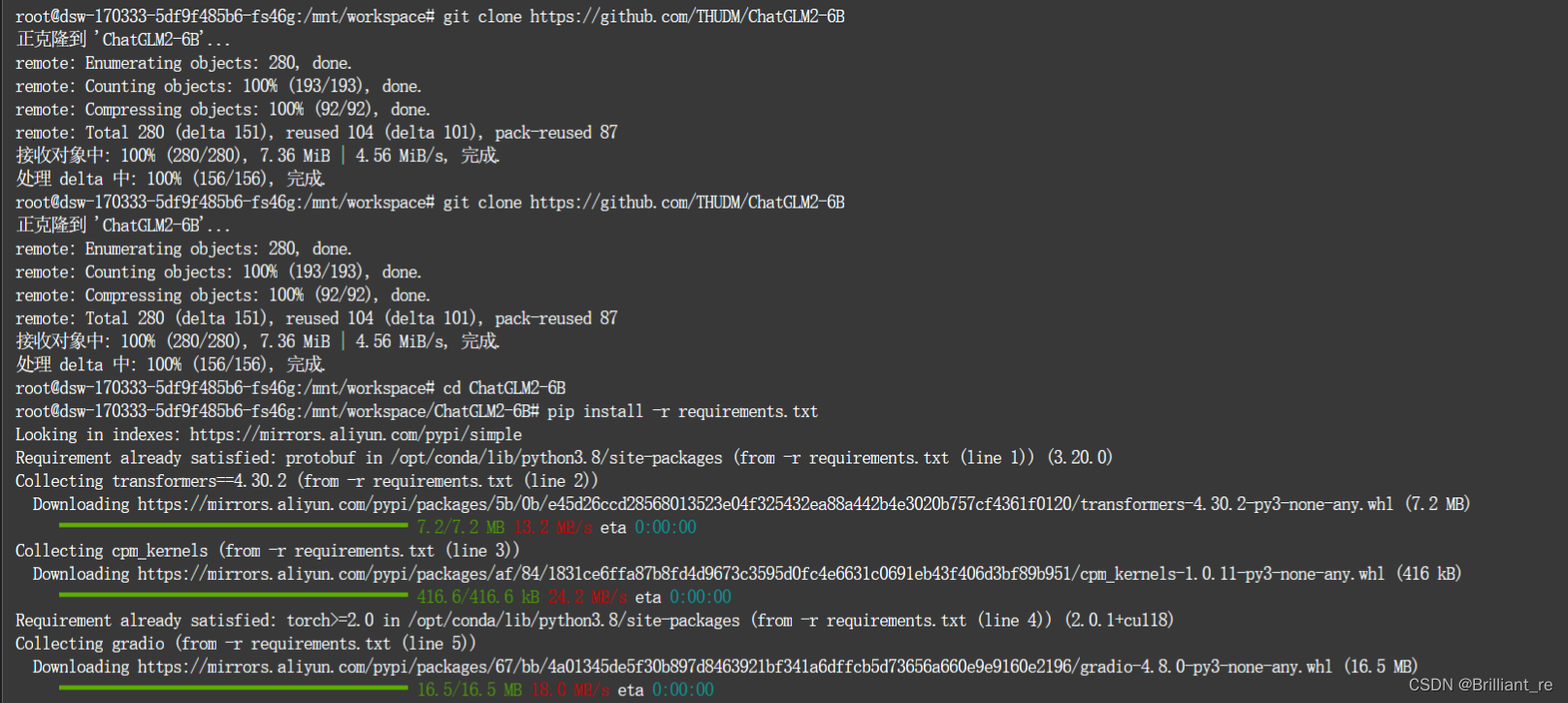

首先打开终端,下载chatglm2的源码,输入

git clone https://github.com/THUDM/ChatGLM2-6B

克隆源码后,进入ChatGLM2-6B目录下

cd ChatGLM2-6B

安装依赖包

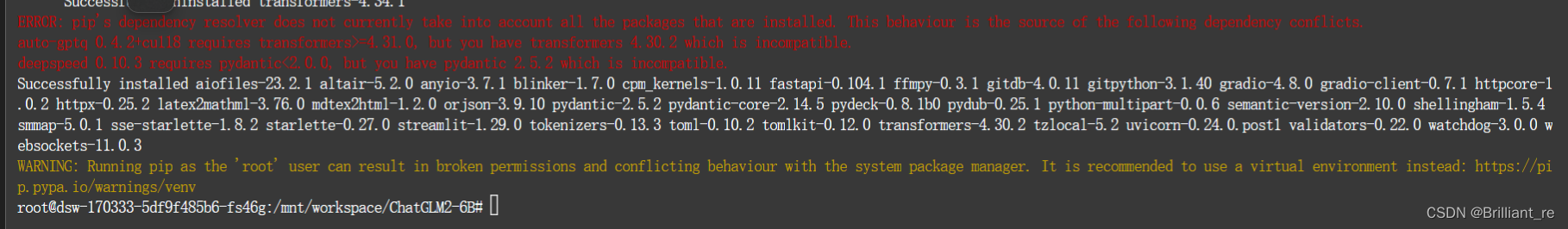

安装我们需要的各种依赖包

pip install -r requirements.txt

依赖包安装后可能会出现下面的报错,不用理会它们,并不会影响到我们的模型搭建

之后更新我们的lfs

git lfs install

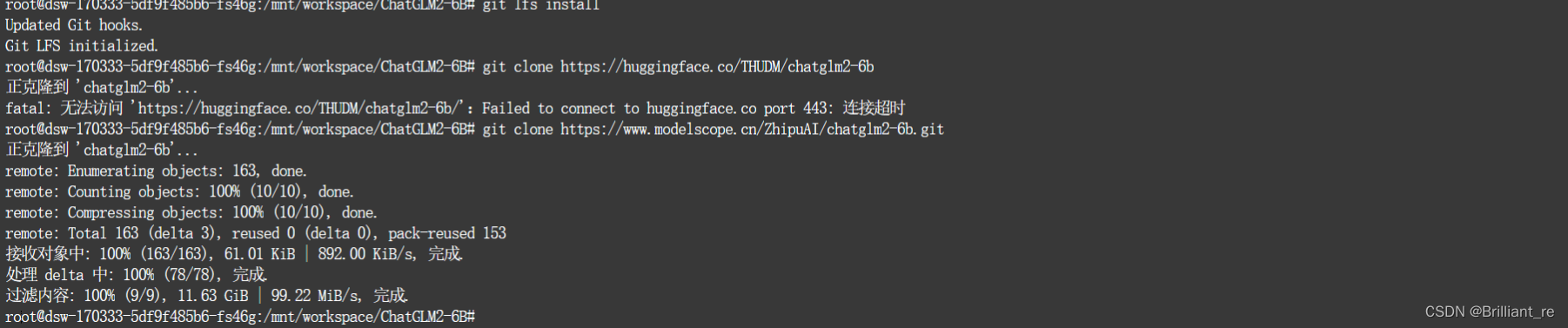

下载模型文件

接下来进行我们的模型文件下载

git clone https://huggingface.co/THUDM/chatglm2-6b

但是由于huggingface可能无法访问,会出现下面的连接超时的错误

我们从魔塔官网上下载模型文件chatglm2-6b · 模型库 (modelscope.cn),输入下面的命令

git clone https://www.modelscope.cn/ZhipuAI/chatglm2-6b.git

修改相关代码

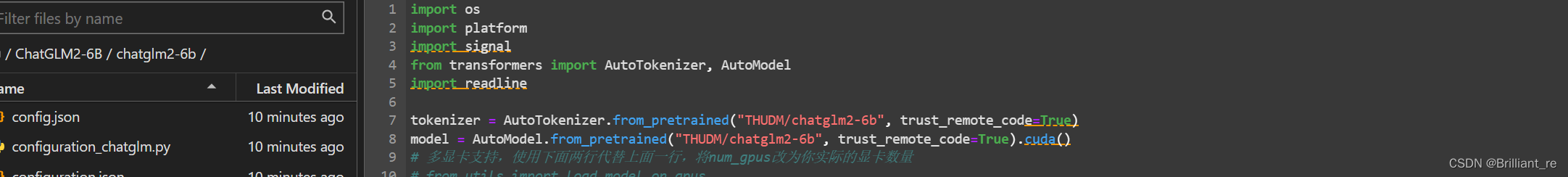

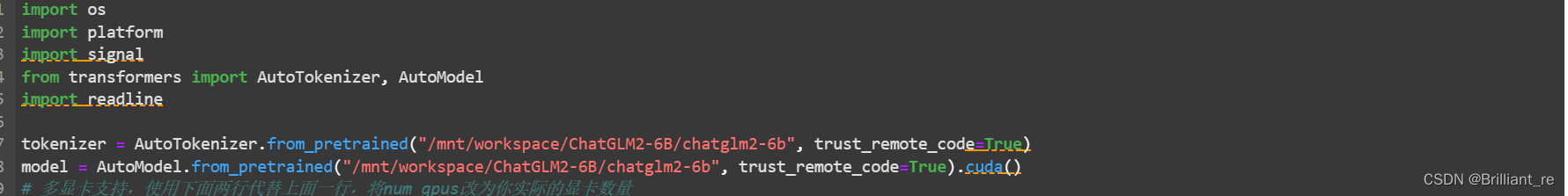

接着我们需要修改cli与web代码中的模型路径,确保正确启动模型

左边菜单栏进入ChatGLM2-6B,打开cli_demo.py代码文件,将下图中的THUDM/chatglm2-6b改为我们的模型路径,这里我使用绝对路径。另建一个终端,进入ChatGLM2-6B/chatglm2-6b目录中输入pwd查看绝对路径,之后我们将路径复制到cli与web文件中

之后保存文件运行模型即可

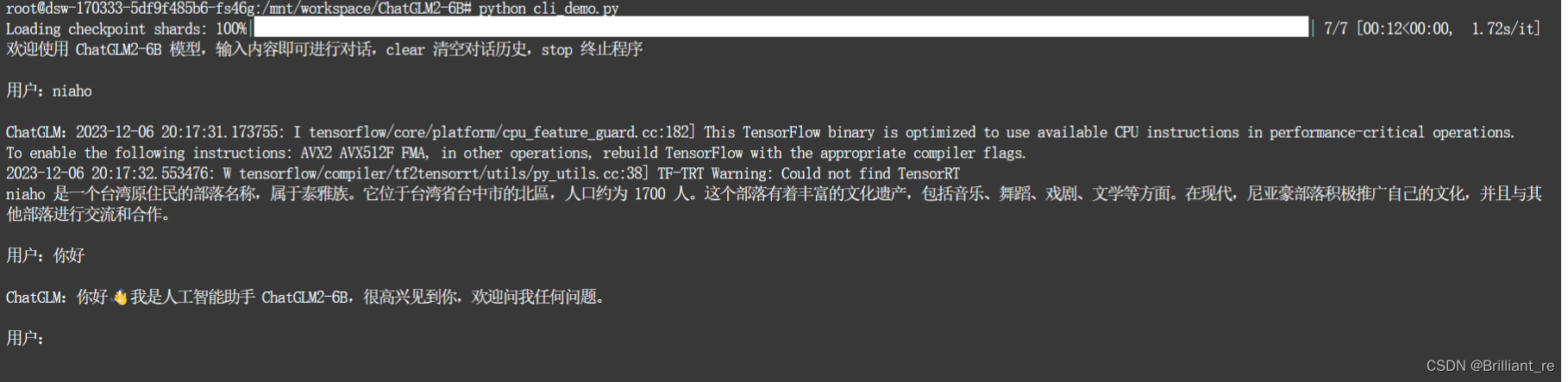

启动模型

我们先运行命令行模型,输入

python cli_demo.py

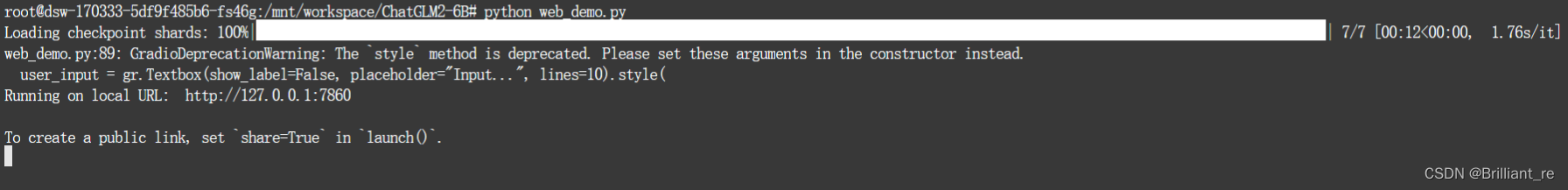

接下来我们尝试运行网页版的模型

python web_demo.py

图中看我们遇到了一个错误AttributeError: 'Textbox' object has no attribute 'style',这可能是与我们的第三方库Gradio的版本问题。我们输入下面的命令下载3.40.0版本的Gradio即可解决这个问题

pip install Gradio==3.40.0

安装完成后我们再次启动网页版

python web_demo.py

我们点击这个网站

进入网页版模型

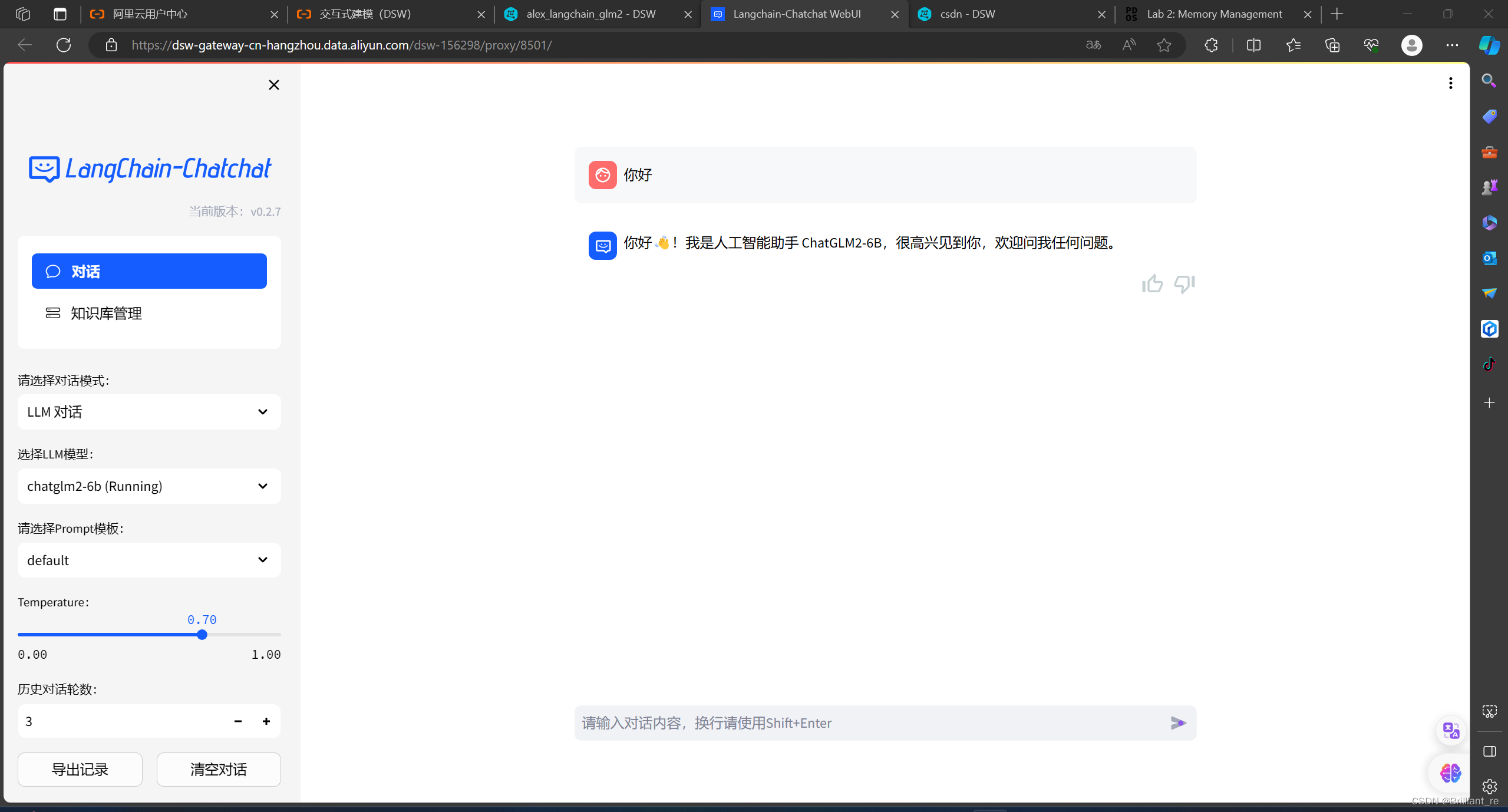

langchain-ChatGLM2-6B知识库部署

获取源代码

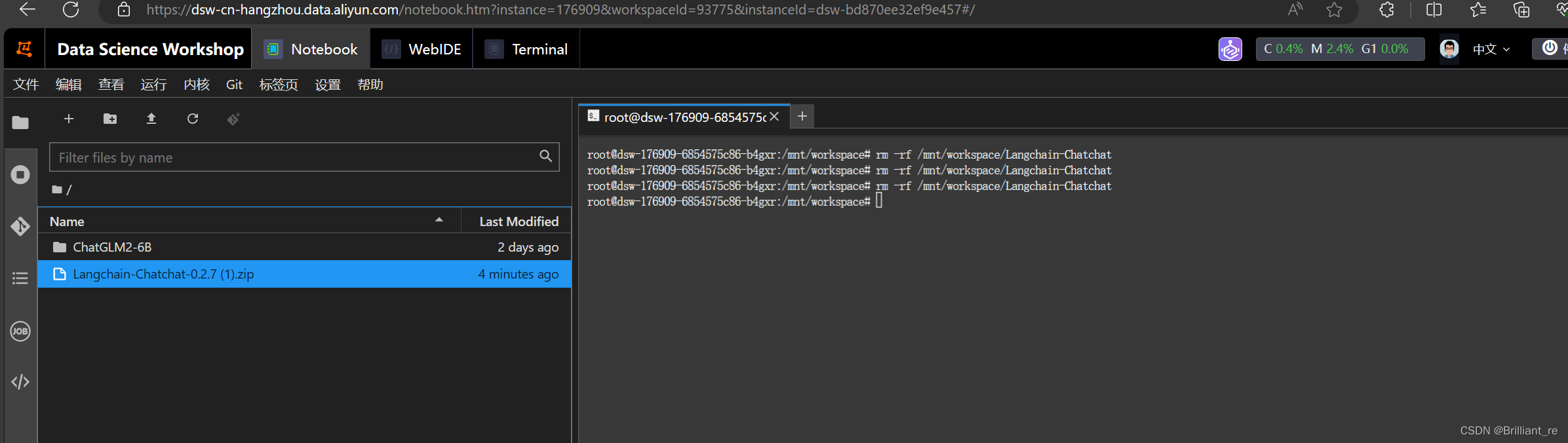

由于GitHub上面最新版已经修改为chatglm3的源码,所以我们先找到之前的版本v0.2.7,然后下载压缩包到本地,之后将压缩包拖入云平台。

修改压缩包重命名为Langchain-ChatGLM.zip,然后下载unzip使用unzip命令解压

apt-get update

apt-get install unzip

unzip Langchain-ChatGLM.zip

将压缩后的文件命名为Langchain-ChatGLM

进入langchain-ChatGLM目录

cd langchain-ChatGLM

安装依赖包

安装全部依赖,遇到报错或者警告不用理会

pip install -r requirements.txt

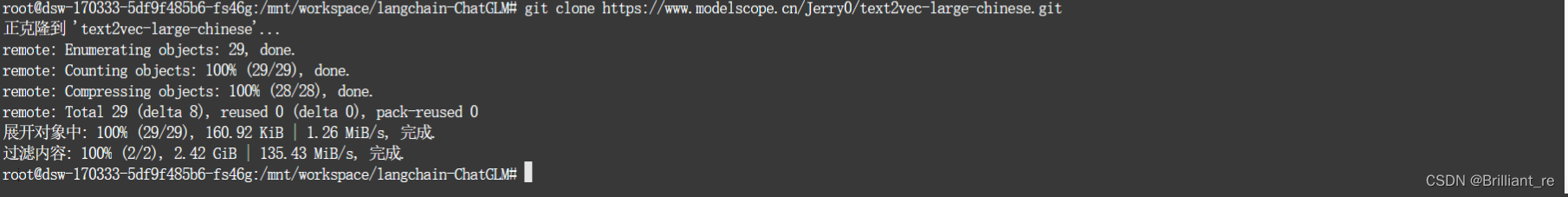

由于已经下载部署过ChatGLM2模型,接下来我们下载embedding模型,以text2vec-large-chinese为例,由于huggingface不能访问,我们依旧从model scope下载模型

git clone https://www.modelscope.cn/Jerry0/text2vec-large-chinese.git

之后更新复制的配置文件

python copy_config_example.py

修改相关代码

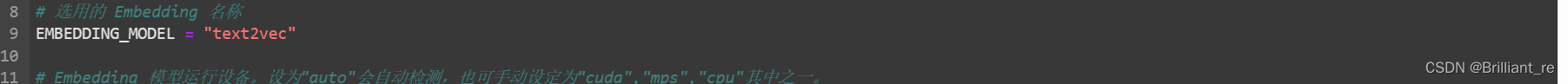

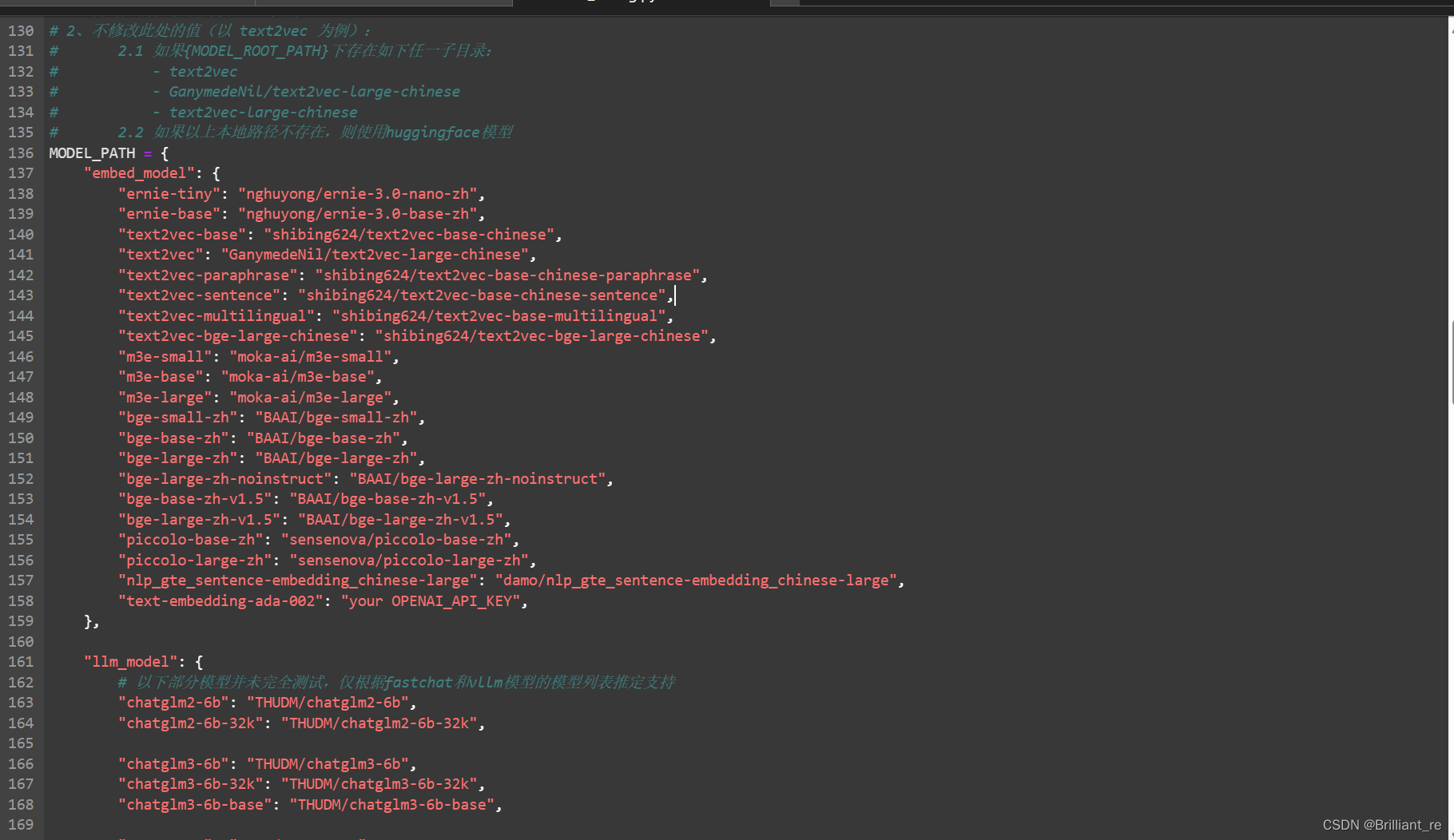

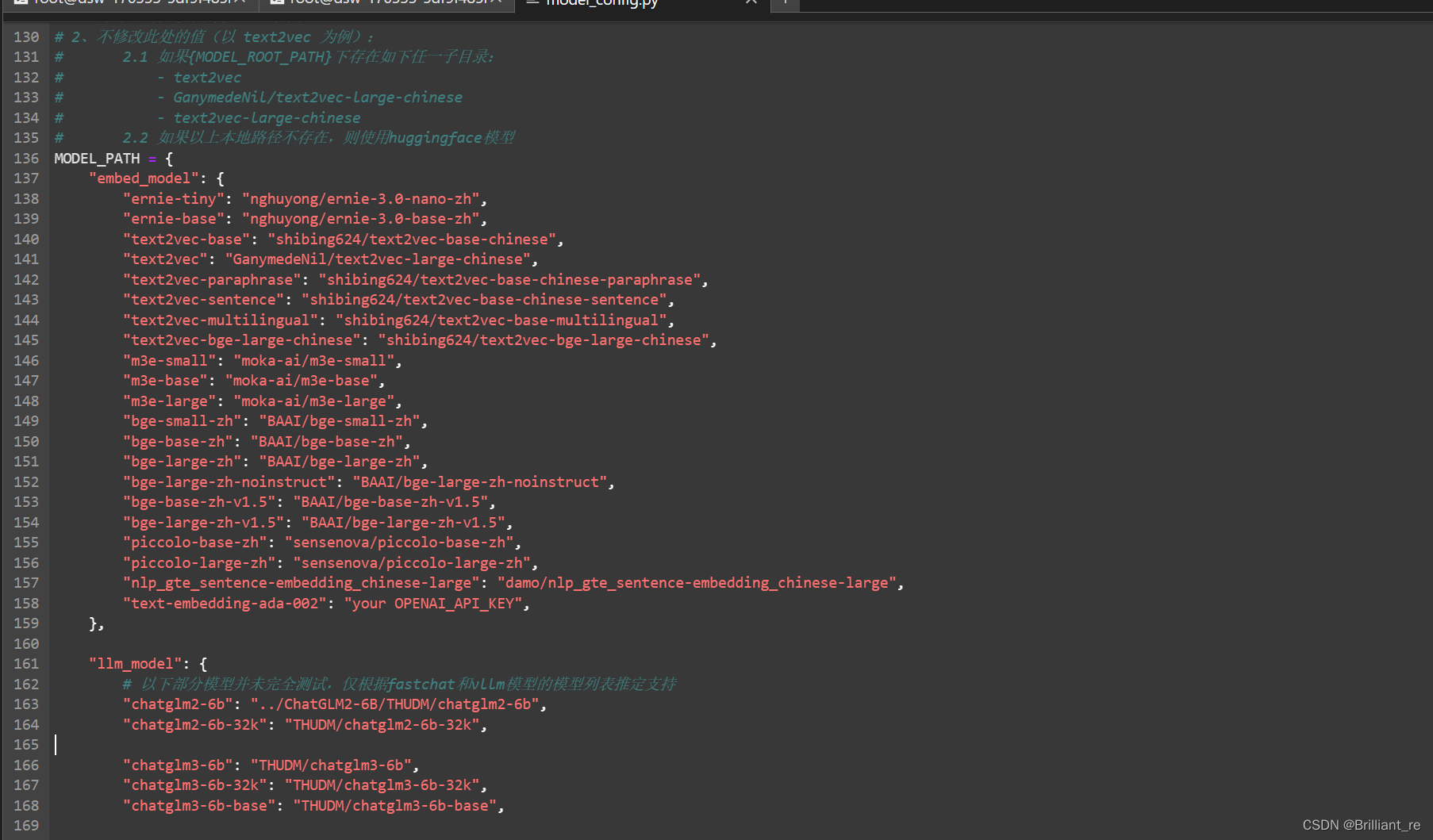

左边菜单栏中进入configs文件夹,修改model_config,py代码文件

将EMBEDDING_MODEL中的"m3e-base“修改为"text2vec"

再将LLM_MODELS=["chatglm2-6b", "zhipu-api", "openai-api"]中的”zhipu-api"删除

然后修改模型的名称和路径

"text2vec": "GanymedeNil/text2vec-large-chinese"中地址修改为text2vec-large-chinese

"chatglm2-6b": "THUDM/chatglm2-6b",中地址修改为../ChatGLM2-6B/THUDM/chatglm2-6b

至此配置文件代码修改完毕

我们需要再安装两个依赖包,避免版本不兼容的问题

pip install torch==2.0.1

pip install langchain==0.0.340

启动模型

接下来我们初始化知识库

python init_database.py --recreate-vs

然后正式启动模型

python startup.py -a

点击网页地址进入web界面,至此知识库搭建完成。