热门标签

热门文章

- 1初学者都能懂的深度学习之神经网络(二)梯度下降法_更新权重梯度下降两层激活

- 2RabbitMQ的介绍

- 3图像质量评价:感知建模vs机器学习【VALSE Webinar】Panel实录

- 4STM32串口通信(发送与接收数据)_stm32串口发送数据

- 5CLIP-Chinese:中文多模态对比学习预训练模型

- 6鸿蒙应用的性能优化与内存管理?_鸿蒙内存管理

- 7禁止访问php框架模板文件下载,解决办法:防止DedeCMS网站模板文件被下载(附批量处理站点的方法)...

- 8【计算机毕业设计】基于SpringBoot+Vue物业管理系统的设计与实现_基于springboot+vue小区物业(源代码+数据库)

- 9逆向工程的未来在哪里?掌握逆向技能,开创新的职业道路!_软件逆向工程行业前景

- 10RuntimeError: Trying to resize storage that is not resizable at ..\aten\src\TH\THStorageFunctions.cp

当前位置: article > 正文

随机梯度下降(SGD)和批量梯度下降(BGD)的区别_批量梯度下降法和随机梯度下降法的区别

作者:我家自动化 | 2024-03-26 18:56:46

赞

踩

批量梯度下降法和随机梯度下降法的区别

梯度下降(GD, gradient descent):梯度下降法是求解无约束最优化问题的一种常用方法,比较适用于控制变量较多,受控系统比较复杂,无法建立准确数学模型的最优化控制过程。是一种迭代算法,每一步需要求解目标函数的梯度向量。

在机器学习中,GD主要用于降低模型输出和真实输出之间的损失/误差,迭代模型结构。随机梯度下降是随机取样替代完整的样本,主要作用是提高迭代速度,避免陷入庞大计算量的泥沼。对于整个样本做GD又称为批梯度下降(BGD,batch gradient descent)。

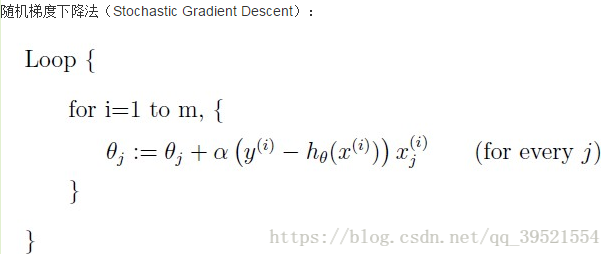

随机梯度下降(SGD, stochastic gradient descent):名字中已经体现了核心思想,随机选取一个店做梯度下降,而不是遍历所有样本后进行参数迭代。因为梯度下降法的代价函数计算需要遍历所有样本,而且是每次迭代都要遍历,直至达到局部最优解,在样本量庞大时就显得收敛速度比较慢了,计算量非常庞大。

随机梯度下降仅以当前样本点进行最小值求解,通常无法达到真正局部最优解,但可以比较接近。属于大样本兼顾计算成本的折中方案。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/319014

推荐阅读

相关标签