- 1FPGA学习路线

- 2类和面向对象习题_25. 下列有关构造方法描述正确的是(c )。 a、所有类都必须定义一个构造方法 b、构

- 3安装Oracle12C提示Hard limit:maxinum open file descriptors的解决方法_please set the maximum number of open file descrip

- 4如何使用 ISP 工具烧写 Surf5_isp工具

- 5虚拟摄像头之五: 详解 android8 的 Camera 子系统框架_安卓虚拟摄像头

- 6ISP调试——基础概念理解

- 72024年软件测试行业发展趋势,智能和服务化成变革关键_软件测试产业的市场需求随着日益增长的信息化水平和智能化水平呈现增长趋势,未来

- 8【转】Developer Express 系列控件使用心得-1

- 9大数据营销的下一步

- 10Hive:日期函数

“具有分布式能源资源的多个智能家庭的能源管理的联邦强化学习”文章学习三——基于联邦深度学习的多智能家居能源管理

赞

踩

一、系统描述

我们考虑一个基于FRL的HEMS,它由单个GS和N个LHEMS组成,如图2所示。如图2-C所示,FRL训练过程包括两个步骤:步骤1)使用本地数据对LHEMS(即本地神经网络的权重ωn)进行本地模型的训练和更新;步骤2)通过平均法(ωG = 1N [1]Nn=1 ωn)对GS进行全局模型的聚合和更新。更新后的本地模型和全局模型将迭代交换,直到满足某种停止标准。

我们考虑LHEMS调度三种可控设备的情形:1)可减少设备(AC);2)具有非可中断负载的可调度设备(WM);3)具有可中断负载的可调度设备(ESS)。可减少设备的能源消耗可以降低电力成本。在分时电价方案下,可调度设备的能源消耗可以从一个时间段转移到另一个时间段,以最小化总电力成本。具有可中断或不可中断负载的可调度设备。在设备任务期间,HEMS控制不能停止具有不可中断负载的可调度设备的运行。相比之下,具有可中断负载的可调度设备可以随时中断。

在HEMS中,AC、WM和ESS的代理通过A2C深度强化学习过程独立执行各自设备的提前一天调度,以1小时为调度分辨率,遵循分时电价。每个设备代理的目标是在满足消费者舒适水平和偏好的同时,降低电力成本并考虑设备运行特性。对于AC,给定状态SAC包括电价、室外温度和室内温度(如4所示),AC代理通过最大化Rt AC(如8所示)来决定AC的最优能耗调度[即,动作Et AC(7)],该函数为负电价和与室内温度相关的消费者舒适成本的之和。对于WM,给定状态SWM包括电价(如5所示),WM代理通过最大化Rt WM(如9所示)来计算WM的最优能耗调度[即,动作Et WM(7)],该函数为负电价和与WM首选运行时间相关的消费者舒适成本的之和。对于ESS,给定状态SESS包括电价、SOE和预测的PV发电量(如6所示),ESS代理通过最大化Rt ESS(如10所示)来计算ESS的最优充放电调度[即,动作Et ESS(7)],该函数为负电价和与ESS过充电和欠充电相关的可靠运行成本的之和。

我们假设HEMS配备了智能电表和智能插头,为本地深度强化学习模块提供输入数据,例如消费者的净能耗和单个设备的能耗。接下来两节将阐述FRL方法的数学模型和算法——状态空间和动作空间的制定以及LHEMS代理的奖励函数和包括A2C方法在内的基于FRL的能量管理方法。

二、数学模型

(1)状态空间:对于∀t = 1,..., 24,WM、AC和ESS代理的状态空间定义如下:

在状态空间定义里,t表示WM、AC和ESS的调度时间。状态Pt表示在t时刻的TOU价值。状态![]() 是t时刻预测的室外温度。

是t时刻预测的室外温度。![]() 是t时刻预测的室内温度,它的计算将使用到

是t时刻预测的室内温度,它的计算将使用到![]() ,用下式:

,用下式:

![]()

![]() 。t时刻AC的能源消耗为

。t时刻AC的能源消耗为![]() ,环境参数

,环境参数![]() 为描述室内温度条件的参数。其它参数的定义类似。

为描述室内温度条件的参数。其它参数的定义类似。

(2)动作空间:每个设备的最优动作取决于代理的环境,包括现在的状态,如(4)至(6)所示。WM、AC和ESS的动作空间如下所示:

![]()

每个动作空间的变量分别表示时间t上空调能耗、WM能耗以及ESS的充电或放电能量。

(3)奖励函数:对于每个设备代理,奖励函数被制定为与消费者偏好的舒适度和设备运行特性相关的负电力成本和负不满成本的之和。首先,空调代理的奖励函数可表达为

其中,![]() 和

和![]() 是消费者热不适来定义的惩罚。这种不舒适的价值定义为消费者偏好的温度

是消费者热不适来定义的惩罚。这种不舒适的价值定义为消费者偏好的温度![]() 与

与![]() 和

和![]() 之间的偏差。只有当

之间的偏差。只有当![]() 偏离

偏离![]() 范围时,才将其视为带有负号的奖励。接下来,WM代理的奖励函数可表达为

范围时,才将其视为带有负号的奖励。接下来,WM代理的奖励函数可表达为

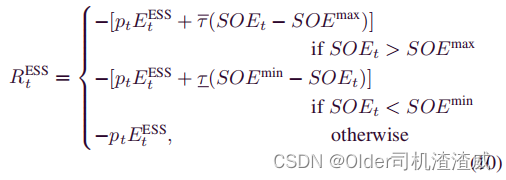

其中,ωs_pref 和 ωf_pref 分别是消费者偏好的 WM 起始和结束时间,而 δ 和 δ 分别是比消费者偏好的运行时间提前和延迟操作的惩罚。如果 WM 代理在 ωs_pref之前或 ωf_pref 之后安排 WM 的能耗,则将不满成本添加到奖励函数中并带有负值;否则,奖励函数只具有负电力成本。最后,ESS 代理的奖励函数定义为

其中,两个τ 分别代表 ESS 过充电和欠充电的惩罚。如果 SOE 低于 SOEmin(欠充电)或高于 SOEmax(过充电),则 ESS 发生能量利用不足。在 ESS 利用不足的情况下,将其视为奖励项,同时考虑在此期间的电力成本。每个代理都执行自己的学习过程,以在有限的时间间隔 T 内从环境中获得的总累积奖励最大化。