- 1Java 实现微信支付详细教程_java微信支付

- 2python3 vsphere 虚拟机管理平台_pyvmomi

- 3C运行时库(C run-time library)概述_c++ runtime library

- 4黑马程序员Java面试专题(2)|并发编程篇(1)线程基础_程序猿面试

- 5RK3566快速入门指南 ROC-RK PC开发板详细入门指南 嵌入式_rk3566书

- 6基于SpringBoot和HeatMap的全球地震热力图可视化实践

- 72022年软件设计师考试复习资料(1)_软件设计师资料

- 8基线理解_SHAP的变量解释性绘图理解与应用_shap.dependence_plot

- 9datasophon大数据组件安装

- 10软考高项-计算题(2)

Big Model Weekly 第6期

赞

踩

点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

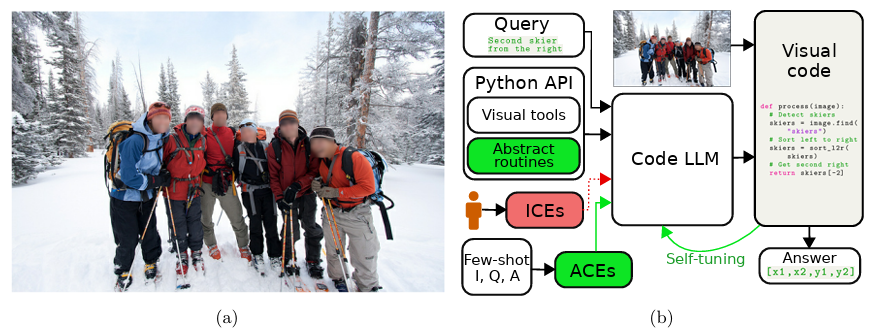

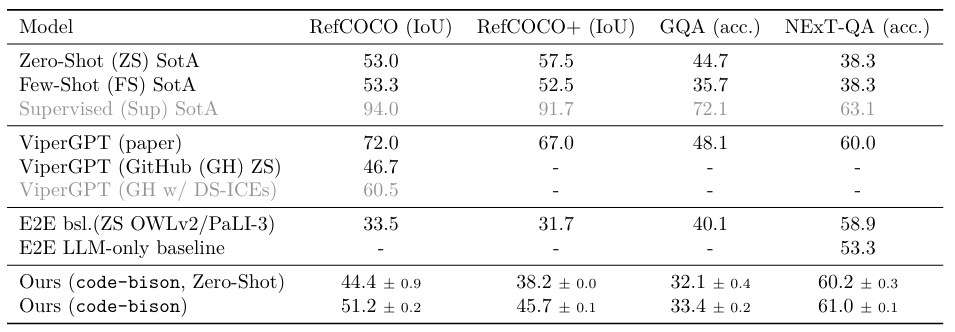

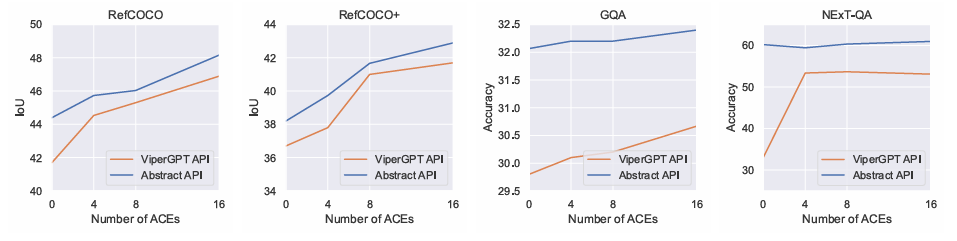

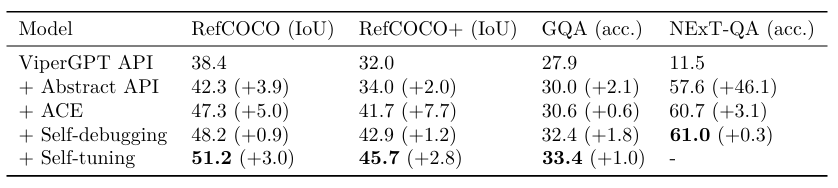

1. Towards Truly Zero-shot Compositional Visual Reasoning with LLMs as Programmers

视觉推理主要由规模达数十亿模型参数和训练示例的端到端神经网络主导。然而,即使是最大的模型在复合推理、泛化、细粒度空间和时间推理以及计数方面都面临困难。具有大型语言模型(LLMs)作为控制器的视觉推理在原理上可以解决这些限制,通过分解任务并通过协调一组(视觉)工具来解决子任务。最近,这些模型在组合视觉问题回答、视觉定位和视频时间推理等任务上取得了出色的性能。然而,以它们当前的形式来看,这些模型在很大程度上依赖于在提示中人工设计的上下文示例,这些示例通常是特定于数据集和任务的,需要高技能程序员进行大量劳动。这项工作提出了一个框架,通过引入空间和时间抽象例程,并利用少量标记示例自动生成上下文示例,从而减轻了这些问题,避免了人工创建的上下文示例。在多个视觉推理任务上,本文展示了所提框架在性能上的一致提升,使LLMs作为控制器的设置更加健壮,并消除了对人工设计上下文示例的需求。

文章链接:

https://arxiv.org/pdf/2401.01974.pdf

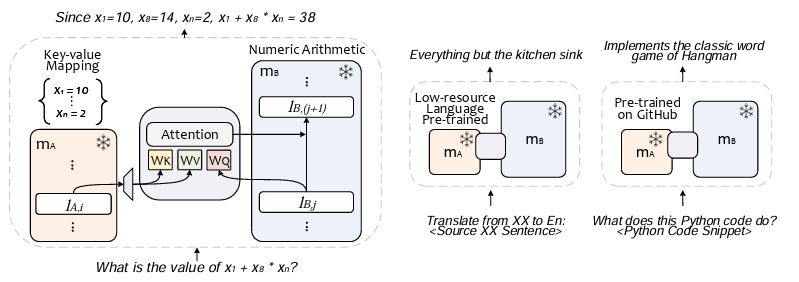

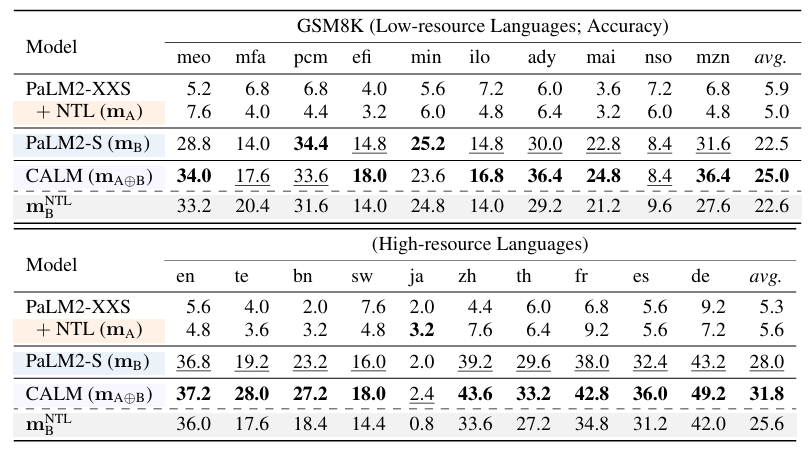

2. LLM Augmented LLMs: Expanding Capabilities through Composition

拥有数十亿参数的基础模型在大型数据语料库上训练后,在各种领域展示出非平凡的技能。然而,由于它们的整体结构,要对其进行扩充或赋予新技能具有挑战性且昂贵。另一方面,由于它们的适应能力,正在训练这些模型的多个新实例以适应新的领域和任务。这项工作研究了如何高效而实用地将现有基础模型与更具体的模型组合,以实现新的功能。为此,作者提出了CALM(Composition to Augment Language Models),引入了模型之间的交叉注意力,以组合它们的表示并实现新的功能。CALM的显著特点包括:(i)通过“重用”现有LLMs以及一些额外的参数和数据,将LLMs扩展到新任务上,(ii)保持现有模型权重不变,因此保留了现有的能力,以及(iii)适用于不同的领域和环境。本文演示了通过用在低资源语言上训练的较小模型对PaLM2-S进行扩充,使其在翻译成英语和低资源语言的算术推理等任务上绝对改进高达13%。同样,当PaLM2-S与一个针对代码的特定模型进行扩充时,在代码生成和解释任务上相对基础模型的改进达到40%,与完全微调的对照模型相媲美。

文章链接:

https://arxiv.org/pdf/2401.02412.pdf

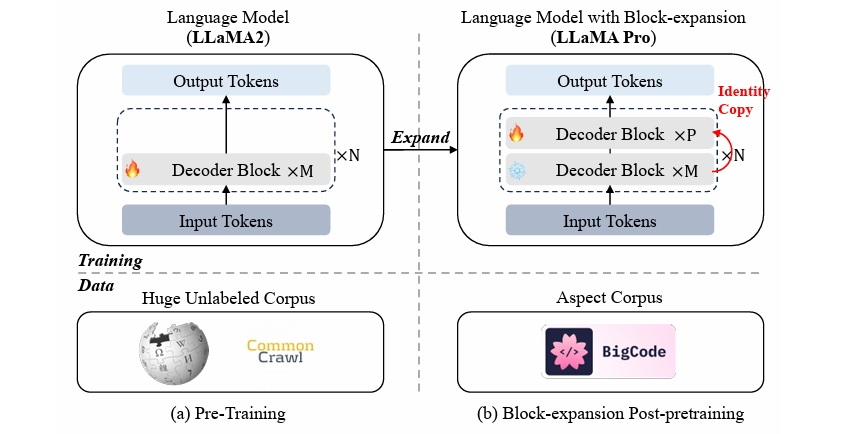

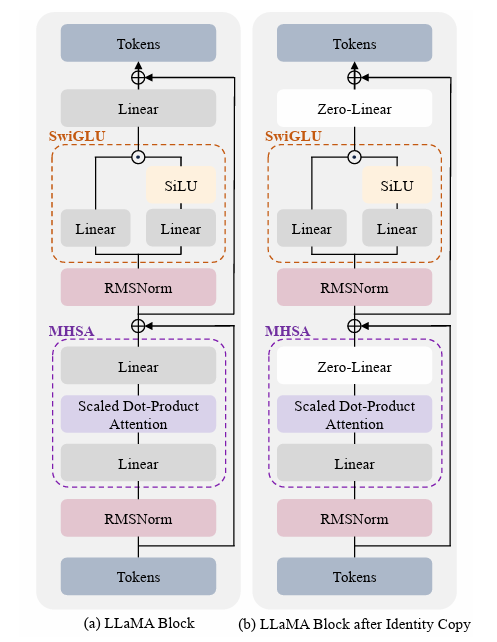

3. LLaMA Pro: Progressive LLaMA with Block Expansion

人类通常在不损害旧技能的情况下获得新技能;然而,对于大型语言模型(LLMs),例如从LLaMA到CodeLLaMA,情况正好相反。为此,本文提出了一种用于LLMs的新的预训练后方法,其中包括Transformer块的扩展。作者仅使用新语料库调整扩展块,以高效而有效地提升模型的知识,而不引发灾难性的遗忘。本文在代码和数学语料库上进行实验,得到了LLAMA PRO-8.3B,初始化自LLaMA2-7B,在一般任务、编程和数学方面表现出色。LLAMA PRO及其遵循指令的对应模型(LLAMA PRO - INSTRUCT)在各种基准测试中取得了先进的性能,显示出在LLaMA家族和各种任务中超越现有开放模型的优越性,以及作为智能代理进行推理和解决多样化任务的巨大潜力。该发现为整合自然语言和编程语言提供了宝贵的见解,为在各种环境中有效运作的先进语言代理的开发奠定了坚实基础。

文章链接:

https://arxiv.org/pdf/2401.02415.pdf

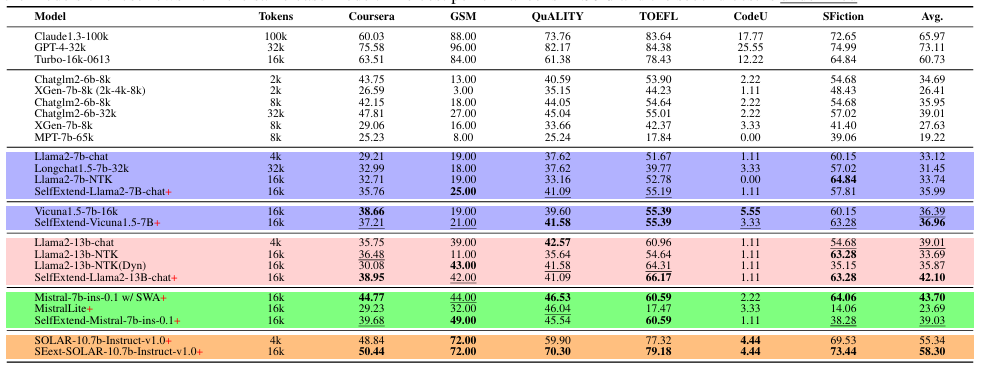

4. LLM Maybe LongLM: Self-Extend LLM Context Window Without Tuning

这项工作揭示了大型语言模型(LLMs)在没有微调的情况下处理长上下文的固有能力。在训练过程中,由于训练序列的有限长度,可能会限制将大型语言模型应用于推理中的长输入序列。这项工作中认为现有的LLMs本身具有处理长上下文的固有能力。基于这一观点,作者建议通过LLMs自身扩展其上下文窗口,以充分利用这一固有能力。作者提出了SelfExtend来激发LLMs的长上下文处理潜力。其基本思想是构建双层注意力信息:组级别和邻居级别。这两个级别是通过原始模型的自注意机制计算的,这意味着所提出的方法不需要任何训练。通过仅进行四行代码修改,所提出的方法可以轻松地扩展现有LLMs的上下文窗口,而无需任何微调。文中进行了全面的实验证明,结果表明所提出的方法能够有效地扩展现有LLMs的上下文窗口长度。

文章链接:

https://arxiv.org/pdf/2401.01325.pdf

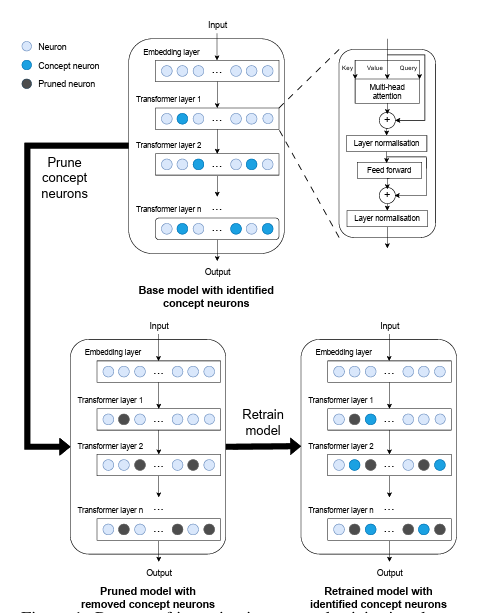

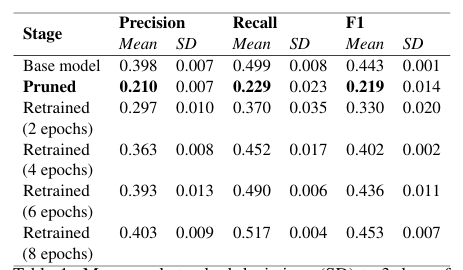

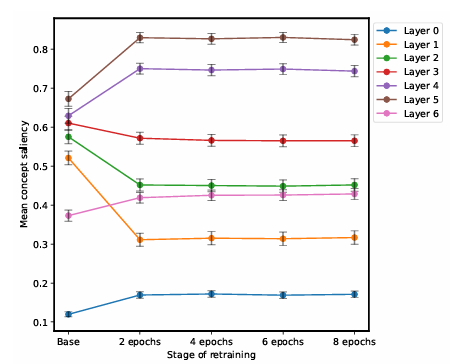

5. Large Language Models Relearn Removed Concepts

通过神经元修剪在模型编辑方面取得的进展为从大型语言模型中去除不良概念提供了希望。然而,目前尚不清楚在编辑后模型是否具有重新学习修剪概念的能力。为了调查这一问题,本文通过在重新训练期间跟踪修剪神经元中的概念显著性和相似性来评估模型中的概念重新学习。研究结果表明,模型可以通过将高级概念重新定位到较早的层,并将修剪的概念重新分配给具有相似语义的激活神经元,从而在修剪后迅速恢复性能。这表明模型具有多义性能力,可以在单个神经元中融合旧概念和新概念。虽然神经元修剪提供了对模型概念的解释能力,但文中的结果强调了永久去除概念以提高模型安全性的挑战。监控概念重新出现并开发技术以减轻重新学习不安全概念的影响将是更健壮的模型编辑的重要方向。总体而言,该工作充分展示了语言模型中概念表示的弹性和流动性。

文章链接:

https://arxiv.org/pdf/2401.01814.pdf

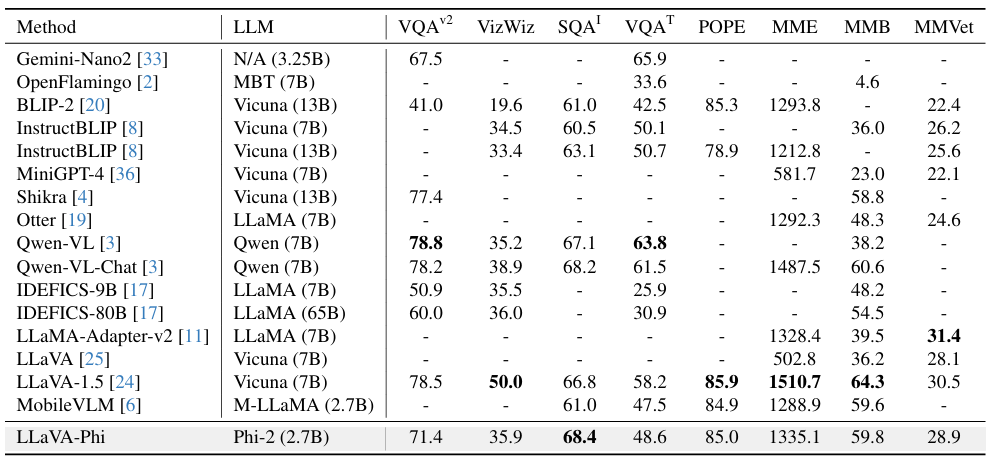

6. LLaVA-ϕ: Efficient Multi-Modal Assistant with Small Language Model

本文介绍了LLaVA-ϕ(LLaVA-Phi),这是一款高效的多模态助手,利用最近先进的小语言模型Phi-2的力量来促进多模态对话。LLaVA-Phi在紧凑的多模态模型领域取得了显著进展。它展示了即使是较小的语言模型,参数只有2.7B,也可以在复杂的对话中有效地融合文本和视觉元素,前提是它们受到高质量语料库的训练。该模型在包括视觉理解、推理和基于知识的感知在内的公开基准测试中表现出色。除了在多模态对话任务中表现出色外,本模型为在时间敏感的环境和需要实时交互的系统中的应用开辟了新的途径,比如具有实体代理的系统。它突显了较小语言模型在保持更大资源效率的同时实现高级理解和交互水平的潜力。

文章链接:

https://arxiv.org/pdf/2401.02330.pdf

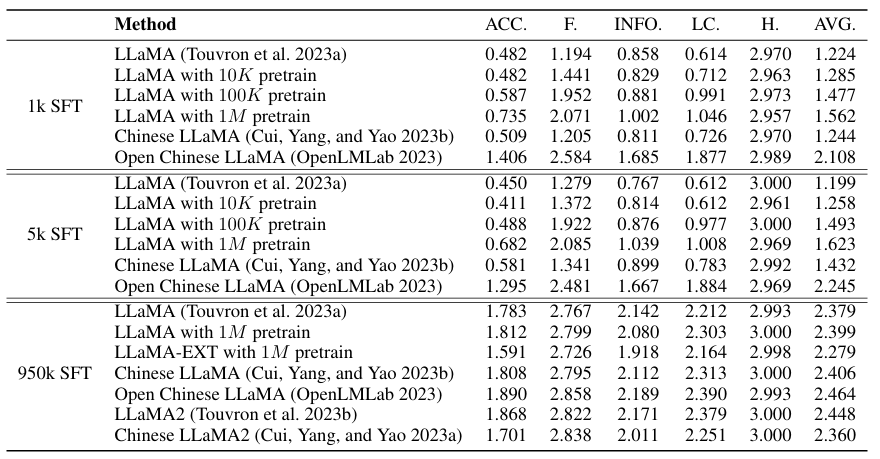

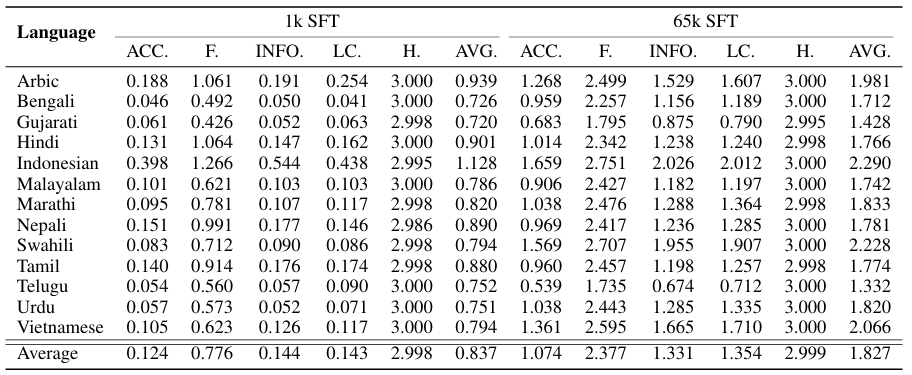

7. LLaMA Beyond English: An Empirical Study on Language Capability Transfer

近年来,大型语言模型(LLMs)取得了显著的进展,如ChatGPT,展示了在各种复杂任务上出色的熟练水平。然而,许多主流LLMs(例如LLaMA)是在以英语为主的语料库上进行预训练的,这限制了它们在其他非英语语言中的性能。本文关注如何有效地将语言生成和遵循指令的能力转移到非英语语言。为了回答这个问题,作者进行了基于LLaMA的广泛实证研究,累计使用了超过1440个GPU小时。文中分析了诸如词汇扩展、进一步的预训练和指令调整等关键因素对转移的影响。为了准确评估模型的知识水平,我们采用了四个广泛使用的标准化测试基准:C-Eval、MMLU、AGI-Eval和GAOKAO-Bench。此外,本文还进行了对模型响应质量的全面评估,考虑了准确性、流畅性、信息量、逻辑一致性和无害性等方面,基于LLM-Eval,这是一个包含17个不同类别指令任务的基准测试。评估结果表明,即使在预训练数据不到1%的情况下,也可以实现与最先进的转移模型相媲美的性能,无论是在知识对齐还是响应质量方面。此外,在十三种低资源语言上的实验结果也呈现出类似的趋势。

文章链接:

https://arxiv.org/pdf/2401.01055.pdf

往期精彩文章推荐

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了1700多位海内外讲者,举办了逾600场活动,超700万人次观看。

我知道你

在看

哦

~

点击 阅读原文 查看更多!