- 1Java中HashMap遍历的七种方法_java map遍历赋值

- 2Linux:ll命令详解_linux ll

- 3深度强化学习实验室(http://www.deeprlhub.com)_深度强化学习 实验室

- 4纯血鸿蒙APP实战开发——列表编辑实现

- 5代码随想录算法练习Day15:快乐数

- 6叮,您有一份ML.NET 速查手册请查收!

- 716:00面试,16:06就出来了,问的问题过于变态了。。。

- 8C++笔试强训day10

- 9SQL 横转竖 、竖专横 (转载) 使用Dapper.Contrib 开发.net core程序,兼容多种数据库 C# 读取PDF多级书签 Json.net日期格式化设置 ASPNET 下载共...

- 10k8s1.20使用动态供给storageclass问题_valid argument "removeselflink=false" for "--featu

Linux安装hadoop

赞

踩

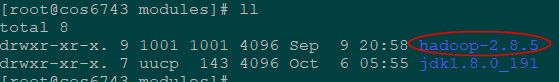

前提:下载hadoop2.8.5

wget下载hadoop,或如果是虚拟机,也可以使用sftp从windows上传hadoop文件

wget -P /home/cent/Downloads https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-2.8.5/hadoop-2.8.5.tar.gz

sftp从windows上传hadoop文件【传输文件sftp命令】

1、解压hadoop

可以先复制到安装目录modules,也可以在解压tar命令中指定路径

cp /home/cent/Downloads/hadoop-2.8.5.tar.gz /opt/modules/

解压到当前目录

tar -zxvf hadoop-2.8.5.tar.gz

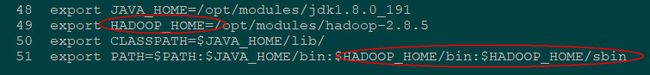

2、配置环境变量

在 /etc/profile 文件中加入以下内容:

export HADOOP_HOME=/opt/modules/hadoop-2.8.5

export PATH= P A T H : PATH: PATH:HADOOP_HOME/bin:$HADOOP_HOME/sbin

输入source命令,使更改马上生效:source profile

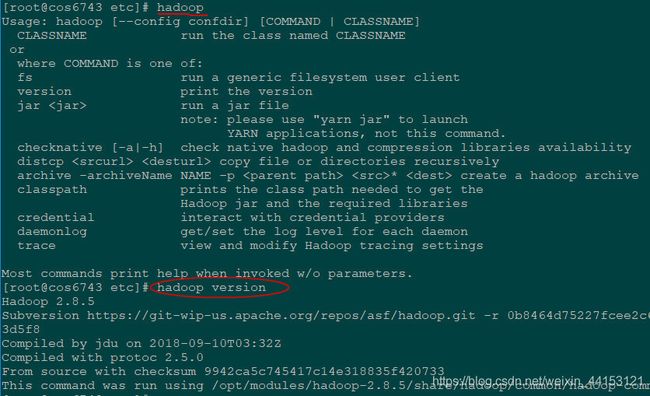

hadoop或hadoop version查看安装是否成功

3、伪分布式hadoop

Hadoop部署模式:单机模式、伪分布式、完全分布式模式、HA完全分布式模式。

本次使用伪分布式需要调整路径【/etc/hadoop/】下的配置文件:

hadoop-env.sh 配置JAVA_HOME

core-site.xml 配置HDFS节点名称和地址

hdfs-site.xml 配置HDFS复制数量

mapred-site.xml 配置mapreduce.framework

3.1 hadoop-env.sh

屏蔽:export JAVA_HOME=${JAVA_HOME}

新增jdk路径:export JAVA_HOME=/opt/modules/jdk1.8.0_191

3.2 core-site.xml

fs.defaultFS

hdfs://cos6743:9000

hadoop.tmp.dir

/opt/modules/hadoop-2.8.5/tmp

fs.defaultFS参数配置的是HDFS的地址,cos6743即hostname,当然也可以用IP地址。

hadoop.tmp.dir指定hadoop运行时产生文件的存储路径。

3.3 hdfs-site.xml

dfs.replication

1

dfs.replication参数设置hdfs副本数量。

3.4 mapred-site.xml

-

cp mapred-site.xml.template mapred-site.xml

-

vi mapred-site.xml

mapreduce.framework.name

yarn

该参数通知框架MR使用YARN

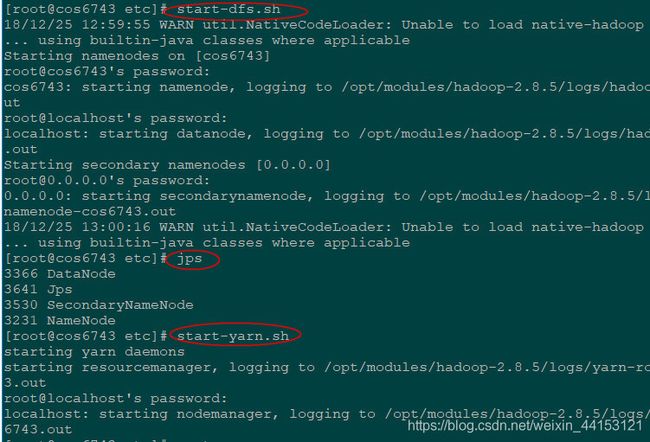

4、启动hadoop

4.1格式化

hadoop namenode -format

仅第一次使用时要格式化,以后不再需要格式化。

格式化是对HDFS分布式文件系统中的DataNode进行分块,统计所有分块后的初始元数据的存储在NameNode中。

4.2启动start-dfs

start-dfs.sh

4.3启动start-yarn

start-yarn.sh

4.4查看启动结果jps

访问HDFS的管理界面 http://ip:50070/

访问MapReduce管理界面:http://ip:8088/cluster

![【Linux】服务器时区 [ CST | UTC | GMT | RTC ]_linux上服务器时区](https://img-blog.csdnimg.cn/img_convert/7ca7738362d74dc0867c0c0ec139a490.png?x-oss-process=image/resize,m_fixed,h_300,image/format,png)