- 1myCobot pro 机械臂(6)逆向运动学_机械臂逆运动学

- 2Flink CDC 整库 / 多表同步至 Kafka 方案(附源码)_cdckafka

- 3Your branch and 'origin/master' have diverged, and have # and # different commits each, respectively

- 4python实现Android实时投屏操控_scrcpy投屏python

- 5职场生存法则和处世之道_职场处事之道

- 6《从零开始学python+自然语言处理100题》——给自己的记录_自然语言处理100练

- 7【深度学习图像识别课程】keras实现CNN系列:(7)迁移学习的原理和应用_机器学习、迁移学习和cnn

- 8windows版redis_redis windows

- 9分布式学习-总结

- 10图像分割实战-系列教程2:Unet系列算法(Unet、Unet++、Unet+++、网络架构、损失计算方法)

【Hadoop】-HDFS的Shell操作[3]

赞

踩

目录

前言

Hadoop Distributed File System (HDFS) 是一个分布式文件系统,用于存储和处理大规模数据集。HDFS具有高可扩展性、高容错性和高吞吐量的特点,是Apache Hadoop框架的核心组件之一。

HDFS提供了一个命令行界面(Shell),用于管理和操作文件系统中的文件和目录。使用HDFS的Shell,用户可以执行各种文件系统操作,如创建目录、上传文件、下载文件、删除文件等。

HDFS的Shell操作类似于Linux的命令行操作,用户可以使用一系列命令来完成各种操作。Shell命令包括一些基本的文件系统操作命令,如ls(列出文件和目录)、mkdir(创建目录)、put(上传文件)、get(下载文件)、rm(删除文件)等。此外,HDFS的Shell还提供了一些其他有用的命令,如chown(修改文件所有者)、chgrp(修改文件所属组)、chmod(修改文件权限)等。

用户可以通过在终端中输入hdfs命令来启动HDFS的Shell。在Shell中,用户可以使用上述命令来管理和操作HDFS文件系统中的文件和目录。通过简单的命令,用户可以轻松地完成HDFS文件系统的常见操作。

HDFS的Shell操作简单方便,适用于对文件进行基本的管理和操作。对于更复杂的操作,如数据分析和处理,用户通常会使用其他工具,如Hadoop MapReduce或Spark等。但对于一些简单的文件系统操作,HDFS的Shell是十分有用的。

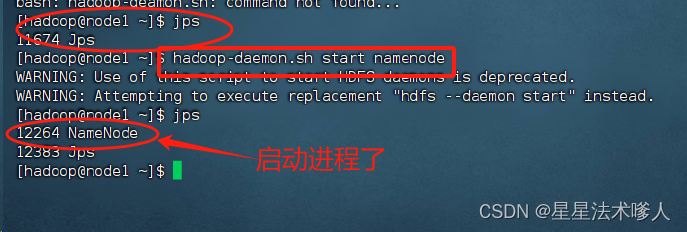

一、HDFS集群启停命令

1.一键启停脚本可用

- $HADOOP_HOME/sbin/strat-dfs.sh

- $HADOOP_HOME/sbin/stop.sh

由于在前置设置中已经配置好了环境,所以只需要执行红色代码即可。

2.独立进程启停可用

- $HADOOP_HOME/sbin/hadoop-deamon.sh

- $HADOOP_HOME/sbin/hdfs --daemon

二、文件系统操作命令

关于HDFS文件系统的操作命令,Hadoop提供了2套命令体系

- hadoop命令(老版本用法),用法:hadoop fs [generic options]

- hdfs命令(新版本用法),用法:hdfs dfs [generic options]

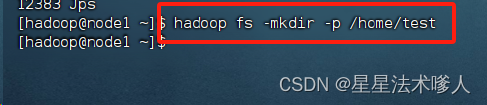

1、创建文件夹

- hadoop fs -mkdir [-p] <path> .......

- hdfs dfs -mkdir [-p] <path>......

path为待创建的目录

-p选项的行为与Linux mkdir -p一致,它会沿着路径创建父目录

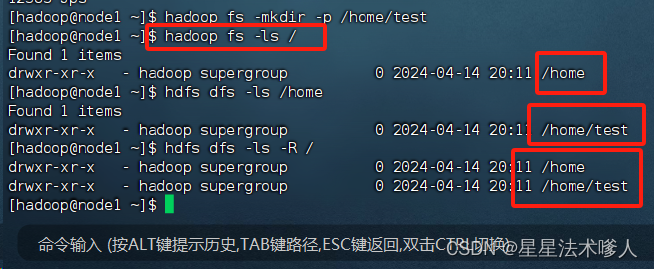

2、查看指定目录下内容

- hadoop fs -ls [-h] [-R] <path> .......

- hdfs dfs -ls [-h] [-R] <path>......

-h人性化显示文件size

-R递归查看指定目录及其子目录

可以查看到我们之前所创建的文件夹。

3、上传文件到HDFS指定目录下

- hadoop fs -put [-f] [-p] <localsrc> ....... <dst>

- hdfs dfs -put [-f] [-p] <localsrc> ....... <dst>

-f 覆盖目标文件(已存在下)

-p 保留访问和修改时间,所有权和权限

localsrc 本地文件系统(客户端所在机器)

dst 目标文件系统(HDFS)

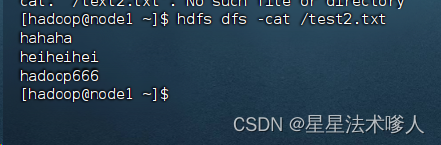

4、查看HDFS文件内容

读取指定文件全部内容,显示在标准输出控制台。

- hadoop fs -cat <src> .......

- hdfs dfs -cat <src> .......

读取大文件可以使用管道符配合more

- hadoop fs -cat <src> | more

- hdfs dfs -cat <src> | more

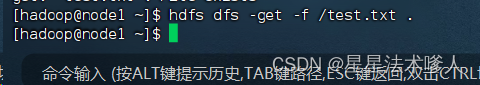

5、下载HDFS文件

下载文件到本地文件系统指定目录,localdst必须是目录

- hadoop fs -get [-f] [-p] <src> ....... <localdst>

- hdfs dfs -get [-f] [-p] <src> ....... <localdst>

-f 覆盖目标文件(已存在下)

-p 保留访问和修改时间,所有权和权限

6、拷贝HDFS文件

- hadoop fs -cp [-f] <src> ....... <dst>

- hdfs dfs -cp [-f] <src> ....... <dst>

将文件test.txt复制到/home目录下。

7、追加数据到HDFS文件中

- hadoop fs -appendToFile <localsrc> ....... <dst>

- hdfs dfs -appendToFile <localsrc> ....... <dst>

将所有给定本地文件的内容追加到给定dst文件。

dst如果文件不存在,将创建该文件。

如果<localSrc>为-,则输入为从标准输入中读取。

8、HDFS数据移动操作

- hadoop fs -mv <src> ....... <dst>

- hdfs dfs -mv <src> ....... <dst>

移动文件到指定文件夹下

可以使用该命令移动数据,重命名文件的名称。

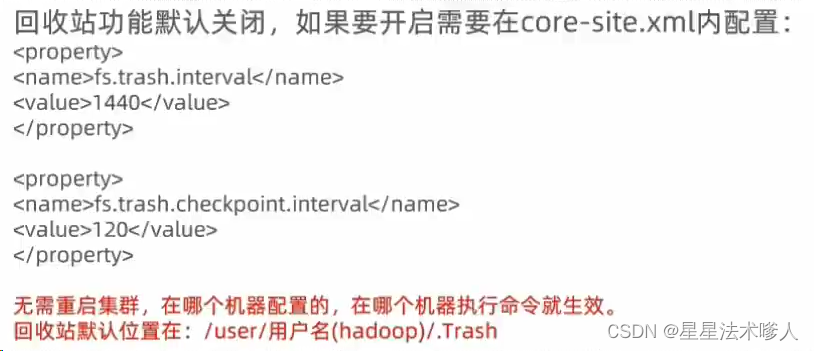

9、HDFS数据删除

- hadoop fs -rm -r [-skipTrash] URI [URI ......]

- hdfs dfs -rm -r [-skipTrash] URI [URI ......]

删除指定路径的文件或文件夹

-skipTrash 跳过回收站,直接删除。

- <property>

- <name>fs.trash.interval</name>

- <value>1440</value>

- </property>

- <property>

- <name>fs.trash.checkpoint.interval</name>

- <value>120</value>

- </property>

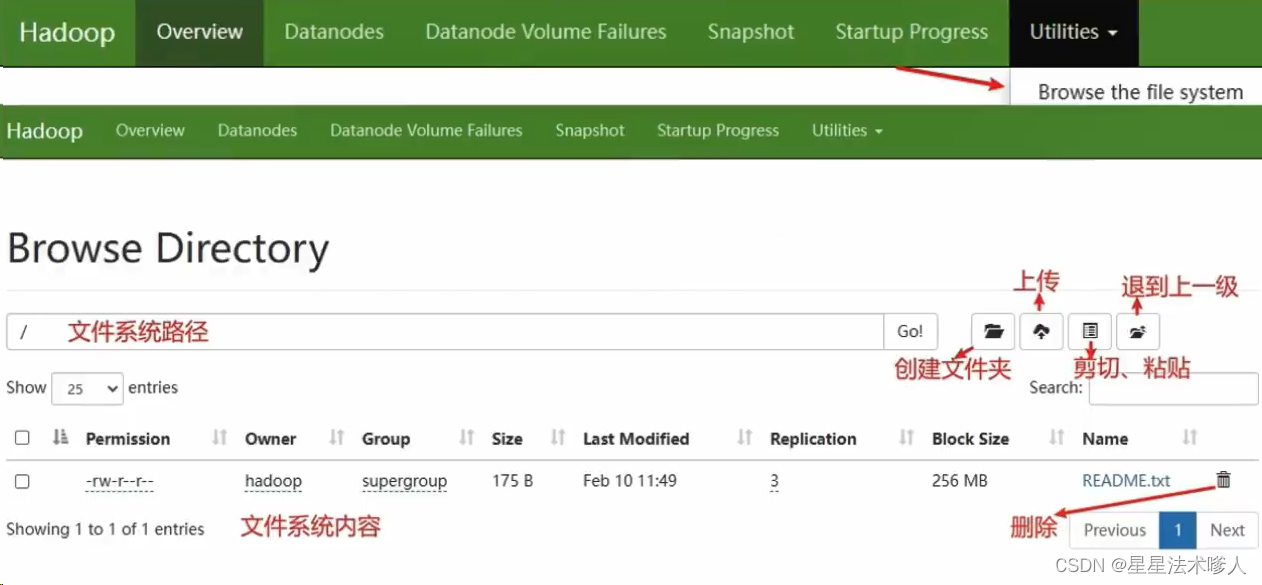

! HDFS WEB浏览

除了使用命令操作HDFS文件系统外,在HDFS的WEB UI 上也可以查看到HDFS系统的内容。

http://node1:9870

使用WEB浏览操作文件系统,一般会遇到权限问题

这是因为WEB浏览器中是以用户(dr,who)登录的,其只有只读权限,多数操作是做不了的。如果需要以特权用户在浏览器中进行操作,需要配置core-site.xml并重启集群,但是,不推荐这样做。

补充:修改权限

在HDFS中,可以使用和Linux一样的授权语句,即chown和chmod

- 修改所属用户和组:

root:用户 supergroup:组

hadoop fs -chown [-R] root:supergroup /xxx.txt

hdfs dfs -chown [-R] root:root /xxx.txt

- 修改权限:

hadoop fs -chown [-R] 777 /xxx.txt

hdfs dfs -chown [-R] 777 /xxx.txt

三、HDFS客户端 - jetbrians产品插件

1.Big Data Tools插件

在jetbrains的产品中,均可以安装插件,其中:Big Data Tools插件可以帮助我们方便的操作HDFS,比如:

- Intellij IDEA(java IDE)

- pyCharm(Python IDE)

- DataGrip(SQL IDE)

均可以支持Bigdata Tools插件

设置-> plugins(插件)-> Marketplace(市场),搜索Big Data Tools

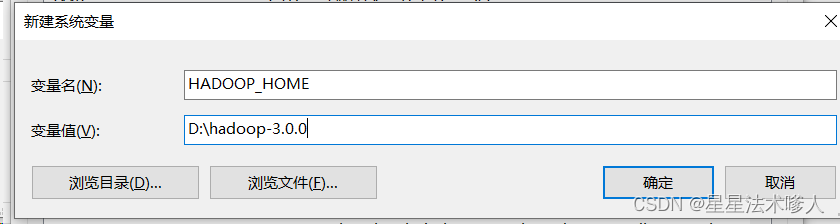

2、配置Windows

需要对Windows系统做一些基础设置,配合插件使用

- 解压Hadoop安装包到Windows系统,如解压到:D:\hadoop-3.0.0

- 设置$HADOOP-HOME环境变量指向:D:\hadoop-3.0.0

- 下载

- hadoop.dll(https://github.com/steveloughran/winutils/blob/master/hadoop-3.0.0/bin/hadoop.dll)

- winutils.exe(https://github.com/steveloughran/winutils/blob/master/hadoop-3.0.0/bin/winutils.exe)

- 将hadoop.dll和winutils.exe放入$HADOOP_HOME/bin中

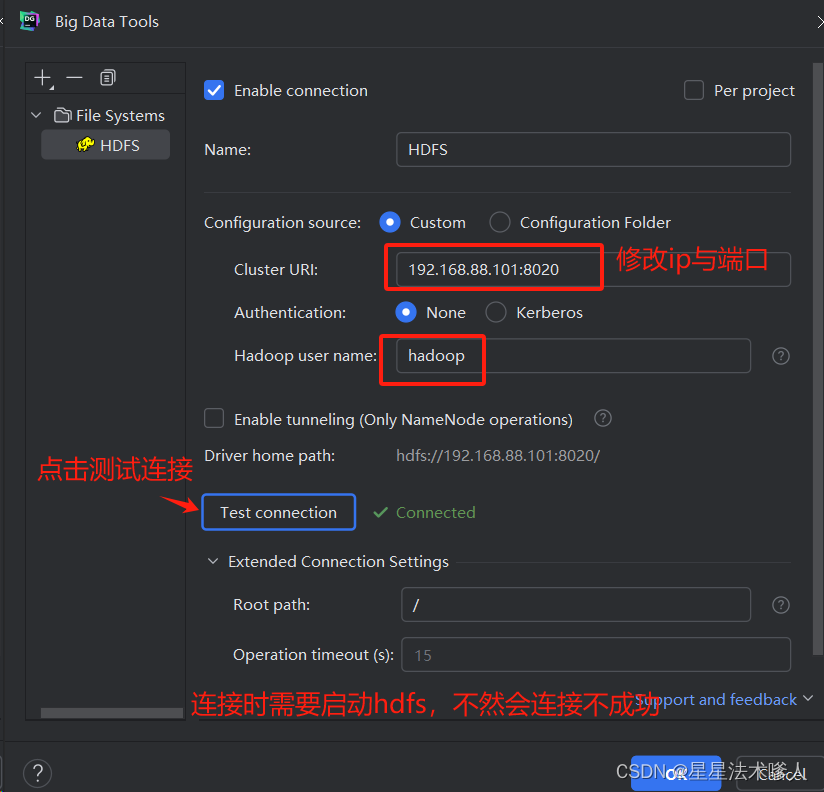

3、配置Big Data Tools插件

打开插件

点击

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。