- 1以http为协议头开头的url_htt开头的

- 2数据挖掘(机器学习)面试--SVM面试常考问题_数据挖掘面试常规问题

- 3网易技术面试,Android UI-开源框架ImageLoader的完美例子,程序员面试防坑宝典

- 4【vivado】ILA调试报错 The debug hub core was not detected 以及 Data read from hw_ila [hw_ila_1] is corrupted_warning: [labtools 27-3361] the debug hub core was

- 5Base64编码解码_base解码

- 6专业课课本复习(数电,通原,数信,信号与系统,数据结构)_表征cpld容量的关键指标是查找表的数量吗

- 7Anaconda Navigator无法打开的问题(已解决)_anaconda navigator打不开

- 8python 车牌识别训练模型_python cnn tensorflow 车牌识别 网络模型

- 9【Python】ffmpeg模块处理视频、音频信息_audio video ffmpeg-python 分离

- 10数据建模五大步(以KNeighborsClassifier算法为主)_joblib加载模型kneighborsclassfier

重大更新!Stable Diffusion WebUI 1.8.0来了!!!_stable duffision webui最新镜像

赞

踩

最近 Stable Diffusion WebUI 发布了 1.8.0 版本,更新内容比较多,据说显存使用有了大幅的下降,这几天我也找时间把 AutoDL 镜像的版本做了个升级,有兴趣的同学可以去体验下新版本了。

这里分享下其中几个我认为比较重要的更新。

1、处理性能优化

Torch版本支持到了2.1.2,Torch 的版本越高一般意味着更优的处理效率,搭配的CUDA需要是11.8或者12.1。

支持FP8精度的计算,FP8使用8位浮点数进行运算,会节省不少显存,官方称图片质量没有明显下降,只是推理速度可能会稍微慢一点,使用FP8时,Pytorch版本需要>=2.1.0。建议显存小于8G的用户开启。

喜欢尝鲜的同学可以先试试,不过也需要硬件、操作系统和相关库的适配,可能会遇到一些小问题。

Torch 是一个老牌开源机器学习库,其底层实现基于 C/C++。Torch 提供了强大的张量计算功能以及一套完整的深度学习框架,支持高效的 GPU 加速计算和自动求导机制。

PyTorch 可以看作是 Torch 的一个分支或者后继者,保留了 Torch 的一些核心理念和技术优势,同时通过采用 Python 这一流行的数据科学和机器学习领域的编程语言,极大地提高了用户友好度和生态系统的兼容性。目前一般所说的“Torch版本”可以理解为PyTorch项目的版本号。

CUDA是由 NVIDIA 公司推出的一种并行计算平台和编程模型,它使得开发者能够利用 NVIDIA 的 GPU 进行大规模并行计算,从而极大地加速数据密集型任务,尤其是在处理深度学习中大量浮点运算时的优势尤为明显。

PyTorch 依赖 CUDA ,不同版本的 PyTorch 需要特定版本的 CUDA。

2、内置LCM采样器

Stable Diffusion WebUI 1.8.0中内置了LCM采样器,不需要再单独安装。

LCM 全称 Latent Consistency Models(潜在一致性模型),是清华大学交叉信息科学研究院研发的一款生成模型。它的特点是可以通过少量步骤推理合成高分辨率图像,使图像生成速度提升 2-5 倍,需要的算力也更少。LCMs 是继 LDMs(Latent Diffusion Models 潜在扩散模型)之后的新一代生成模型。

Consistentcy Models 对去噪推理这一步进行了优化,它不再需要像 Diffusion 模型那样逐步迭代,而是追求“一步完成推理”,这样需要处理的步数减少了,图像的生成速度自然就提升了。LCM 则是在 Consistency Models 的基础上引入了 Lantent Space (潜空间),进一步压缩需要处理的数据量,从而实现超快速的图像推理合成。LCM 官方以此训练了一个新的模型 Dreamshaper-V7,仅通过 2-4 步就能生成一张 768*768 分辨率的清晰图像。

实际测试,对于大多数LCM模型,4步可以得到清晰图像,6-10步图片质量就不错了,宽高512*512在3090显卡上可以做到秒级出图。

使用的LCM模型见文末。

3、支持SDXL-Inpaint模型

以往在使用SDXL通用模型进行图像修复时,用户经常会遇到修复效果不尽如人意的情况。现在,diffusers发布了专注于图片修复功能的SDXL-Inpaint模型,该模型特别强化了对局部区域进行精确重绘的能力。

SDXL-Inpaint模型文件见文末。

4、柔和重绘

在1.8.0版本中,图生图模块迎来了一项极为实用的新特性——柔和重绘模式。此前,在缺乏这一功能时,对图像进行局部重绘的操作往往会导致生成图片存在较为显著的瑕疵问题,尤其是可见的接缝痕迹十分明显。而随着1.8版本新功能的引入,局部图像的重绘处理得到了显著改善,能够更加平滑地融合原图与生成部分,从而极大减少瑕疵并消除明显的拼接感,使得最终效果更为自然和理想。

比如这里把一只可爱的小猫重绘为一只呆萌的小狗:

在“图生图”界面可以打开这个设置:

5、其它

高清化:支持了3个DAT放大模型:DAT X2;DAT X3;DAT X4,从放大生成速度上来讲,DAT X4最快,X3中等,X2最快。从放大质量上来讲,DAT X2是最好的。一般显卡大于8G的就用 DAT X2。

支持提示词支持提示词注释:

支持昇腾 NPU 芯片出图。

本地而非Google服务器提供字体服务。

当然还有很多其它的更新,包括修复了很多BUG,扩展了很多API,有兴趣的可以去官方页面看看。

6、使用1.8.0

一种方式就是从Github下载最新版本的代码,覆盖到本地目录,重启后即可使用最新版本。不过可能会遇到一些插件或者包版本冲突方面的问题,需要自己解决,也可向我咨询。

另一种方式是直接使用我封装的AutoDL镜像,经测试各项功能正常,可以直接体验。

创建实例时选择“社区镜像”,输入“yinghuo”,选择 webui 镜像的最新版本。

7、资源分享

文章中使用的SD模型、Lora模型、SD插件、示例图片等,都已经上传到我整理的 Stable Diffusion 绘画资源中,添加下方即可获取。

另外我整理了自己输出的关于 Stable Diffusion 的所有教程,包括基础篇、ControlNet、插件、实战、模型训练等多个方面,比较全面、体系化,特别适合新手和想要系统化学习Stable Diffusion的同学。

1.stable diffusion安装包

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

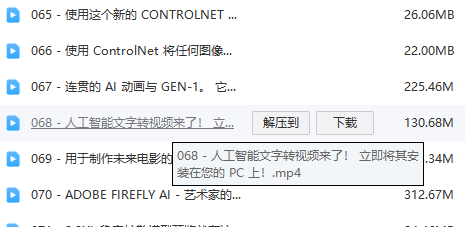

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.SD从0到落地实战演练

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名SD大神的正确特征了。

这份完整版的stable diffusion资料我已经打包好,需要的点击下方添加,即可前往免费领取!