- 1Unity 谷歌登录 Android + iOS_unity 谷歌授权登录

- 2Python3 使用UIautomator2移动端自动化_手机自动化执行工具ui automator

- 3用python文本挖掘分析_文本挖掘和文本分析的九大应用场景

- 4libusb系列-002-Windows下libusb源码编译_windows libusb

- 5【依葫芦画瓢】SSM-CRUD --- 3_依葫芦画瓢化前端

- 6学位论文、中文期刊中参考文献著录格式【依据国家标准 GB/T 7714-2015】_gbt77142015 参考标准模板

- 7【Neo4j】Python操作Neo4j_neo4j python操作

- 8LDA(Latent Dirichlet Allocation)的原理和代码实现_lda(latent dirichlet allocation)算法

- 9Ubuntu 16.04 LTS上用IDEA编程操作hive报错:Table or view not found_setting hive.metastore.warehouse.dir ('null') to t

- 10进来教你无人机蜂群作战以及…反无人机蜂群作战

计算机视觉的应用28-基于OpenPose算法的实际应用,实例代码实现OpenPose算法的原理_openpose的应用

赞

踩

大家好,我是微学AI,今天给大家介绍一下计算机视觉的应用28-基于OpenPose算法的实际应用,OpenPose算法的原理与结构。OpenPose是一种先进的实时人体关键点检测和全身姿态估计的深度学习框架,由 Carnegie Mellon University 和 Adobe Research 开发。其主要原理是通过深度卷积神经网络(CNN)和条件随机场(CRF)相结合的方式,对图像或视频中的多个人体进行全身姿态估计和关键点检测。OpenPose的核心在于它能够同时识别并定位25个身体关节,包括面部、手部、脚部以及身体的主要部位,这对于动作捕捉、人体跟踪、游戏交互、医学影像分析等领域具有重要意义。

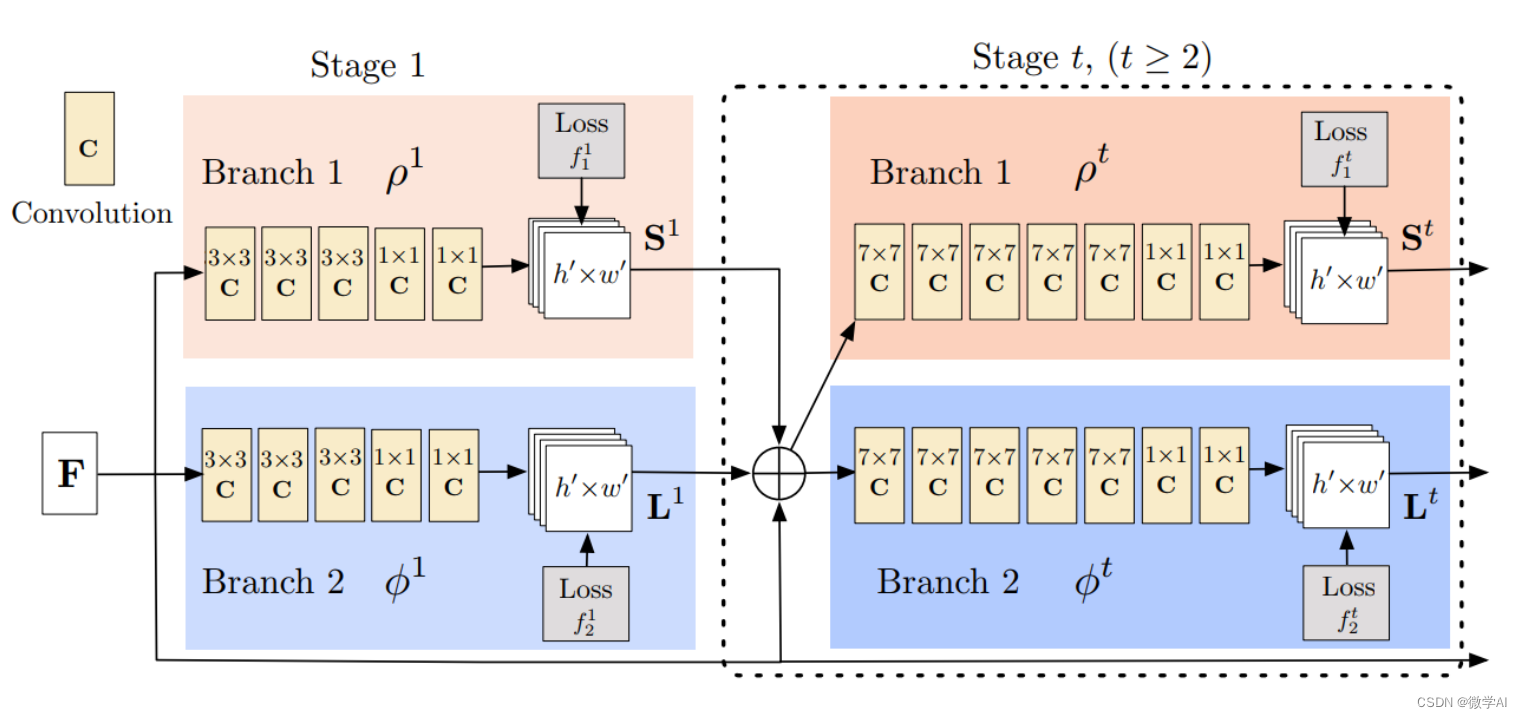

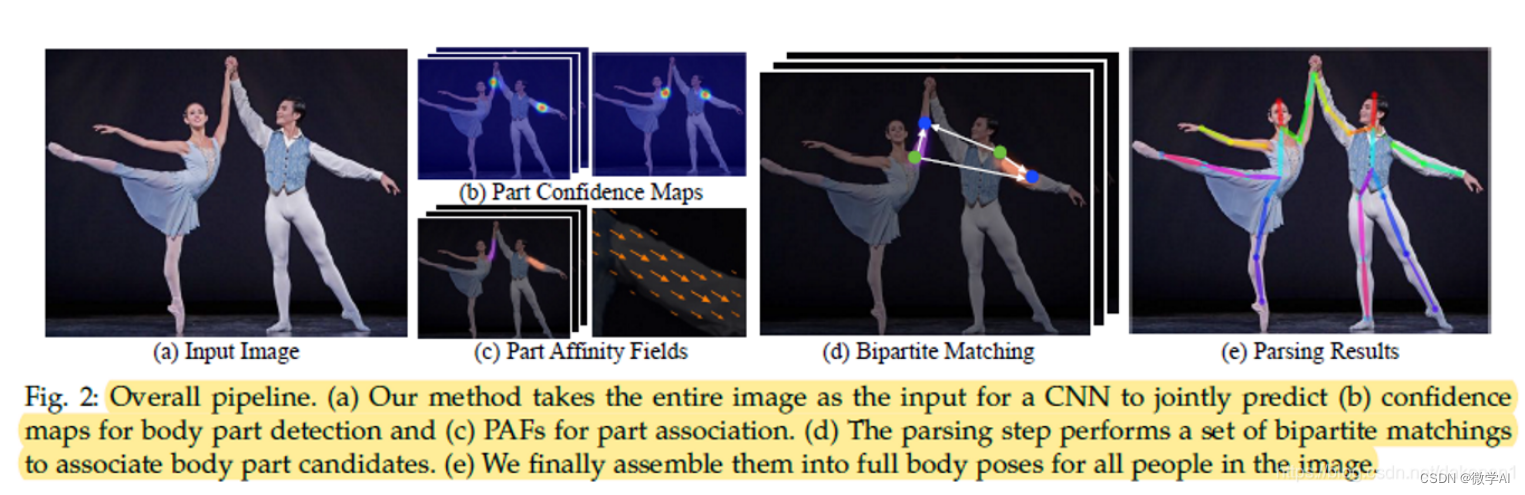

OpenPose的结构分为两个主要部分:一是多尺度金字塔网络(Multi-Person Pose Estimation Network),用于检测人体轮廓和关键点;二是人体部件解码器(Part Affinity Fields),用于确定每个关键点与其周围其他关键点的关系。网络采用级联结构,先进行粗略的人体检测,再逐步细化到关键点定位,提高了效率和准确性。

一、OpenPose算法简介

1.1 算法概述

OpenPose是一种先进的多任务人体关键点检测算法,它不仅能够精确地识别和定位2D和3D的人体关节,还包括面部表情、手部姿态等丰富信息。OpenPose采用了深度学习与可分图模型的融合方法,通过将人体看作一个由多个部分组成的图结构,每个部分代表一个关节或特征点,利用卷积神经网络(CNN)对输入图像进行特征提取,再通过图优化技术预测各个部分的位置。其主要优势在于对复杂动作和大规模人群的处理能力,以及实时性,使得在体育分析、游戏交互、虚拟现实等领域有着广泛应用。

假设我们正在开发一款健身应用。用户上传他们的运动视频,OpenPose算法会在后台运行,实时检测并标记出用户的关节位置,如肩、肘、腕、髋、膝、踝等,同时还能识别出手臂和腿部的动作。这对于量化运动表现,比如跑步的步频、划船的动作准确性,或者瑜伽的体式完成度都非常有帮助。此外,OpenPose还可以捕捉面部表情,为用户提供个性化的反馈,比如鼓励他们在做高强度运动时保持微笑,以此提高运动体验和效果。这就是OpenPose算法在实际项目中的强大功能和价值体现。

1.2 原理与架构

OpenPose是由 Carnegie Mellon University 和 UC Berkeley 的研究团队开发。其核心原理基于深度学习,特别是Convolutional Neural Networks (CNN) 和 Graph Convolutional Networks (GCN),通过多层次的特征提取和人体结构解析来定位和识别25个身体关节和部分关键点。

OpenPose的架构分为两个主要部分:图像流和图形优化。首先,图像流模块利用预训练的卷积神经网络对输入图像进行多尺度分析,生成一系列特征图。这些特征图捕捉了不同尺度和位置的人体特征。接着,这些特征图通过Heatmap Regression和Part Affinity Fields(PAF)两种方式来预测关键点的位置。Heatmap Regression用于直接预测每个关节对应的热力图,而PAF则通过连接相邻关节的概率来描绘关节之间的关系,形成人体的姿态图。

在图形优化阶段,通过非极大抑制(NMS)和边裁剪等技术,从预测的热力图中筛选出最可能的关节,并使用Dijkstra算法构建出人体的姿态树。这样,OpenPose不仅能提供精确的关节位置,还能输出全身的姿态信息。

二、实际应用场景

2.1 视频监控与行为分析

视频监控与行为分析在实际应用场景中发挥着至关重要的作用。它是一种高级的视频处理技术,通过深度学习和计算机视觉算法,对监控画面中的人员、车辆、物体等进行实时识别、追踪和行为分析。例如,在商场中,系统可以自动识别出异常行为,如人群拥挤、滞留时间过长或独自徘徊的可疑人员,从而及时预警潜在的安全风险。在停车场,它可以追踪车辆进出,防止盗窃,并帮助找回丢失的车辆。在智能家居中,行为分析可以识别人体动作,实现智能控制,如开关灯光、调整空调温度。此外,它也被广泛应用于交通管理,通过分析交通流量、违规行为,优化道路安全和交通流线。总的来说,视频监控与行为分析技术极大地提升了公共安全和生活便利性。

2.2 体育运动分析

在实际应用场景中,体育运动分析是一种强大的数据驱动工具,它通过收集和分析运动员的训练数据、比赛表现以及生理指标等,帮助教练员和运动员优化训练策略,提升竞技水平。例如,在田径比赛中,可以通过GPS追踪系统记录运动员的速度、距离和心率,实时监测其体能状况。视频分析技术则可以详细拆解运动员的技术动作,指出改进点。此外,运动生物力学分析可以帮助预防运动伤害,通过对运动员动作的动态分析,发现潜在的不平衡或过度使用风险。

在双人舞运动中,教练和舞者可以利用OpenPose算法来分析和改进舞者的动作和姿态。OpenPose是一种实时多人关键点检测算法,能够识别图像中人物的骨架和关键点位置。通过OpenPose算法,舞者可以在训练过程中跟踪自己的动作,如手臂和腿部的运动轨迹、身体平衡、以及两人之间的相对位置和互动。这有助于舞者理解自己的舞蹈动作,并对其进行微调,以达到更好的艺术效果和技巧水平。教练可以使用这些数据来分析舞者在舞蹈中的协调性、节奏感和表现力,进而给出更具针对性的指导和建议。例如,如果发现某个舞者在特定动作中身体平衡不够稳定,教练可以针对性地进行训练,以改善其平衡能力。

2.3 游戏开发与虚拟现实

在现代游戏开发中,虚拟现实(VR)技术的应用日益广泛。它将玩家完全沉浸在游戏世界中,提供了一种前所未有的沉浸式体验。例如,开发团队可以利用VR技术创建《半条命:艾利克斯》这类的第一人称射击游戏,玩家戴上VR头盔,仿佛置身于战火纷飞的太空站,亲手操作武器,感受子弹呼啸而过和爆炸的震撼。此外,VR还能用于构建互动性强的冒险游戏,如《Beat Saber》中的音乐节奏游戏,玩家需挥舞光剑击打飞来的方块,身体动作直接影响游戏进程,真实感爆棚。

在教育领域,VR也被用于历史重现或科学探索。比如,《Google Earth VR》让学生仿佛亲临古罗马斗兽场,直观理解历史遗迹。在医学培训中,VR模拟手术环境,让医学生在虚拟现实中进行实践操作,提高技能水平。VR技术不仅丰富了游戏的玩法和体验,还在教育、训练等多个领域展现了其巨大的潜力。

三、深入理解与实现

3.1 模型训练与优化

在深度学习中,模型训练与优化是核心环节。首先,我们需要定义一个预测模型,如卷积神经网络(CNN)或循环神经网络(RNN),用于处理特定任务,如图像分类或自然语言处理。模型的参数会随机初始化,然后通过大量的数据输入进行训练,这个过程就是反向传播算法的应用,它根据预测结果与真实标签之间的误差调整参数,以最小化损失函数。

优化器,如Adam、SGD等,负责调整参数更新的速度和方向,使模型的学习过程更加高效。我们会设置一个学习率,控制每次参数更新的幅度,同时使用梯度下降策略,沿着梯度的反方向更新,以达到最优解。

在一个图像识别项目中,我们可能使用ResNet或VGG这样的预训练模型,首先在大规模图像数据集上进行训练。然后,我们将模型冻结一部分层,只对新增的或特定层进行微调,以适应我们的特定任务。在训练过程中,我们会监控验证集的表现,通过调整学习率、优化器参数等方式,不断优化模型,直到达到最佳性能。这整个过程就是模型训练与优化的实践应用。

3.2 实战案例与代码解读

在深入理解与实现的章节3.2中,我们通过实战案例和代码解读的方式,将理论知识转化为实际操作。比如,我们会探讨如何使用Python的Scrapy框架来爬取和解析网页数据。通过一个具体的案例,如新闻网站的标题抓取,首先,我们会学习如何设置请求头,模拟浏览器行为,避免被网站封禁。接着,解析BeautifulSoup库解析HTML,提取出所需信息,如新闻标题。代码逐行解释,让你理解每个步骤的作用,如XPath选择器的选择,以及如何存储和处理抓取的数据。

这个过程不仅锻炼了编程技能,也让你理解了网络爬虫在实际项目中的应用场景,如数据挖掘、舆情分析等。通过这样的实战,你不仅能掌握基础的爬虫技术,还能提升问题解决和项目实施的能力。例如,如果要做一个实时新闻跟踪系统,你需要定期抓取并分析各大新闻网站的内容,这就需要运用到所学的爬虫技术和数据处理技术。

四、.OpenPose算法模型的数学原理

OpenPose是一种多任务人体关键点检测和全身姿态估计的深度学习框架,其主要目标是同时定位人体的2D和3D关键点,并且识别出多个可互换的人体部分。以下是OpenPose算法的一些核心数学原理的简要描述:

-

人体关键点检测:

OpenPose通过卷积神经网络(Convolutional Neural Networks, CNN)来处理图像数据。假设输入图像为 ( I ),输出为一组关键点 ( \mathbf{P} = {p_1, p_2, …, p_n} ),其中 ( n ) 是关键点的数量,( p_i = (x_i, y_i) ) 表示第 ( i ) 个关键点的像素坐标。CNN的输出可以表示为:

P = f ( I ; θ ) \mathbf{P} = f(I; \theta) P=f(I;θ)

其中 ( f(\cdot) ) 是CNN的函数,( \theta ) 是网络的参数。 -

人体姿态估计:

为了估计3D姿态,OpenPose通常结合了回归和分类的方法。首先,使用深度学习网络预测每个关键点的深度 ( d_i ),然后通过相机参数(如焦距、光心等)计算3D坐标 ( \mathbf{Q}i ):

Q i = K ⋅ [ d i , p i x , p i y ] T \mathbf{Q}_i = K \cdot [d_i, p_{ix}, p_{iy}]^T Qi=K⋅[di,pix,piy]T

其中 ( K ) 是相机内参矩阵,( p{ix} ) 和 ( p_{iy} ) 分别是关键点在图像上的横纵坐标。 -

人体部件分割:

OpenPose还能够识别并分割出人体的不同部分,如手、脚、脸部等。这部分通常使用条件随机场(Conditional Random Field, CRF)进行后处理,以优化关键点之间的关联性。CRF的潜在变量 ( Z ) 可以表示为:

Z = arg max C P ( C ∣ I ) Z = \arg\max_{\mathbf{C}} P(\mathbf{C}|I) Z=argCmaxP(C∣I)

其中 ( \mathbf{C} ) 是人体部件的标签,( P(\cdot) ) 是给定图像 ( I ) 的条件概率。 -

损失函数:

训练过程中,OpenPose通常采用多任务损失函数,包括关键点检测损失 ( L_{kp} )、身体部件分割损失 ( L_{seg} ) 和3D姿态损失 ( L_{3D} ) 等:

L = L k p + L s e g + L 3 D L = L_{kp} + L_{seg} + L_{3D} L=Lkp+Lseg+L3D

请注意,这只是一个简化版的描述,实际的OpenPose算法更为复杂,涉及到更深层次的特征提取、多尺度预测和细化步骤。完整的数学公式可能需要更多篇幅来详细阐述。

五、OpenPose算法模型的代码实现

OpenPose是一个开源的人体关键点检测和全身姿态估计库,它使用深度学习模型进行实时的人体关键点检测。以下是一个简单的Python示例,使用PyTorch和OpenPose API进行人体关键点检测。请注意,这个例子需要你已经安装了OpenPose库和相关的依赖项。

下载0penPose源码,然后进行编译,请看教程:

openpose环境搭建(详细教程CPU/GPU)windows 10+python 3.7+CUDA 11.6+VS2022

安装后,实现代码如下:

import cv2

import numpy as np

from openpose import pyopenpose as op

# 初始化OpenPose

params = dict()

params["model_folder"] = "path_to_openpose_model" # 指定OpenPose模型路径

params["logging_level"] = 3 # 设置日志级别

params["num_gpu"] = 1 # 使用GPU

opWrapper = op.WrapperPython()

opWrapper.configure(params)

opWrapper.start()

# 读取图像

image = cv2.imread("path_to_image.jpg")

# 进行人体关键点检测

output = opWrapper.emplaceAndPop([image])

# 提取关键点

keypoints = output[0].bodyKeypoints

# 绘制关键点

for i in range(0, len(keypoints), 3):

x, y = keypoints[i], keypoints[i + 1]

cv2.circle(image, (int(x), int(y)), 5, (0, 255, 0), -1)

# 显示图像

cv2.imshow("OpenPose Detection", image)

cv2.waitKey(0)

cv2.destroyAllWindows()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

在这个例子中,我们需要替换"path_to_openpose_model"和"path_to_image.jpg"为你的OpenPose模型文件路径和要处理的图片路径。注意,OpenPose的安装和配置可能比较复杂,需要下载预训练模型,并在系统上设置环境变量。

六、总结

OpenPose是一款由CMU和Adobe研发的深度学习框架,专长于实时人体关键点检测和全身姿态估计。它结合CNN和CRF技术,能同时识别25个身体关节,支持多任务处理。其结构包含多尺度金字塔网络和部件解码器,采用级联方式提高精度。OpenPose在AR/VR、体育、行为识别、医疗等领域大显身手,如健身应用中的姿势追踪、游戏角色动作控制和医疗诊断辅助,极大地推动了计算机视觉在人体分析领域的广泛应用。