热门标签

热门文章

- 1GraphRAG 深入解析_graphrag深入解析

- 2本地运行《使用AMD上的SentenceTransformers构建语义搜索》_sentencetransformerembeddings本地

- 3RUST网络客户端的基本技术说明-裸指针和unsafe

- 4python处理语音的包_使用Python 2.x/3.x库处理语音数据

- 5Android制作.9图片_占位图16:9

- 6【MQ】MQ消息中间件RabbitMQ_mq中间件

- 7IT职场求生法则

- 8人工智能(4)发展现状及未来趋势_人工智能发展现状和趋势

- 9数字人下半场:奔向“真”生产力_2023年京东言犀数字人智能客服京小智使用商家数量超36万,中小商家数较2022年同期

- 10Nodejs 入门学习 (一) 定义变量_nodejs定义变量

当前位置: article > 正文

Langchain Streamlit AI系列之 使用 Google 的 Gemma-2b-it、LangChain 和 Streamlit 与 PDF 文档对话(教程含源码)

作者:木道寻08 | 2024-08-08 20:15:53

赞

踩

langchain streamlit ai系列之 使用 google 的 gemma-2b-it、langchain 和 stream

介绍

大型语言模型 (LLM) 擅长将有关世界的知识压缩为数十亿个参数。

然而,LLM 有两个主要限制:它们只拥有截至上一次训练迭代时的最新知识。当被问到特定问题时,它们有时会编造知识(产生幻觉)。

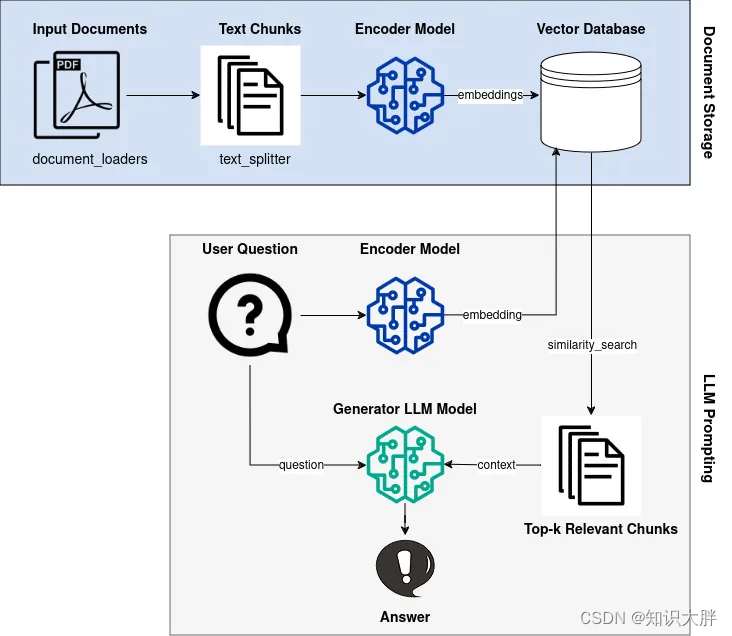

使用 RAG 技术,我们可以让预先训练过的 LLM 在回答我们的问题时访问非常具体的信息作为附加背景。

在本文中,我将介绍使用 Hugging Face 变换器库、LangChain 和 Faiss 矢量数据库实现具有附加 RAG 功能的 Google LLM Gemma 的理论和实践。

下图显示了RAG管道的概览,我们将逐步实现。

系列文章

-

《LangChain + Streamlit:在几分钟内创建基于语言模型的大型演示所需的技术堆栈》 权重1,本地类、Streamlit类、LangChain类

-

《使用本地 Llama 2 模型和向量数据库建立私有检索增强生成 (RAG) 系统 LangChain》权重1,llama类、本地类、langchai

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/木道寻08/article/detail/949763

推荐阅读

相关标签