- 1GitToolBox 插件安装与使用指南

- 2PyQt5保姆级教程-- 从入门到精通

- 3C/C++ 线程销毁问题_c++线程销毁

- 4RabbitMQ-消息队列延迟队列二

- 5java中http调用组件深入详解_java有哪些网络调用组件

- 6Unity开发Pico4_pico4开发 只能输入app id

- 7typescript 贪吃蛇_typescript贪吃蛇--食物逻辑代码(3)

- 8VUE UI项目管理器一直加载_vue项目管理器一直加载

- 9Java线程池中的execute和submit_java submit

- 10第11届蓝桥杯省赛真题剖析-2020年6月21日Scratch编程初中级组_蓝桥杯2020年省赛scratch 答案

深度学习之基础模型-Inception-V3_inception-v3模型

赞

踩

Although increased model size and computational cost tend to translate to immediate quality gains for most tasks (as long as enough labeled data is provided for training), computational efficiency and low parameter count are still enabling factors for various use cases such as mobile vision and big-data scenarios.

从论文中,可以看出作者主要考虑的是虽然网络的深度增加给很多任务带来了很多好处,但是模型的大小和计算效率也很关键,尤其是对于一些移动设备或者大数据场景,就显得很有必要了。

作者指出,尽管VGGNet在特征提取方面具有非常简洁的优势,但是也消耗了大量的计算资源,另一方面,GoogLeNet(Inception-V1)在内存和计算复杂度方面做了限制下,也能达到很好的效果。

- GoogLeNet包含5million参数,只是AlexNet的

112 ,其中AlexNet包含60million参数 - VGGNet包含的参数比AlexNet的3倍还多

通用设计原则

- 避免采用带有瓶颈的层,尤其在网络结构开始的时候。对于一个前向传播网络,可以将其看作一个有向五环图(从输入到分类或者回归层)。将输入与输出进行分开,都能导致大量的信息从分开处流失。一般的情况下,特征图的大小从输入到输出应该缓慢下降。理论上讲,很多信息不能通过特征维数来得到,比如相关性结构。维度智能代表一些粗略的信息。

- 高维度能够很更容易在网络的局部进行处理。在卷积网络结构中,增加非线性能够使得更多的特征解耦合。从而使的网络训练速度更快。

- 空间聚合能够在低维嵌入进行,然而不会带来任何表达能的减弱。例如,在进行3x3的卷积时,可以在空间聚合之前,对输入进行降维,而不会带来严重的影响。原因:如果采用空间聚合,则相邻的位置的信息具有强相关性,即使进行了降维,也不会带来太多的损失,并且维数的降低,也能够加速网络学习。

- 平衡网络的宽度和深度。最优的网络可以通过平衡每一个阶段的滤波器的个数和网络的深度达到。网络的宽度和深度的增加可以使的网络达到了一个更高的效果。但是,最优的网络结构都是通过同时来提升网络的宽度和深度,但是也需要考虑计算资源的分配。

大卷积->小卷积

- 考虑1x1卷积后面紧跟3x3卷积,由于激活层的相邻位置是高度相关的,因此这种先降维后聚合的操作也可以达到类似的局部表达效果。

- 任何的降维都能减少网络的参数。从而,合适的卷积分解,能得到更多的解耦合的特征,这也有助于提高网络训练的速度。另一方面,也可以利用节省下来的内存去增加filter-bank的大小,使得模型能哦股在单个机器上进行训练。

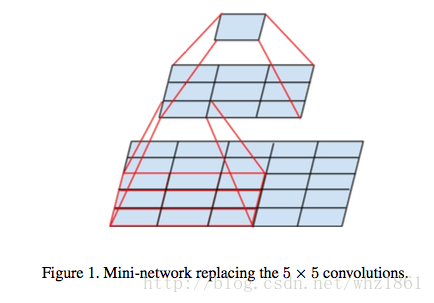

3x3的卷积相对5x5的卷积能减少更多的参数。因此可以利用两个3x3的小卷积代替一个5x5的卷积核,表达能力没有减弱,但参数却减少很多(

9+925 )[利用小卷积代替大卷积的思想在VGG中也有讨论]网络结构

遵循上面的原则,对Inception-v进行了改进

原始的Inception模块

将5x5的卷积改为2个3x3的卷积,得到

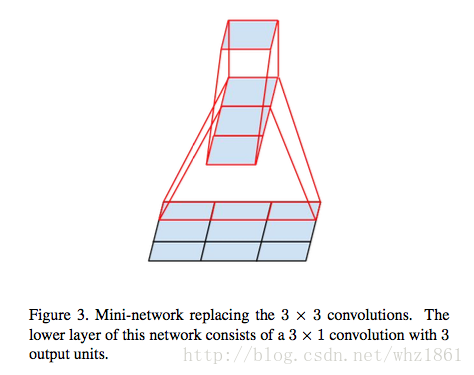

进一步,作者深入讨论了将NxN的卷积,分解成1xN和Nx1的卷积叠加

根据这种规则提出了如下结构:

- 将NxN结构分解为1xN和Nx1的叠加,能减少很多计算量。但是不建议在网络的开始阶段使用,效果并不好。但是在中间层使用,能达到不错的效果(中间处于12~20层的结构中)。这种尺度下,7x7的卷积分解成1x7和7x1的卷积后,呆了很好的效果

- 遵循通用构造原则中的第2条,在8x8的特征层上,利用这种分解然后聚合的结构来提升高维度的表达能力

辅助分类器

这种做法在GoogLeNet上就已经使用,认为这种辅助分类器,在网络训练过程中扮演着非常重要的角色,能有效的将梯度传播到底层。但是作者发现辅助分类器并没有提升收敛速度,但是却起到了正则化的作用:

- 如果辅助分类器使用了batch-normalized或者dropout层,最终的分类器效果更好

有效降低特征图尺寸

通常,卷积网络会利用pooling操作来降低特征图的大小。为了避免出现bottleneck现象,在应用Max Pooling或者average pooling之前,可以适当的扩大特征层的维度。

- 如果将

d xd 大小k 层的特征图,变成d2 x