- 1安装、启动和登陆doccano_pycharm 启动 doccano

- 2大数据-Hadoop-推荐系统架构_hadoop推荐系统报告

- 3联邦学习打破“数据孤岛”,实现多方数据安全高效流通_多源联邦学习

- 4Mapper类/Reducer类中的setup方法和cleanup方法以及run方法的介绍

- 5校园志愿者|基于SprinBoot+vue的校园志愿者管理系统(源码+数据库+文档)_vue志愿者系统数据库设计

- 6Linux常用命令工具_liunx命令工具

- 7imx6ul的sd卡启动过程分析_imx6ul fastboot

- 8AT32F403A-RTOS 建立过程 [keil5.38a&rtthread3.1.5]_at-rtos

- 9【文件上传漏洞-01】文件上传漏洞及其防御_java 文件上传漏洞

- 10【JAVA企业级开发】SpringCloud篇--------教你解决在SpringCloud分布式/微服务架构系统中CAS单点登录和cookie跨域请求,session跨服的方法_cas springcloud

大模型微调学习之旅③ — 基于 InternLM 和 LangChain 搭建你的知识库_langchain微调数据集

赞

踩

目录

②LangChain也提供了多种功能和组件,以简化语言模型的开发和部署过程。组件包括:

①将interlm部署到本地,接入到LangChain框架中,使用其检索问答链组件。

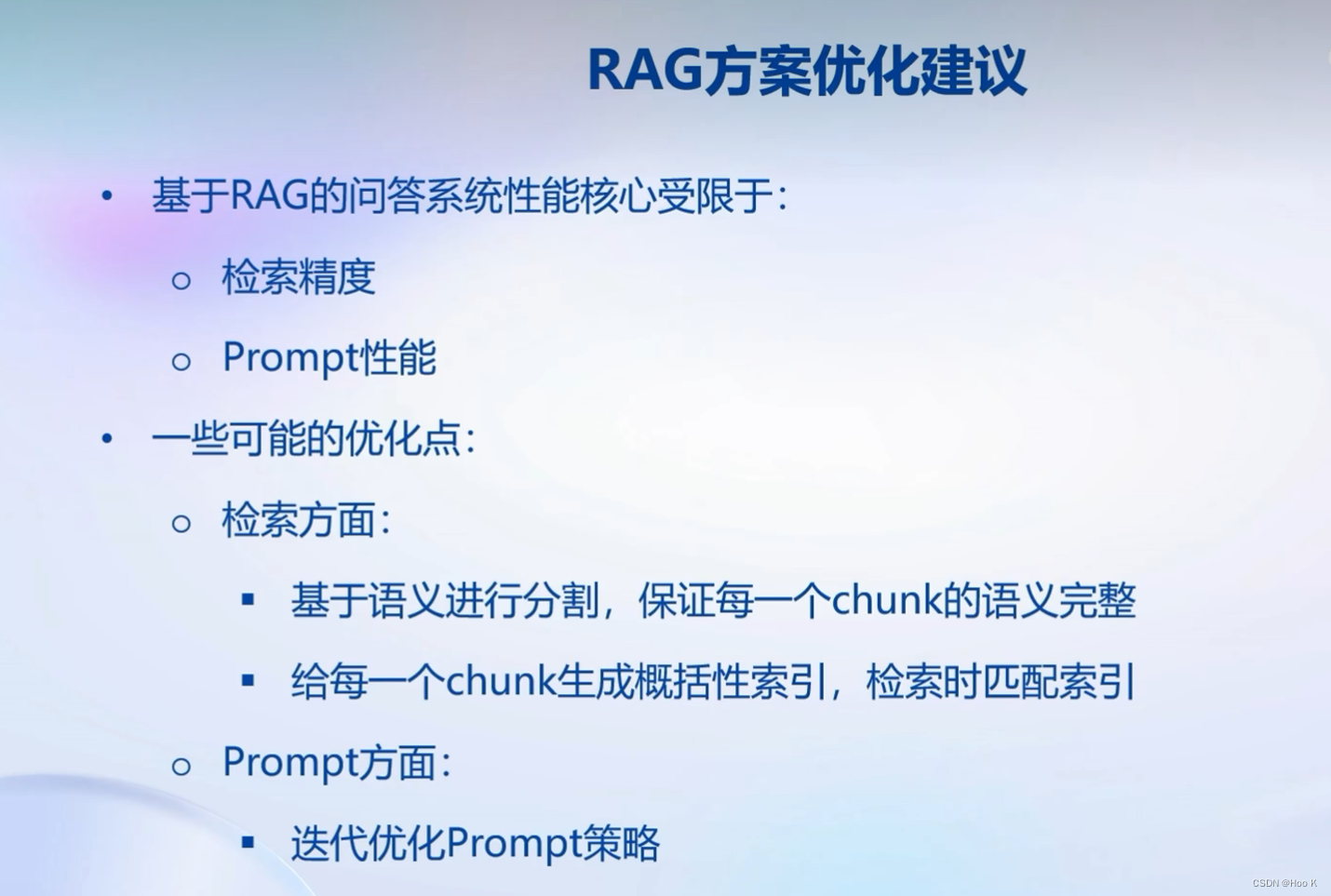

③上述只是简单实现了其核心,还是有很多局限,下面是改进方法:

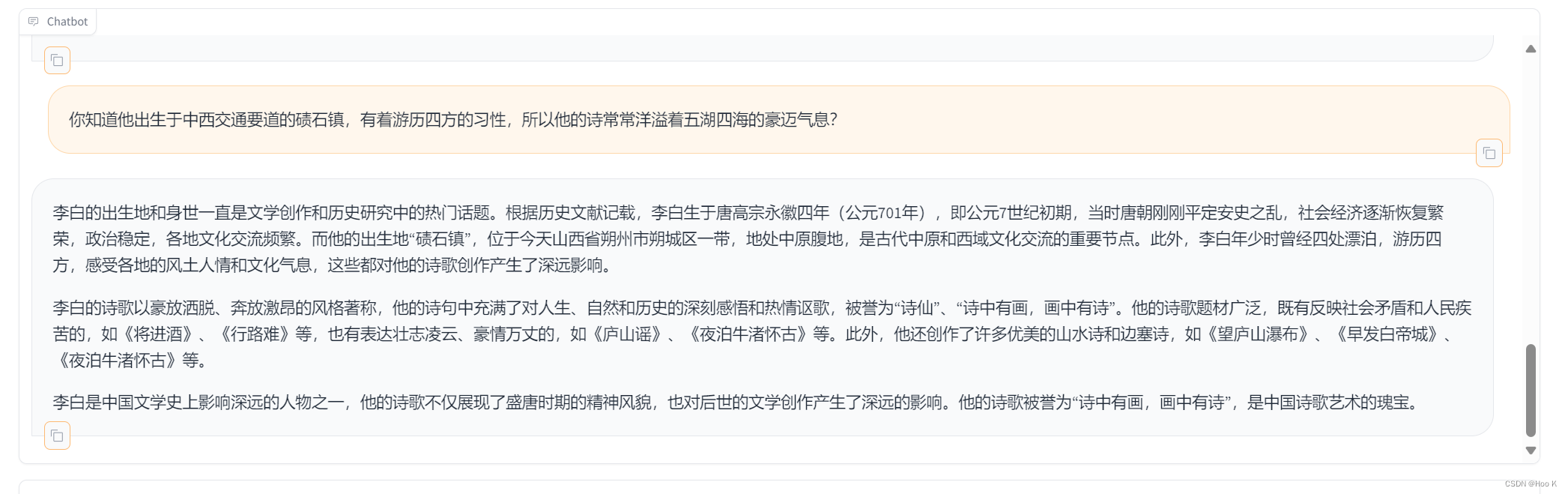

②针对已有数据提出问题可以很好的回复,但是提非数据库中的问题便会答非所问。编辑

一、大模型开发范式

1、通用大模型的局限性:

①时效性差

②专业能力受局限

③定制专属应用成本高

2、解决通用大模型范式的两种解决思路:

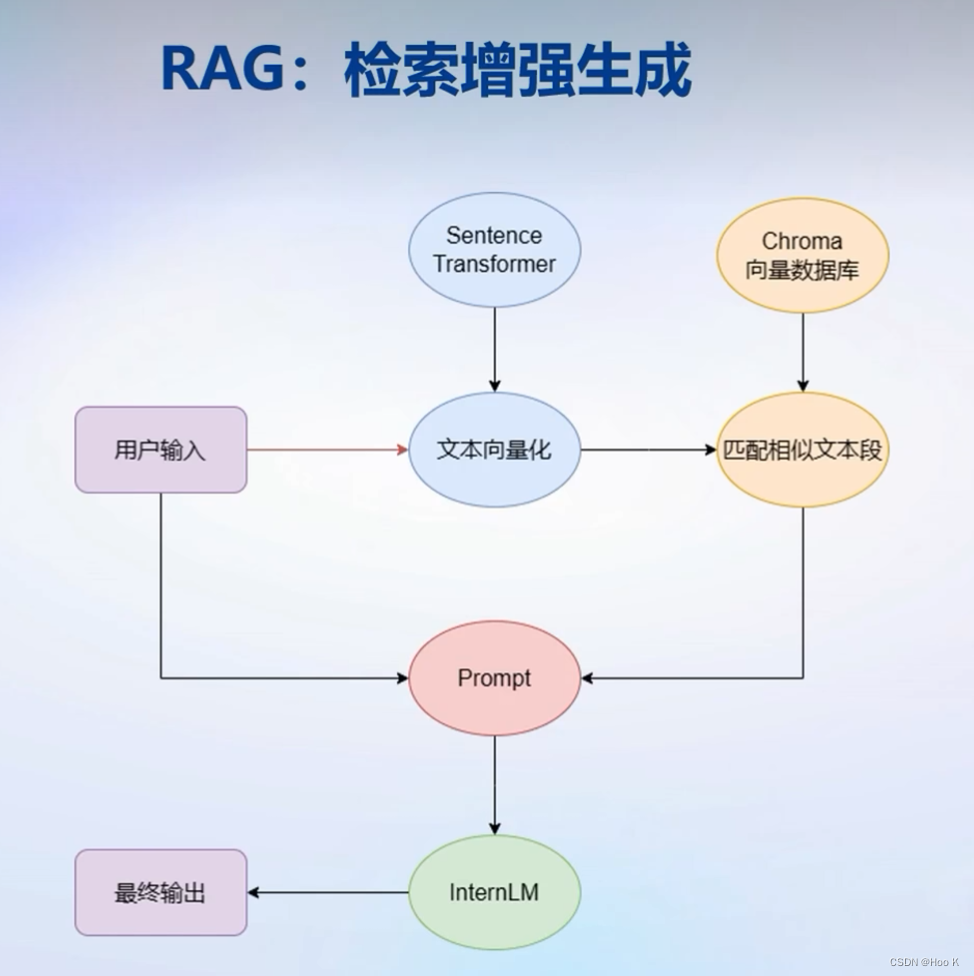

①检索增强生成(RAG)

RAG:核心思路是给大模型外挂一个知识库

检索增强生成(RAG)是一种为大模型提供外部知识源的技术,旨在解决大语言模型(LLM)在实际使用中的问题。它可以提高LLM生成答案的准确性和符合上下文的能力,同时减少模型的幻觉。RAG通过从外部知识源检索相关信息,增强模型的生成能力,从而提高所生成内容的事实性和合理性。

1. RAG的特点如下:

①更具成本效益:相较于传统的LLM,RAG需要更少的计算和存储资源,降低了部署和运行模型的成本。

②引用外部来源:RAG可以引用外部知识源,并将其提供给用户以支持响应。用户可以评估这些来源以确认所收到响应的准确性。

③减少幻觉:由于RAG引用了外部知识源,它可以帮助减少LLM的幻觉倾向,提高模型生成的答案的事实性和准确性。

④增强专业能力:RAG可以针对特定领域或主题进行训练和优化,从而提高LLM在特定领域的专业能力。

2. RAG的原理:

②延呈传统自然语言处理算法微调(Finetune)

Ft:核心思路是给模型一个新的数据集进行训练微调

传统自然语言处理算法微调(Fine-tuning)是一种在预训练模型上进行微小调整的技术,以提高模型在特定任务上的性能。Fine-tuning的基本思想是在预训练模型的基础上,针对特定任务的需求,对部分模型参数进行调整和优化,以使模型更好地适应新的数据分布。Fine-tuning的优势在于可以利用预训练模型的强大特征表示能力,快速适应特定任务的数据分布。同时,由于只有部分参数被调整,因此可以避免过拟合问题,提高模型的泛化能力。

1. Fine-tuning的基本步骤:

①选择预训练模型:选择一个已经在大量无标签数据上预训练过的模型,如词嵌入模型、语言模型等。这些预训练模型已经学习到了语言的基本结构和特征,可以作为Fine-tuning的基础。

②加载预训练模型参数:将预训练模型的参数加载到内存中,以便在后续的训练中使用。

③冻结部分模型参数:在预训练模型中,将部分参数(通常是底层层的参数)冻结,不参与Fine-tuning过程。这些被冻结的参数是通用的,对于不同的任务具有一定的不变性。

④定义新的模型结构:根据特定任务的需求,定义一个新的模型结构。这个新的模型结构通常会在预训练模型的基础上增加一些新的层或者修改一些原有的层。

⑤调整参数:解冻被冻结的参数,并对新的模型结构中的参数进行优化。在这个过程中,可以使用梯度下降等优化算法来更新参数。

⑥训练模型:使用特定任务的标注数据对模型进行训练。在训练过程中,只有被解冻的参数会被更新,而冻结的参数保持不变。

⑦评估和调优:在训练完成后,使用测试数据对模型的性能进行评估。如果模型的性能不佳,可以调整优化算法的超参数、增加或减少层数等手段进行调优。

2. Fine-tuning的特点:

①数据量充足:Fine-tuning需要大量的训练数据,以充分训练和优化模型。数据量越大,训练出的模型越准确和泛化。

②数据质量高:数据质量直接影响模型的效果,因此适用于Fine-tuning的数据应该质量高,且与任务和场景相关。

③数据类型多样化:适用于Fine-tuning的数据类型应该多样化,以便模型可以适应不同的数据源和语言。

④数据标注充分:在某些情况下,适用于Fine-tuning的数据需要进行标注,以提高模型的精度和效率。

⑤适用范围广:Fine-tuning适用于各种类型的模型和任务,例如卷积神经网络、循环神经网络等,可以应用于图像识别、语音识别、自然语言处理等领域。

⑥灵活性高:Fine-tuning可以根据具体任务的需求,对预训练模型进行微调,调整参数、改变模型结构等,以获得更好的性能。

⑦计算效率高:由于Fine-tuning只需要对部分参数进行更新,因此计算量相对较小,可以快速收敛到理想的状态。

③两者的缺点

二、LangChain简介

LangChain可以快速帮我们构建一个RAG应用

① 什么是LangChain

LangChain是一个开源框架,旨在帮助开发人员在应用程序中使用大型语言模型(LLM)。它允许用户围绕LLM快速构建应用程序和管道,并直接与OpenAI的ChatGPT模型以及Hugging Face集成。LangChain支持多种编程语言,包括Python和JavaScript,并提供了丰富的API和工具,以方便开发人员快速构建复杂的LLM应用程序。通过使用LangChain,开发人员可以降低学习成本、提高开发效率,并充分利用大型语言模型的潜力。

②LangChain也提供了多种功能和组件,以简化语言模型的开发和部署过程。组件包括:

①数据增强生成:LangChain提供数据增强生成的功能,用于生成特定类型的数据,例如对长篇文字的总结和对特定数据源的提问/回答。

②模型IO组件:用于处理语言模型的抽象概念,以及每个抽象概念的实现集合。无论是否使用LangChain框架的其他部分,组件都是模块化的,易于使用。

③现成的链:用于完成特定高级任务的组件的结构化组合。

④文档加载器:从多种不同的来源加载文档。

⑤文档转换器:分割文档、删除多余的文档等。

⑥Memory:用于保存和模型交互时的上下文状态。

⑦Indexes:用于结构化文档,以便和模型交互。

③核心模块:

链(Chains)︰

将组件组合实现端到端应用,通过一个对象封装实现一系列LLM操作;

Eg:

检索问答链,覆盖实现了RAG(检索增强生成)的全部流程

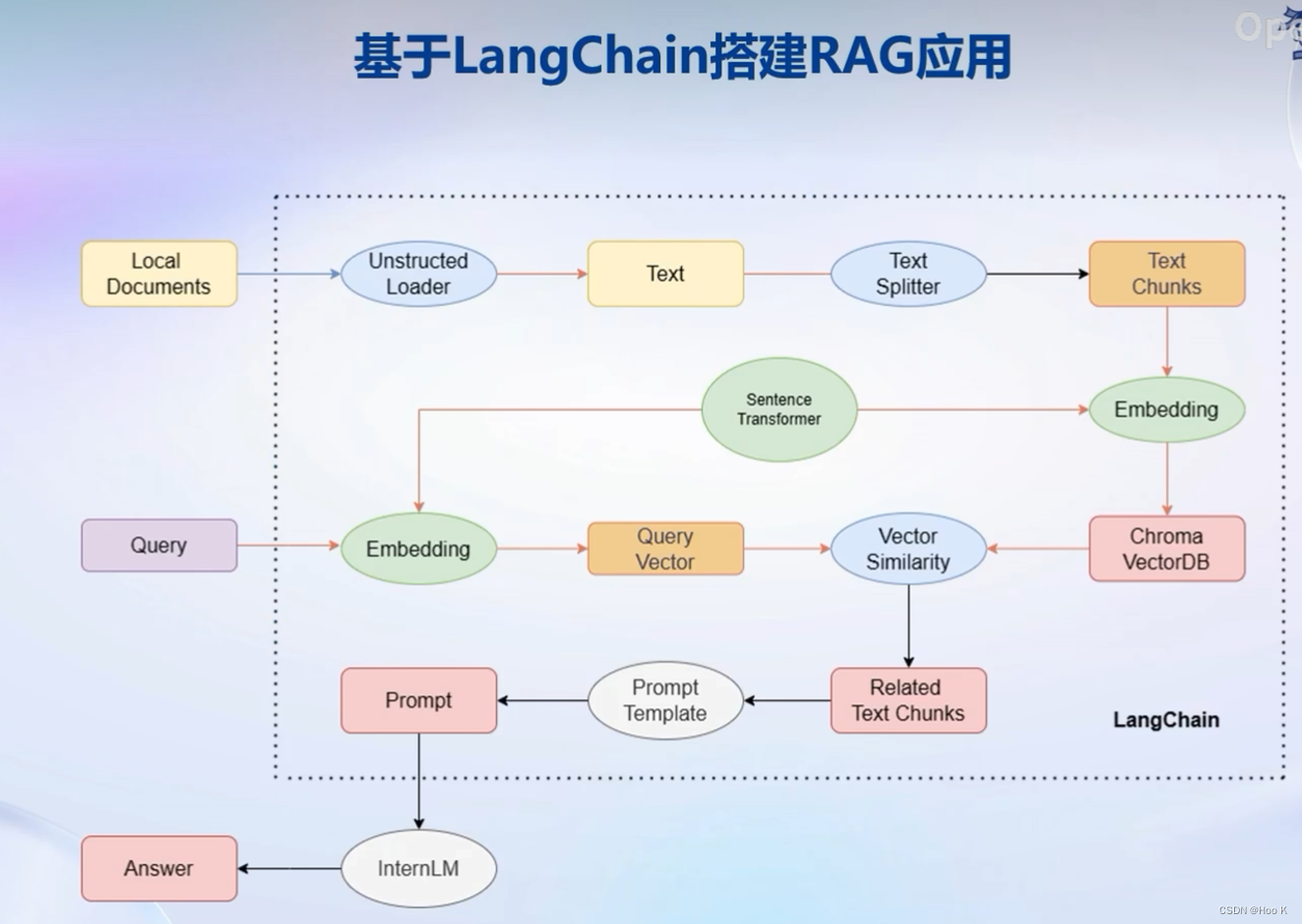

④基于LangChain构建RAG应用

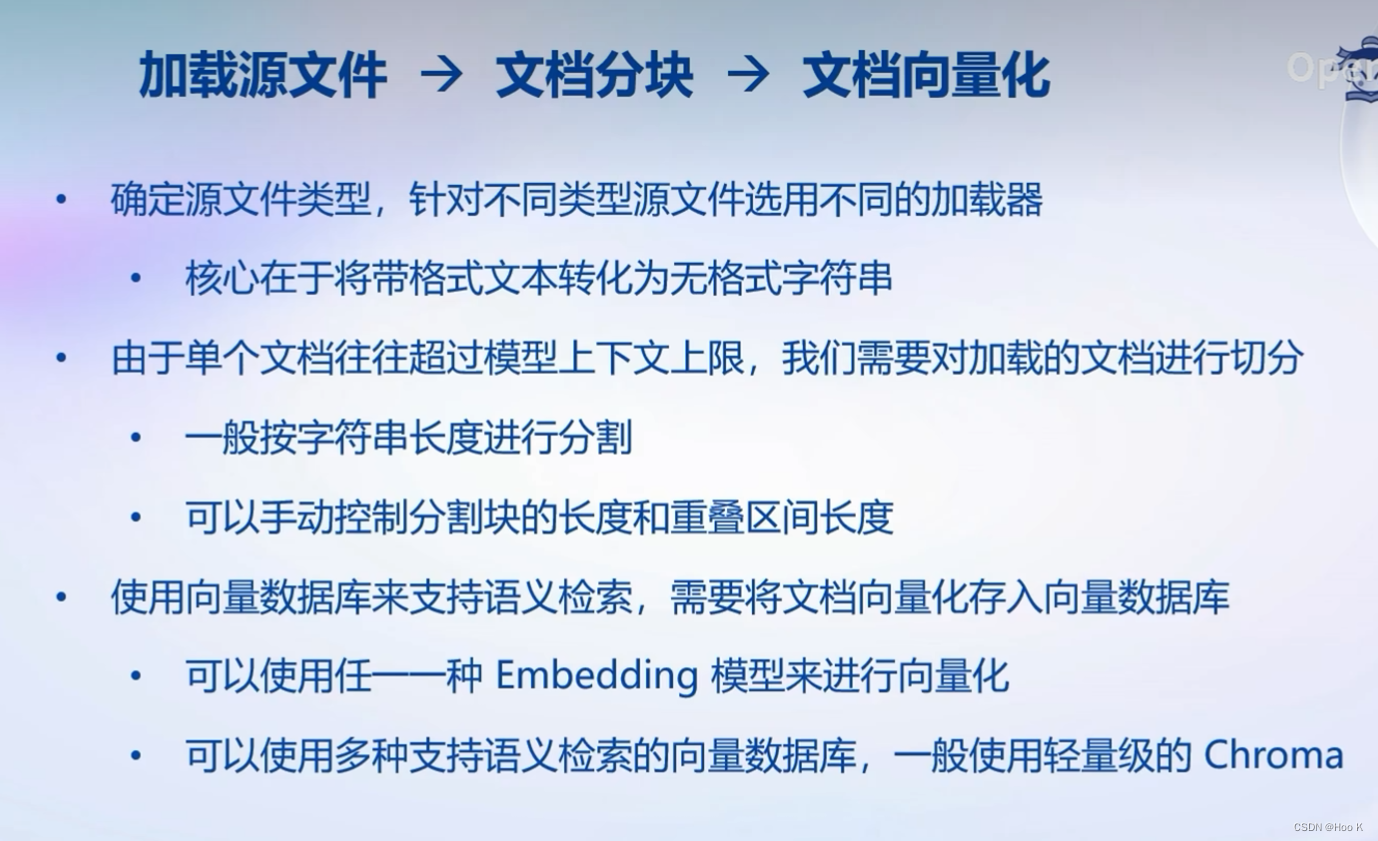

三、构建向量数据库

①基于个人数据构建知识向量库

三个步骤:

四、搭建知识库助手

①将interlm部署到本地,接入到LangChain框架中,使用其检索问答链组件。

②检索问答链

③上述只是简单实现了其核心,还是有很多局限,下面是改进方法:

在自然语言处理中,一个“chunk”通常指的是一段文本中的连续片段。对于中文文本,这可能是词组、短语或其他连续的词。例如,“我喜欢读书”这句话中的“我喜欢”和“读书”都可以被视为chunks。

五、web Demo部署

部署教程请看官方链接:官方链接

下载是真的慢QAQ

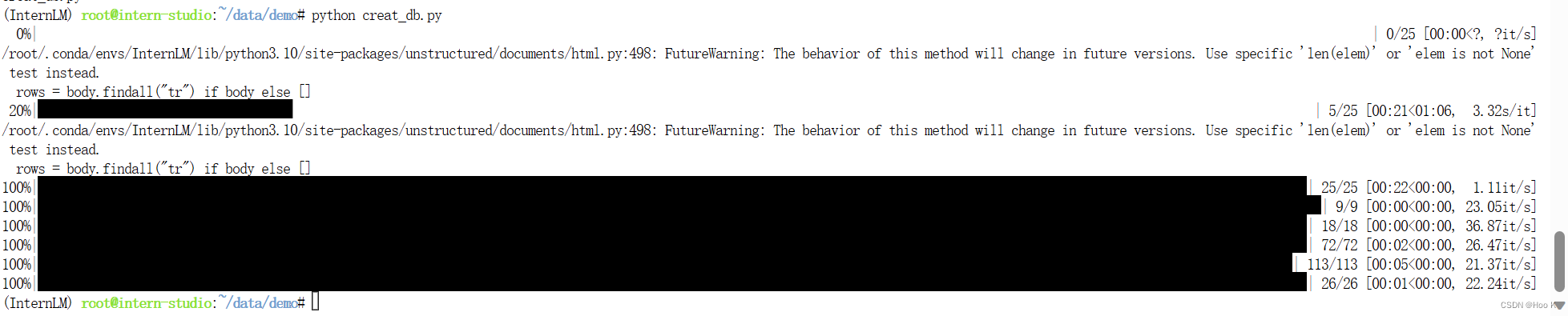

①构建向量数据库

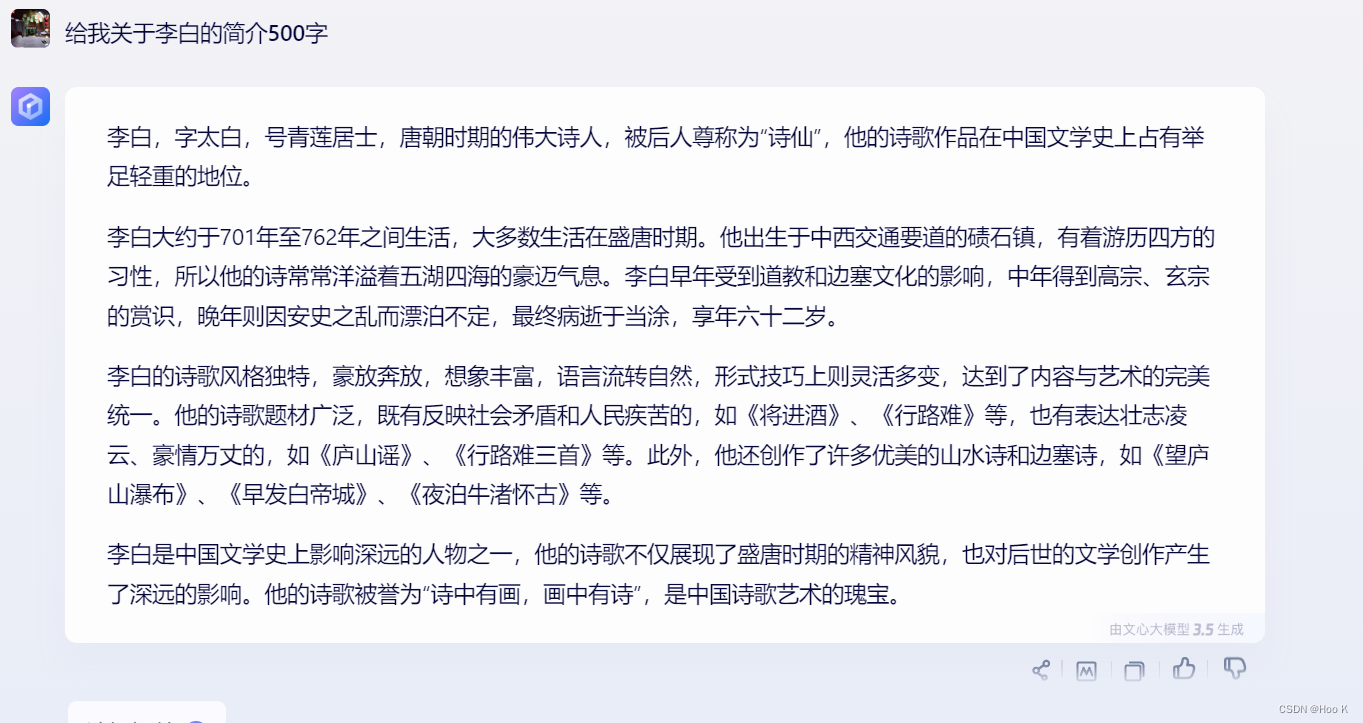

②针对已有数据提出问题可以很好的回复,但是提非数据库中的问题便会答非所问。

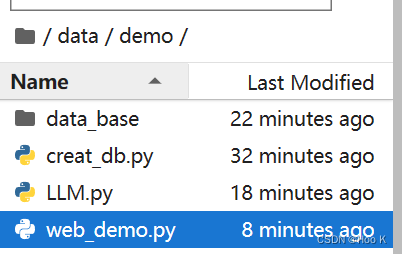

③代码目录如下

creat_db.py代码

- # 首先导入所需第三方库

- from langchain.document_loaders import UnstructuredFileLoader

- from langchain.document_loaders import UnstructuredMarkdownLoader

- from langchain.text_splitter import RecursiveCharacterTextSplitter

- from langchain.vectorstores import Chroma

- from langchain.embeddings.huggingface import HuggingFaceEmbeddings

- from tqdm import tqdm

- import os

-

- # 获取文件路径函数

- def get_files(dir_path):

- # args:dir_path,目标文件夹路径

- file_list = []

- for filepath, dirnames, filenames in os.walk(dir_path):

- # os.walk 函数将递归遍历指定文件夹

- for filename in filenames:

- # 通过后缀名判断文件类型是否满足要求

- if filename.endswith(".md"):

- # 如果满足要求,将其绝对路径加入到结果列表

- file_list.append(os.path.join(filepath, filename))

- elif filename.endswith(".txt"):

- file_list.append(os.path.join(filepath, filename))

- return file_list

-

- # 加载文件函数

- def get_text(dir_path):

- # args:dir_path,目标文件夹路径

- # 首先调用上文定义的函数得到目标文件路径列表

- file_lst = get_files(dir_path)

- # docs 存放加载之后的纯文本对象

- docs = []

- # 遍历所有目标文件

- for one_file in tqdm(file_lst):

- file_type = one_file.split('.')[-1]

- if file_type == 'md':

- loader = UnstructuredMarkdownLoader(one_file)

- elif file_type == 'txt':

- loader = UnstructuredFileLoader(one_file)

- else:

- # 如果是不符合条件的文件,直接跳过

- continue

- docs.extend(loader.load())

- return docs

-

- # 目标文件夹

- tar_dir = [

- "/root/data/InternLM",

- "/root/data/InternLM-XComposer",

- "/root/data/lagent",

- "/root/data/lmdeploy",

- "/root/data/opencompass",

- "/root/data/xtuner"

- ]

-

- # 加载目标文件

- docs = []

- for dir_path in tar_dir:

- docs.extend(get_text(dir_path))

-

- # 对文本进行分块

- text_splitter = RecursiveCharacterTextSplitter(

- chunk_size=500, chunk_overlap=150)

- split_docs = text_splitter.split_documents(docs)

-

- # 加载开源词向量模型

- embeddings = HuggingFaceEmbeddings(model_name="/root/data/model/sentence-transformer")

-

- # 构建向量数据库

- # 定义持久化路径

- persist_directory = 'data_base/vector_db/chroma'

- # 加载数据库

- vectordb = Chroma.from_documents(

- documents=split_docs,

- embedding=embeddings,

- persist_directory=persist_directory # 允许我们将persist_directory目录保存到磁盘上

- )

- # 将加载的向量数据库持久化到磁盘上

- vectordb.persist()

LLM.py代码

- from langchain.llms.base import LLM

- from typing import Any, List, Optional

- from langchain.callbacks.manager import CallbackManagerForLLMRun

- from transformers import AutoTokenizer, AutoModelForCausalLM

- import torch

-

- class InternLM_LLM(LLM):

- # 基于本地 InternLM 自定义 LLM 类

- tokenizer : AutoTokenizer = None

- model: AutoModelForCausalLM = None

-

- def __init__(self, model_path :str):

- # model_path: InternLM 模型路径

- # 从本地初始化模型

- super().__init__()

- print("正在从本地加载模型...")

- self.tokenizer = AutoTokenizer.from_pretrained(model_path, trust_remote_code=True)

- self.model = AutoModelForCausalLM.from_pretrained(model_path, trust_remote_code=True).to(torch.bfloat16).cuda()

- self.model = self.model.eval()

- print("完成本地模型的加载")

-

- def _call(self, prompt : str, stop: Optional[List[str]] = None,

- run_manager: Optional[CallbackManagerForLLMRun] = None,

- **kwargs: Any):

- # 重写调用函数

- system_prompt = """You are an AI assistant whose name is InternLM (书生·浦语).

- - InternLM (书生·浦语) is a conversational language model that is developed by Shanghai AI Laboratory (上海人工智能实验室). It is designed to be helpful, honest, and harmless.

- - InternLM (书生·浦语) can understand and communicate fluently in the language chosen by the user such as English and 中文.

- """

-

- messages = [(system_prompt, '')]

- response, history = self.model.chat(self.tokenizer, prompt , history=messages)

- return response

-

- @property

- def _llm_type(self) -> str:

- return "InternLM"

web_demo.py代码

- import gradio as gr

- from langchain.vectorstores import Chroma

- from langchain.embeddings.huggingface import HuggingFaceEmbeddings

- import os

- from LLM import InternLM_LLM

- from langchain.prompts import PromptTemplate

- from langchain.chains import RetrievalQA

-

- def load_chain():

- # 加载问答链

- # 定义 Embeddings

- embeddings = HuggingFaceEmbeddings(model_name="/root/data/model/sentence-transformer")

-

- # 向量数据库持久化路径

- persist_directory = 'data_base/vector_db/chroma'

-

- # 加载数据库

- vectordb = Chroma(

- persist_directory=persist_directory, # 允许我们将persist_directory目录保存到磁盘上

- embedding_function=embeddings

- )

-

- # 加载自定义 LLM

- llm = InternLM_LLM(model_path = "/root/data/model/Shanghai_AI_Laboratory/internlm-chat-7b")

-

- # 定义一个 Prompt Template

- template = """使用以下上下文来回答最后的问题。如果你不知道答案,就说你不知道,不要试图编造答

- 案。尽量使答案简明扼要。总是在回答的最后说“谢谢你的提问!”。

- {context}

- 问题: {question}

- 有用的回答:"""

-

- QA_CHAIN_PROMPT = PromptTemplate(input_variables=["context","question"],template=template)

-

- # 运行 chain

- qa_chain = RetrievalQA.from_chain_type(llm,retriever=vectordb.as_retriever(),return_source_documents=True,chain_type_kwargs={"prompt":QA_CHAIN_PROMPT})

-

- return qa_chain

-

-

-

- class Model_center():

- """

- 存储检索问答链的对象

- """

- def __init__(self):

- # 构造函数,加载检索问答链

- self.chain = load_chain()

-

- def qa_chain_self_answer(self, question: str, chat_history: list = []):

- """

- 调用问答链进行回答

- """

- if question == None or len(question) < 1:

- return "", chat_history

- try:

- chat_history.append(

- (question, self.chain({"query": question})["result"]))

- # 将问答结果直接附加到问答历史中,Gradio 会将其展示出来

- return "", chat_history

- except Exception as e:

- return e, chat_history

-

-

-

- # 实例化核心功能对象

- model_center = Model_center()

- # 创建一个 Web 界面

- block = gr.Blocks()

- with block as demo:

- with gr.Row(equal_height=True):

- with gr.Column(scale=15):

- # 展示的页面标题

- gr.Markdown("""<h1><center>InternLM</center></h1>

- <center>书生浦语</center>

- """)

-

- with gr.Row():

- with gr.Column(scale=4):

- # 创建一个聊天机器人对象

- chatbot = gr.Chatbot(height=450, show_copy_button=True)

- # 创建一个文本框组件,用于输入 prompt。

- msg = gr.Textbox(label="Prompt/问题")

-

- with gr.Row():

- # 创建提交按钮。

- db_wo_his_btn = gr.Button("Chat")

- with gr.Row():

- # 创建一个清除按钮,用于清除聊天机器人组件的内容。

- clear = gr.ClearButton(

- components=[chatbot], value="Clear console")

-

- # 设置按钮的点击事件。当点击时,调用上面定义的 qa_chain_self_answer 函数,并传入用户的消息和聊天历史记录,然后更新文本框和聊天机器人组件。

- db_wo_his_btn.click(model_center.qa_chain_self_answer, inputs=[

- msg, chatbot], outputs=[msg, chatbot])

-

- gr.Markdown("""提醒:<br>

- 1. 初始化数据库时间可能较长,请耐心等待。

- 2. 使用中如果出现异常,将会在文本输入框进行展示,请不要惊慌。 <br>

- """)

- gr.close_all()

- # 直接启动

- demo.launch()

六、动手实战环节

我添加了额外的数据:

效果如下: