- 1Python爬虫入门实例:Python7个爬虫小案例(附源码)_python网络爬虫技术案例教程

- 2Java 使用 JDBC 连接mysql

- 3PMP认证是什么?考试相关的详细介绍_什么是pmp考试?

- 4抛java.lang.NoClassDefFoundError: org.slf4j.LoggerFactory错误_sofa-middleware-log slf4j error : build iloggerfac

- 5AI绘画Stable Diffusion【游戏场景】: 等距视图之3D游戏环境模型分享,设计师必看!(附模型下载)_stable diffusion 游戏素材

- 6怎么进行按钮级别的权限控制?

- 7java语言alist,如何在Java中反轉列表?

- 8IT专业入门,高考假期预习指南

- 9阿里云专有云平台

- 10【数据挖掘】决策树中C4.5与CART算法讲解及决策树应用iris数据集实战(图文解释 附源码)_cart算法中target是什么

自然语言开源大模型ChatGLM-6B的本地部署_chatglm-6b 本地部署

赞

踩

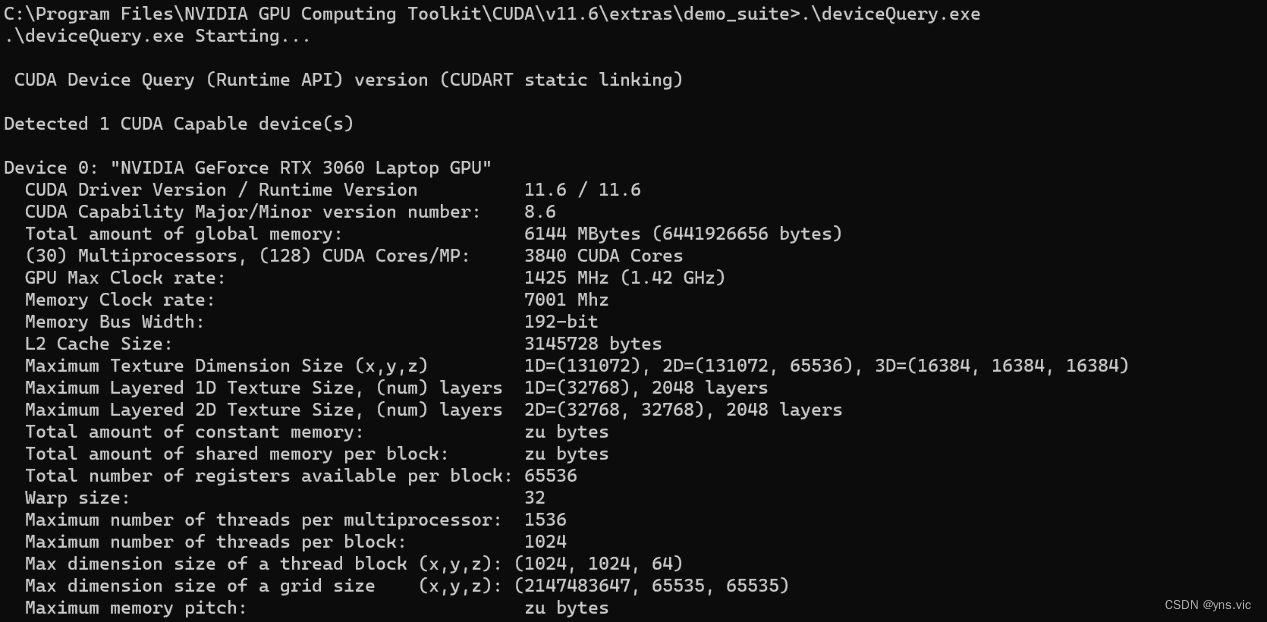

1.环境信息

显卡:NVIDIA GeForce RTX 3060 Laptop GPU

系统:Windows 11

CUDA版本:11.6

Python.exe版本:3.8

Pytorch版本:1.12.1

IDE:PyCharm

Anaconda虚拟环境

模型在GPU上运行

2.实验内容

1)首先从GitHub - THUDM/ChatGLM-6B: ChatGLM-6B: An Open Bilingual Dialogue Language Model | 开源双语对话语言模型下载ChatGLM-6B-main并解压,保存路径为D盘根目录。

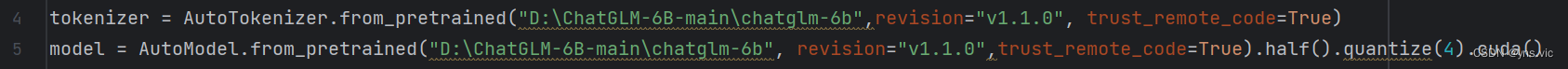

2)由于网络原因,在本机上无法使用命令“from transformers import AutoTokenizer, AutoModel” 自动下载模型实现和参数。所以我选择首先将模型下载到本地,然后从本地加载。步骤如下:安装Git LFS,然后在Git CMD中输入git clone https://huggingface.co/THUDM/chatglm-6b。保存路径为D:\ChatGLM-6B-main\chatglm-6b

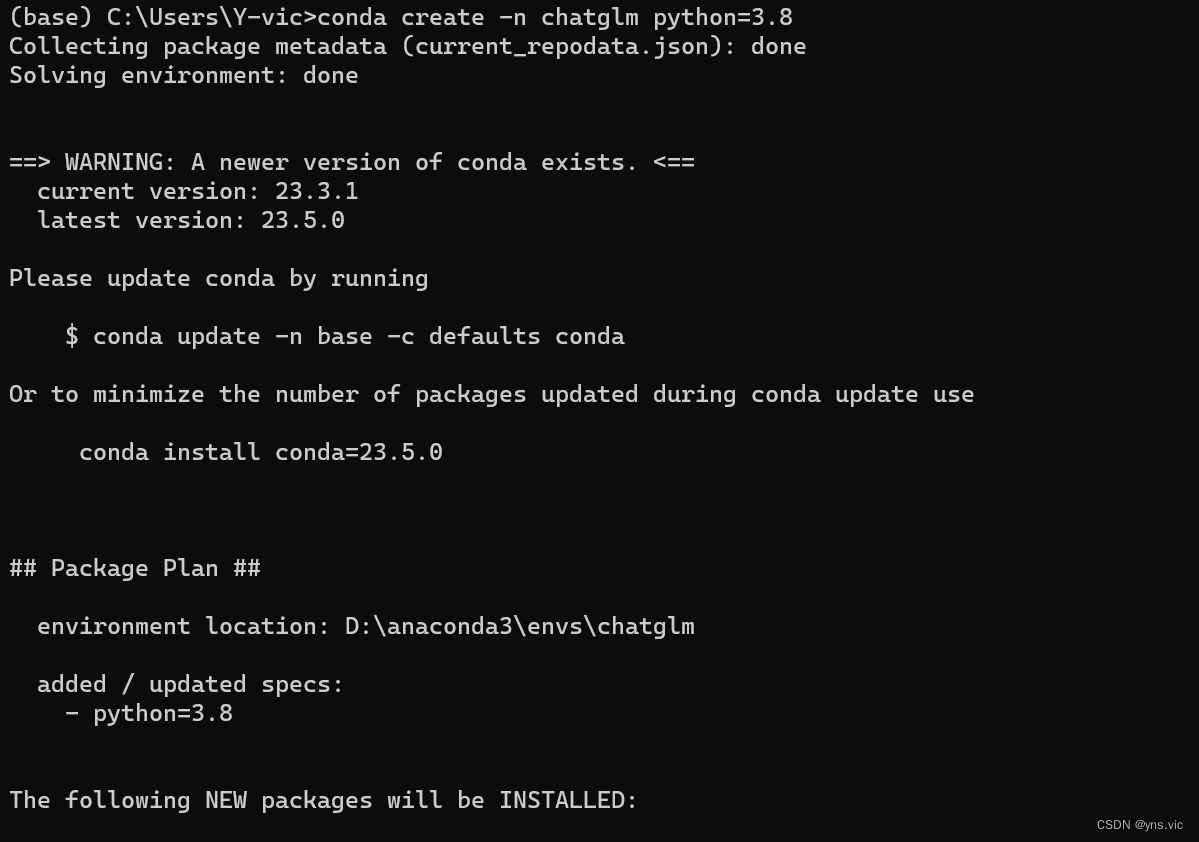

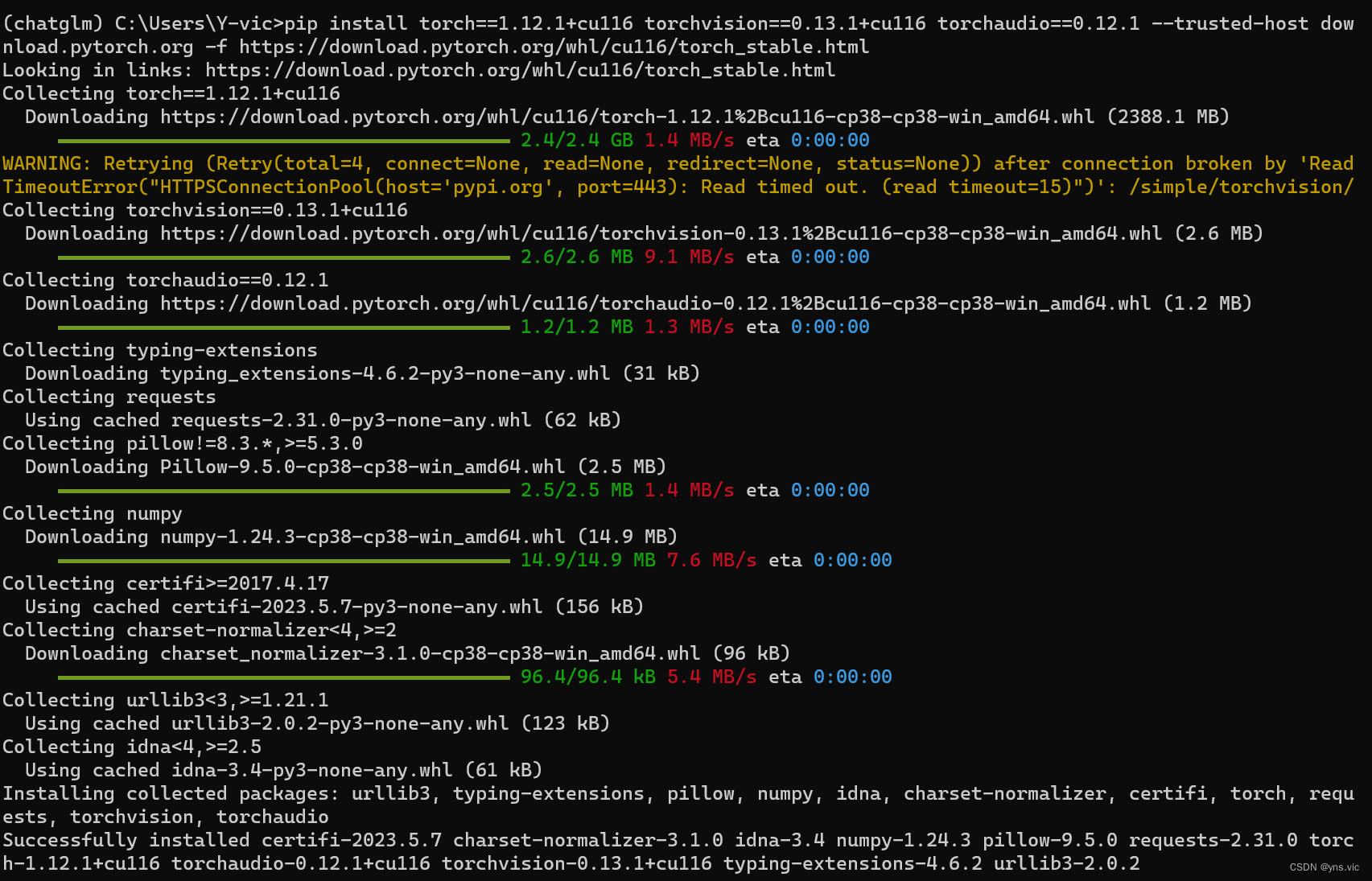

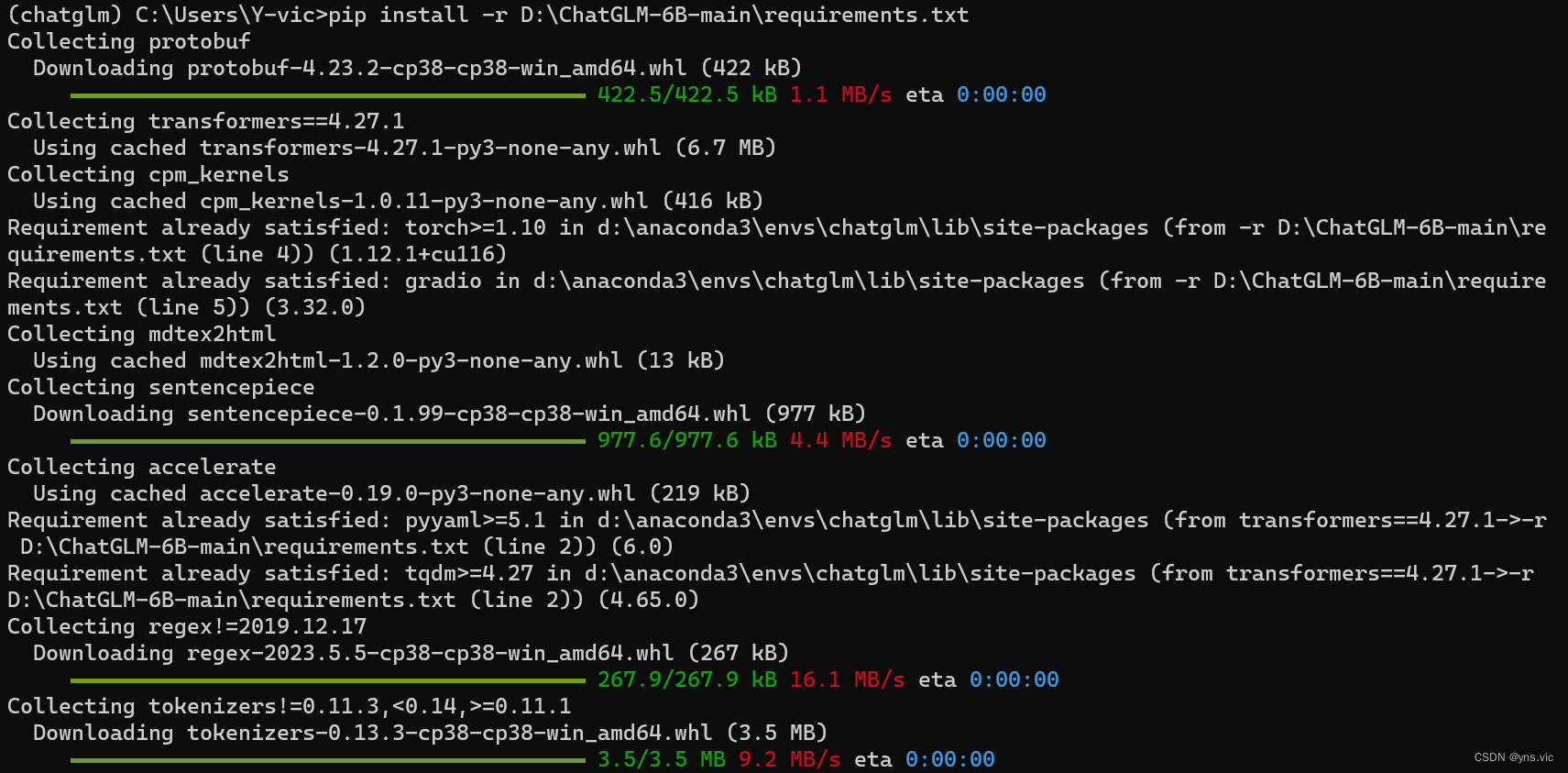

3)使用anaconda3为ChatGLM-6B创建新的虚拟环境,使用python.exe3.8版本,由于本机显卡支持cuda11.6版本及以上,所以我选择了cuda11.6,以及torch1.12.1,命令行运行结果如下:

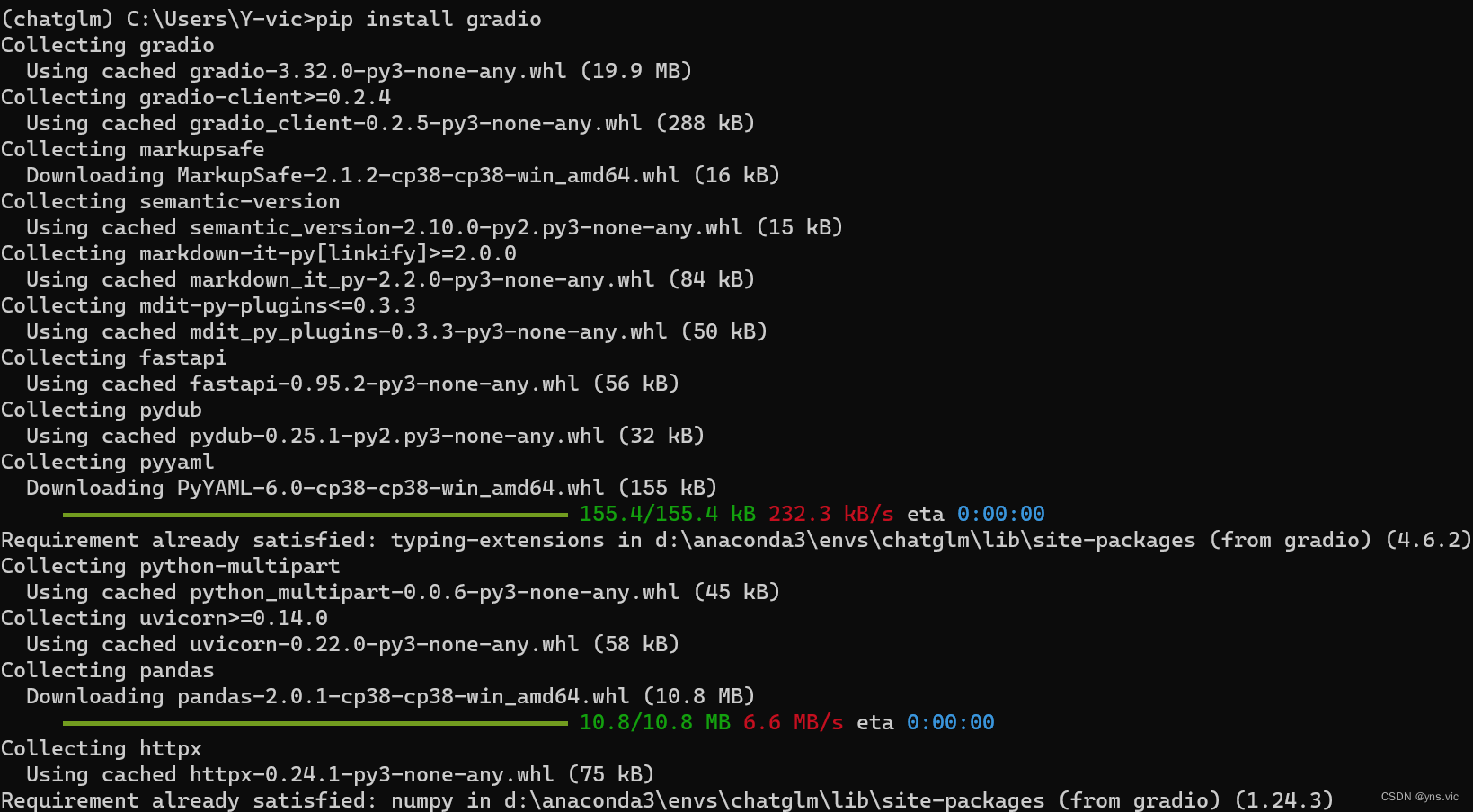

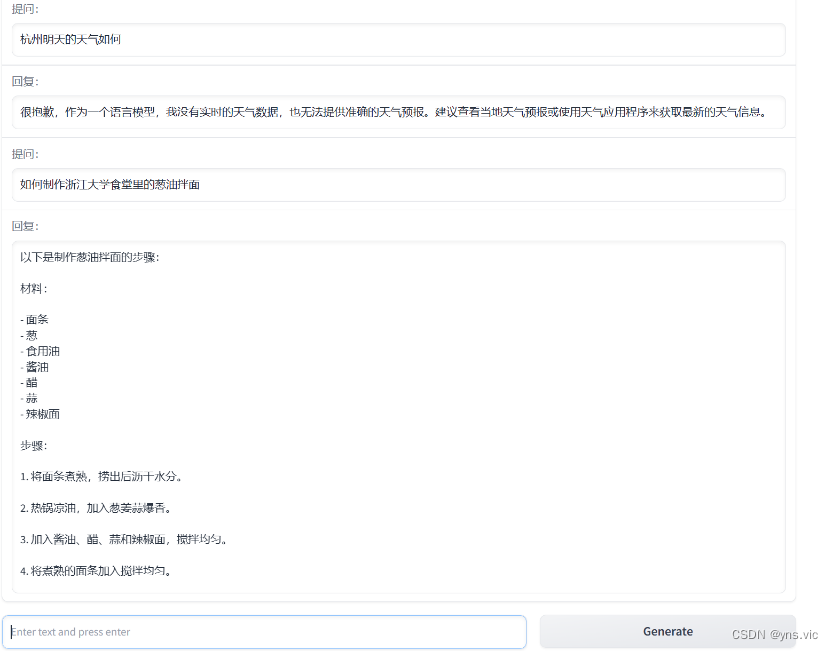

因为想实现网页版demo,所以继续安装gradio,以及运行依赖,相关结果如下:

至此完成虚拟环境的配置。

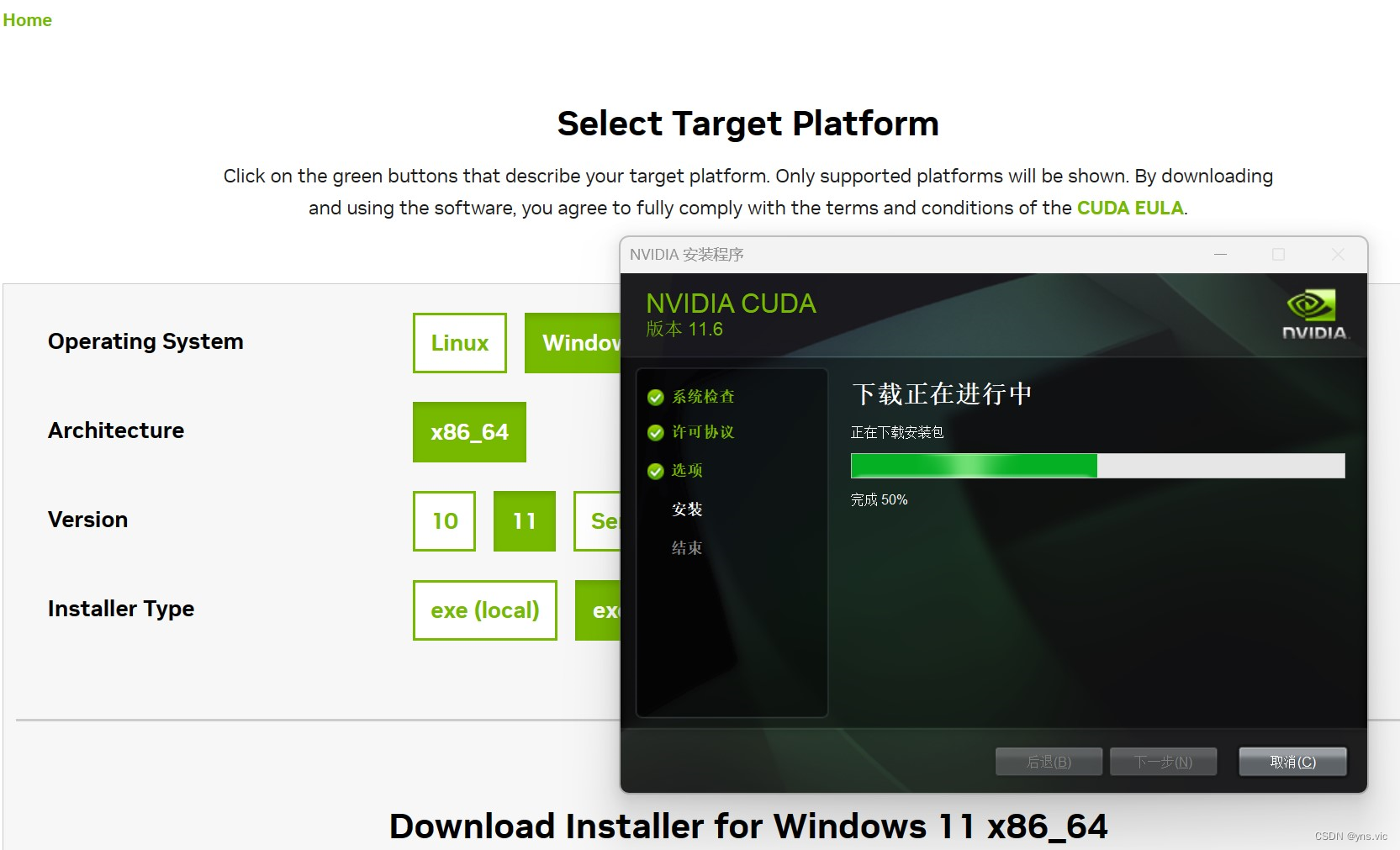

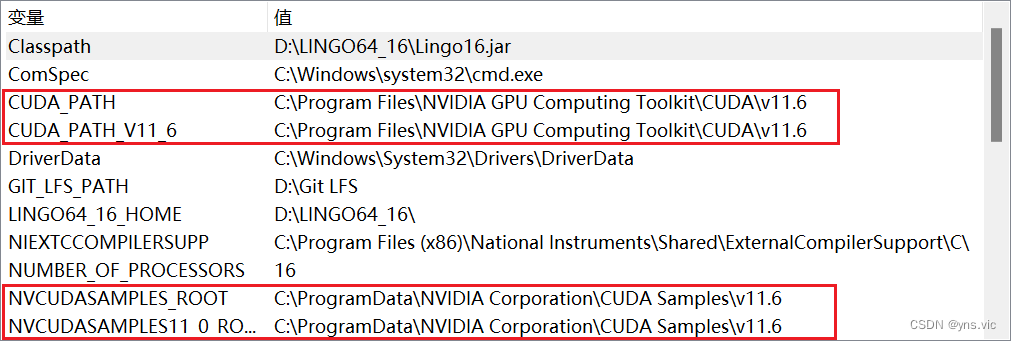

4)下载CUDA toolkit和cuDNN。因为我之前并没有接触过CUDA,所以这里需要额外下载CUDA并配置环境变量。

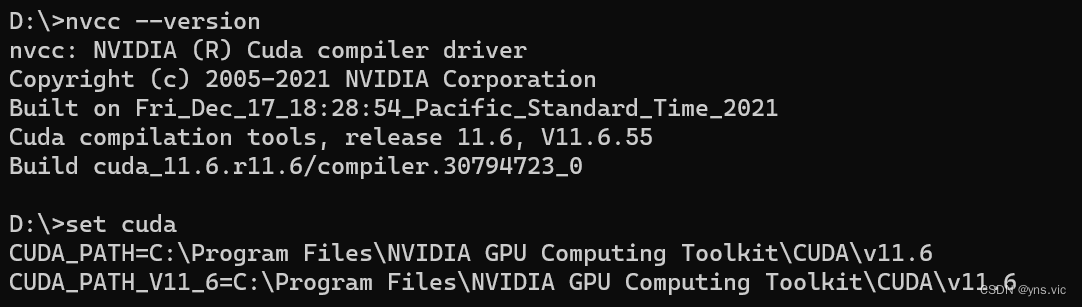

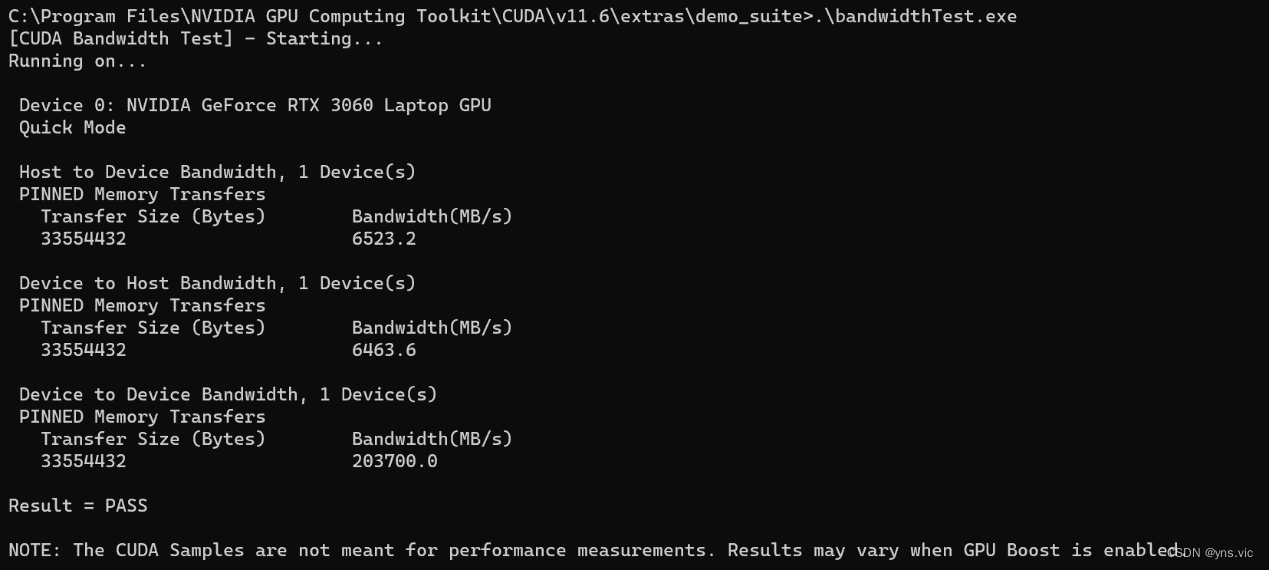

以下命令用于检验是否下载配置成功:

5)使用PyCharm打开ChatGLM-6B-main项目对web_demo.py做出以下修改后,运行即可在弹出的网页中对话,下图是修改内容和运行结果:

3.遇到的问题和解决方法

在具体配置的时候,我遇到的很大的问题就是在下载的ChatGLM项目是包含一个虚拟环境的,但是里面的pytorh的版本是2.0.1+cpu,该版本的torch适配的CUDA版本并不支持Windows11系统,(CUDA是从11.4.3版本之后才开始适配Windows11),此外我的显卡又只适配11.6版本以上,所以我的解决方法就是使用anaconda创建一个新的虚拟环境,采用python.exe 3.8,cuda 11.6,以及torch1.12.1。