热门标签

热门文章

- 1编程猫官网和猫社区_编程猫社区入口

- 2MySQL开启慢查询_mysql如何开启慢查询

- 3嫌功能测试薪资太低岗位太Low?3分钟带你入门自动化测试!

- 4【Datawhale组队学习:Sora原理与技术实战】Transformers+diffusion_sora transformers diffusion

- 5面向对象的开发方法(Object Oriented,OO)

- 6一种简单的地图聚合算法

- 7性能测试流程-JMeter工具进行系统最大并发数测试_jmeter 最大并发数

- 8Kafka核心技术与实战 15 消费者组

- 9python实现Android实时投屏操控_scrcpy投屏python

- 10编码问题:UnicodeDecodeError: 'utf-8' codec can't decode byte 0xb3 in position

当前位置: article > 正文

轻松搭建llama3Web 交互界面 - Ollama + Open WebUI_ollama3

作者:盐析白兔 | 2024-05-07 07:51:26

赞

踩

ollama3

Ubuntu下安装:(官网:Download Ollama on Linux)

curl -fsSL https://ollama.com/install.sh | sh

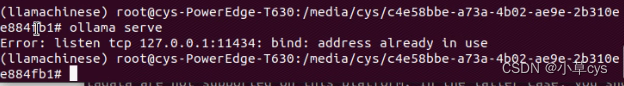

就运行起来ollama了,不放心可以用ollama serve查看一下

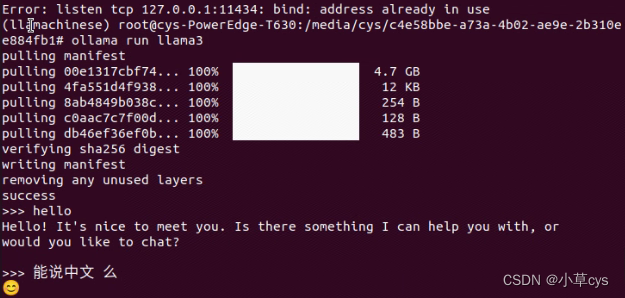

ollama run llama3

就可以跑起来了,

那么我们肯定还是希望有chat界面,

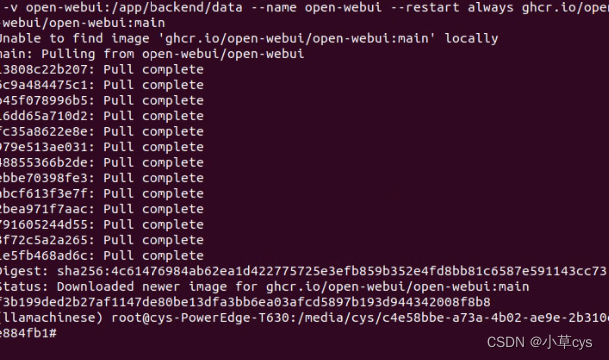

使用https://github.com/open-webui/open-webui

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

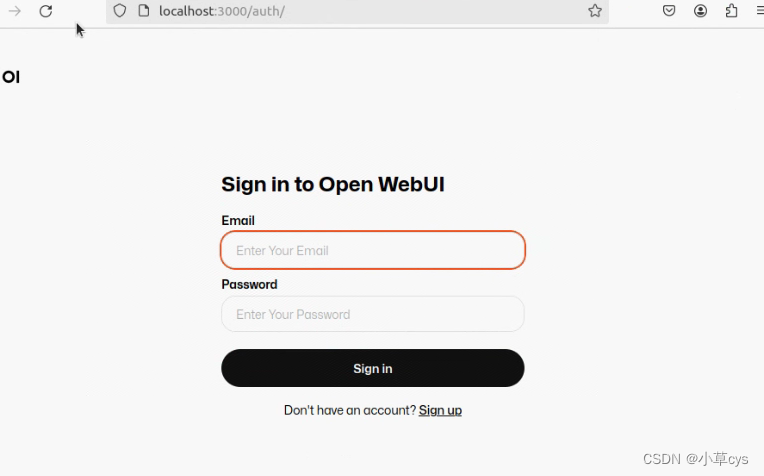

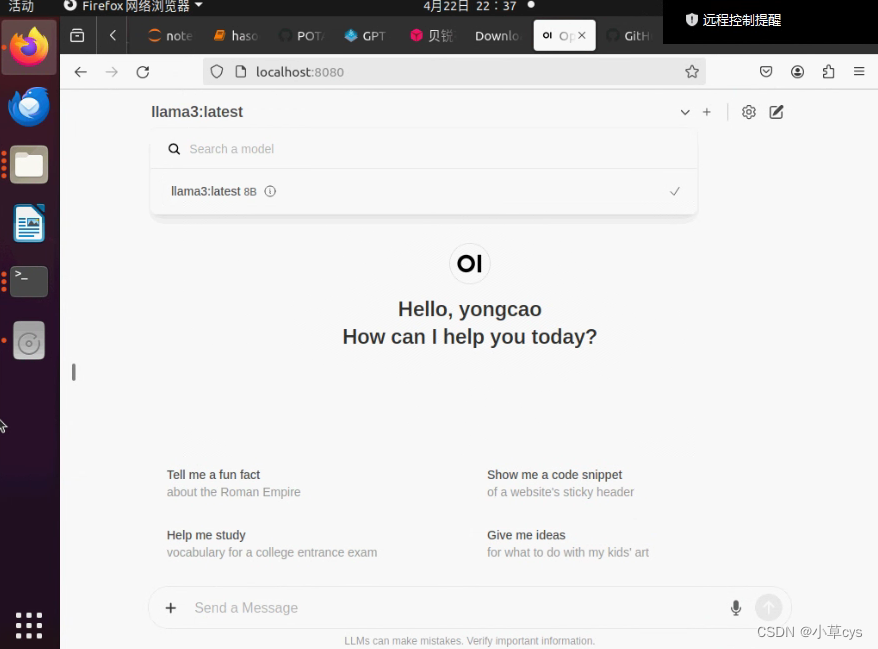

出现下面这个界面就是open webui启动成功了:

默认注册的第一个用户是管理员

如果llama3出不来,那么把open webui停掉删掉,使用这个命令,第一句是停掉,第二句命令是删掉container:

docker stop open-webui

docker rm open-webui

ollama先执行,不要stop

重新执行这句命令,就ok了

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/548080

推荐阅读

相关标签