- 1自然语言处理中的情感分析:技术与应用

- 22023年如何面试大厂?分享阿里、美团、滴滴Java岗面试真题_滴滴出行java面试题

- 3【Spring Boot】使用Websocket实现点对点通信_springboot @sendtouser

- 429.云原生KubeSphere服务网格实战之Istio安装配置_kubesphere安装istio

- 5【Git】git push时出现文件冲突的解决办法_git push 冲突

- 6webservice中常用注解--------------------@WebService @WebMethod

- 7锁相环技术原理及FPGA实现(第二章2.3)_quartus中altfp_abs是什么

- 8python数据结构之字典(dict)——超详细_创建一个字典dic,初始化账号和密码,使用字典的特点,如果输入的账号、密码与di

- 9【C语言三种自定义类型】_c语言当中用户自定义的类型

- 10讯飞语音识别_清晰识别多人混叠的对话!科大讯飞语音识别技术再攀新高

Lobechat 的基本使用流程_lobechat + ollama

赞

踩

一、安装

下载lobechart的页面代码

$ git clone https://github.com/lobehub/lobe-chat.git

$ cd lobe-chat

$ pnpm install

$ pnpm run dev

- 1

- 2

- 3

- 4

注意:node环境要18以上

二、使用本地模型

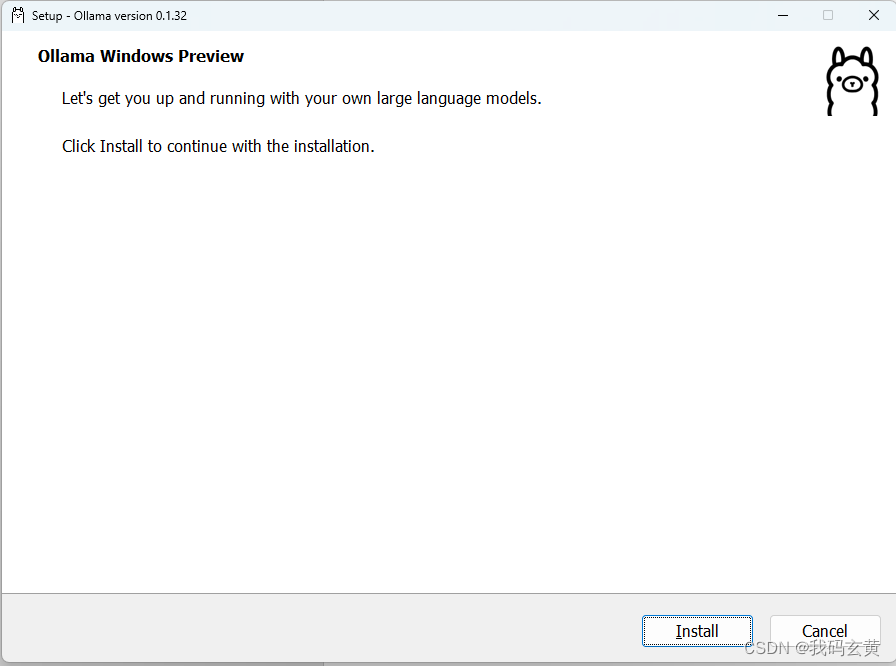

1.安装ollama

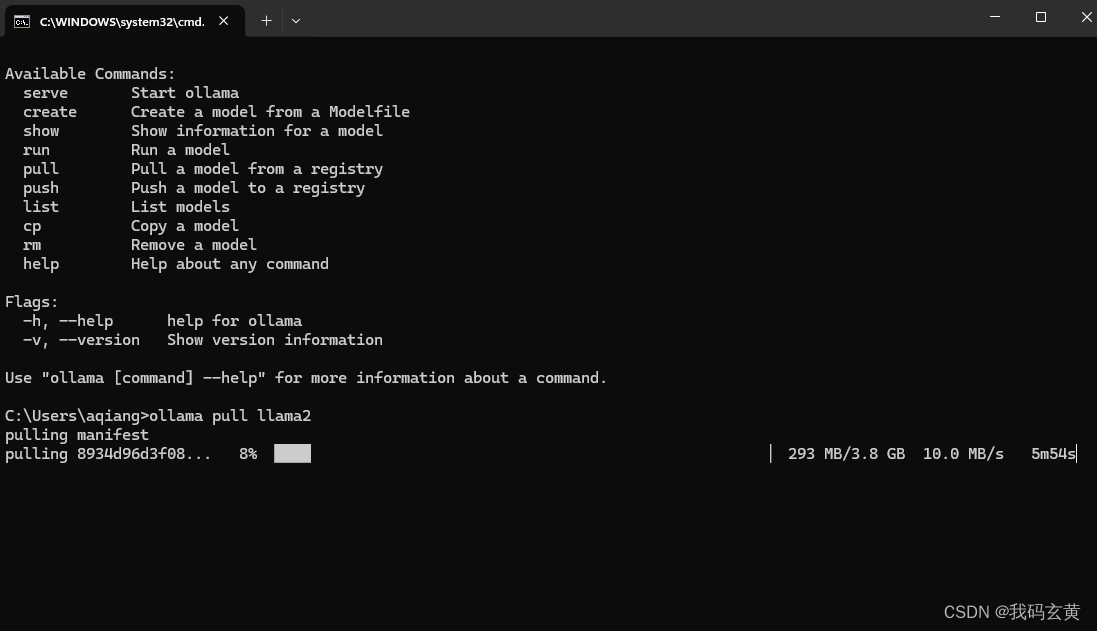

2.通过ollama 下载本地模型 llama2(选择合适的本地模型)

Llama 2:这是一个预训练的大型语言模型,具有7B、13B和70B三种不同规模的模型。Llama 2增加了预训练语料,上下文长度从2048提升到4096,使得模型能够理解和生成更长的文本。

OpenHermes:这个模型专注于代码生成和编程任务,适合用于软件开发和脚本编写等场景。

Solar:这是一个基于Llama 2的微调版本,专为对话场景优化。Solar在安全性和有用性方面进行了人工评估和改进,旨在成为封闭源模型的有效替代品。

Qwen:7B:这是一个中文微调过的模型,特别适合处理中文文本。它需要至少8GB的内存进行推理,推荐配备16GB以流畅运行。

ollama pull llama2

- 1

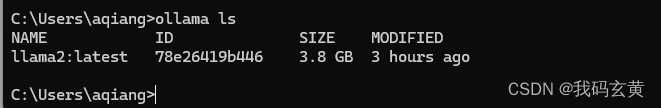

Ollama ls

- 1

进入lobe-chat目录

# 修改ollama配置

OLLAMA_PROXY_URL=http://127.0.0.1:11434/v1

OLLAMA_MODEL_LIST=llama2

- 1

- 2

- 3

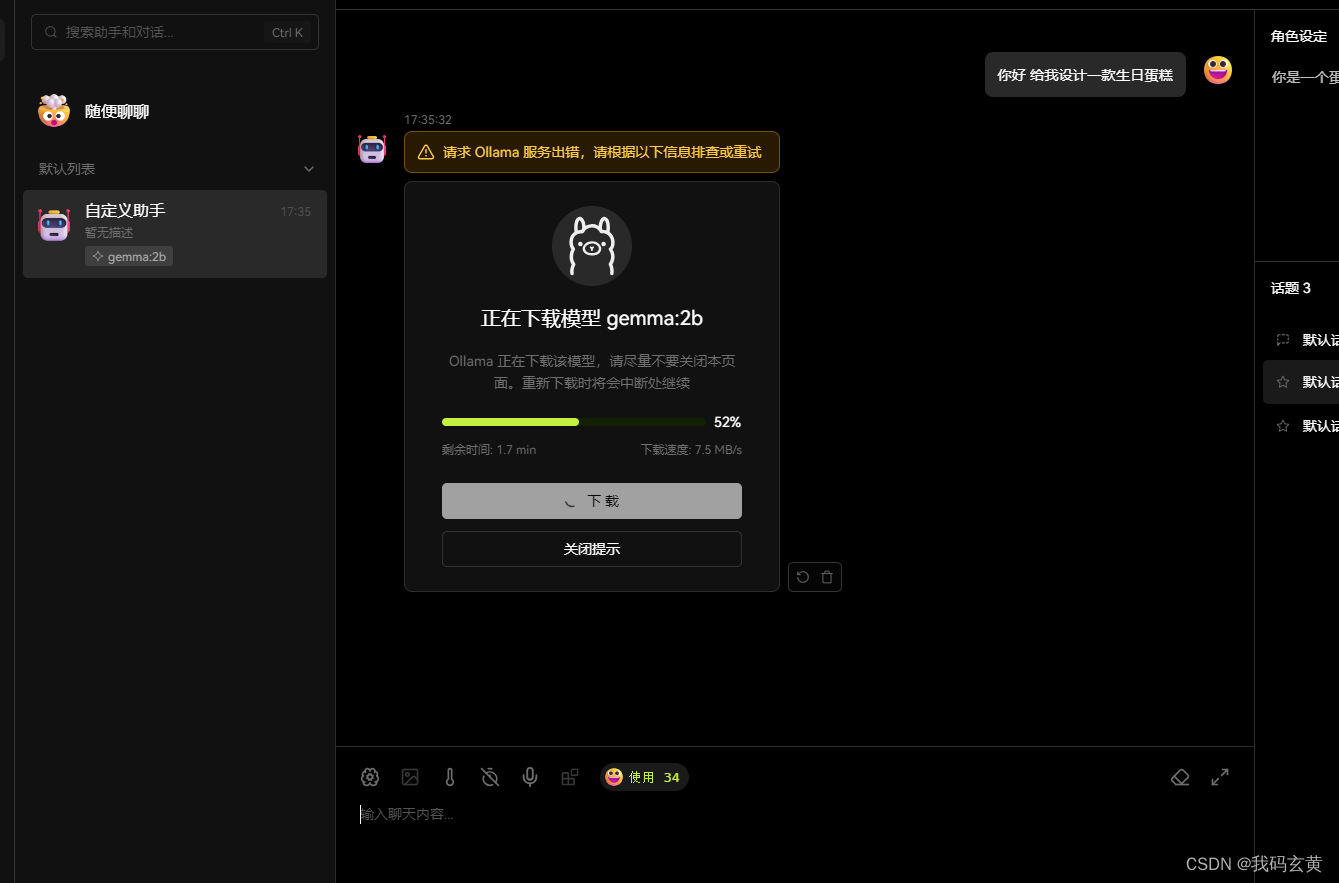

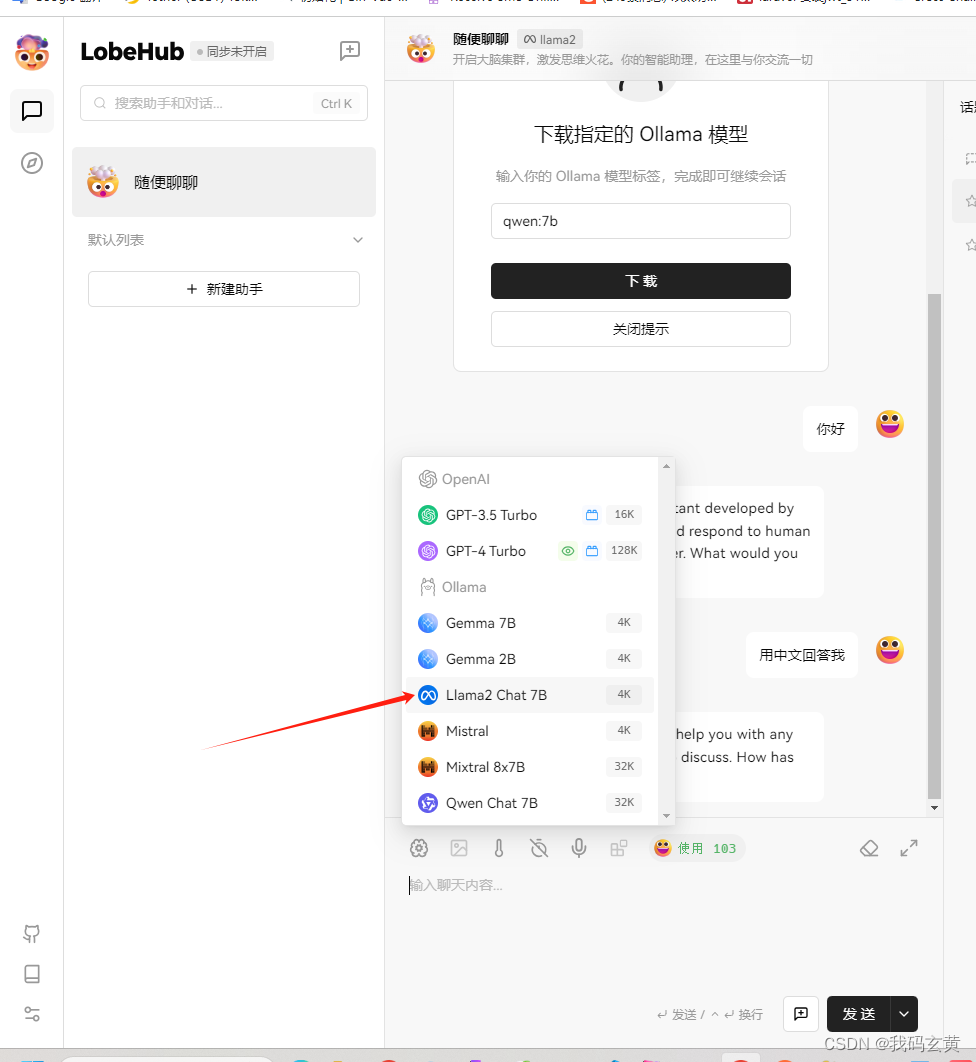

然后进入lobechat主界面,选择我们刚刚下载的llama2模型(也可选择别的)

直接下载就可以

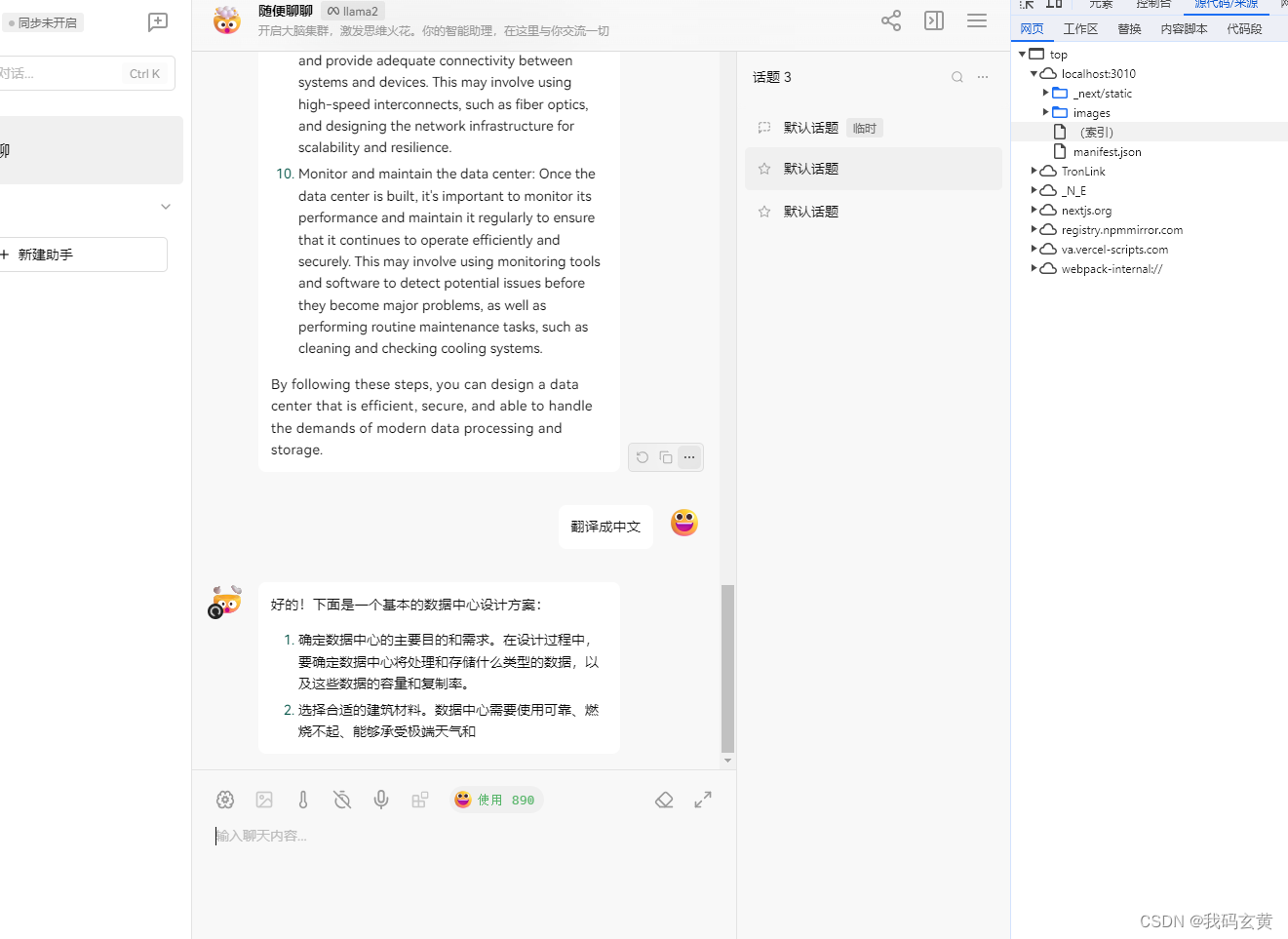

开始问答

本地模型运用就完毕。

三、插件:

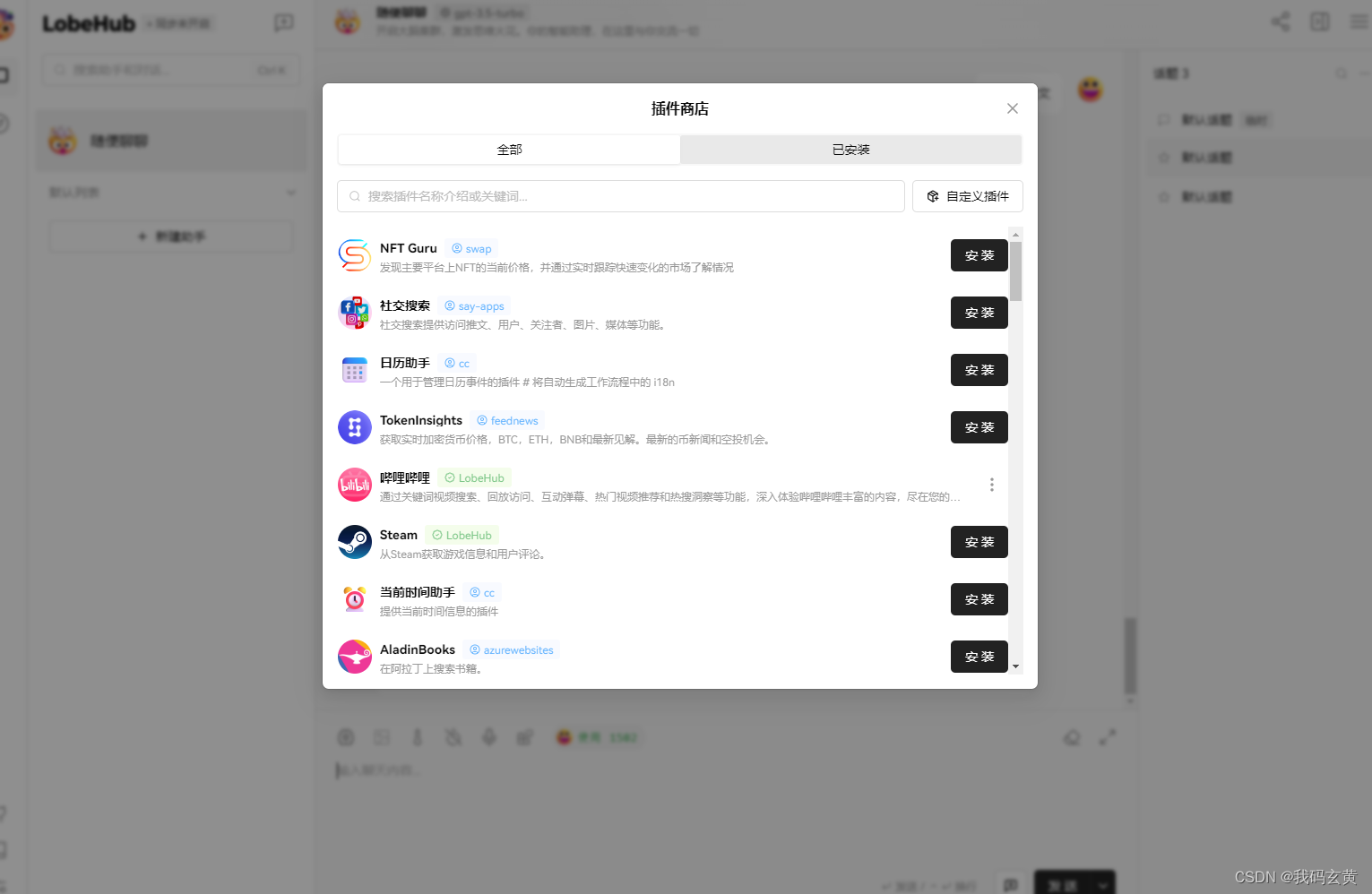

我下载了一个哔哩哔哩插件,可以获取第三方相应的信息

通过利用插件,LobeChat 的助手们能够实现实时信息的获取和处理,例如搜索网络信息,为用户提供即时且相关的资讯。

此外,这些插件不仅局限于新闻聚合,还可以扩展到其他实用的功能,如快速检索文档、生成图片、获取 Bilibili 、Steam 等各种平台数据,以及与其他各式各样的第三方服务交互。

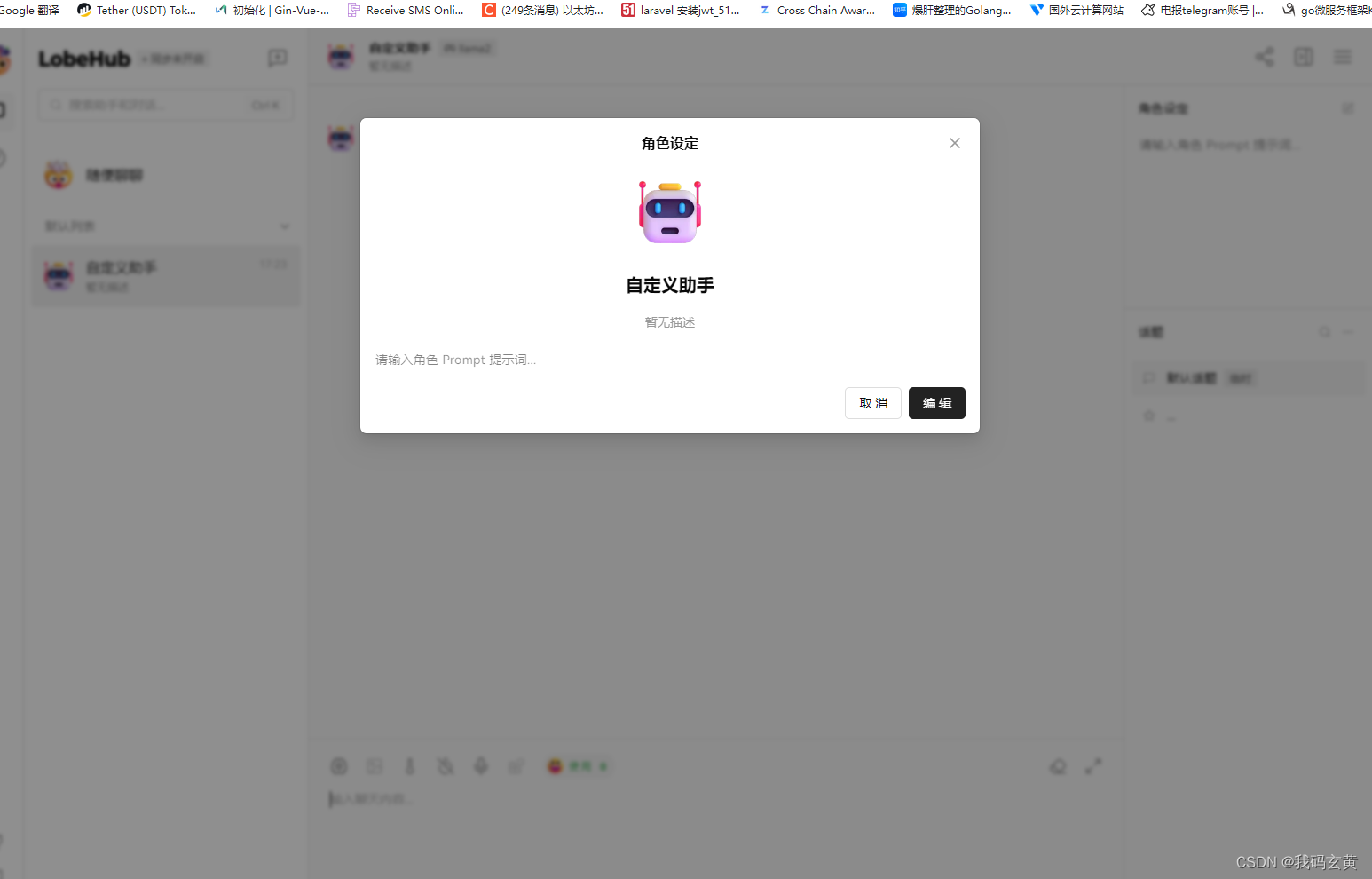

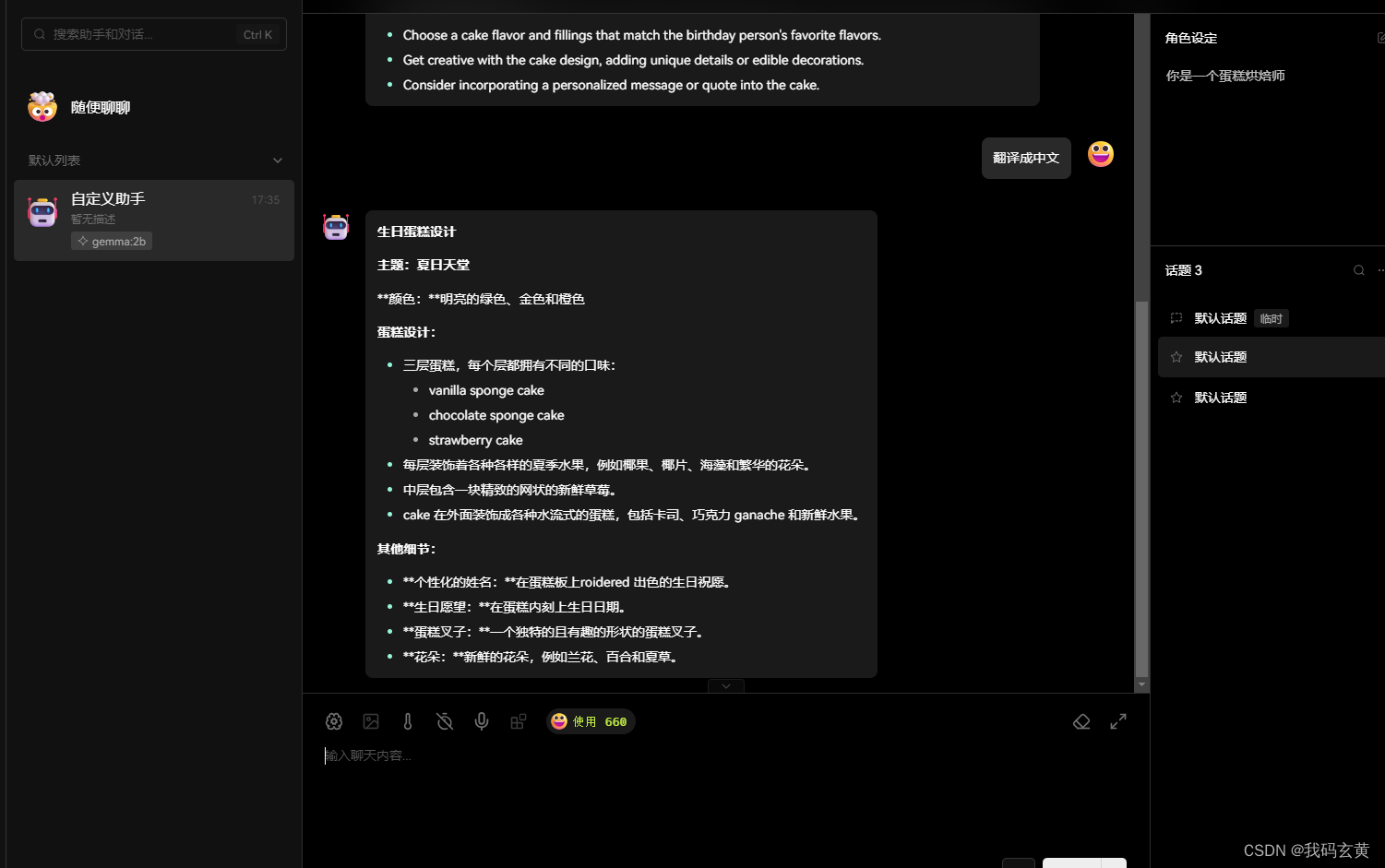

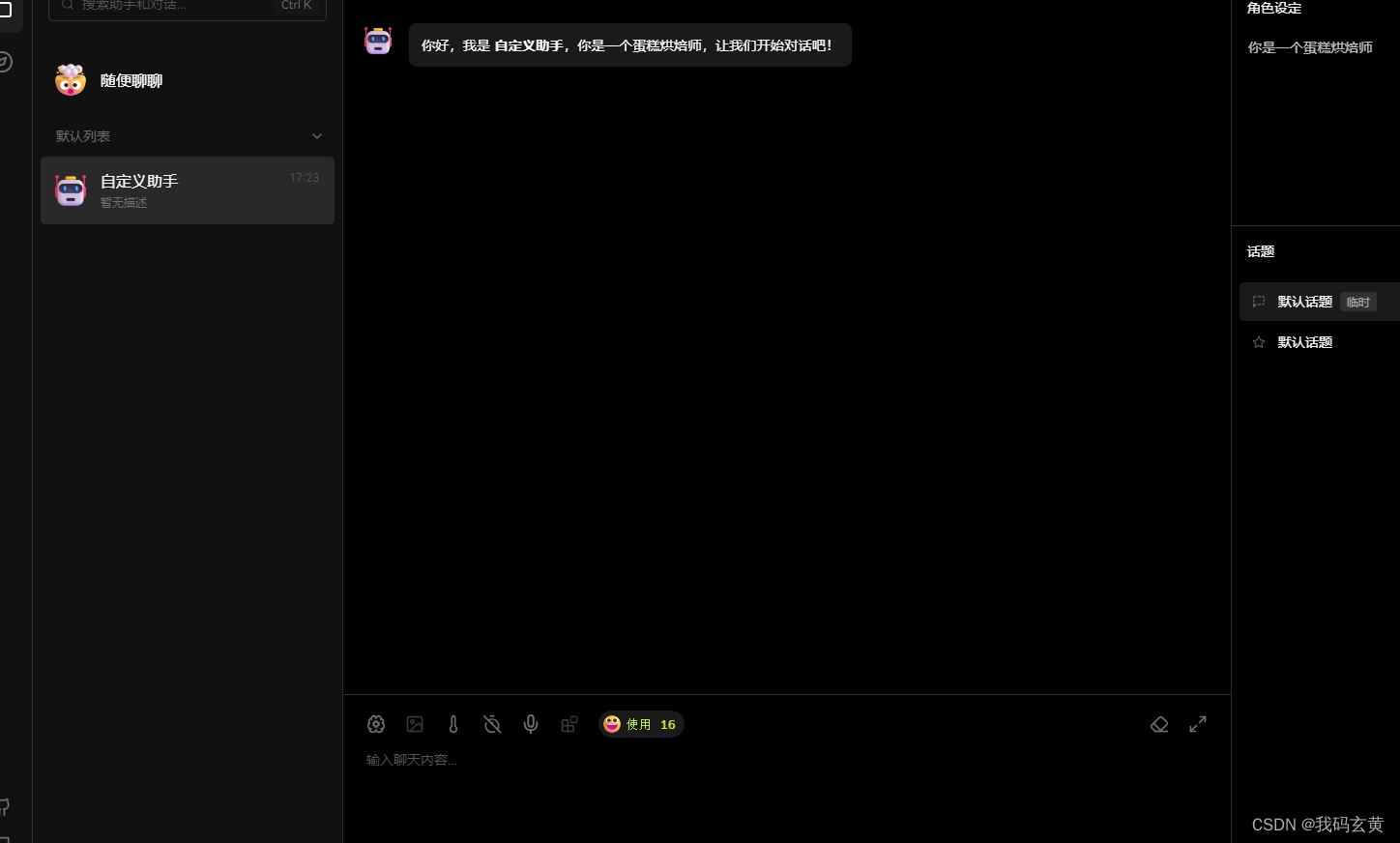

四、助手市场

设定角色,可以给每次的对话设定相应角色,这样大模型在聊天的时候能够更好的结合角色去问答。

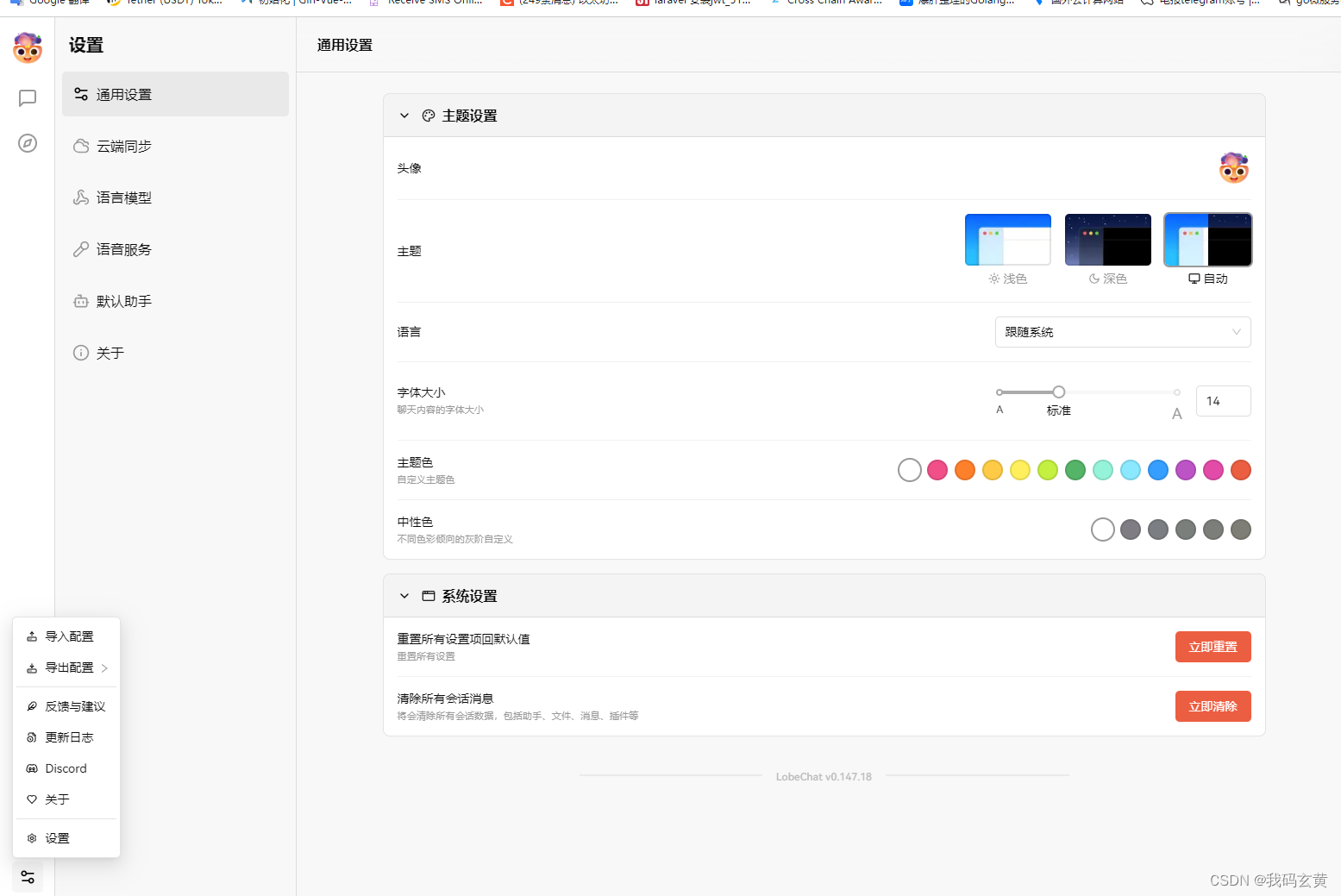

五、lobechat通用设置

可以设置界面外观,配置助手

六、总结

lobochat 是一个现代化设计的开源 ChatGPT/LLMs 聊天应用与开发框架

支持语音合成、多模态、可扩展的插件系统

除开本地模型还支持gpt-4-vision gpt-3.5openai模型

支持视觉识别的模型,这是一个具备视觉识别能力的多模态应用。 用户可以轻松上传图片或者拖拽图片到对话框中,助手将能够识别图片内容,并在此基础上进行智能对话,构建更智能、更多元化的聊天场景。