热门标签

热门文章

- 1单链表基本操作(2)_6-1 单链表

- 2Python学习干货,如何用Python进行数据分析?_在熟悉各种典型的数据预处理方法原理的基础上,选择数据分析工具python语言进行数

- 342. 【农产品溯源项目前后端Demo】后端-区块链连接服务_区块链网络 连接前端连还是后端连

- 4Python制作【大麦网】抢票程序,看演唱会再也不怕没票了_python 操控苹果手机抢大麦网演唱会的票

- 5node【引入模块查找机制】_npm模块搜索

- 6(大数据静态处理demo)flume+hadoop+hive+sqoop+mysql

- 7mac上搭建鸿蒙开发环境(2024)_鸿蒙 mac

- 8Vue3项目运行Error: Cannot find module ‘vue-loader-v16/package.json‘问题处理_loader error 3

- 9如何解决“来自计算机网络的异常流量”_我们的系统检测到您的计算机网络中存在异常流量。请稍后重新发送请求。为什么会这

- 10可能是MacOS中最好用的集成开发工具-Xcode初学者(C/C++ 新生)教程_xcode 开发教程

当前位置: article > 正文

Grafana Prometheus 通过JMX监控kafka 【2023最新方式】_prometheus监控kafka

作者:盐析白兔 | 2024-05-31 12:55:28

赞

踩

prometheus监控kafka

第三方kafka exporter方案

目前网上关于使用Prometheus 监控kafka的大部分资料都是使用一个第三方的

kafka exporter,他的原理大概就是启动一个kafka客户端,获取kafka服务器的信息,然后提供一些metric接口供Prometheus使用,随意它能展示的监控信息比较有限,只有每个主题的分区数,每秒/分钟消息数,消费组的lag数。但是kafka本身的JMX有提供500+的监控信息可以进行监控,当然不是说这这么监控指标都很重要,相比kafka exporter直接使用JMX可监控的选项会更多。

Prometheus官方方案

Prometheus官方提供的jmx_exporter可以将JMX转换为Prometheus Metrics格式。

Prometheus JMX exporter使用方式选择

jmx_exporter提供两种用法:

- 一种是启动独立的进程。JVM 启动时指定参数,暴露 JMX 的 RMI 接口,JMX_Exporter 调用 RMI 获取 JVM 运行时状态数据,转换为 Prometheus metrics 格式,并暴露端口让 Prometheus 采集。

- 一种是JVM进程内启动,通过java agent的形式运行,进程内读取 JVM 运行时状态数据,转换为 Prometheus metrics 格式,并暴露端口让 Prometheus 采集。官方比较推荐使用这种方式。

使用JMX exporter监控kafka

在kafka-server-start.sh最上面添加下面的代码:

export KAFKA_OPTS="-javaagent:/opt/kafka_2.11-1.1.0/bin/jmx_prometheus_javaagent-0.19.0.jar=9990:/opt/kafka_2.11-1.1.0/bin/kafka-jmx.yml"

- 1

jmx_exporter官网下载最新的jmx_prometheus_javaagent-0.19.0.jar包。

kafka-jmx.yml

lowercaseOutputName: true

rules:

# Special cases and very specific rules

- pattern : kafka.server<type=(.+), name=(.+), clientId=(.+), topic=(.+), partition=(.*)><>Value

name: kafka_server_$1_$2

type: GAUGE

labels:

clientId: "$3"

topic: "$4"

partition: "$5"

- pattern : kafka.server<type=(.+), name=(.+), clientId=(.+), brokerHost=(.+), brokerPort=(.+)><>Value

name: kafka_server_$1_$2

type: GAUGE

labels:

clientId: "$3"

broker: "$4:$5"

- pattern : kafka.coordinator.(\w+)<type=(.+), name=(.+)><>Value

name: kafka_coordinator_$1_$2_$3

type: GAUGE

# Generic per-second counters with 0-2 key/value pairs

- pattern: kafka.(\w+)<type=(.+), name=(.+)PerSec\w*, (.+)=(.+), (.+)=(.+)><>Count

name: kafka_$1_$2_$3_total

type: COUNTER

labels:

"$4": "$5"

"$6": "$7"

- pattern: kafka.(\w+)<type=(.+), name=(.+)PerSec\w*, (.+)=(.+)><>Count

name: kafka_$1_$2_$3_total

type: COUNTER

labels:

"$4": "$5"

- pattern: kafka.(\w+)<type=(.+), name=(.+)PerSec\w*><>Count

name: kafka_$1_$2_$3_total

type: COUNTER

- pattern: kafka.server<type=(.+), client-id=(.+)><>([a-z-]+)

name: kafka_server_quota_$3

type: GAUGE

labels:

resource: "$1"

clientId: "$2"

- pattern: kafka.server<type=(.+), user=(.+), client-id=(.+)><>([a-z-]+)

name: kafka_server_quota_$4

type: GAUGE

labels:

resource: "$1"

user: "$2"

clientId: "$3"

# Generic gauges with 0-2 key/value pairs

- pattern: kafka.(\w+)<type=(.+), name=(.+), (.+)=(.+), (.+)=(.+)><>Value

name: kafka_$1_$2_$3

type: GAUGE

labels:

"$4": "$5"

"$6": "$7"

- pattern: kafka.(\w+)<type=(.+), name=(.+), (.+)=(.+)><>Value

name: kafka_$1_$2_$3

type: GAUGE

labels:

"$4": "$5"

- pattern: kafka.(\w+)<type=(.+), name=(.+)><>Value

name: kafka_$1_$2_$3

type: GAUGE

# Emulate Prometheus 'Summary' metrics for the exported 'Histogram's.

#

# Note that these are missing the '_sum' metric!

- pattern: kafka.(\w+)<type=(.+), name=(.+), (.+)=(.+), (.+)=(.+)><>Count

name: kafka_$1_$2_$3_count

type: COUNTER

labels:

"$4": "$5"

"$6": "$7"

- pattern: kafka.(\w+)<type=(.+), name=(.+), (.+)=(.*), (.+)=(.+)><>(\d+)thPercentile

name: kafka_$1_$2_$3

type: GAUGE

labels:

"$4": "$5"

"$6": "$7"

quantile: "0.$8"

- pattern: kafka.(\w+)<type=(.+), name=(.+), (.+)=(.+)><>Count

name: kafka_$1_$2_$3_count

type: COUNTER

labels:

"$4": "$5"

- pattern: kafka.(\w+)<type=(.+), name=(.+), (.+)=(.*)><>(\d+)thPercentile

name: kafka_$1_$2_$3

type: GAUGE

labels:

"$4": "$5"

quantile: "0.$6"

- pattern: kafka.(\w+)<type=(.+), name=(.+)><>Count

name: kafka_$1_$2_$3_count

type: COUNTER

- pattern: kafka.(\w+)<type=(.+), name=(.+)><>(\d+)thPercentile

name: kafka_$1_$2_$3

type: GAUGE

labels:

quantile: "0.$4"

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

配置好kafka-server-start.sh后还需要重启kafka。

Prometheus配置

在Prometheus的prometheus.yml添加如下内容。注意端口号为KAFKA_OPTS配置的端口。

- job_name: "kafka_jmx"

metrics_path: /metrics

static_configs:

- targets: ['192.168.249.1:9990','192.168.249.2:9990','192.168.249.3:9990']

- 1

- 2

- 3

- 4

配置完成后重新加载Prometheus配置文件就可以了。

grafana 配置

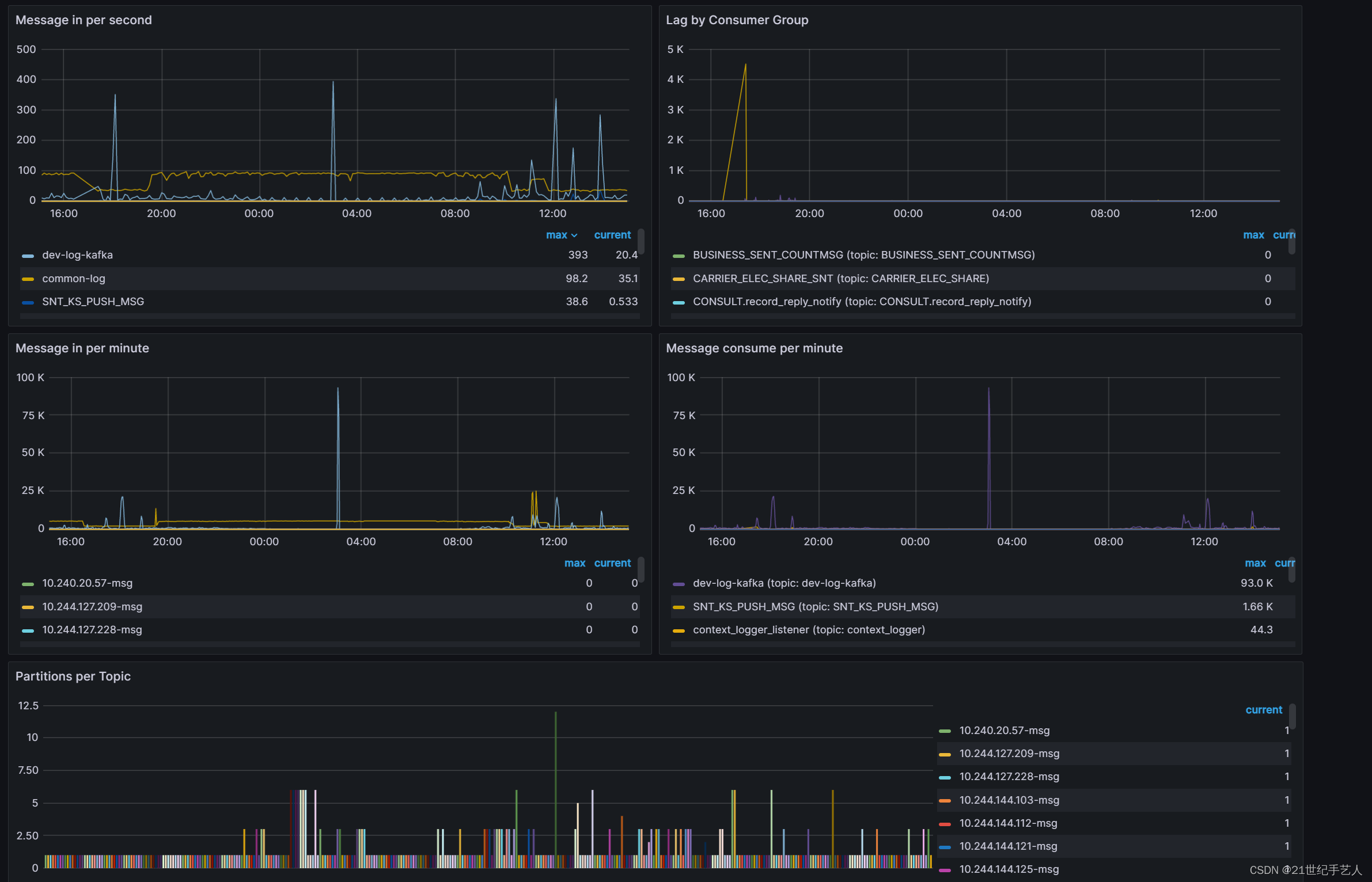

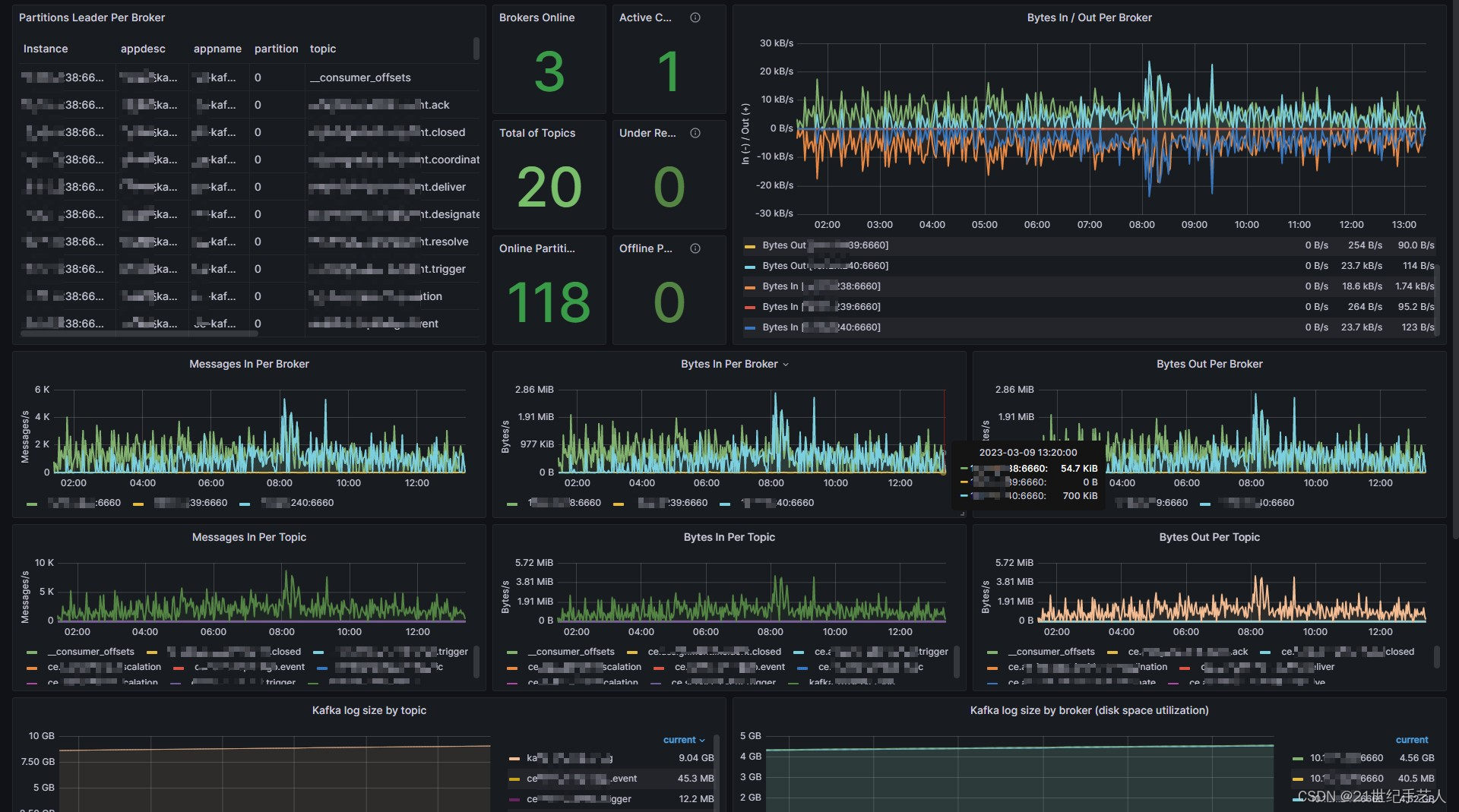

通过上面配置后,可以在grafan中找到对应的面板直接来用。

https://grafana.com/grafana/dashboards/18276-kafka-dashboard/

- 1

效果

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/652439

推荐阅读

相关标签