热门标签

热门文章

- 1ARM64 SMP多核启动详解2(psci)_cpu psci

- 2数据仓库搭建_数仓的构建

- 3nginx:HTTP Error 404. The requested resource is not found.

- 4LimeSDR实验教程(13) LTE基站、终端、核心网 (srsLTE nextepc)_lime sdr 解调lte信号

- 5目标检测中的预测框回归优化之IOU、GIOU、DIOU、CIOU和EIOU_ciou论文

- 6大模型训练基本流程讨论_大模型训练流程

- 7机器学习-自注意力机制Self/Intra Attention简介_机器学习self attention

- 8百度Comate:你的智能编程助手,让代码编写更高效_comate针对哪些痛点

- 9【方案-分析】流程编排技术选型_流程编排引擎 技术选型

- 10初探 Spring Boot Starter Security:构建更安全的Spring Boot应用_spring-boot-starter-security

当前位置: article > 正文

Co-Attention、Self-Attention 和 Bi-Attention

作者:盐析白兔 | 2024-06-14 19:54:27

赞

踩

co-attention

Co-Attention、Self-Attention 和 Bi-Attention 是在自然语言处理和计算机视觉等领域中常见的注意力机制的变种,它们有一些区别:

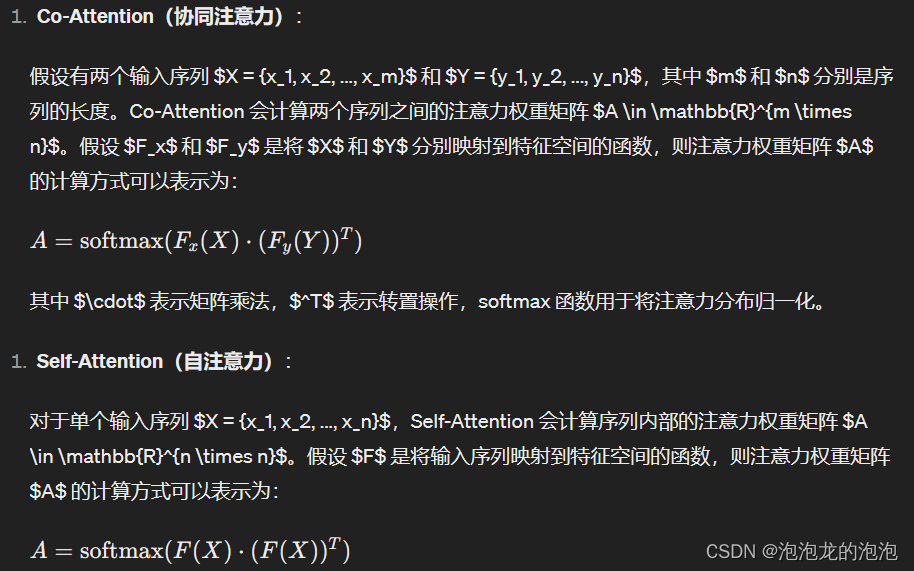

Co-Attention(协同注意力):

Co-Attention 是一种注意力机制,用于在两个不同的输入序列之间建立关联。它能够同时关注到两个序列中的相关元素,并学习它们之间的交互关系。在自然语言处理中,常用于将图像与文本建立联系,例如在图像描述生成任务中,将图像和对应的文字描述进行关联。

Self-Attention(自注意力):

Self-Attention 是一种注意力机制,用于在单个输入序列内建立关联。它允许输入序列中的不同位置之间相互交互,从而捕捉序列内部的长程依赖关系。Self-Attention 在诸如Transformer等模型中得到了广泛应用,用于编码输入序列的表示。

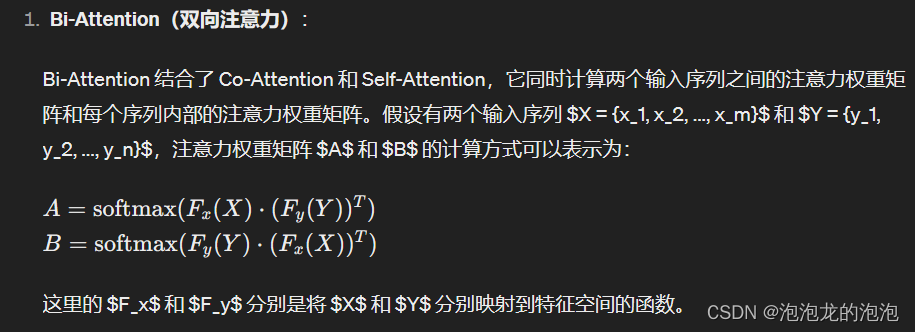

Bi-Attention(双向注意力):

Bi-Attention 是一种结合了Co-Attention和Self-Attention的方法,用于同时建立两个输入序列之间的关联以及单个序列内部的关联。它既考虑到了输入序列之间的交互,又考虑到了序列内部的关联。Bi-Attention 常用于双向的任务,例如自然语言推理和问答系统等。

总的来说,这三种注意力机制在注意力的应用范围和机制上有所不同,但都是用来捕捉序列之间或序列内部的关联信息。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/719412

推荐阅读

相关标签