热门标签

热门文章

- 1mssql 数据库审计账户_SQL Server 创建服务器和数据库级别审计

- 2linux进程间通讯指南-打通IPC大门,高效沟通无阻_linux ipc通讯的最好方式

- 3Uniapp启动编译报错问题_uniapp parsing failed at character position 14 nea

- 4hiveserver2连接数与hivemetastore连接数详解_查看hivemetastore连接数

- 5unity 用LineRender画四边形并测面积

- 6【信息安全】DES加密算法

- 7深度学习环境完整安装(Python+Pycharm+Pytorch cpu版)_深度学习环境安装

- 8大语言模型原理与工程实践:全参数微调

- 9[677]python操作SQLite数据库_python sqliteutil

- 10微软Edge浏览器搜索引擎切换全攻略_edge浏览器修改默认搜索引擎

当前位置: article > 正文

边缘计算 - 在移动设备上部署深度学习模型的思路与注意点_在边缘设备上部署深度学习模型

作者:盐析白兔 | 2024-07-13 00:09:33

赞

踩

在边缘设备上部署深度学习模型

大家在新闻当中见到越来越多的令人振奋的人工智能相关的应用新闻。

- 『人工智能在围棋中击败了人类!』

- 『基于神经网络的精准天气预报』

- 『会写作创作的AI』

- 『会说话的蒙娜丽莎绘画』

- 『绘画艺术创作以假乱真的AI』

尽管新闻很炫酷甚至令人惊叹不已,但 AI

的应用与现实世界还有一些差距,核心的原因之一是它们的规模。为了取得更好的效果,现代AI神经网络模型会使用更大数据集、更多的模型参数,但这样一方面训练它们变得让普通人遥不可及(需要特定的昂贵物理资源和大量的电力资源等),另外一方面使得实际推理应用也变得复杂(无法在小型设备上部署,且推理时间很长)。

如果要让 AI

能覆盖现实生活中的场景问题,我们希望可以在资源有限的设备上运行的更小的模型。另外一方面,随着广受关注的安全和隐私问题,我们也希望模型可以部署安装在本地设备上,而不是向服务器传输任何数据进行请求。

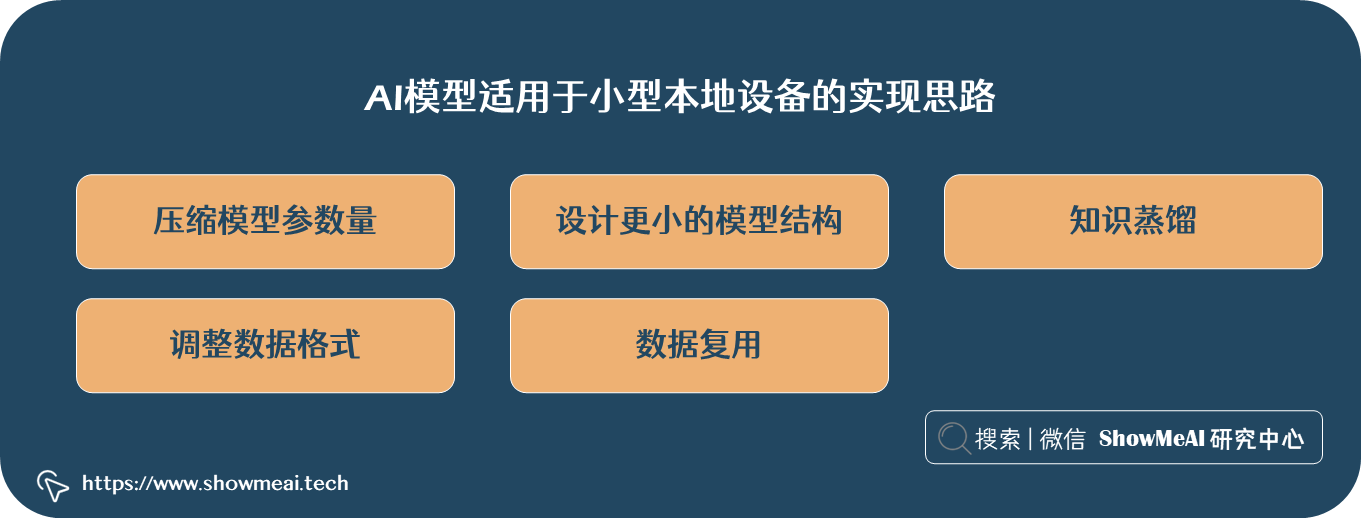

接下来 ShowMeAI 给大家介绍和总结使 AI

模型能适用于小型本地设备上的方法技术,实现思路包括:压缩模型参数量 、设计更小的模型结构 、知识蒸馏 、调整数据格式

、数据复用 等。我们还会介绍到移动小处理设备的类型,适用移动设备的模型框架等。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/816728

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/816728

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。