热门标签

热门文章

- 1三个月华为od工作感受:关于转正,身份和适合谁_华为od岗位有必要去吗

- 2图论之各种找环

- 311 插入排序和希尔排序

- 4【C语言】利用指针实现a,b数值交换(swap),指针程序易错改正(程序注释详细)_c语言指针交换变量a和b的值

- 5JS深拷贝、浅拷贝 和 使用场景 详解_js 深拷贝

- 6cloudflare入门之附加 cookie___cf_bm

- 7Pycharm配置PyQt5的三个External Tools—Qt Designer、pyUIC、pyRCC_linux下pycharm外部工具qt

- 8java输错重新输入_java程序在dos界面运行时输入错误后返回重新输入的方法

- 9字节跳动测试工程师面试总结2019.7.17_将m元钱,随机放入n个红包中

- 10virt-install工具创建虚拟机命令介绍(详细)_virtinstall创建虚拟机详细说明

当前位置: article > 正文

书生·浦语大模型实战营-学习笔记5

作者:盐析白兔 | 2024-02-15 20:06:50

赞

踩

书生·浦语大模型实战营-学习笔记5

LMDeploy 大模型量化部署实践

大模型部署背景

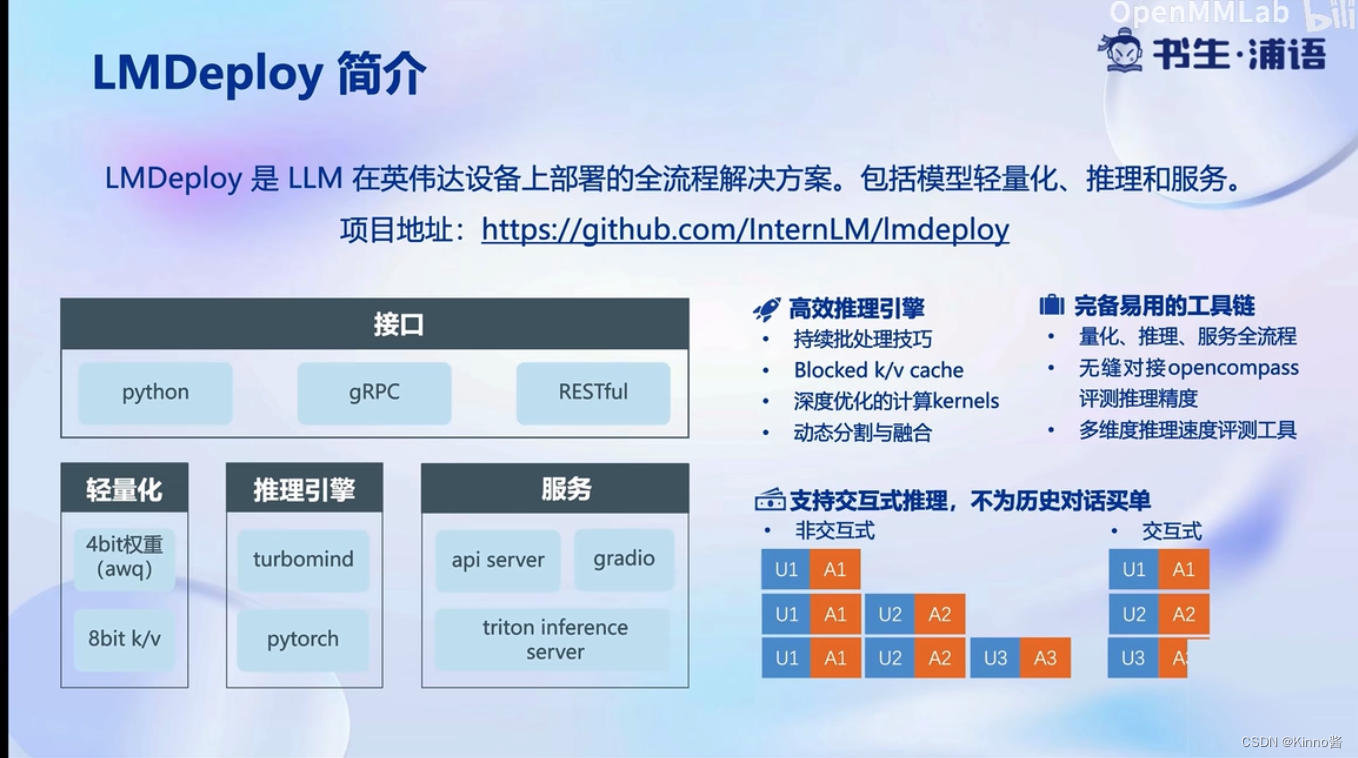

LMDeploy简介

轻量化、推理引擎、服务

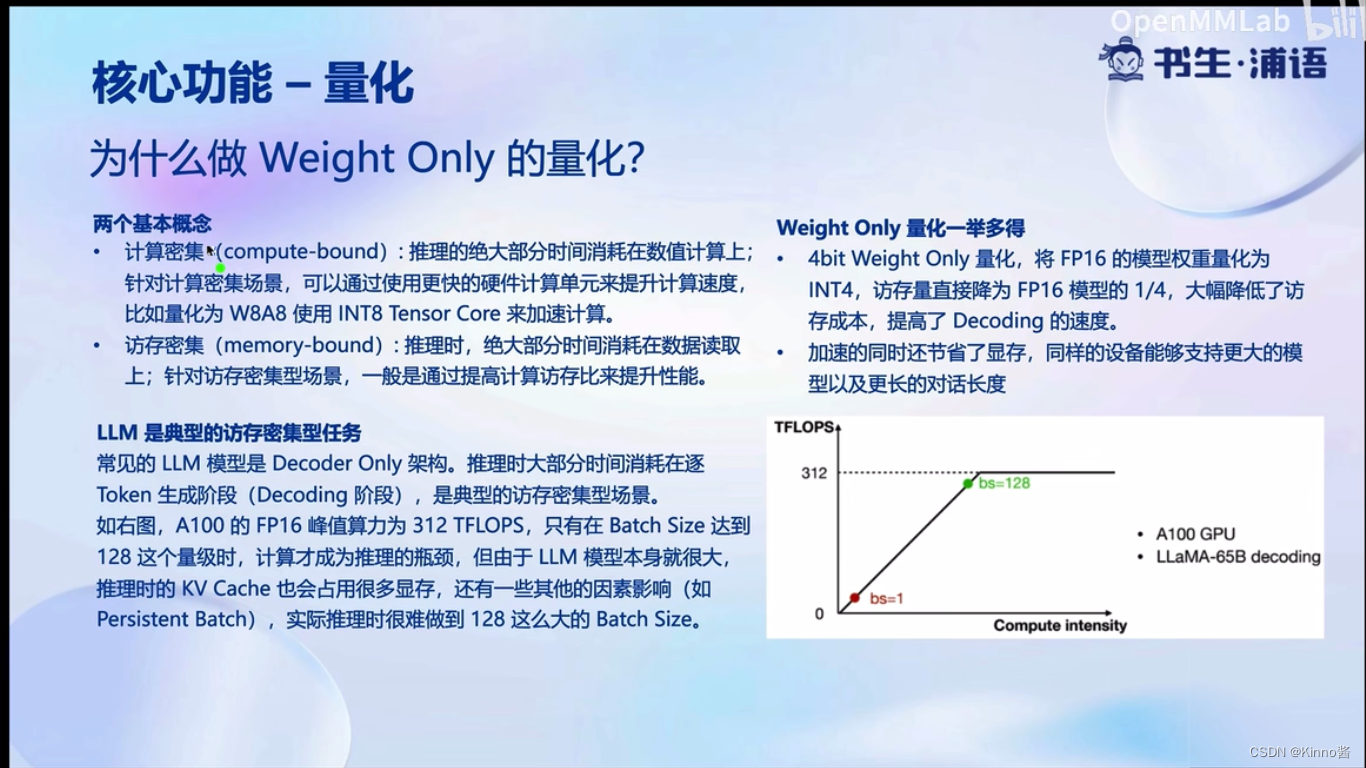

核心功能-量化

显存消耗变少了

大语言模型是典型的访存密集型任务,因为它是decoder-by-decoder

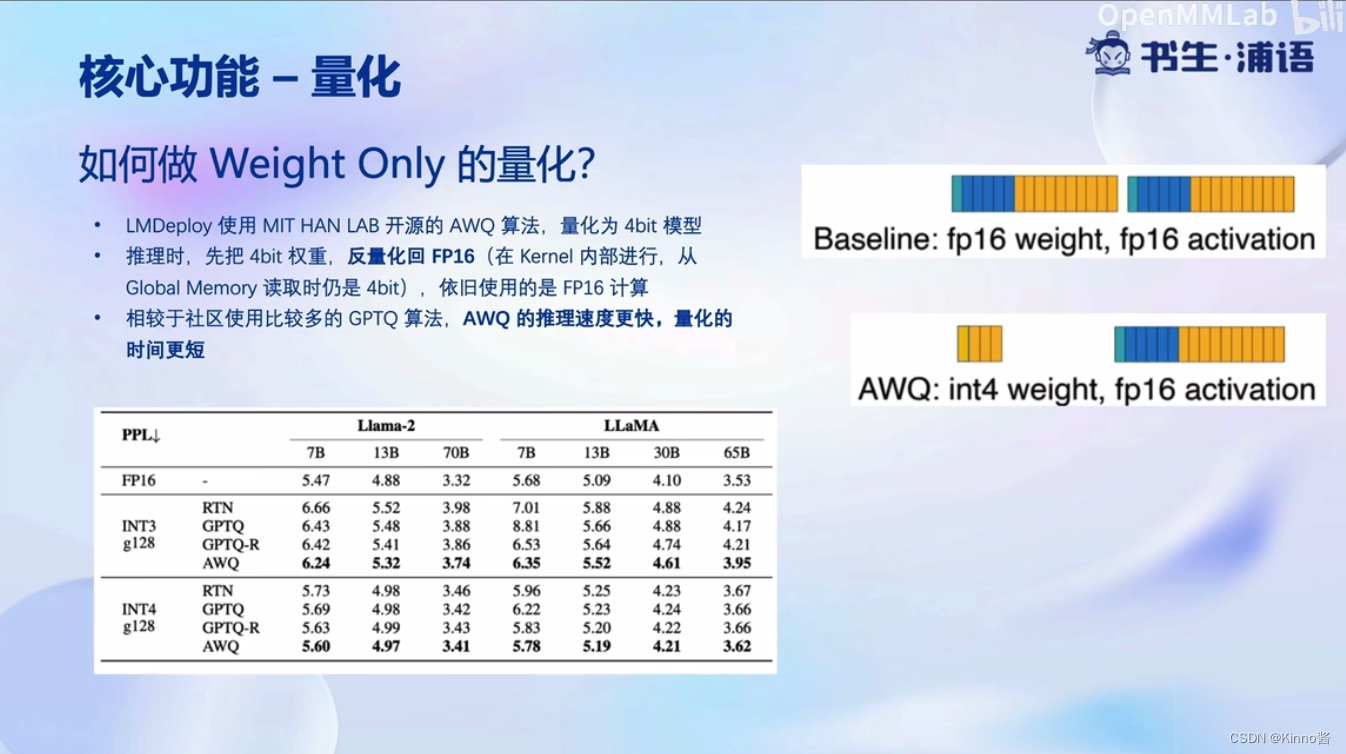

先把数据量化为INT4存起来,算的时候会反量化为FP16

AWQ算法:观察到模型在推理过程中,只有一小部分参数是重要的参数,这部分参数不量化,其他的参数量化,这样保留了显存,性能也不会下降多少

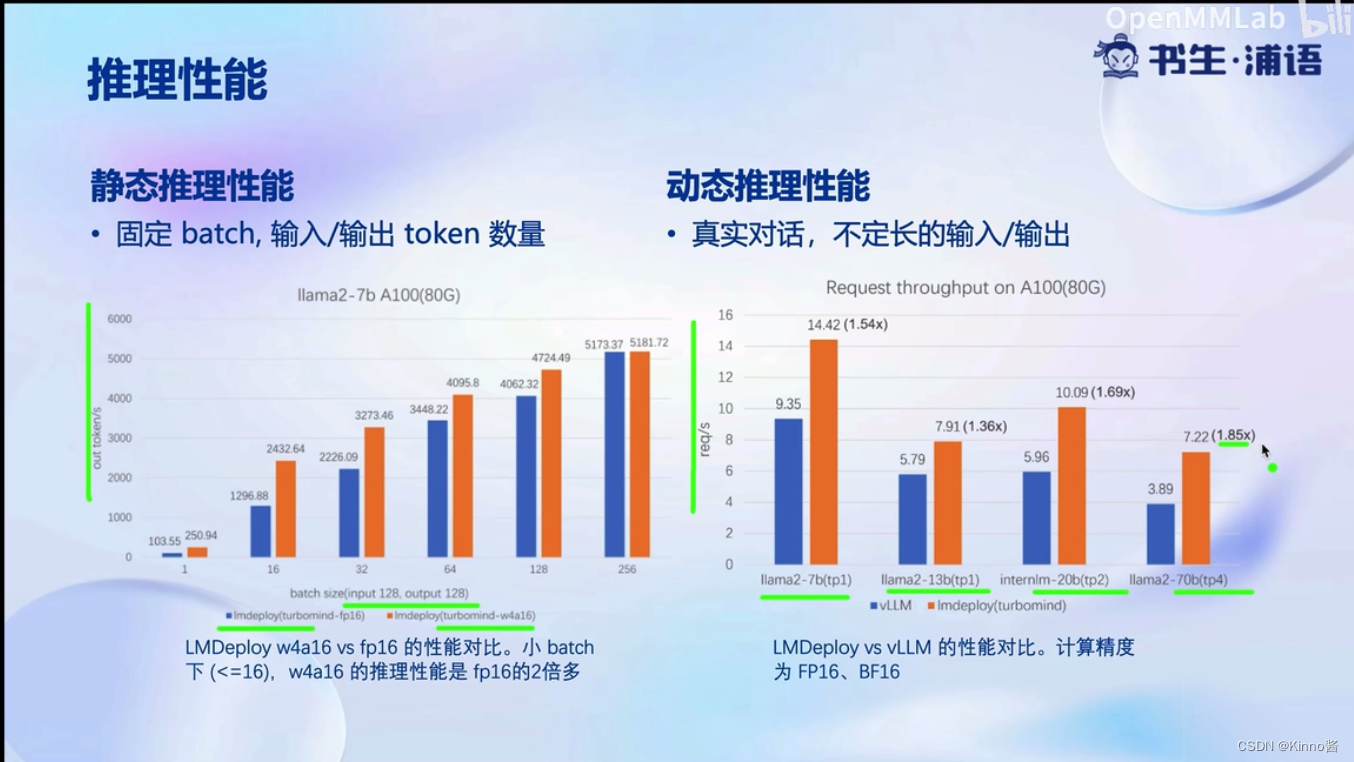

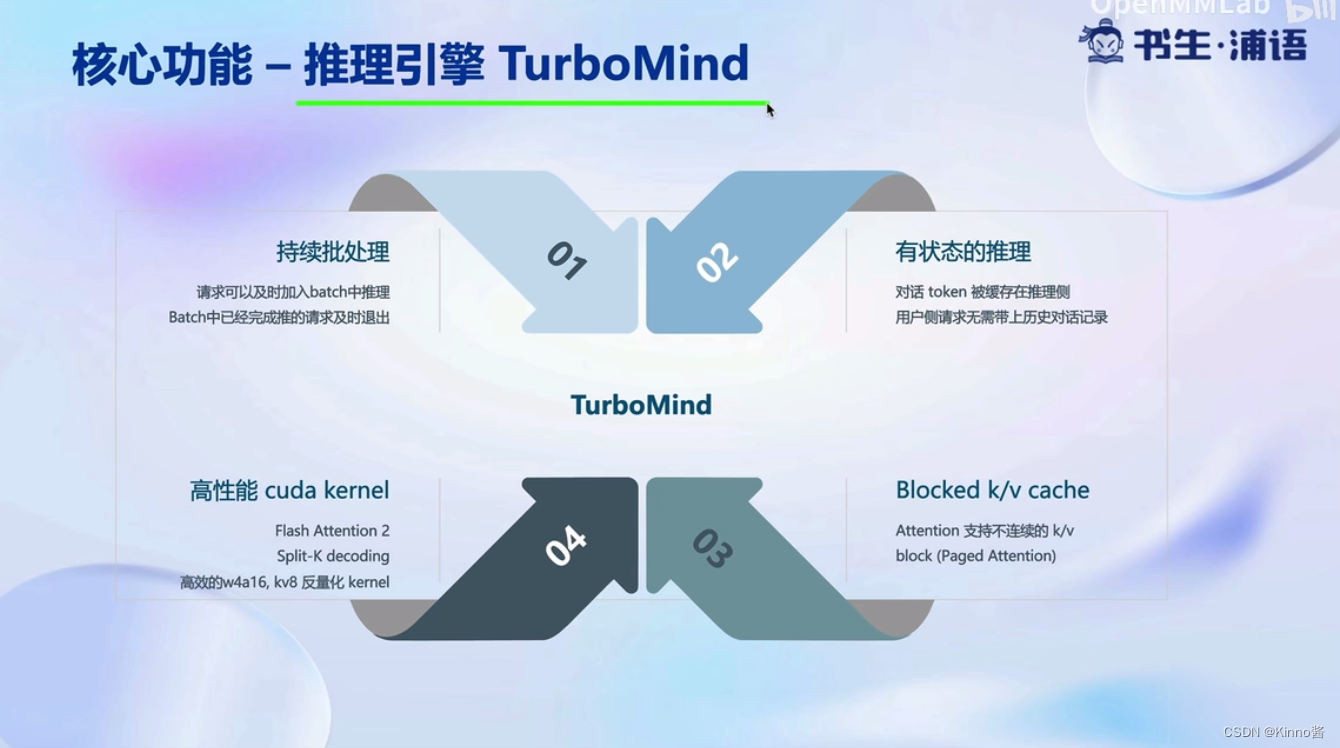

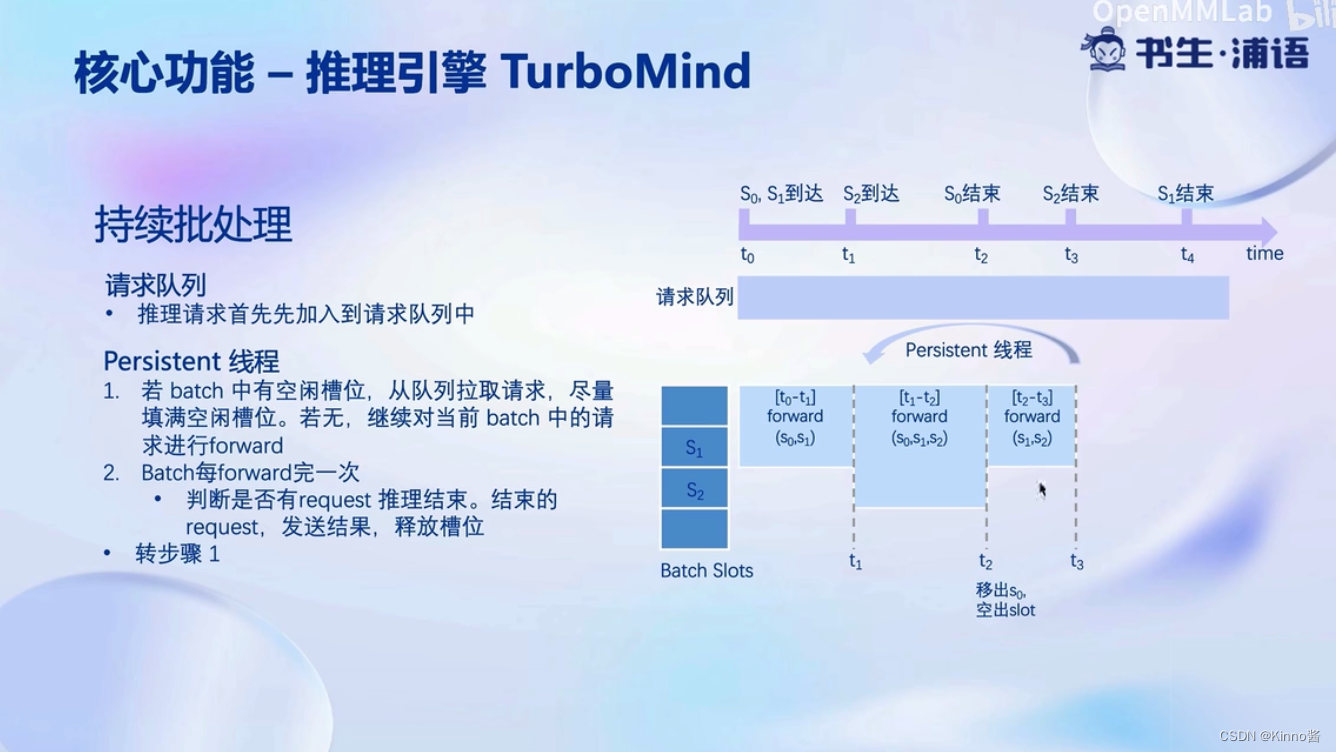

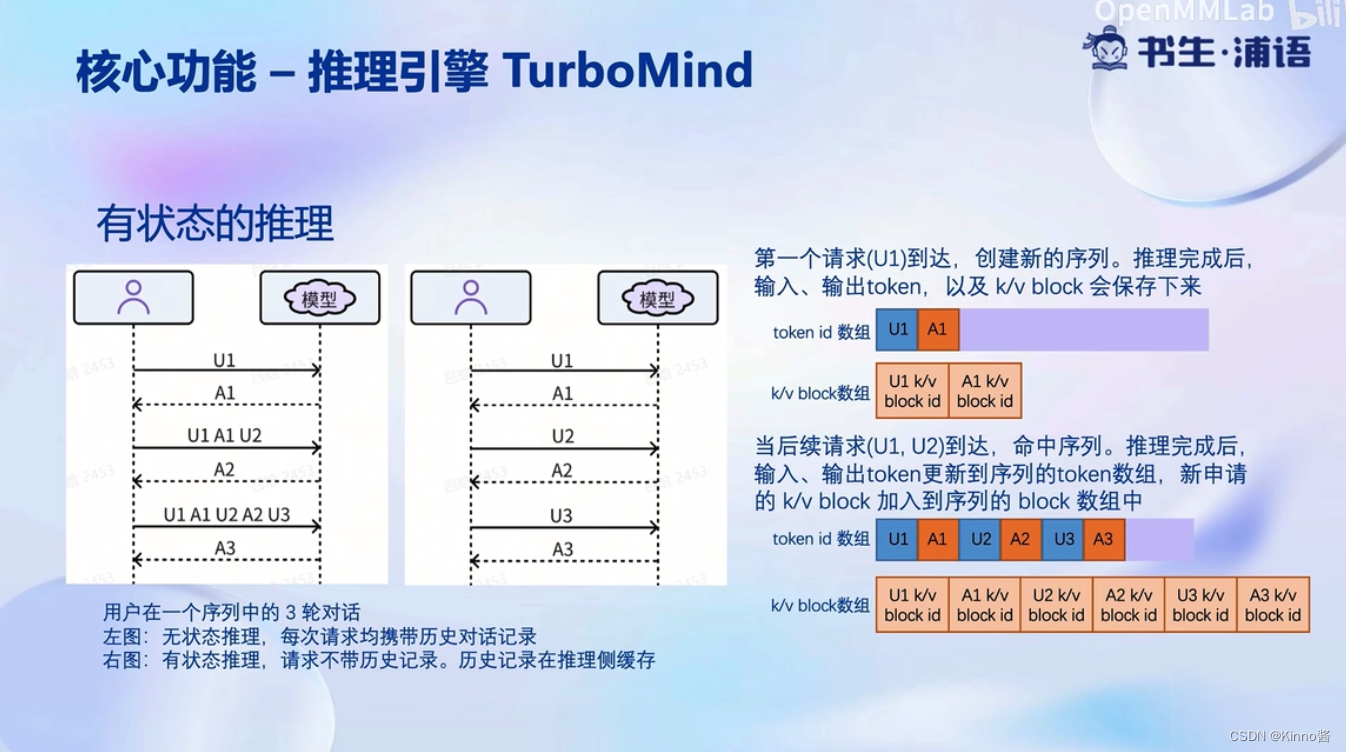

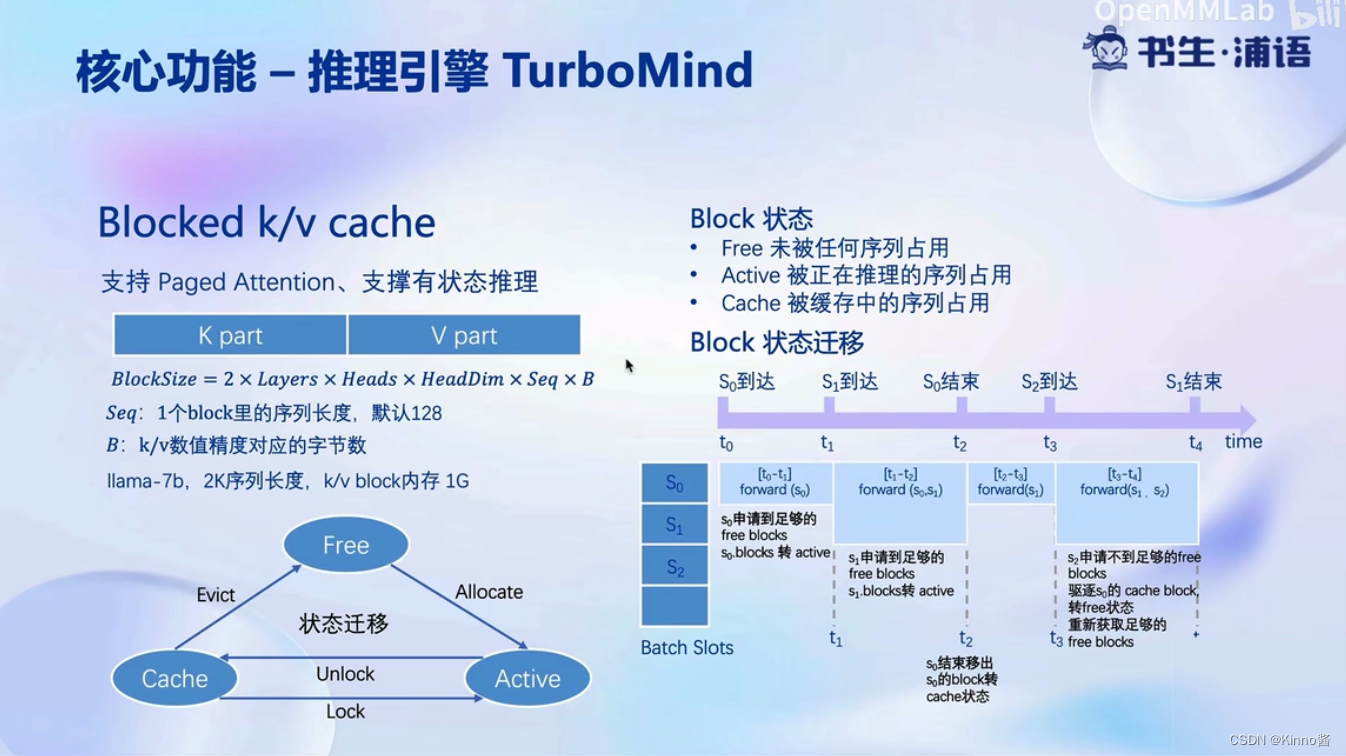

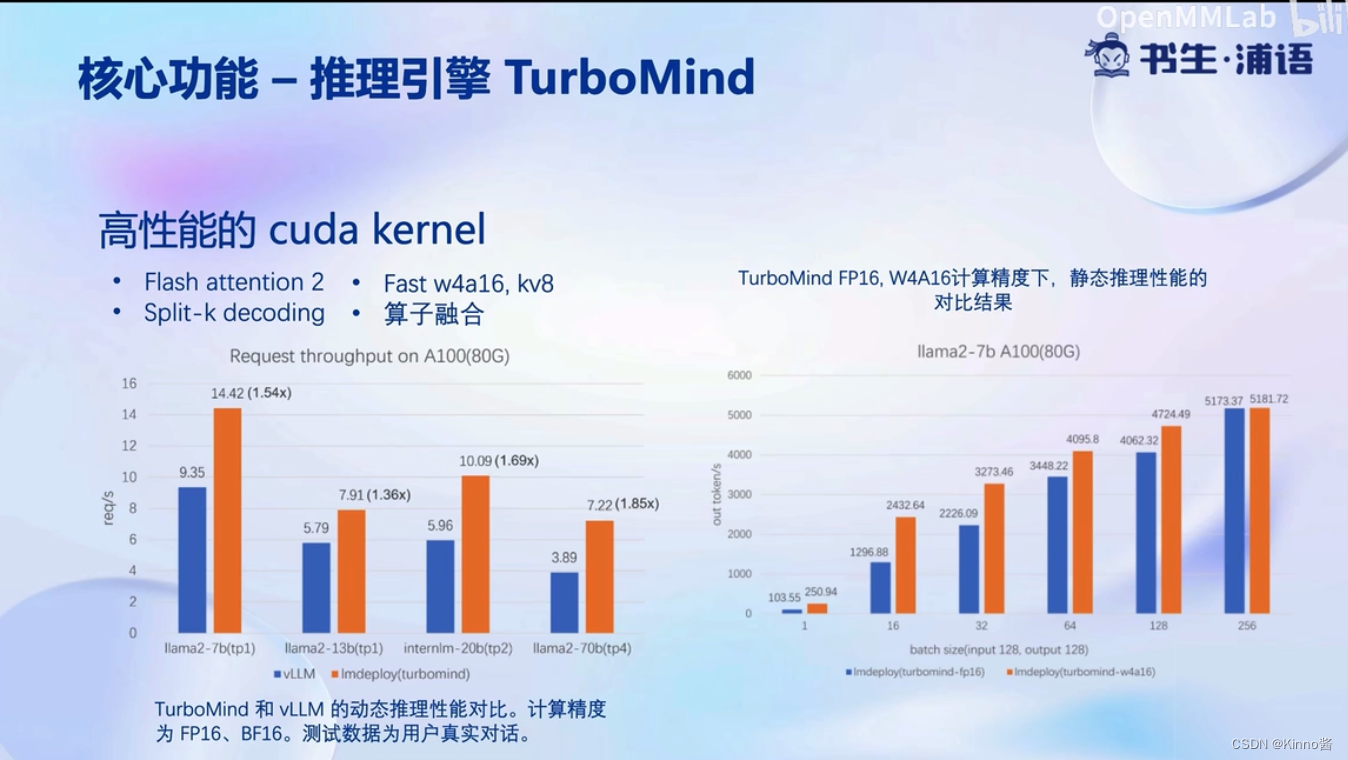

核心功能-推理引擎

不用等到整个batch结束

核心功能-推理服务api server

动手实践环节

https://github.com/InternLM/tutorial/blob/main/lmdeploy/lmdeploy.md

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/86575

推荐阅读

相关标签