热门标签

热门文章

- 1尤大都推荐的组件库是如何开发出来的?_extractthemeoverrides 如何去声明值

- 21.1 数据通信模型_终端设备接收到数据帧时,会如何处理?

- 3istio学习笔记3:envoy代理

- 4OpenWrt使用cron实现路由器定时重启 之二_openwrt设置自动重启

- 5基于Python的仓库出入库管理系统_python仓库管理系统

- 6使用FFMPEG配合bat批量执行程序将 m4a批量转mp3_bat ffmpeg m4a 批量转mp3

- 7lottie插件_比阿里犸良还强大!Lottie 动效设计完全指南(基础篇)

- 8Vmstat命令详解_wmstat

- 9rclone挂载webdav详细步骤(含脚本)

- 10nginx执行文件替换掉之后重启提示permission denied

当前位置: article > 正文

BP神经网络回归预测-附完整MATLAB代码(代码完整可直接用,注释详细,可供学习)

作者:知新_RL | 2024-02-18 02:34:57

赞

踩

神经网络回归预测

一、BP神经网络

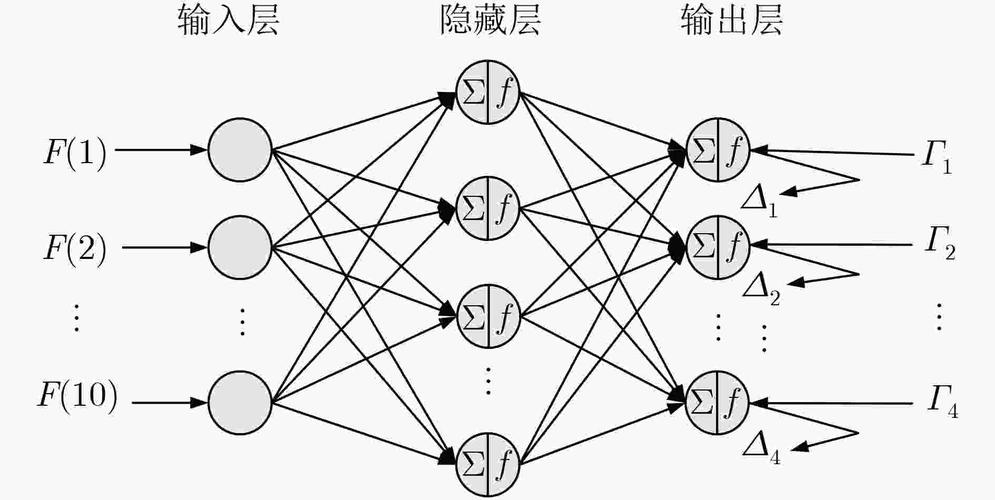

BP神经网络(Backpropagation Neural Network)是一种常用的人工神经网络,可用于回归预测任务。它通过在网络中进行前向传播和反向传播的过程来学习输入和输出之间的非线性映射关系。下面是使用BP神经网络进行回归预测的一般步骤:

1. 数据准备:准备用于回归预测的训练集和测试集数据。确保数据已经进行预处理,例如归一化或标准化。

2. 网络构建:构建BP神经网络模型。BP神经网络由输入层、隐藏层和输出层组成。隐藏层的数量和节点数可以根据问题的复杂性和数据特征进行选择。

3. 初始化权重和偏置:初始化网络中的权重和偏置参数。通常,这些参数可以使用随机初始化的方式。

4. 前向传播:将训练集的输入数据通过网络进行前向传播,计算每个神经元的输出值,并将输出传递到下一层。

5. 计算损失:根据网络输出和训练集的真实值,计算损失函数(如均方误差)来衡量网络的预测误差。

6. 反向传播:根据损失函数,使用反向传播算法计算每个权重和偏置参数对损失的梯度,并根据梯度更新参数。

7. 参数优化:使用优化算法(如随机梯度下降)来更新网络中的权重和偏置参数,以最小化损失函数。

8. 迭代训练:重复执行步骤4至步骤7,直到达到预定的训练停止条件(如达到最大迭代次数或损失函数收敛)。

9. 预测:使用训练好的BP神经网络对测试集数据进行预测。将测试集的输入数据通过网络进行前向传播,得到回归预测值。

10. 评估模型:使用适当的评估指标(例如均方根误差)评估模型在测试集上的性能。

二、MATLAB仿真结果

1. 最佳隐含层节点的确定过程

2. 各项误差指标结果

3. 打印测试集结果

4. BP预测值和实际值的对比以及预测误差

5. 回归图和误差直方图

三、BP优化模型

| 遗传算法 GA-BP | 粒子群优化算法 PSO-BP |

| 灰狼优化算法 GWO-BP | 鲸鱼优化算法 WOA-BP |

| 麻雀搜索算法 SSA-BP | 布谷鸟搜索算法 CS-BP |

四、BP代码

代码获取:点击跳转(链接安全)![]() https://kdocs.cn/l/cv16i3LNubfz

https://kdocs.cn/l/cv16i3LNubfz

- %% BP神经网络回归预测

- %% 1.初始化

- clear

- close all

- clc

- format bank %2位小数,format short精确4位,format long精确15位

-

- %% 2.读取数据

- data=xlsread('数据.xlsx'); % xlsread函数报错时,可用Load函数替代

-

- % 设置神经网络的输入和输出

- input=data(:,1:end-1); %第1列至倒数第2列为输入

- output=data(:,end); %最后1列为输出

- N=length(output); %计算样本数量

-

- %% 3.设置训练集和测试集

- %(1)随机选取测试样本

- k=rand(1,N);

- [m,n]=sort(k);

- testNum=500; %设定测试集样本数量 !仅需修改这里

- trainNum=N-testNum; %设定训练集样本数量

- input_train = input(n(1:trainNum),:)'; % 训练集输入

- output_train =output(n(1:trainNum))'; % 训练集输出

- input_test =input(n(trainNum+1:trainNum+testNum),:)'; % 测试集输入

- output_test =output(n(trainNum+1:trainNum+testNum))'; % 测试集输出

-

- %(2)从数据后面选取测试样本

- %testNum=50; %设定测试集样本数量

- %trainNum=N-testNum; %设定训练集样本数量

- %input_train = input(1:trainNum,:)'; % 训练集输入

- %output_train =output(1:trainNum)'; % 训练集输出

- %input_test =input(trainNum+1:trainNum+testNum,:)'; % 测试集输入

- %output_test =output(trainNum+1:trainNum+testNum)'; % 测试集输出

-

- %% 4.数据归一化

- [inputn,inputps]=mapminmax(input_train,0,1); % 训练集输入归一化到[0,1]之间

- [outputn,outputps]=mapminmax(output_train); % 训练集输出归一化到默认区间[-1, 1]

- inputn_test=mapminmax('apply',input_test,inputps); % 测试集输入采用和训练集输入相同的归一化方式

-

- %% 5.求解最佳隐含层

- inputnum=size(input,2); %size用来求取矩阵的行数和列数,1代表行数,2代表列数

- outputnum=size(output,2);

- disp(['输入层节点数:',num2str(inputnum),', 输出层节点数:',num2str(outputnum)])

- disp(['隐含层节点数范围为 ',num2str(fix(sqrt(inputnum+outputnum))+1),' 至 ',num2str(fix(sqrt(inputnum+outputnum))+10)])

- disp(' ')

- disp('最佳隐含层节点的确定...')

-

- %根据hiddennum=sqrt(m+n)+a,m为输入层节点数,n为输出层节点数,a取值[1,10]之间的整数

- MSE=1e+5; %误差初始化

- transform_func={'tansig','purelin'}; %激活函数采用tan-sigmoid和purelin

- train_func='trainlm'; %训练算法

- for hiddennum=fix(sqrt(inputnum+outputnum))+1:fix(sqrt(inputnum+outputnum))+10

-

- net=newff(inputn,outputn,hiddennum,transform_func,train_func); %构建BP网络

-

- % 设置网络参数

- net.trainParam.epochs=1000; % 设置训练次数

- net.trainParam.lr=0.01; % 设置学习速率

- net.trainParam.goal=0.000001; % 设置训练目标最小误差

-

- % 进行网络训练

- net=train(net,inputn,outputn);

- an0=sim(net,inputn); %仿真结果

- mse0=mse(outputn,an0); %仿真的均方误差

- disp(['当隐含层节点数为',num2str(hiddennum),'时,训练集均方误差为:',num2str(mse0)])

-

- %不断更新最佳隐含层节点

- if mse0<MSE

- MSE=mse0;

- hiddennum_best=hiddennum;

- end

- end

- disp(['最佳隐含层节点数为:',num2str(hiddennum_best),',均方误差为:',num2str(MSE)])

-

- %% 6.构建最佳隐含层的BP神经网络

- net=newff(inputn,outputn,hiddennum_best,transform_func,train_func);

-

- % 网络参数

- net.trainParam.epochs=1000; % 训练次数

- net.trainParam.lr=0.01; % 学习速率

- net.trainParam.goal=0.000001; % 训练目标最小误差

-

- %% 7.网络训练

- net=train(net,inputn,outputn); % train函数用于训练神经网络,调用蓝色仿真界面

-

- %% 8.网络测试

- an=sim(net,inputn_test); % 训练完成的模型进行仿真测试

- test_simu=mapminmax('reverse',an,outputps); % 测试结果反归一化

- error=test_simu-output_test; % 测试值和真实值的误差

-

- % 权值阈值

- W1 = net.iw{1, 1}; %输入层到中间层的权值

- B1 = net.b{1}; %中间各层神经元阈值

- W2 = net.lw{2,1}; %中间层到输出层的权值

- B2 = net.b{2}; %输出层各神经元阈值

-

- %% 9.结果输出

- % BP预测值和实际值的对比图

- figure

- plot(output_test,'bo-','linewidth',1.5)

- hold on

- plot(test_simu,'rs-','linewidth',1.5)

- legend('实际值','预测值')

- xlabel('测试样本'),ylabel('指标值')

- title('BP预测值和实际值的对比')

- set(gca,'fontsize',12)

-

- % BP测试集的预测误差图

- figure

- plot(error,'bo-','linewidth',1.5)

- xlabel('测试样本'),ylabel('预测误差')

- title('BP神经网络测试集的预测误差')

- set(gca,'fontsize',12)

-

-

- %计算各项误差参数

- [~,len]=size(output_test); % len获取测试样本个数,数值等于testNum,用于求各指标平均值

- SSE1=sum(error.^2); % 误差平方和

- MAE1=sum(abs(error))/len; % 平均绝对误差

- MSE1=error*error'/len; % 均方误差

- RMSE1=MSE1^(1/2); % 均方根误差

- MAPE1=mean(abs(error./output_test)); % 平均百分比误差

- r=corrcoef(output_test,test_simu); % corrcoef计算相关系数矩阵,包括自相关和互相关系数

- R1=r(1,2);

-

- % 显示各指标结果

- disp(' ')

- disp('各项误差指标结果:')

- disp(['误差平方和SSE:',num2str(SSE1)])

- disp(['平均绝对误差MAE:',num2str(MAE1)])

- disp(['均方误差MSE:',num2str(MSE1)])

- disp(['均方根误差RMSE:',num2str(RMSE1)])

- disp(['平均百分比误差MAPE:',num2str(MAPE1*100),'%'])

- disp(['预测准确率为:',num2str(100-MAPE1*100),'%'])

- disp(['相关系数R: ',num2str(R1)])

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/103835

推荐阅读

相关标签