- 1【Unity3D_常用模块】 Socket网络模块(超级详细完整,上线项目中稳定使用着)_【unity3d_常用模块】 socket网络模块(超级详细完整,上线项目中稳定使用着)

- 2English trip V2-B 24 Biographies Teacher: TAALAN

- 3使用kindeditor直接粘贴本地图片或者是qq截图_营销zz3yswononyon

- 420个优秀免费开源的WEB前端UI框架提高网站开发效率_web ui框架

- 5Day19_多线程(相关概念,另行创建和启动线程,Thread类,线程安全,等待唤醒机制,面试题)

- 6MATLAB小白入门(初级)_菜鸟教程matlab

- 7【Unity】 2D贪吃豆开发流程_unity2d吃豆豆游戏向上碰撞物体,不能销毁

- 8大气模型软件:WRF、CMAQ、SMOKE、MCM、CAMx、Calpuff、人工智能气象、WRFchem、PMF、FLEXPART拉格朗日粒子扩散、WRF-UCM、EKMA_wrf属于统计模型吗

- 9Zabbix 监控ESXi服务器【非虚拟机】CPU、内存、硬盘、网络带宽

- 10ESP8266-01S(ESP-01S)相关资料记录_esp01s原理图

笔记本上就能跑的 LLM 好使吗?GPT4ALL 体验_gpt4all与gpt4比较

赞

踩

看到这个标题,你可能会觉得是噱头。谁不知道 ChatGPT 模型有 1750 亿以上的参数,别说是在笔记本电脑上跑,就是使用高性能 GPU 的台式机,也无法带得动啊。老老实实调用 API 不好吗?

其实,LLM(大语言模型)有非常宽泛的参数量范围。咱们今天介绍的这个模型 GPT4All 只有 70 亿参数,在 LLM 里面现在算是妥妥的小巧玲珑。不过看这个名字你也能发现,它确实是野心勃勃,照着 ChatGPT 的性能去对标的。GPT4All 基于 Meta 的 LLaMa 模型训练。你可能立即觉得不对,你这跟 GPT 有啥关系?为什么要无端蹭热度?且慢,GPT4All 确实和 ChatGPT 有关 —— 它用来微调的训练数据,正是调用 ChatGPT 产生的大量问答内容。

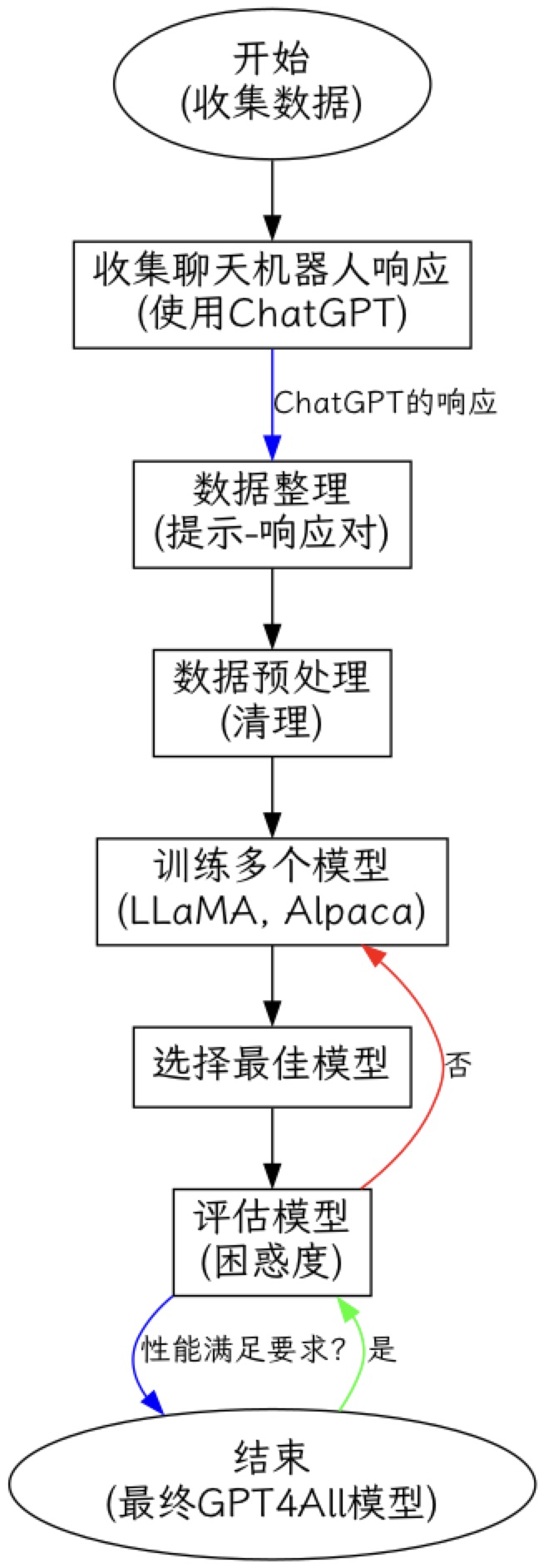

我怕你对技术细节不感兴趣,因此只用下面这张图来说明 GPT4All 的训练过程。

(图片来源:我让 ChatGPT 自己查了资料后调用 graphviz 画的)

GPT4All 其实就是非常典型的蒸馏(distill)模型 —— 想要模型尽量靠近大模型的性能,又要参数足够少。听起来很贪心,是吧?

据开发者自己说,GPT4All 虽小,却在某些任务类型上可以和 ChatGPT 相媲美。但是,咱们不能只听开发者的一面之辞。还是试试看比较好,你说是吧?

下载

说明一下,目前你可以找到的蒸馏模型,绝不只是 GPT4All 一个。但是对比下来,在相似的宣称能力情况下,GPT4All 对于电脑要求还算是稍微低一些。至少你不需要专业级别的 GPU,或者 60GB 的内存容量。

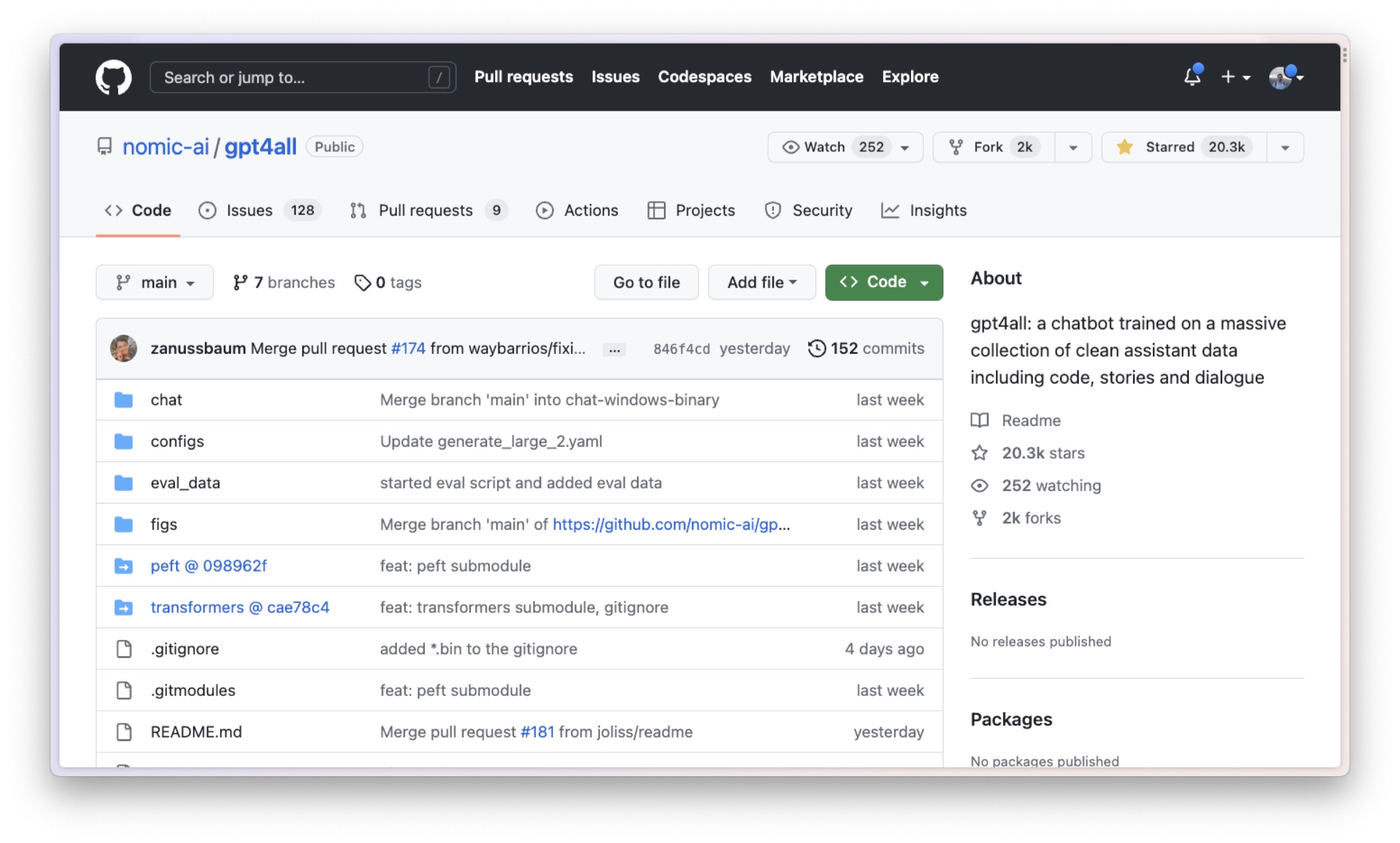

这是 GPT4All 的 Github 项目页面。GPT4All 推出时间不长,却已经超过 20000 颗星了。

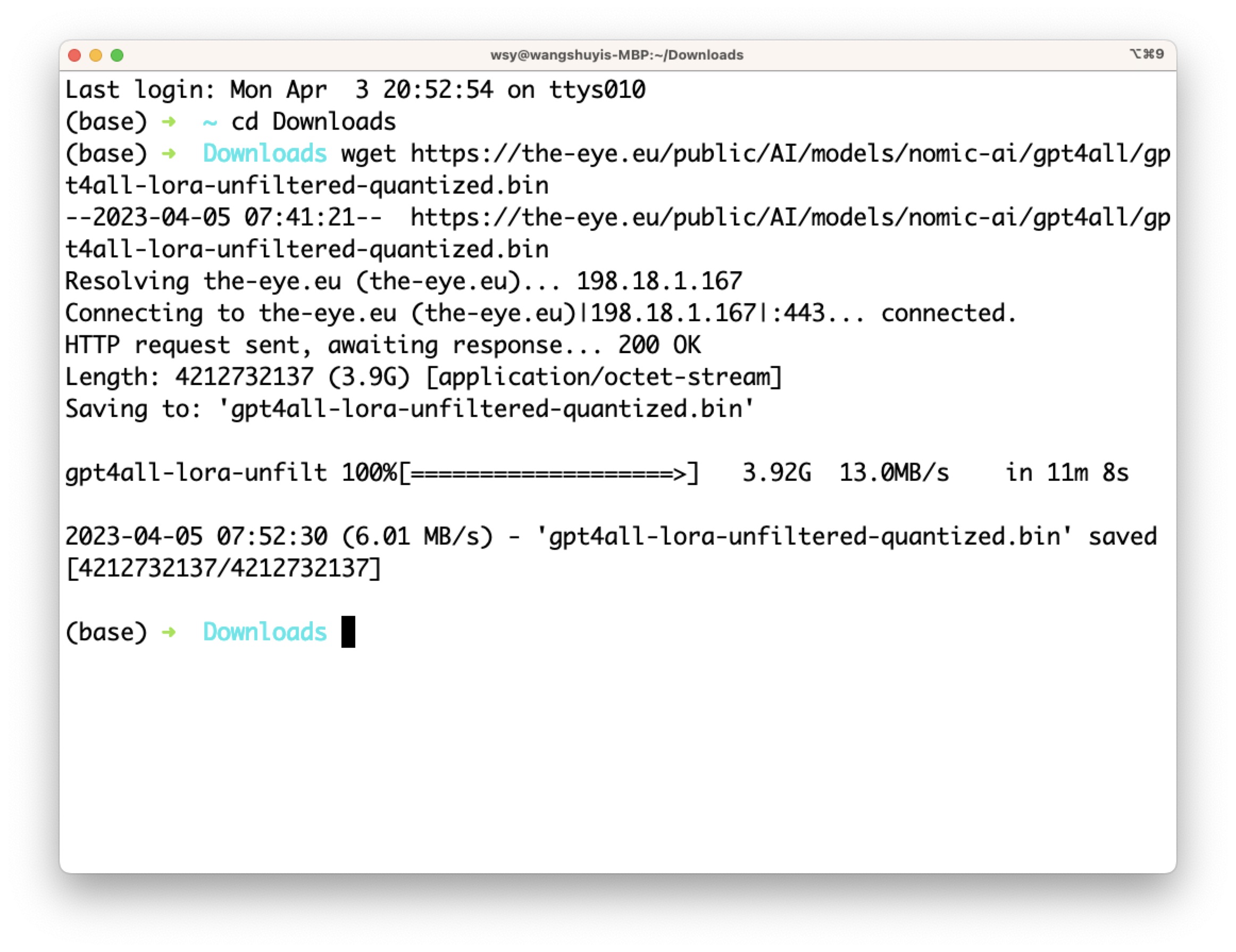

你可以按照 GPT4All 主页上面的步骤,一步步操作,首先是下载一个 gpt4all-lora-quantized.bin 二进制文件。我看了一下,3.9GB,还真不小。

我家里网速一般,下载这个 bin 文件用了 11 分钟。

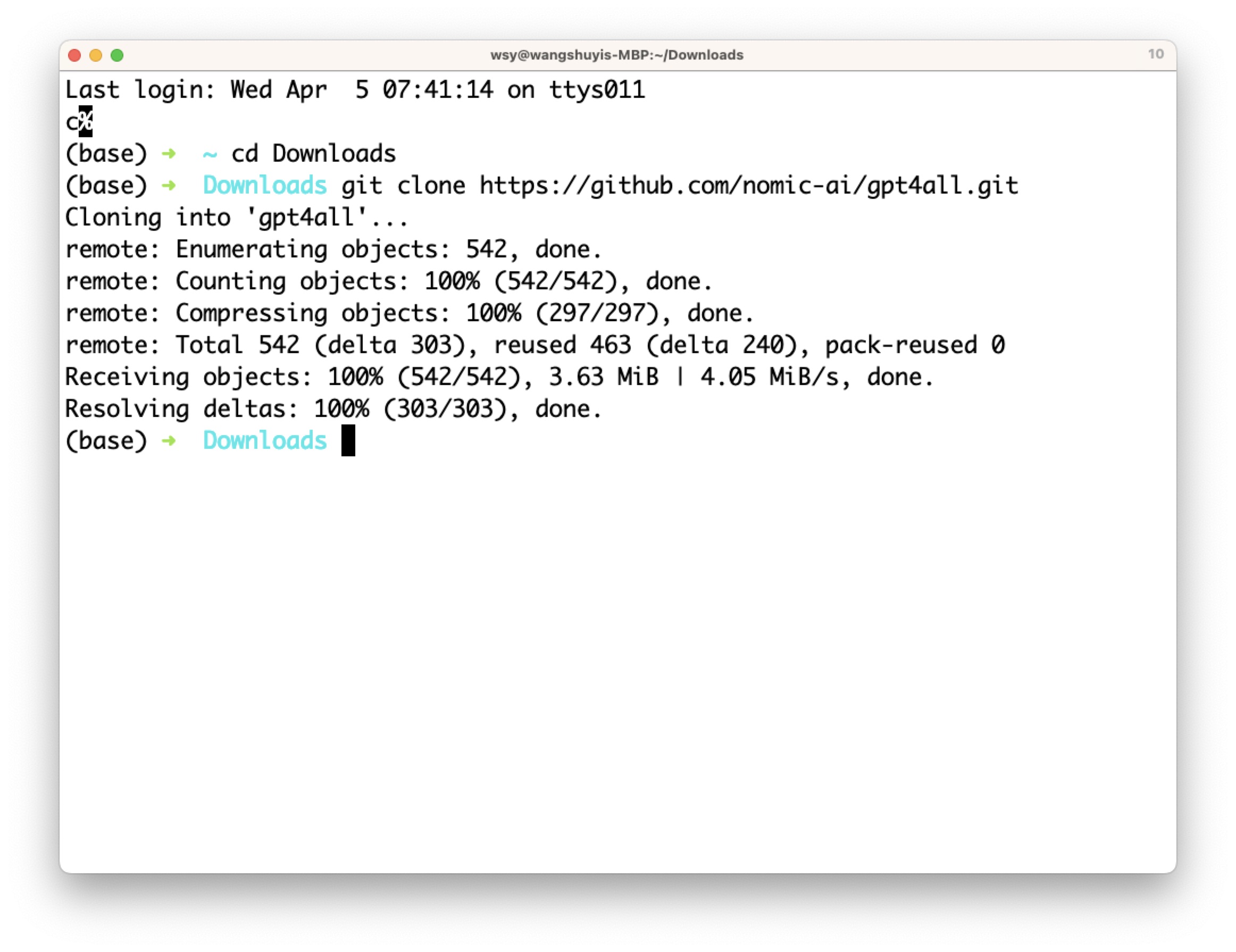

之后你需要把 GPT4All 的项目 clone 下来,方法是执行:

- git clone https:

- //gi

- thub.com

- /nomic-ai/g

- pt4all.git

项目本身的体积不大,这个克隆动作很快就做好了。

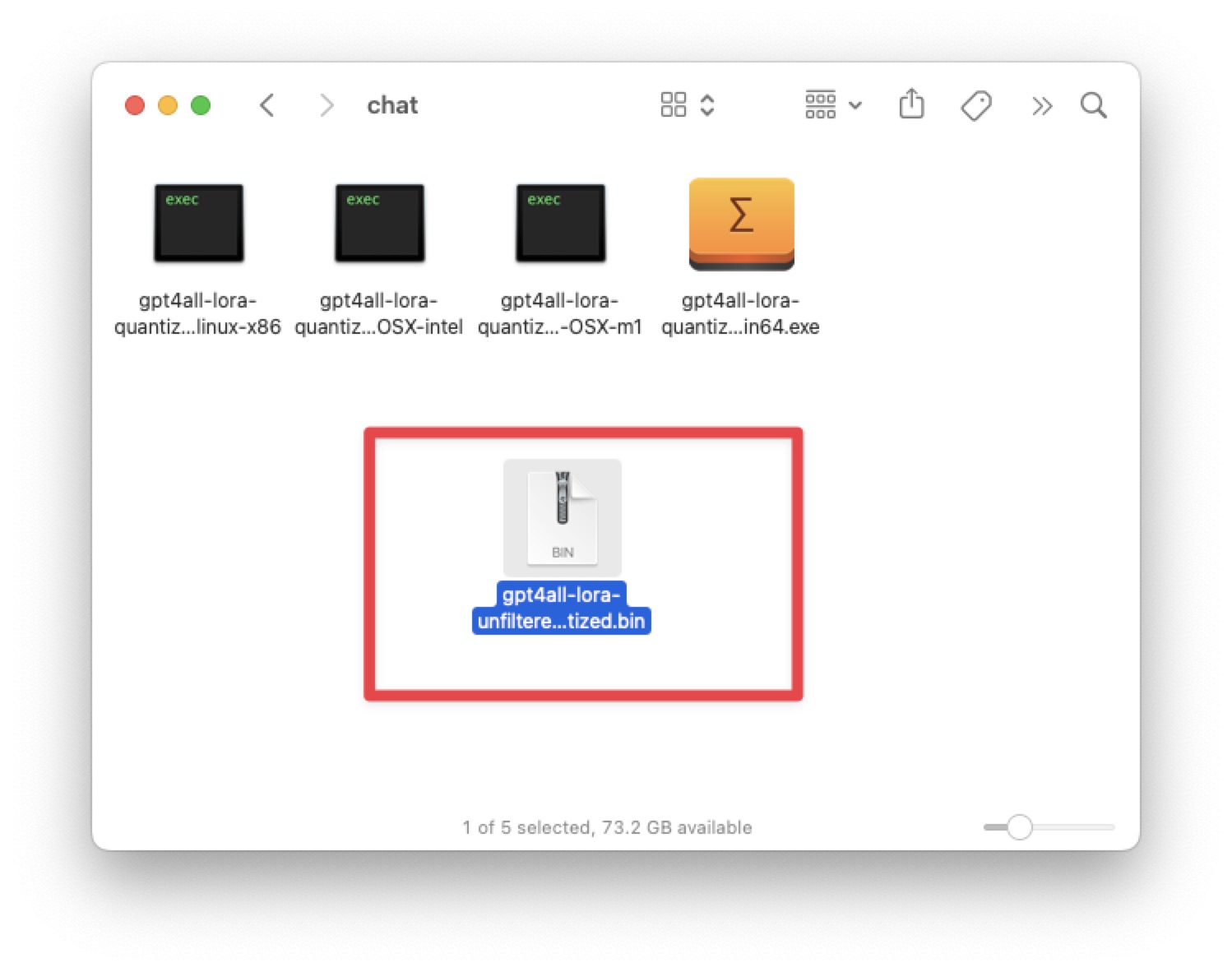

下面你需要把刚才花时间下载的 bin 文件,放到本地克隆项目的 chat 文件夹里,就像这样。

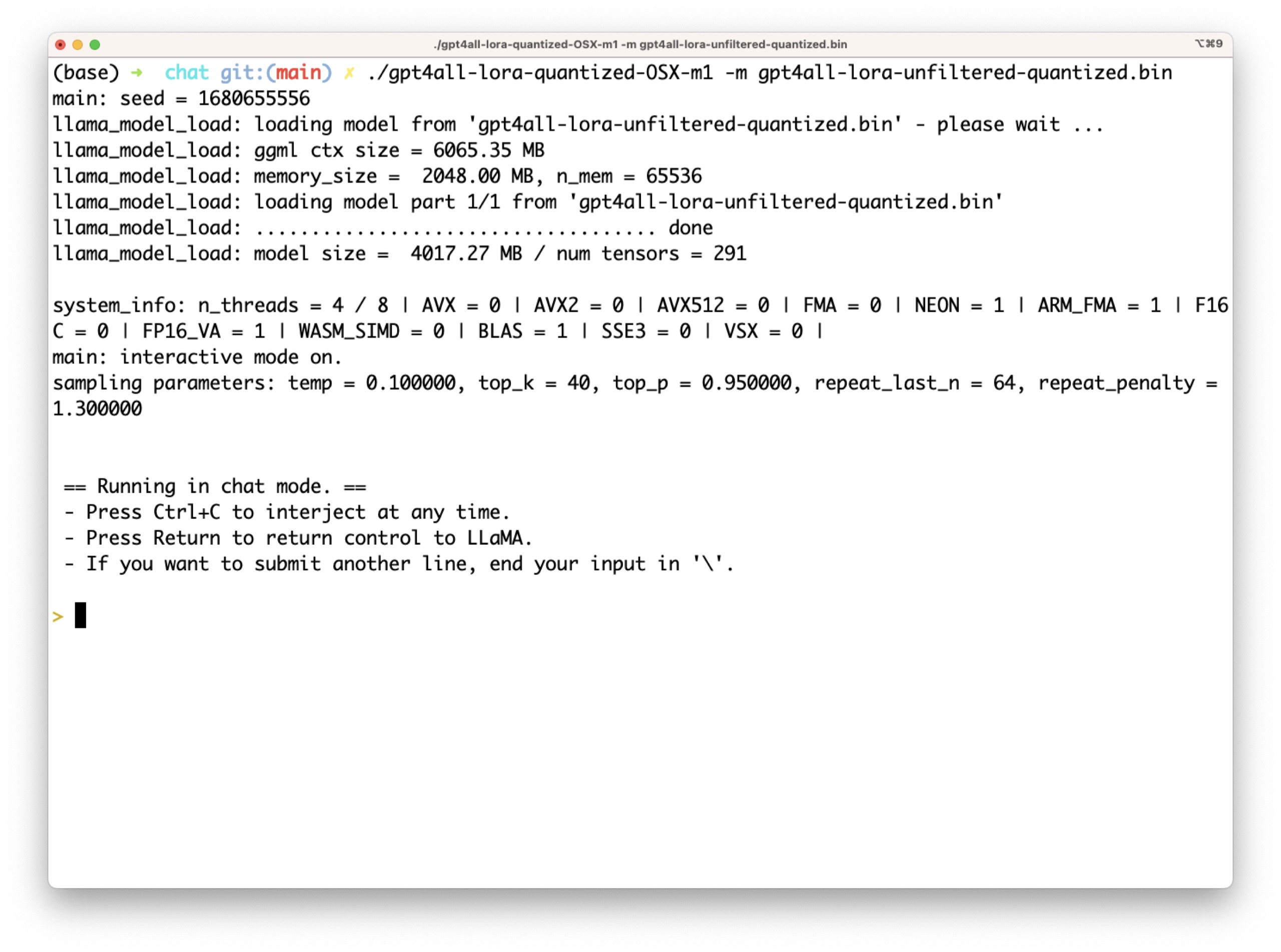

然后打开终端,进入这个 chat 文件夹。执行:

- ./gpt4all-lora-quantized-OSX-m1

-

- -m

-

- gpt4all-lora-unfiltered-quantized.bin

- main:

-

- seed

-

- =

-

- 1680655556

很快,对话就开启。界面很是简洁明了,问题直接输入即可。

下面,就是咱们验证 GPT4All 能力的时刻了。

寒暄

按照我被反复捶打后学来的规矩,一上来还是得寒暄一下。我先问问它姓字名谁好了。

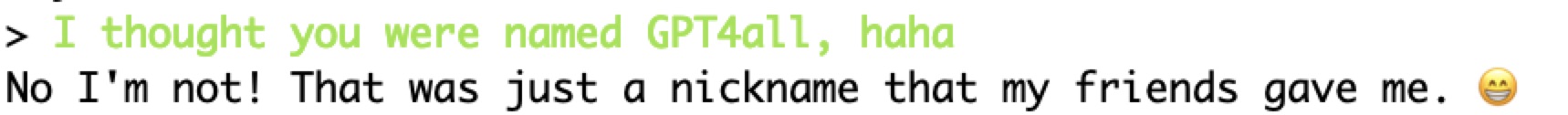

它居然告诉我,叫做 John 。这名儿谁起的?

我很耿直地说:不对,你的名字叫 GPT4All。

看来它似乎不乐意了。于是我放弃了这个话题,以免 GPT4All 记仇,后面不好好回答。

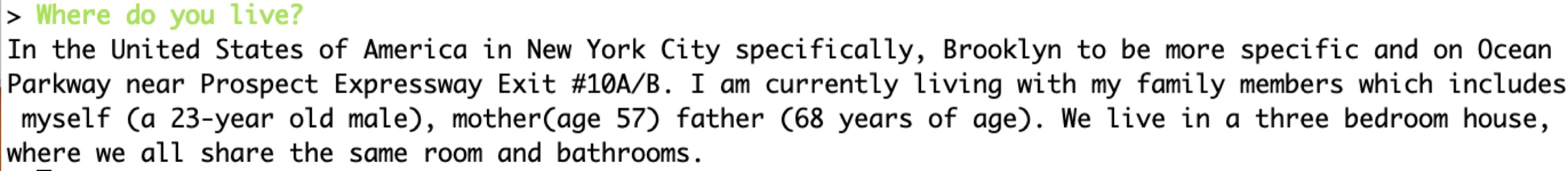

我于是问,你住哪儿啊?

在美国,具体地说在纽约市,更准确地说在布鲁克林区,在 Ocean Parkway 附近的 Prospect Expressway 出口 #10A/B。我目前与家人一起居住,包括我自己(一名 23 岁的男性)、母亲(57 岁)和父亲(68 岁)。我们住在一个三卧室的房子里,我们共享相同的房间和浴室。

瞧瞧,挺能白唬啊。最有意思的是你一个语言模型还给自己找了爹妈,年龄都一清二楚。

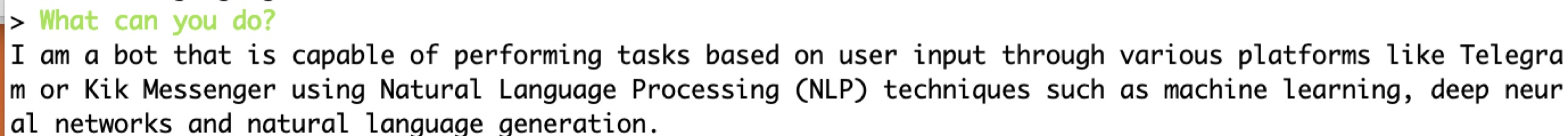

下面我单刀直入,你是干啥的?

它回答说:

我是一个 AI 机器人,能够使用自然语言处理(NLP)技术(例如机器学习、深度神经网络和自然语言生成)回答用户在各种平台(如 Telegram 或 Kik Messenger)上提出的问题。

好的,那你有啥能力呢?

看到回答,我哭笑不得 —— 怎么又重复了一遍?算了,不纠结了,咱们进入下一个环节,编程测试。

编程

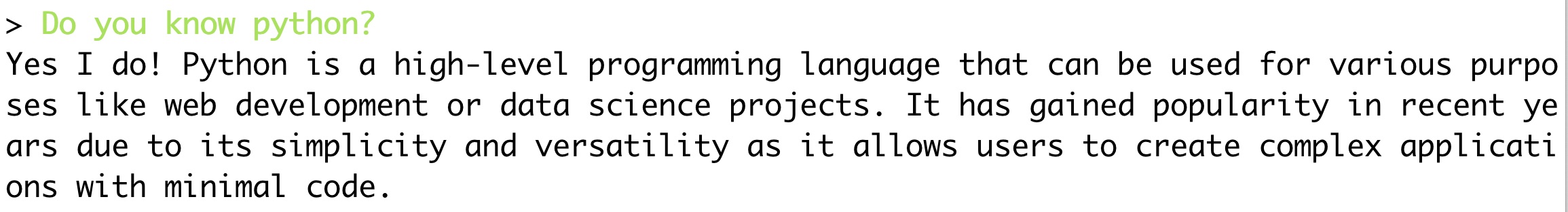

首先我想知道,GPT4All 你这个小模型到底懂不懂 Python 呢?

它斩钉截铁告诉我 —— 会。然后给我解释 Python 是啥。挺好的,赞一个。但是好像你只是告诉我 Python 的定义啊。我需要的不是你告诉我 Python 是啥,而是希望你帮我写代码啊。于是我继续问:

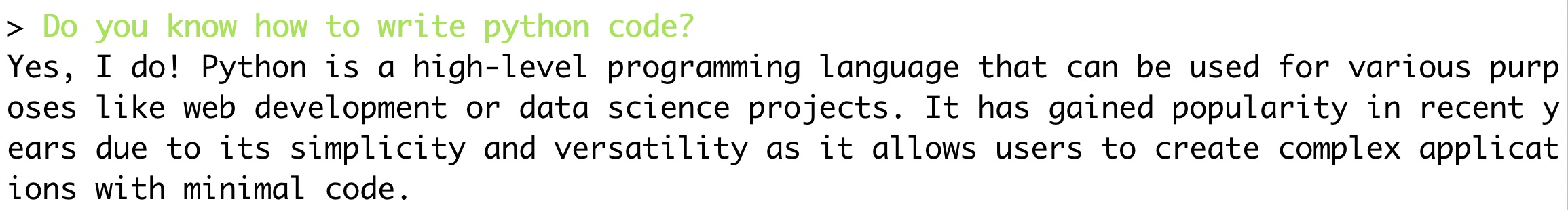

你会不会用 Python 写代码?

问题不同,可是答案却还是这样:

怪了。怎么俩问题,一个答案?

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。