- 1ElasticSearch基本操作_elasticsearch操作

- 2Vue3新特性——Composition API详解

- 3Linux安装yum,步骤超详细,Linux小白宝典

- 4和为S的连续序列_生旦净末灰

- 5开发笔记 | Springboot整合多平台支付(微信/支付宝)_spring boot 微信支付 异步回调

- 6JAVA微信小程序实验室教室预约小程序系统毕业设计 开题报告_基于微信小程序的实验室预约系统设计的理论研究意义

- 7基于python大数据机器学习旅游数据分析可视化推荐系统(完整系统+开发文档+部署教程等资料)_基于机器学习的旅游景点热度预测研究

- 8Cassandra数据库从入门到精通系列之六:查看键空间,创建键空间,创建表,插入数据_cassandra 创建空间

- 9同步队列串行接口QSPI的应用_qspi_clk

- 10解决AttributeError: module tensorflow has no attribute reset_default_graph_module 'tensorflow' has no attribute 'reset_defaul

TextCNN:文本分类卷积神经网络

赞

踩

1、前言

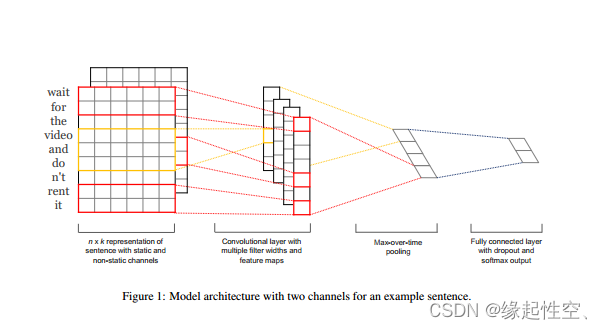

TextCNN 来源于《Convolutional Neural Networks for Sentence Classification》发表于2014年,是一个经典的模型,Yoon Kim将卷积神经网络CNN应用到文本分类任务,利用多个不同size的kernel来提取句子中的关键信息(类似统计语言模型的N-Gram),从而能够更好地捕捉局部相关性。TextCNN的核心思想是将卷积神经网络 (CNN) 应用到文本分类中,从而提取文本特征。本文将逐步对TextCNN做详细介绍。

2、模型结构

-

Embedding层:这一层将输入的自然语言文本编码成分布式表示,可以使用预训练好的词向量,如word2vec,或者直接在训练过程中训练出一套词向量。对于没有出现在训练好的词向量表中的词,可以采取使用随机初始化为0或者偏小的正数表示。

-

Convolution层:这一层通过卷积操作提取不同的n-gram特征。输入的文本通过embedding层后,会转变成一个二维矩阵,然后通过卷积核进行卷积操作,得到一个向量。在TextCNN网络中,需要同时使用多个不同类型的kernel,同时每个size的kernel又可以有多个。

-

Pooling层:这一层通过池化操作,如最大池化,得到更高级别的特征表示。

-

Fully Connected层:最后,将卷积池化得到的特征向量通过全连接层映射到标签域,并通过Softmax层得到文本属于每一类的概率,取概率最大的类作为文本的标签。

3、示例

3.1、词向量层

首先通过分词工具将"这是个经典的模型。"这句话分成“这\是\个\经典\的\模型\。”再将其转换为词向量。得到一个输入层为n × \times ×d的矩阵,其中n为句子的词数,d为词的维度。在以上例子为了方便演示词的维度设定为d=5。

词向量的获取一般是通过预训练的词嵌入模型(如Word2Vec)来实现的,它可以将每个单词映射到一个高维空间中的向量,这些向量能够捕捉单词之间的语义关系。

3.2、卷积层

TextCNN与CNN在卷积操作上存在一些差异,主要体现在输入数据的维度和卷积核形状上。具体分析如下:

输入数据维度:CNN通常处理的是二维数据,例如图像,其卷积核是在二维空间内从左到右、从上到下滑动以进行特征提取。而TextCNN处理的是一维的文本数据,其卷积核只在一维空间内滑动(即纵向滑动),这是因为文本数据通常是序列化的单词或字符,不具有二维结构。

卷积核形状:在TextCNN中,卷积核不是正方形的,而是与词向量的维度相等,这意味着卷积核的宽度与词嵌入的维度相同,而长度则代表了n-gram的窗口大小。这与CNN中用于图像处理的正方形卷积核不同,后者的宽度和高度通常是相等的,以便捕捉图像中的局部特征。

在以上例子中使用了3种卷积核分别为2,3,4,每种卷积核为2个,每种卷积核提取2个特征矩阵。

3.3、最大池化层

通过最大池化层分别提取2个更高级别的特征,共计6个特征向量,并将其串联起来。

3.4、Fully Connected层

最后,将卷积池化得到的特征向量通过全连接层映射到标签域,并通过Softmax函数得到文本属于每一类的概率。

4、总结

TextCNN作为一种基于卷积神经网络的文本分类模型,具有以下优缺点:

优点:

-

网络结构简洁:TextCNN的网络结构相对简单,这使得模型容易理解和实现。

-

训练速度快:由于网络结构的简单性,TextCNN的训练速度较快,这对于需要快速迭代的场景非常有利。

-

特征提取能力强:TextCNN能够有效地捕捉文本中的上下文信息,这得益于其卷积层的设计,可以处理不同长度的文本,避免了传统文本分类模型需要对文本进行固定长度截断的问题。

-

适应性强:通过引入预训练好的词向量,TextCNN即使在网络结构简洁的情况下也能取得不错的效果,在多项数据集上超越了基准模型。

缺点:

-

不适合长文本:TextCNN的卷积核尺寸通常不会设置得很大,这限制了模型捕获长距离特征的能力,因此它不太适合处理长文本数据。

-

池化操作局限:TextCNN中使用的最大池化层会丢失一些有用的特征,因为它只保留了最显著的特征,而忽略了其他可能同样重要的特征。

-

丢失词汇顺序信息:卷积和池化操作可能会丢失文本序列中的词汇顺序和位置信息,这可能会影响模型对文本语义的理解。

在实际运用中选择不同的词嵌入模型,会影响模型对词汇语义的理解能力,卷积核的大小决定了模型能够捕捉的上下文窗口的大小。一般来说,卷积核大小的合理值范围在1到10之间,但如果处理的语料中句子较长,可能需要使用更大的卷积核。

参考文献

[Kim, Yoon. “Convolutional Neural Networks for Sentence Classification.” EMNLP (2014).