- 1Elasticsearch - Docker安装Elasticsearch8.12.2

- 2Flutter入门之Row、Column、Container布局_flutter container和row

- 3如何修改YOLOV8?(从这8方面入手帮你提升精度)_yolov8改进

- 476. 最小覆盖子串 滑动窗口

- 5【运维】MacOS Wifi热点设置

- 6Java导出Excel里包含图片(包括GIF)_java excel导出图片

- 7解决将IDEA中的项目上传到Gitee平台时报错:Failed to connect to 127.0.0.1 port XXXX: Connection refused_idea failed to connect to 127.0.0.1 port 15732 aft

- 8最小二乘法(LSM)入门详解(原理及公式推导),MATLAB实现及应用_最小二乘法原理和公式

- 9Android Studio 自定义Gradle Plugin_android studio process release agcpligin

- 10LlamaIndex:轻松构建索引查询本地文档的神器_spacytextsplitter

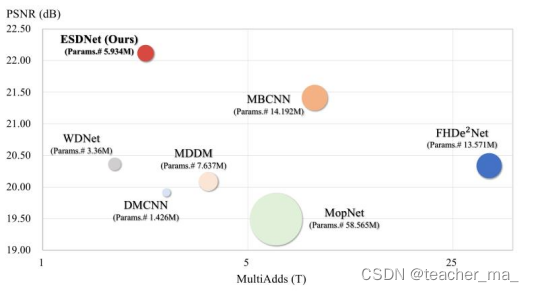

ESDNet-2022ECCV

赞

踩

论文题目

Towards Efficient and Scale-Robust Ultra-High-Definition Image Demoireing

1. Introduction

随着移动设备的快速发展,针对Ultra-High-Definition图像的去摩尔纹研究更具有实际意义,但此前没有高清数据集,因此本文建立了一个新的数据集UHDM,并基于此建立了一些SOTA方法的评价和分析,指出了此前研究存在的一些问题:缺少有效的多尺度特征提取策略。并且注意到从不同语义层次进行多尺度提取时,容易导致特征失配。

为此,受HRNet启发,设计了一个plug-and-play的语义对准尺度感知模块SAM来处理不同尺度的摩尔纹,进而设计了ESDNet。

2. Related Work

残差网络、dense网络、多尺度网络等在low-level中有着庞大的应用和良好的效果,本文同样也设计了dense block、SAM Module等。

3. UHDM Dataset

新建立的UHDM数据集包括5000对4K图像,覆盖了不同的场景。基于此数据集,设计了Benchmark来对比其他SOTA方法。

4. Proposed Method

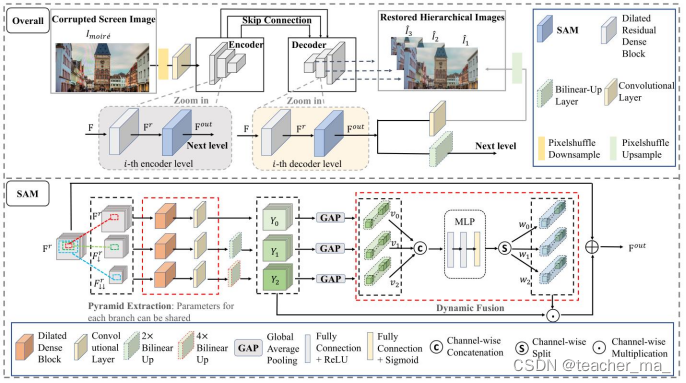

4.1 Pipeline

整体结构如图,输入图像首先经过一个Pixel Shuffle去下采样两次,然后经过一个5X5卷积层提取特征,提取的特征送入到encode-decoder backbone,通过skip connection连接,使高分辨率信息特征有助于去摩尔纹。在每个decoder level,网络通过卷积和像素混合上采样产生结果,同时也受到真实值监督训练。每个编码器和解码器都有一个dilated residual dense block和SAM模块,用于提取和动态融合同一语义级别的多尺度特征。

dilated residual dense block

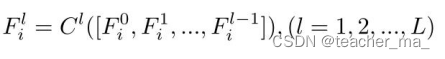

输入特征送到这个模块,包含residual dense block(RDB)和dilated扩张卷积层,处理输入并输出细化特征。给定F输入,每个层的级联公式为

括号里的式子为层l之前所有中间特征级联,Cl是conv和Relu的运算符,之后采用1X1卷积保持输入输出通道相同,最后采用残差连接生成更精细的特征表示,Fri就是下面SAM的输入,公式如下:

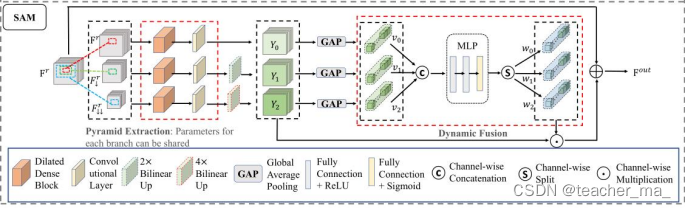

4.2 Semantic-Aligned Scale-Aware Module

在得到了Fri的输入,SAM旨在提取同语义级别多尺度特征并进行动态融合,从而提高处理摩尔纹能力。主要包含两个模块:金字塔特征提取和跨尺度动态融合。

Pyramid context extraction

如上图所示,首先通过双线性插值,将输入的特征下降2、4倍采样,将它们送到具有5个卷积层,产生金字塔输出。然后送入扩张密集块等后续一系列操作,不过多阐述。

Cross-scale dynamic fusion

金字塔的三个特征,通过此模块进行跨尺度动态融合。由于摩尔纹比例因图像而异,因此设计了跨尺度动态融合模块,设计动态权重适应图像。包括全局池化、MLP学习权重等。最后将三个输出融合,得到SAM最终输出。

4.3 Loss Function

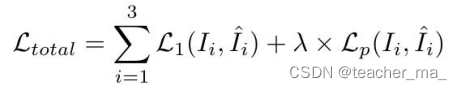

为了促进优化,本文采用深度监督策略,每个解码器产生三个分层预测,这些预测也被ground-truth监督。由于摩尔纹会破坏图像结构,因此采用perceptual loss感知损失来监控特征,最终损失函数为: