热门标签

热门文章

- 1基于Python爬虫河南省岗位招聘信息数据可视化和岗位查询系统(Django框架) 研究背景和意义、国内外现状

- 2MySQL:语法速查手册【持续更新...】_mysql查询第二个字为洋的学生

- 3第1章 引言:AI大模型的时代1.2 AI大模型的定义与特点1.2.3 大模型与传统模型的对比_ai 模型 传统模型

- 4Rust 程序设计语言 第一章入门_rust程序设计语言

- 5Mac安装Stable Diffusion详细教程(二):安装与使用Draw Things_draw things无法导入lora

- 6yarn安装和使用及与npm的区别

- 7GitHub的安装和使用 详细过程(实验报告)_github安装和注册方法

- 8STM32物联网(ESP-01S模块及STM32和ESP-01S通信方式介绍)_可以用stlink连接esp01s吗

- 9基于微信小程序的校园二手交易平台_校园二手交易小程序需求分析

- 10ICRA 2024 国际机器人与自动化大会_icra2024

当前位置: article > 正文

llama2-7b-chat-hf部署步骤(cpu版本)_llama-2-7b-chat-hf

作者:知新_RL | 2024-04-07 22:50:52

赞

踩

llama-2-7b-chat-hf

1.git clone GitHub - ggerganov/llama.cpp: Port of Facebook's LLaMA model in C/C++

2.进入llama.cpp文件夹并make

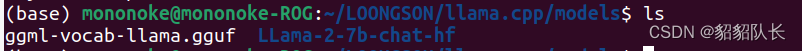

make3.把下载好的模型LLama-2-7b-chat-hf移入 /llama.cpp/models中

4.在llama.cpp目录中执行下面的命令安装依赖

python -m pip install -r requirements.txt5.转换格式

python convert.py models/LLama-2-7b-chat-hf6.进行4 bit量化

./quantize ./models/LLama-2-7b-chat-hf/ggml-model-f16.gguf ./models/LLama-2-7b-chat-hf/ggml-model-q4_0.gguf q4_07.使用交互模式运行

./main -m ./models/LLama-2-7b-chat-hf/ggml-model-q4_0.gguf -n 128 --repeat_penalty 1.0 --color -i -r "User:" -f prompts/chat-with-bob.txt声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/381151

推荐阅读

相关标签