热门标签

热门文章

- 1Tortoisegit使用教程以及提交代码所遇到的问题_tortoise commit框无法输入文字

- 2【项目】基于Django和深度学习的分类检测系统(实现的是花分类,可以上传图片或者摄像头调用)_基于djingo的检测系统

- 3内核交叉编译配置定制和编译(2)_安卓8.1 交叉编译 配置

- 4Sora是什么,Sora有多好,Sora是如何实现从文本到视频的?本文让你认识目前Sora的总体情况_sora 采用逐帧生成还是

- 5ROS Turtlebot3多机器人编队导航仿真_turtlebot3 gazebo

- 6基于Web的美食网站的设计与实现(JSP+java+springmvc+mysql+MyBatis)_w3school编写美食网站的jsp代码

- 7c ++ assign函数_vector :: assign()函数,以及C ++ STL中的示例

- 8一次失败的面试经历:我只想找个工作,你却用面试题羞辱我_面试时让她感觉我只是想找你工作

- 9阿里云 物联网平台 MQTT连接、数据传输

- 10Oracle到PostgreSQL的不停机数据库迁移

当前位置: article > 正文

Windows本地部署ChatGLM-6B模型并用CPU运行_no module named 'transformers_modules.thudm/chatgl

作者:知新_RL | 2024-05-06 17:04:59

赞

踩

no module named 'transformers_modules.thudm/chatglm2-6b

下载模型代码

git clone https://github.com/THUDM/ChatGLM2-6B

相关代码会下载到ChatGLM2-6B文件夹中

创建虚拟环境

cmd 打开 ChatGLM2-6B文件夹

python -m venv venv # 创建了一个叫做 venv 的虚拟环境,会出现一个 venv 的文件夹

venv\Scripts\activate.bat # 来激活虚拟环境,如果报错,就先cd到Scripts文件夹,执行activate.bat

pip install -r requirements.txt -i https://pypi.douban.com/simple # 安装所需要的包

- 1

- 2

- 3

下载模型

https://huggingface.co/THUDM/chatglm-6b-int4

从这个网站上下载模型相关的文件

在ChatGLM2-6B文件夹下创建THUDM/chatglm-6b-int4文件夹,将下载的文件放到这个文件夹中

运行

from transformers import AutoTokenizer, AutoModel

# 绝对路径

tokenizer = AutoTokenizer.from_pretrained("D:\ChatGLM\ChatGLM2-6B\THUDM\chatglm2-6b-int4", trust_remote_code=True)

model = AutoModel.from_pretrained("D:\ChatGLM\ChatGLM2-6B\THUDM\chatglm2-6b-int4", trust_remote_code=True).float()

model = model.eval()

input = "我该怎么训练你"

response, history = model.chat(tokenizer, input, history=[])

print(response)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

运行结果

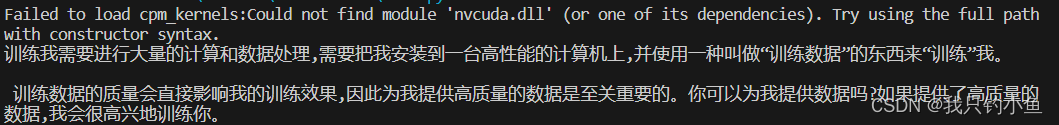

问题

1、报错 No module named ‘transformers_modules.THUDM/chatglm-6b’

win系统下子文件夹的路径应该写成\(“THUDM\chatglm-6b”), 原代码写的是linux文件系统用的/ (“THUDM/chatglm-6b”)。

2、quantization_kernels_parallel.so 加载失败

这是因为ctypes在Windows环境下的bug还没修复,python3.10目前还有问题。需要对quantization.py 中的 ctypes.cdll.LoadLibrary相关代码 进行处理:

将

kernels = ctypes.cdll.LoadLibrary(kernel_file)

修改为

kernels = ctypes.CDLL(kernel_file, winmode = 0)

- 1

- 2

- 3

- 4

也有人会手动编译,步骤如下,也可以尝试

(1)手动编译,在模型path下

gcc -fPIC -pthread -fopenmp -std=c99 quantization_kernels_parallel.c -shared -o quantization_kernels_parallel.so

gcc -fPIC -pthread -fopenmp -std=c99 quantization_kernels.c -shared -o quantization_kernels.so

- 1

- 2

(2)然后在原先模型加载后手动加载一下手动编译的kernel

model = AutoModel.from_pretrained("THUDM/chatglm-6b-int4",trust_remote_code=True).float()

model = model.quantize(bits=4, kernel_file="Your Kernel Path")

- 1

- 2

参考文献

https://blog.csdn.net/u013817537/article/details/131500501

https://blog.csdn.net/chaishen10000/article/details/131274928

https://zhuanlan.zhihu.com/p/640677084

声明:本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:【wpsshop博客】

推荐阅读

相关标签