- 1使用Colab_LLaMA_Factory_LoRA微调_Llama3(可自定义数据)_llama factory colab 导出

- 2(10-3)Actor-Critic算法:Soft Actor-Critic (SAC)_sac训练过程

- 3springboot实现rabbitmq动态创建交换机,队列以及交换机、队列绑定_springboot启动 rabbitmq队列未自动绑定

- 4Java项目源码—垃圾分类管理系统_java垃圾分类管理系统,mysql数据库,管理员,回收员,用户三种角色,预约回收,回收管

- 5普通人如何仰望星空_平庸人类的观星方式

- 6项目管理-项目经理如何高效沟通

- 7SQL Server技巧合集2005-04-2

- 8Docker AIGC等大模型深度学习环境搭建(完整详细版)_docker管理深度训练

- 9Leetcode水题——132模式_leetcode 132 回溯

- 10各大模型厂商API使用:百度、阿里、豆包、kimi、deepseek

绝对完美解决hdfs datanode数据和磁盘数据分布不均调整(hdfs balancer )——经验总结_datanode balance(2)_hadoop datanode多目录磁盘配置

赞

踩

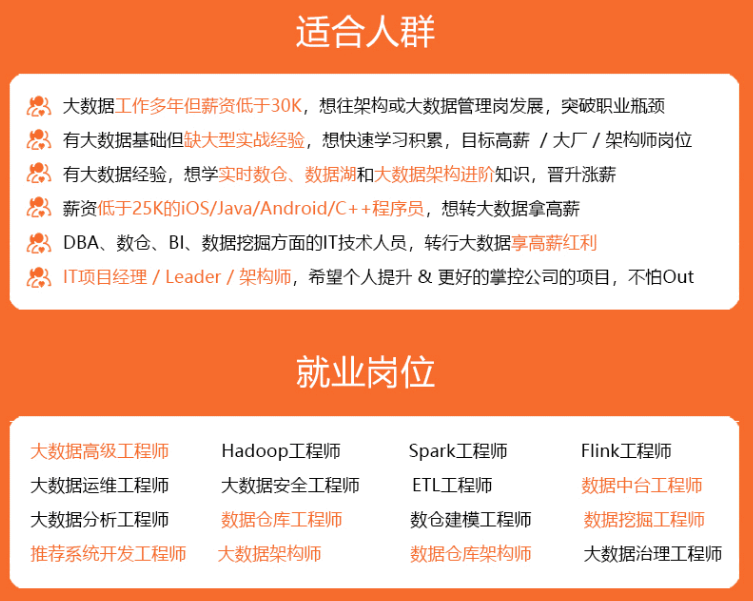

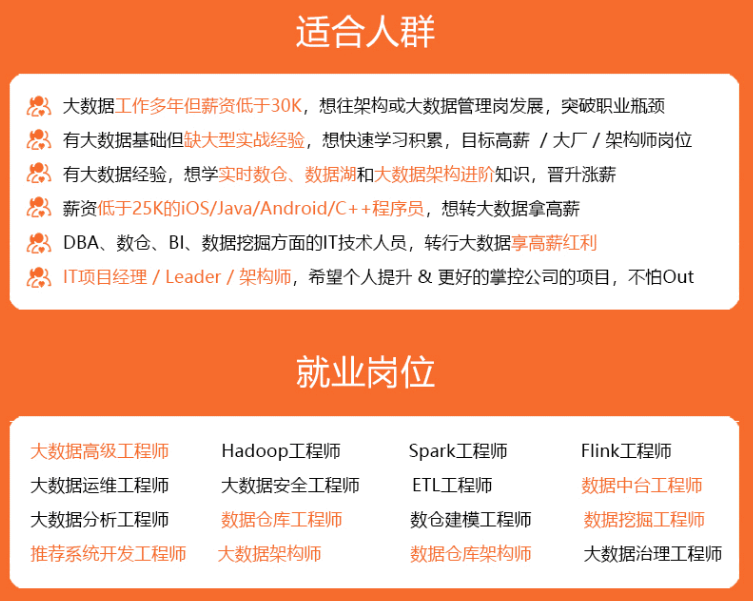

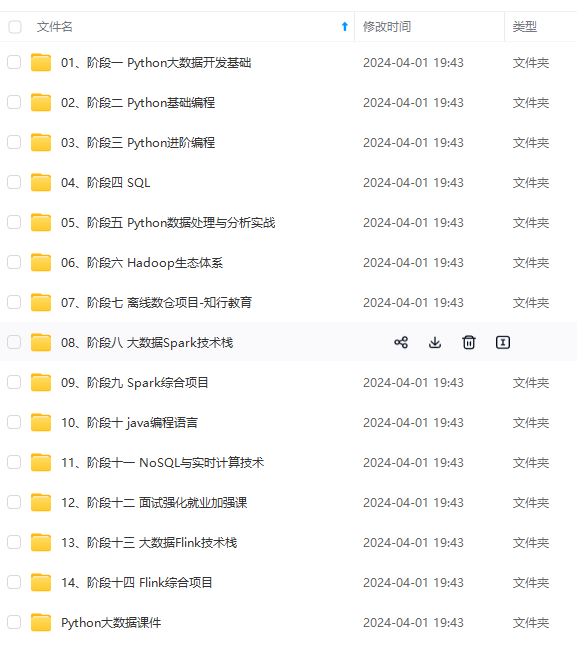

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

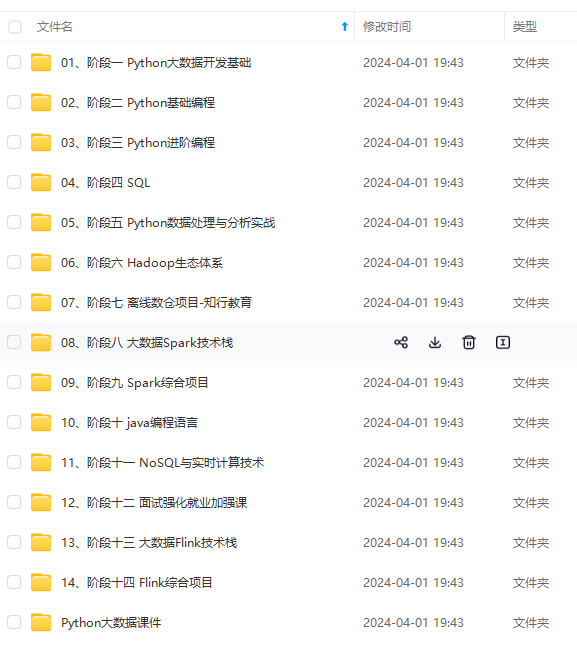

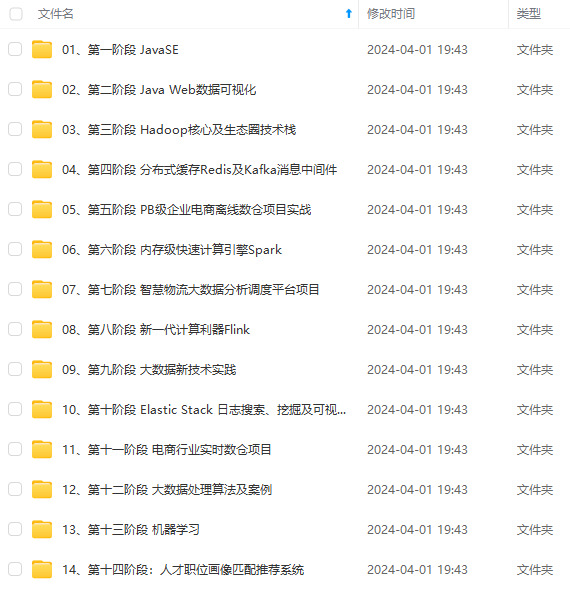

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

hdfs 需要存写大量文件,有时磁盘会成为整个集群的性能瓶颈,所以需要优化 hdfs 存取速度,将数据目录配置多磁盘,既可以提高并发存取的速度,还可以解决一块磁盘空间不够的问题。

Hadoop 环境部署可以参考我之前的文章:大数据Hadoop之——Hadoop 3.3.4 HA(高可用)原理与实现(QJM)

二、Hadoop DataNode多目录磁盘配置

1)配置hdfs-site.xml

在配置文件中$HADOOP_HOME/etc/hadoop/hdfs-site.xml添加如下配置:

<!-- dfs.namenode.name.dir是保存FsImage镜像的目录,作用是存放hadoop的名称节点namenode里的metadata--> <property> <name>dfs.namenode.name.dir</name> <value>file:/opt/bigdata/hadoop/hadoop-3.3.4/data/namenode</value> </property> <!-- 存放HDFS文件系统数据文件的目录(存储Block),作用是存放hadoop的数据节点datanode里的多个数据块。 --> <property> <name>dfs.datanode.data.dir</name> <value>/data1,/data2,/data3,/data4</value> </property> <!-- 设置数据存储策略,默认为轮询,现在的情况显然应该用“选择空间多的磁盘存”模式 --> <property> <name>dfs.datanode.fsdataset.volume.choosing.policy</name> <value>org.apache.hadoop.hdfs.server.datanode.fsdataset.AvailableSpaceVolumeChoosingPolicy</value> </property> <!-- 默认值0.75。它的含义是数据块存储到可用空间多的卷上的概率,由此可见,这个值如果取0.5以下,对该策略而言是毫无意义的,一般就采用默认值。--> <property> <name>dfs.datanode.available-space-volume-choosing-policy.balanced-space-preference-fraction</name> <value>0.75f</value> </property> <!-- 配置各个磁盘的均衡阈值的,默认为10G(10737418240),在此节点的所有数据存储的目录中,找一个占用最大的,找一个占用最小的,如果在两者之差在10G的范围内,那么块分配的方式是轮询。 --> <property> <name>dfs.datanode.available-space-volume-choosing-policy.balanced-space-threshold</name> <value>10737418240</value> </property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

【温馨提示】此处的

dfs.namenode.name.dir和dfs.datanode.data.dir位置需要不一样,不能是一个文件夹,之前设置成一个文件夹报错ERROR org.apache.hadoop.hdfs.server.common.Storage: It appears that another node 1003@iZ2zeh8q22e14pvqr3bu01Z has already locked the storage directory:

【原因】是当namenode启动后,锁定了文件夹,导致datanode无法启动。

2)配置详解

1、 dfs.datanode.data.dir

HDFS数据应该存储Block的地方。可以是逗号分隔的目录列表(典型的,每个目录在不同的磁盘)。这些目录被轮流使用,一个块存储在这个目录,下一个块存储在下一个目录,依次循环。每个块在同一个机器上仅存储一份。不存在的目录被忽略。必须创建文件夹,否则被视为不存在。

2、dfs.datanode.fsdataset.volume.cho

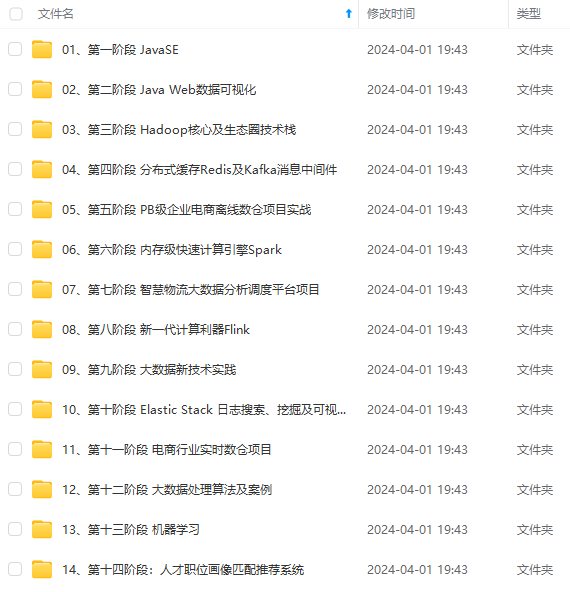

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

并且后续会持续更新**