- 1【秋招】计算机视觉面试题

- 2基于esp32IDF的简单频率计(1-20M)_esp32频率计

- 3Python 基础 (标准库):math (数学函数)_python math

- 4Oracle数据库统计数据量的大小的命令_oracle统计不同年度数据量存储大小

- 5winmm.dll文件丢失导致程序无法运行问题

- 6C语言结构体声明的妙用,隐藏结构体内部信息_王凯c语言

- 7人事管理 | 如何用一套系统完成“入转调离”全生命周期管理?_入转调离生命周期

- 8机械臂全面学习---moveit和gazebo联合仿真_机械臂yaml仿真

- 9字节跳动简历冷却期_拿到字节跳动offer后,简历被阿里捞了起来,二面迎来了P9"盘问...

- 10Python对多属性的重复数据去重_python 用类的多个属性 判断重复

python天气数据分析与处理,python天气数据分析报告_python 天气数据分析

赞

踩

大家好,给大家分享一下python天气数据分析与处理并给出结论怎么写,很多人还不知道这一点。下面详细解释一下。现在让我们来看看!

前言

天气预报我们每天都会关注,我们可以根据未来的天气增减衣物、安排出行,每天的气温、风速风向、相对湿度、空气质量等成

为关注的焦点。本次使用python中requests和BeautifulSoup库对中国天气网当天和未来14天的数据进行爬取,保存为csv文件,之

后用matplotlib、numpy、pandas对数据进行可视化处理和分析,得到温湿度度变化曲线、空气质量图、风向雷达图等结果,为获

得未来天气信息提供了有效方法Python解释器的安装步骤。

1、数据获取

请求网站链接

首先查看中国天气网的网址:http://www.weather.com.cn/weather/101280701.shtml这里就访问本地的天气网址,如果想爬取不同

的地区只需修改最后的101280701地区编号即可,前面的weather代表是7天的网页,weather1d代表当天,weather15d代表未来

14天。这里就主要访问7天和14天的中国天气网。采用requests.get()方法,请求网页,如果成功访问,则得到的是网页的所有字

符串文本。这就是请求过程。

- Python学习交流Q群:906715085###

- def getHTMLtext(url):

- """请求获得网页内容"""

- try:

- r = requests.get(url, timeout = 30)

- r.raise_for_status()

- r.encoding = r.apparent_encoding

- print("成功访问")

- return r.text

- except:

- print("访问错误")

- return" "

提取有用信息

这里采用BeautifulSoup库对刚刚获取的字符串进行数据提取,首先对网页进行检查,找到需要获取数据的标签:

可以发现7天的数据信息在div标签中并且id=“7d”,并且日期、天气、温度、风级等信息都在ul和li标签中,所以我们可以使用

BeautifulSoup对获取的网页文本进行查找div标签id=“7d”,找出他包含的所有的ul和li标签,之后提取标签中相应的数据值,保存

到对应列表中。

这里要注意一个细节就是有时日期没有最高气温,对于没有数据的情况要进行判断和处理。另外对于一些数据保存的格式也要提

前进行处理,比如温度后面的摄氏度符号,日期数字的提取,和风级文字的提取,这需要用到字符查找及字符串切片处理。

- Python学习交流Q群:906715085###

- def get_content(html):

- """处理得到有用信息保存数据文件"""

- final = [] # 初始化一个列表保存数据

- bs = BeautifulSoup(html, "html.parser") # 创建BeautifulSoup对象

- body = bs.body

- data = body.find('div', {'id': '7d'}) # 找到div标签且id = 7d

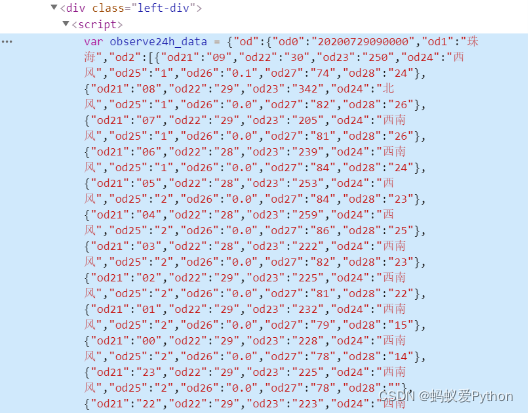

下面爬取当天的数据

- Python学习交流Q群:906715085####

- data2 = body.find_all('div',{'class':'left-div'})

- text = data2[2].find('').string

- text = text[text.index('=')+1 :-2] # 移除改var data=将其变为json数据

- jd = json.loads(text)

- dayone = jd['od']['od2'] # 找到当天的数据

- final_day = [] # 存放当天的数据

- count = 0

- for i in dayone:

- temp = []

- if count <=23:

- temp.append(i['od21']) # 添加时间

- temp.append(i['od22']) # 添加当前时刻温度

- temp.append(i['od24']) # 添加当前时刻风力方向

- temp.append(i['od25']) # 添加当前时刻风级

- temp.append(i['od26']) # 添加当前时刻降水量

- temp.append(i['od27']) # 添加当前时刻相对湿度

- temp.append(i['od28']) # 添加当前时刻控制质量

- #print(temp)

- final_day.append(temp)

- count = count +1

下面爬取7天的数据

- ul = data.find('ul') # 找到所有的ul标签

- li = ul.find_all('li') # 找到左右的li标签

- i = 0 # 控制爬取的天数

- for day in li: # 遍历找到的每一个li

- if i < 7 and i > 0:

- temp = [] # 临时存放每天的数据

- date = day.find('h1').string # 得到日期

- date = date[0:date.index('日')] # 取出日期号

- temp.append(date)

-

- inf = day.find_all('p') # 找出li下面的p标签,提取第一个p标签的值,即天气

- temp.append(inf[0].string)

-

-

- tem_low = inf[1].find('i').string # 找到最低气温

-

- if inf[1].find('span') is None: # 天气预报可能没有最高气温

- tem_high = None

- else:

- tem_high = inf[1].find('span').string # 找到最高气温

- temp.append(tem_low[:-1])

- if tem_high[-1] == '℃':

- temp.append(tem_high[:-1])

- else:

- temp.append(tem_high)

- wind = inf[2].find_all('span') # 找到风向

- for j in wind:

- temp.append(j['title'])

- wind_scale = inf[2].find('i').string # 找到风级

- index1 = wind_scale.index('级')

- temp.append(int(wind_scale[index1-1:index1]))

- final.append(temp)

- i = i + 1

-

- return final_day,final

同样对于/weather15d:15天的信息,也做同样的处理,这里经过查看后发现他的15天网页中只有8-14天,前面的1-7天

在/weather中,这里就分别访问两个网页将爬取得到的数据进行合并得到最终14天的数据。- 前面是未来14天的数据爬取过程,

对于当天24小时的天气信息数据,经过查找发现他是一个json数据,可以通过json.loads()

方法获取当天的数据,进而对当天的天气信息进行提取。

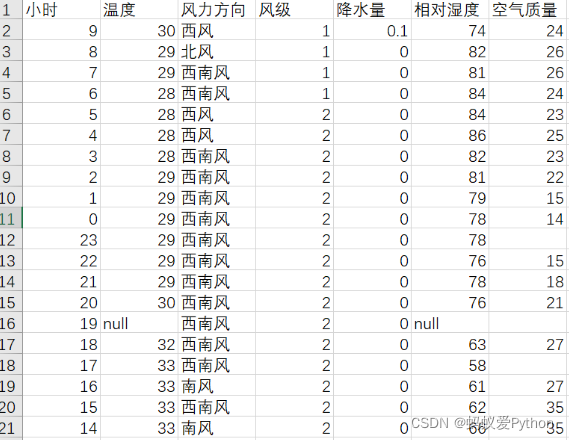

保存csv文件

前面将爬取的数据添加到列表中,这里引入csv库,利用f_csv.writerow(header)和f_csv.writerows(data)方法,分别写入表头和每

一行的数据,这里将1天和未来14天的数据分开存储,分别保存为weather1.csv和weather14.csv,下面是他们保存的表格图: